sync=standard: sync writes are written 2 times (first to LOG, second as normal write every ~5 seconds)async write are written only once (every ~5 seconds)sync=always: sync & async writes are written 2 times (first to LOG, second as normal write every ~5 seconds)sync=disabled: sync & async writes are written only once (every ~5 seconds)

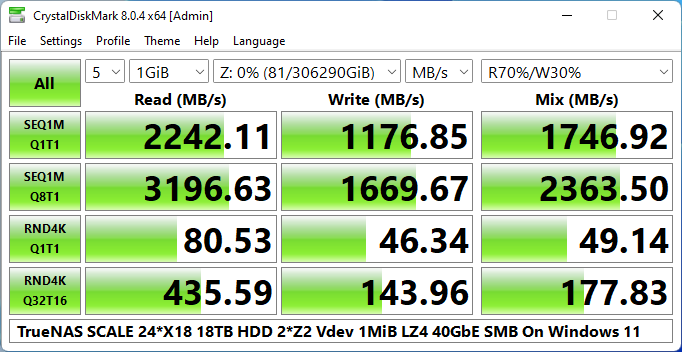

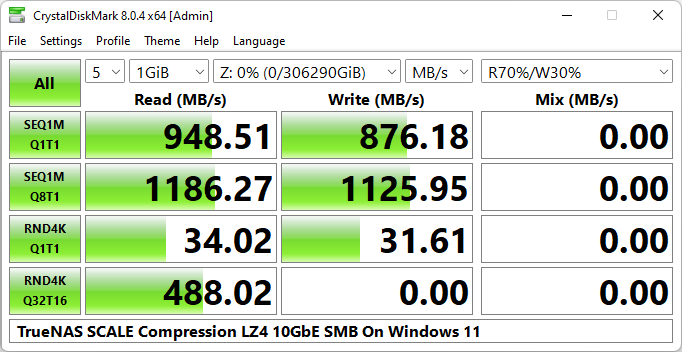

[Read]

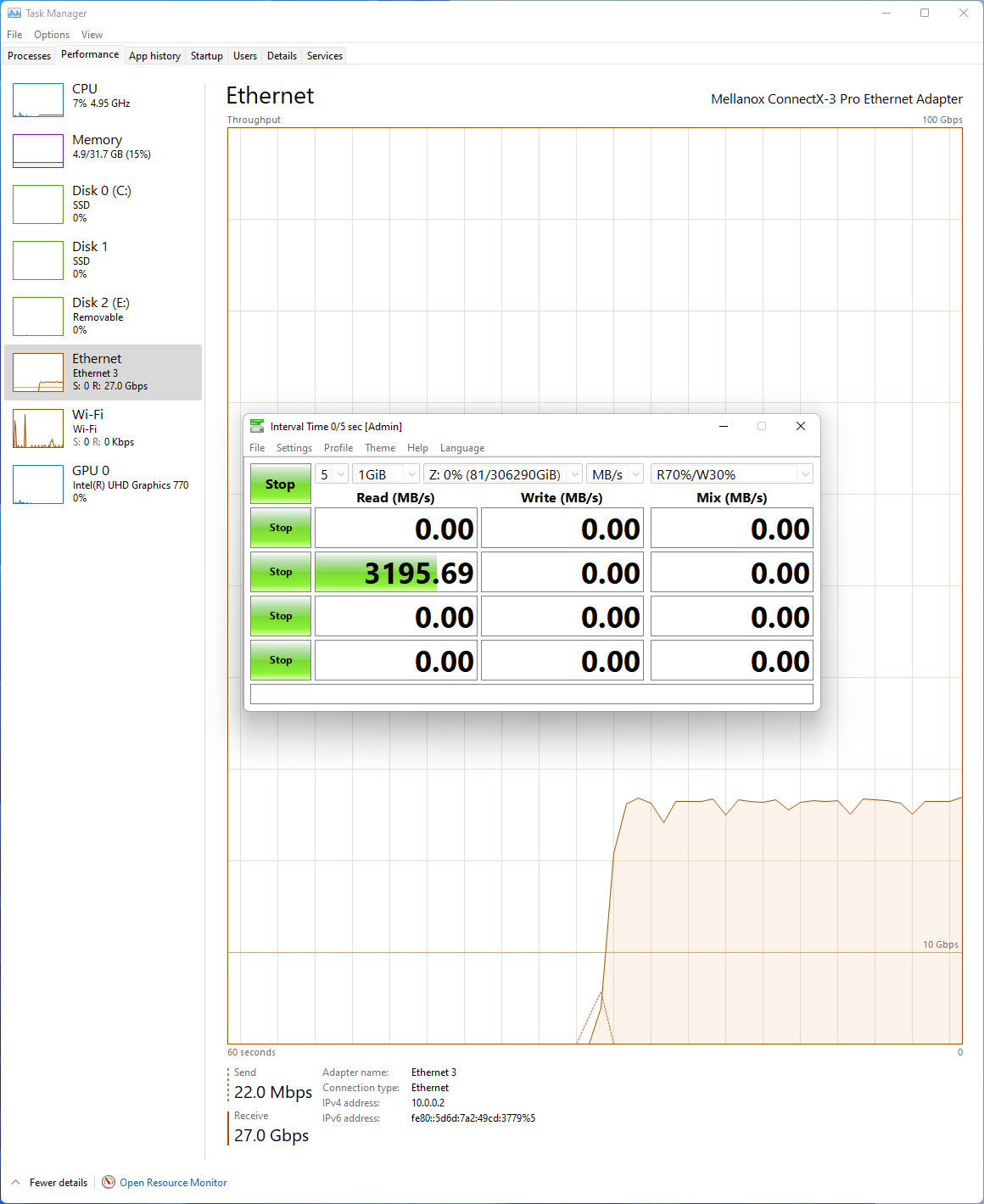

SEQ 1MiB (Q= 1, T= 1): 2242.112 MB/s [ 2138.2 IOPS] < 467.34 us>

SEQ 1MiB (Q= 8, T= 1): 3196.626 MB/s [ 3048.5 IOPS] < 2615.14 us>

RND 4KiB (Q= 1, T= 1): 80.535 MB/s [ 19661.9 IOPS] < 50.75 us>

RND 4KiB (Q= 32, T=16): 435.586 MB/s [ 106344.2 IOPS] < 4803.52 us>

[Write]

SEQ 1MiB (Q= 1, T= 1): 1176.851 MB/s [ 1122.3 IOPS] < 890.14 us>

SEQ 1MiB (Q= 8, T= 1): 1669.667 MB/s [ 1592.3 IOPS] < 4985.51 us>

RND 4KiB (Q= 1, T= 1): 46.335 MB/s [ 11312.3 IOPS] < 88.27 us>

RND 4KiB (Q= 32, T=16): 143.955 MB/s [ 35145.3 IOPS] < 13889.98 us>

[Mix] Read 70%/Write 30%

SEQ 1MiB (Q= 1, T= 1): 1746.924 MB/s [ 1666.0 IOPS] < 599.57 us>

SEQ 1MiB (Q= 8, T= 1): 2363.504 MB/s [ 2254.0 IOPS] < 3541.11 us>

RND 4KiB (Q= 1, T= 1): 49.138 MB/s [ 11996.6 IOPS] < 83.01 us>

RND 4KiB (Q= 32, T=16): 177.827 MB/s [ 43414.8 IOPS] < 11661.94 us>

醉酒棕熊 发表于 2022-3-26 20:21

门槛太高

内卷严重

后排支持

后排支持

gtx9 发表于 2022-3-26 20:18

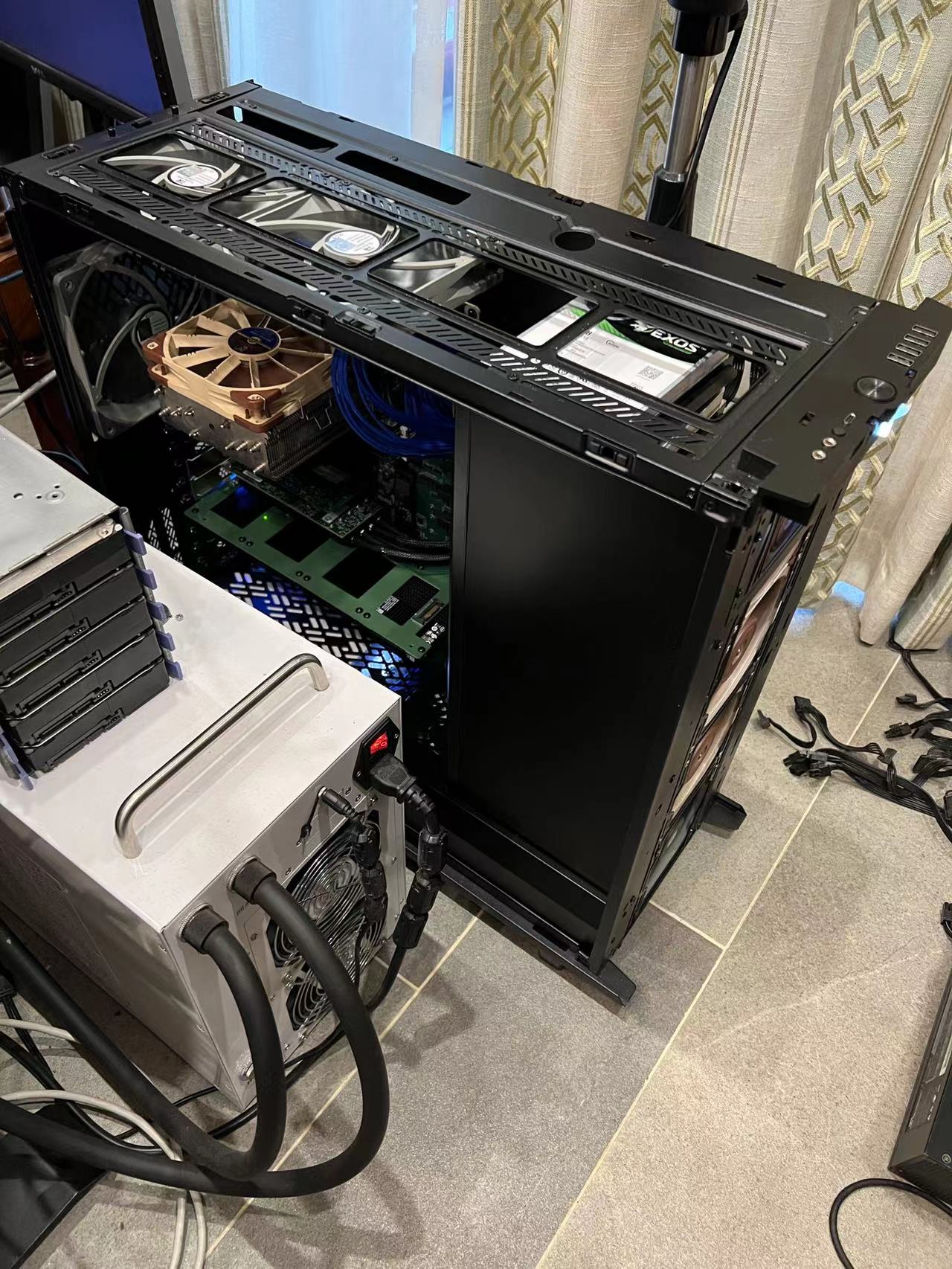

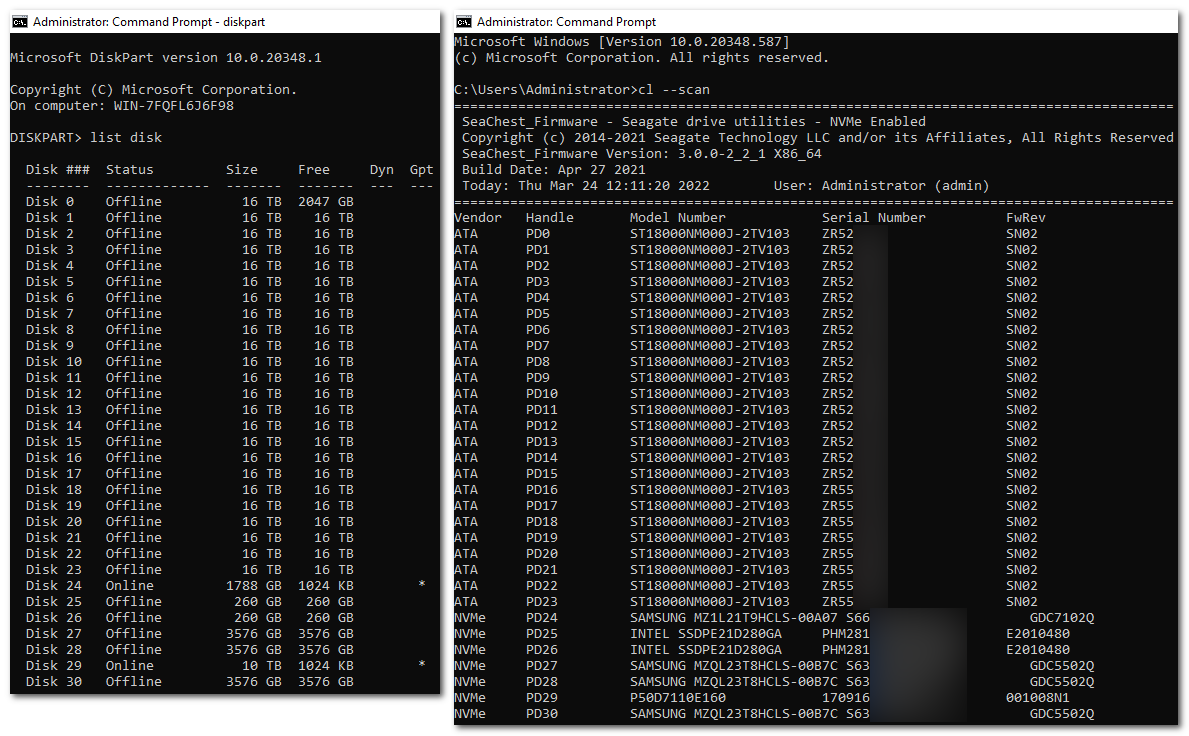

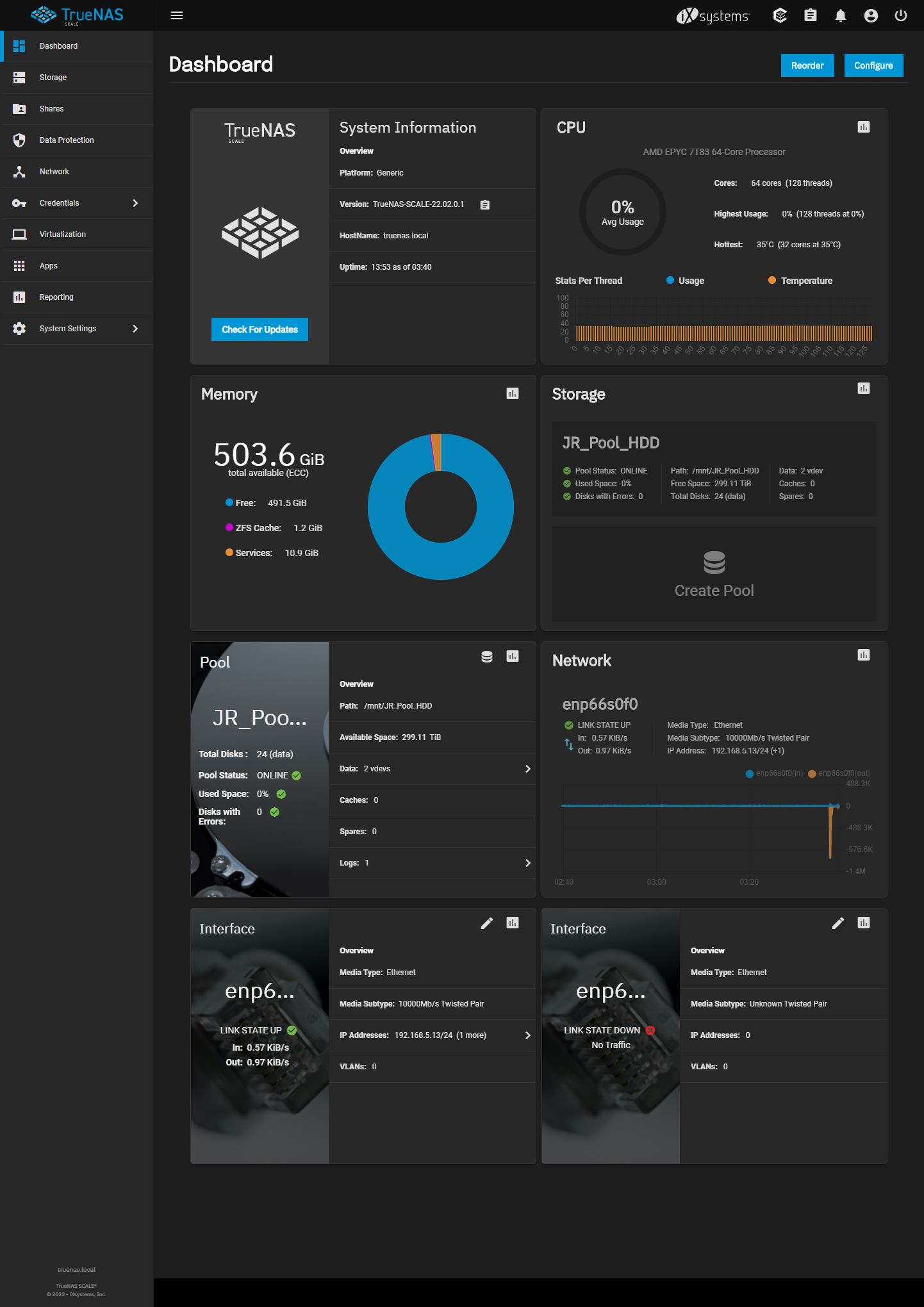

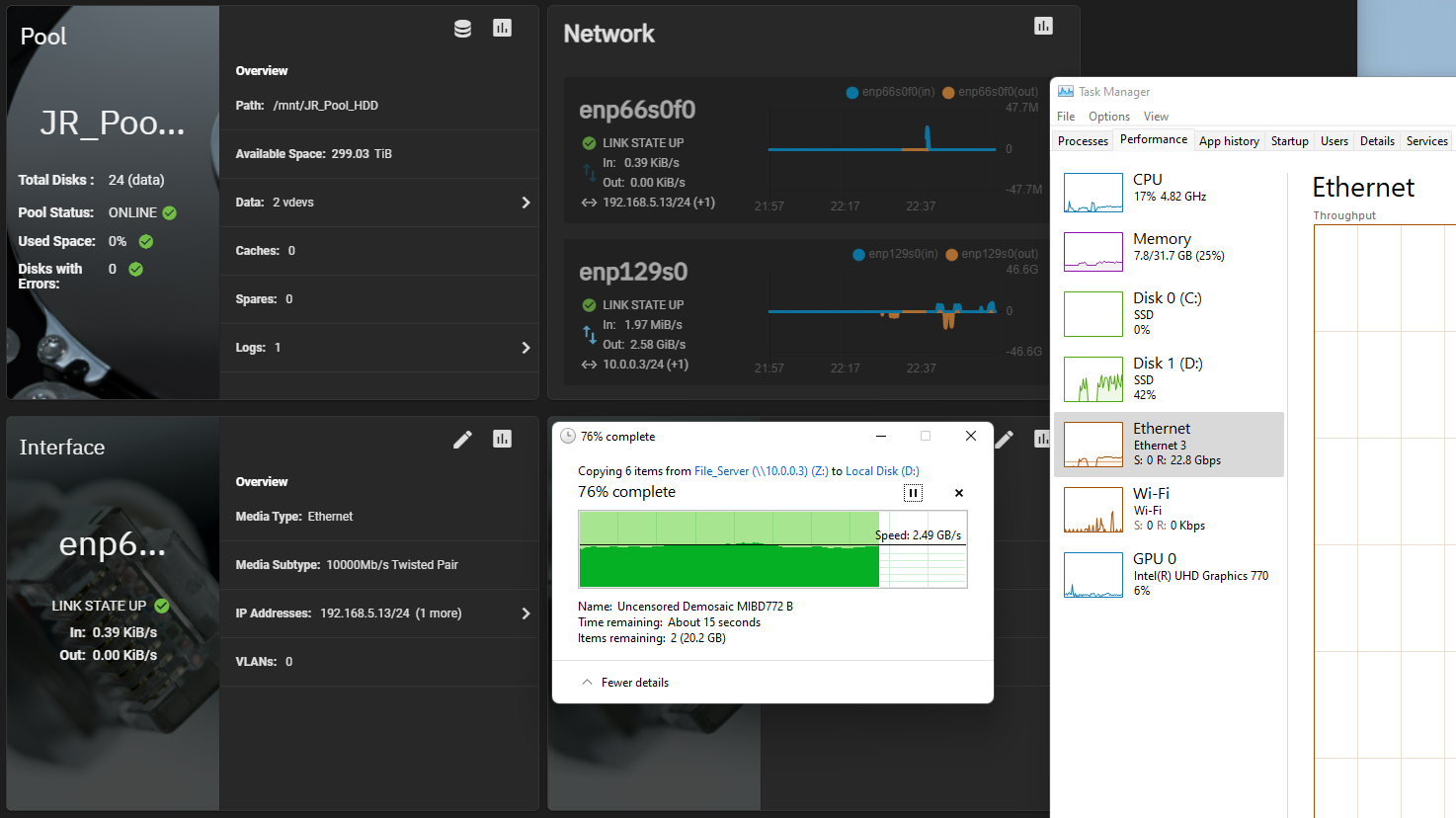

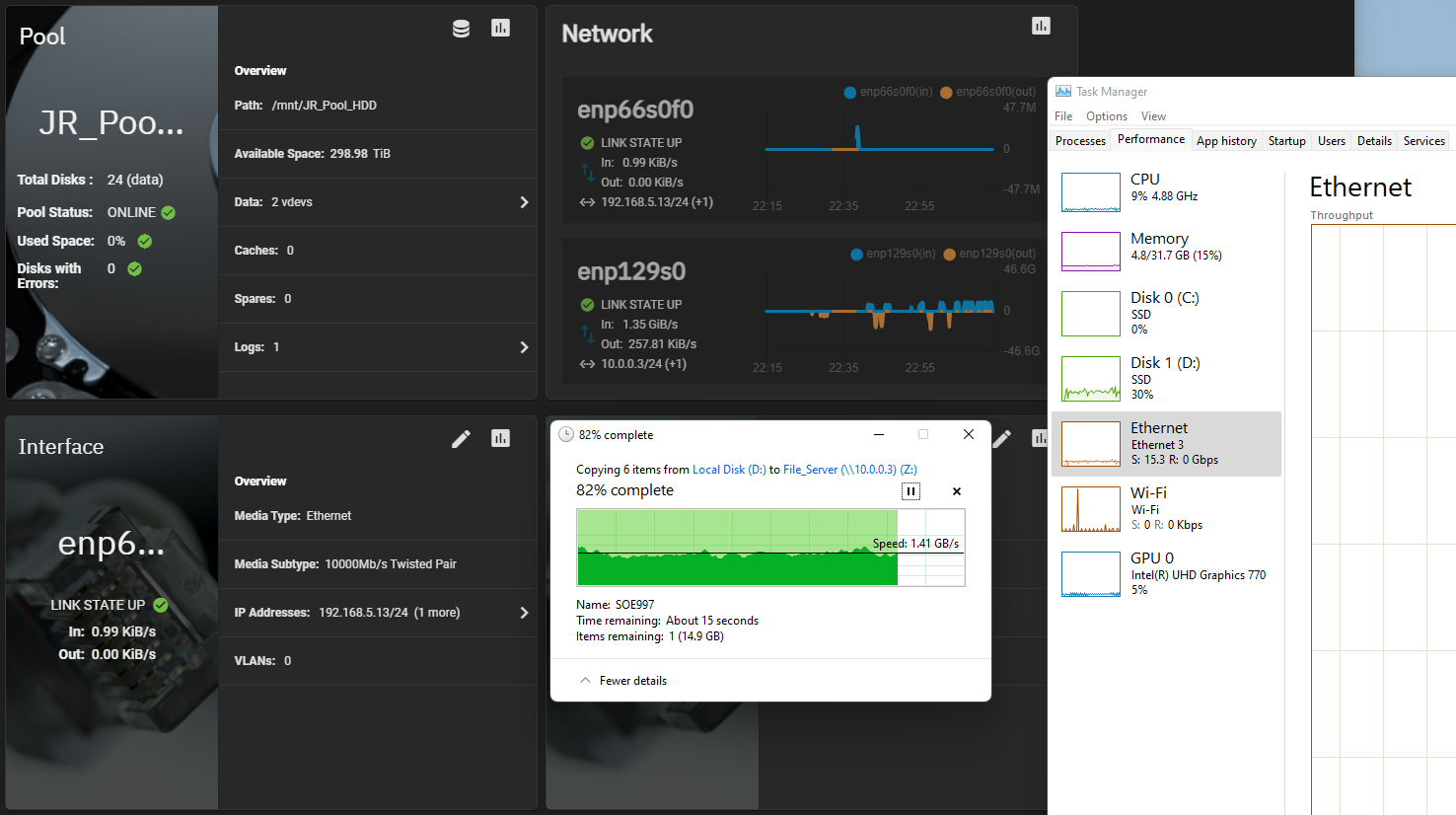

估计是目前CHH最强NAS配置了

这配置,强无敌。。。。

这配置,强无敌。。。。oldnetdog 发表于 2022-3-26 21:17

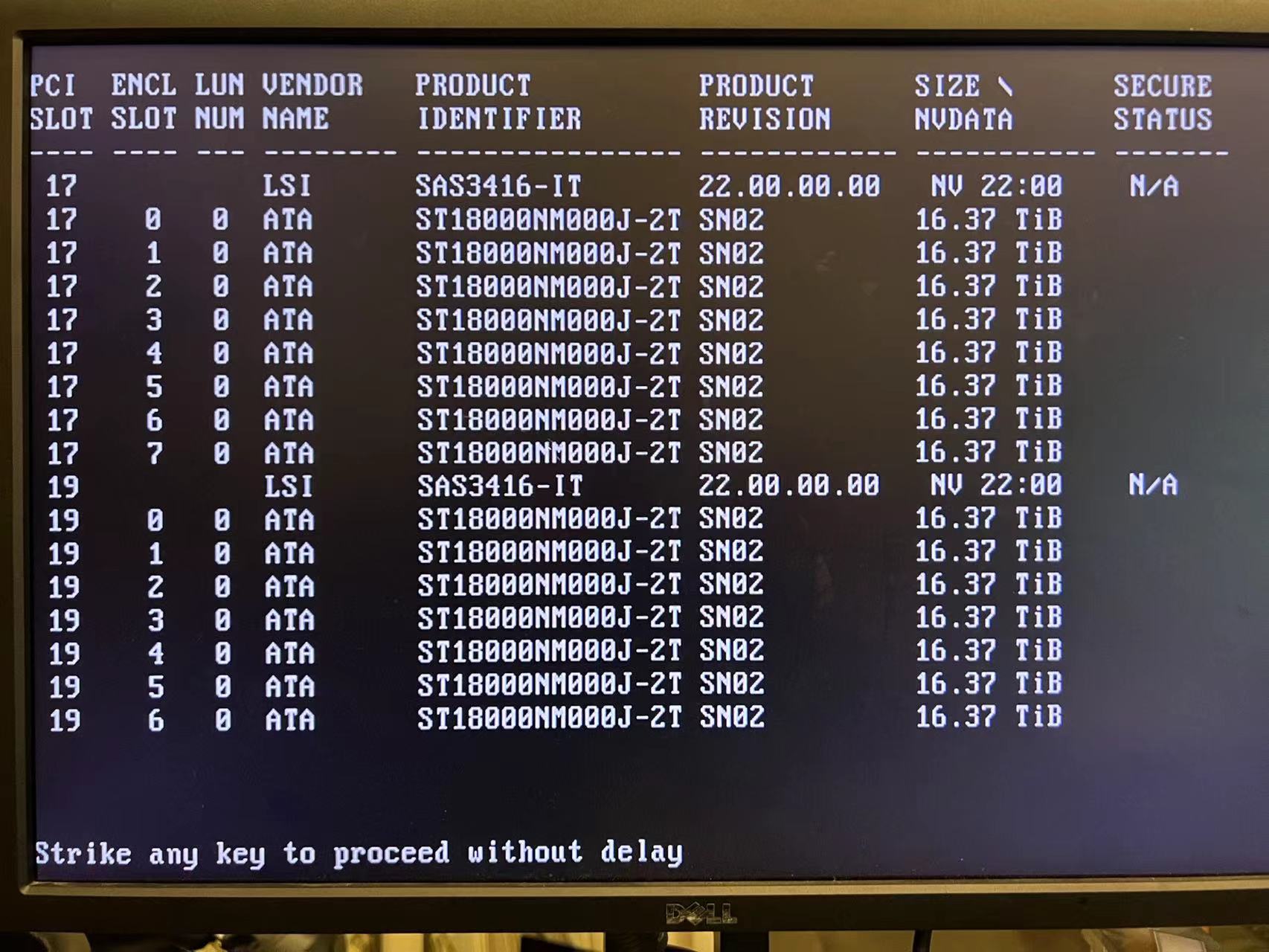

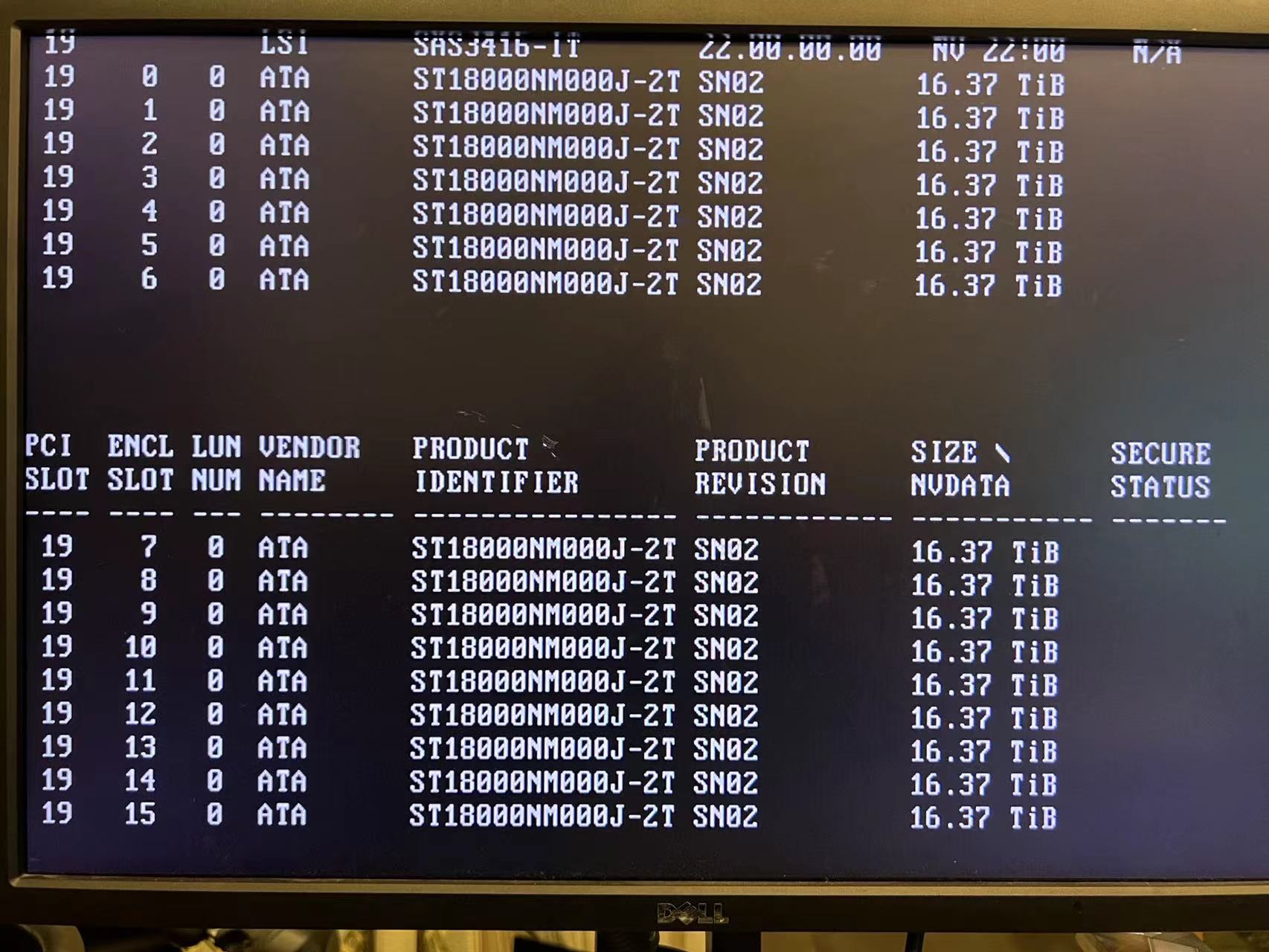

这个机箱不是只能18个3.5的HDD吗?怎么可以安装24块盘的?

lovesb 发表于 2022-3-26 20:50

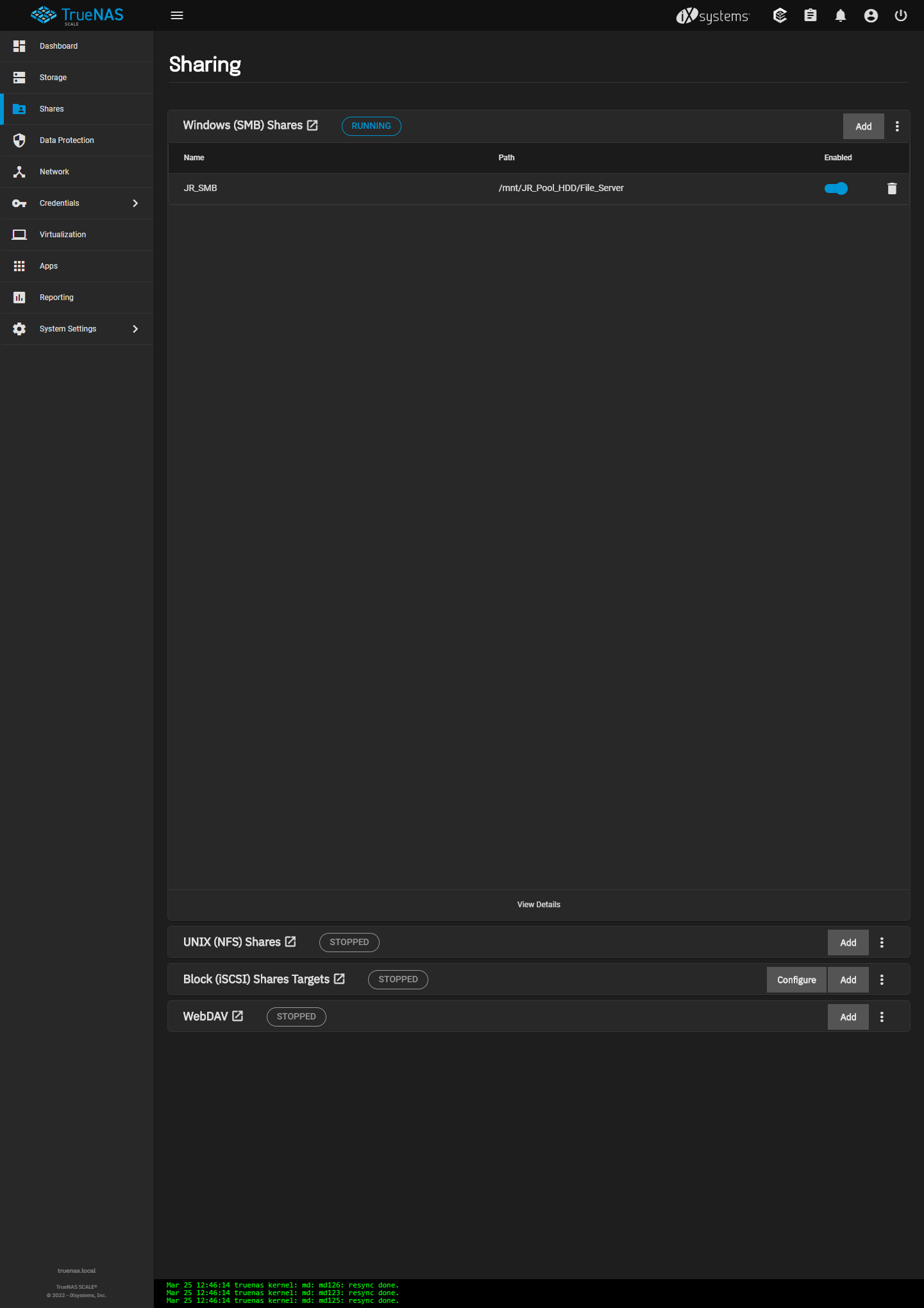

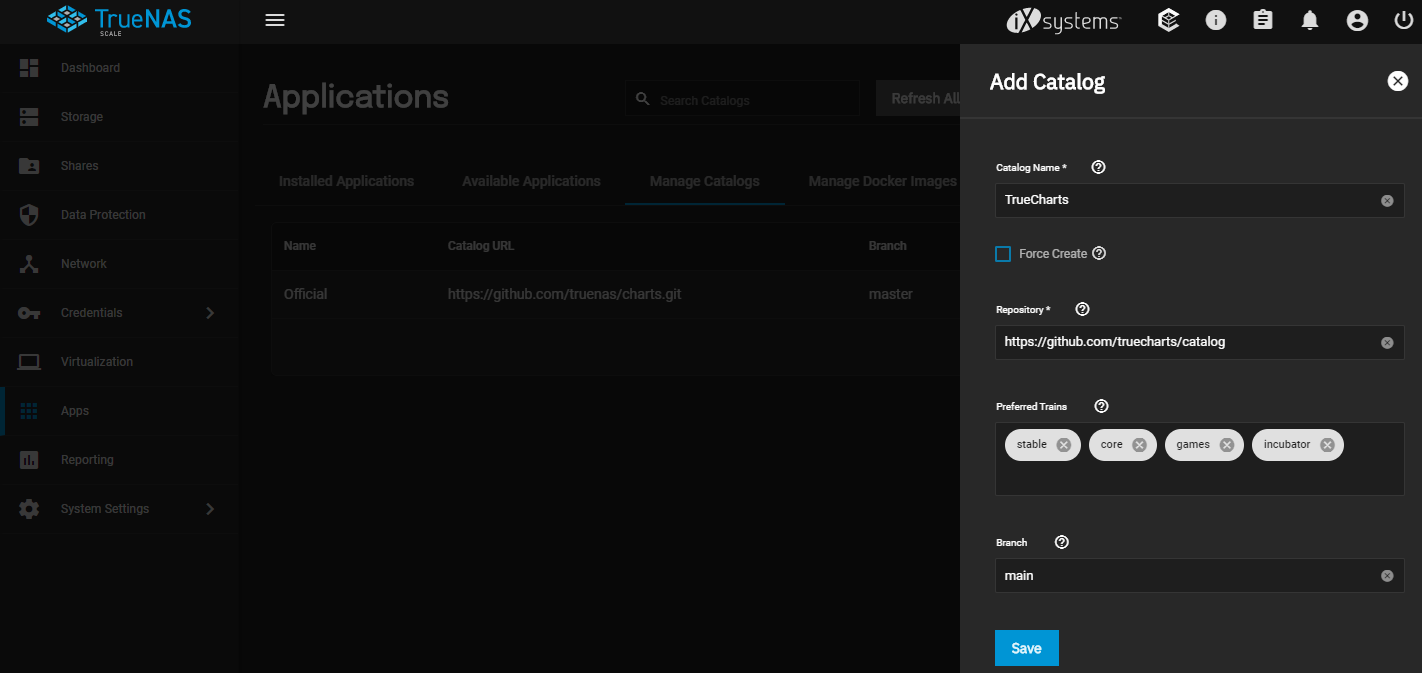

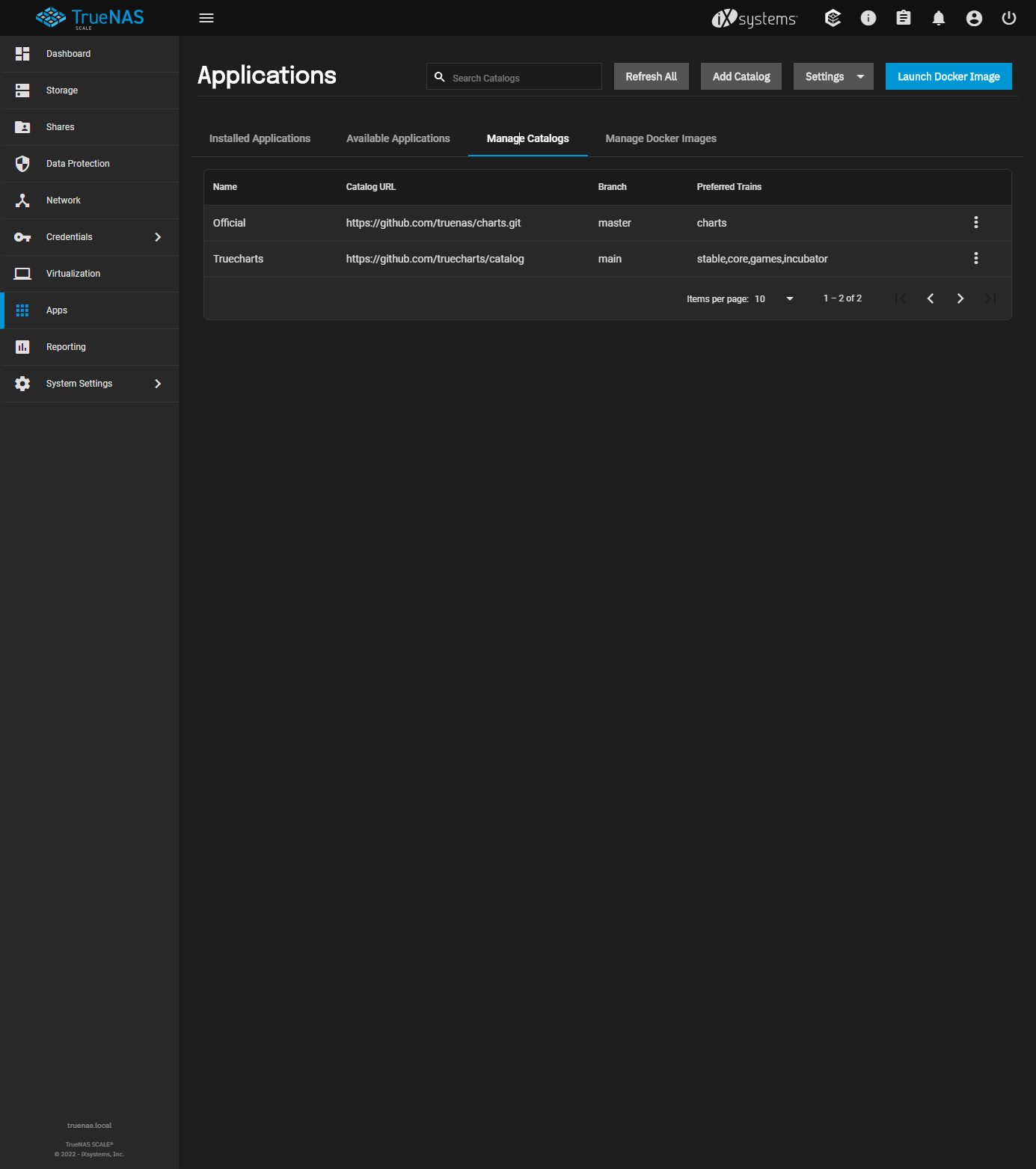

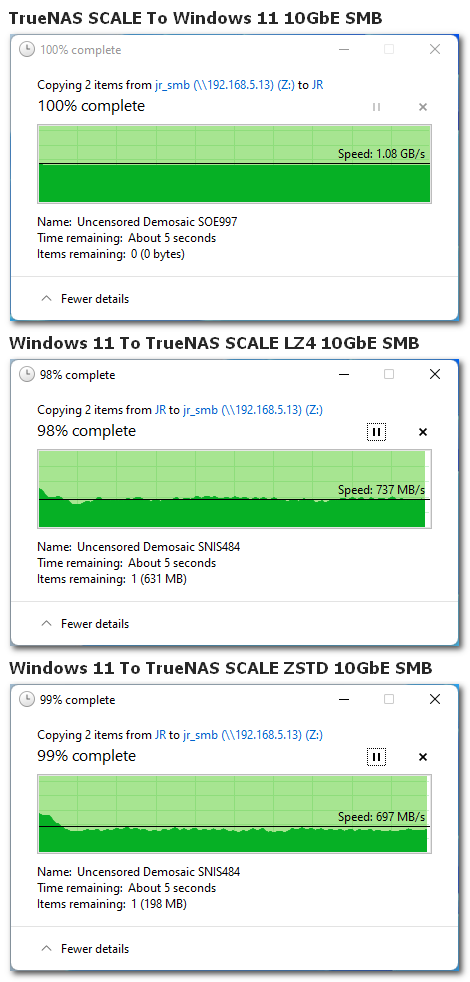

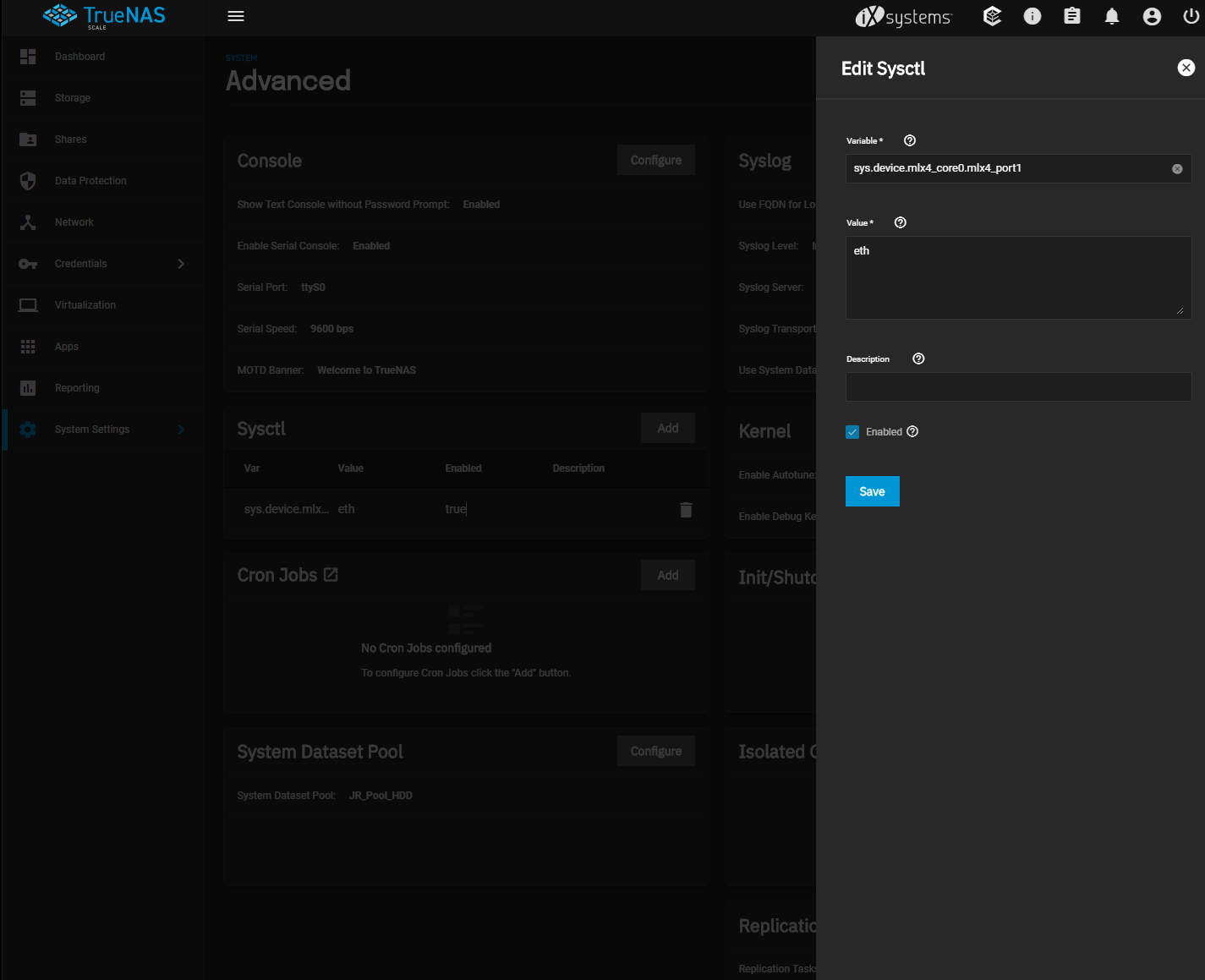

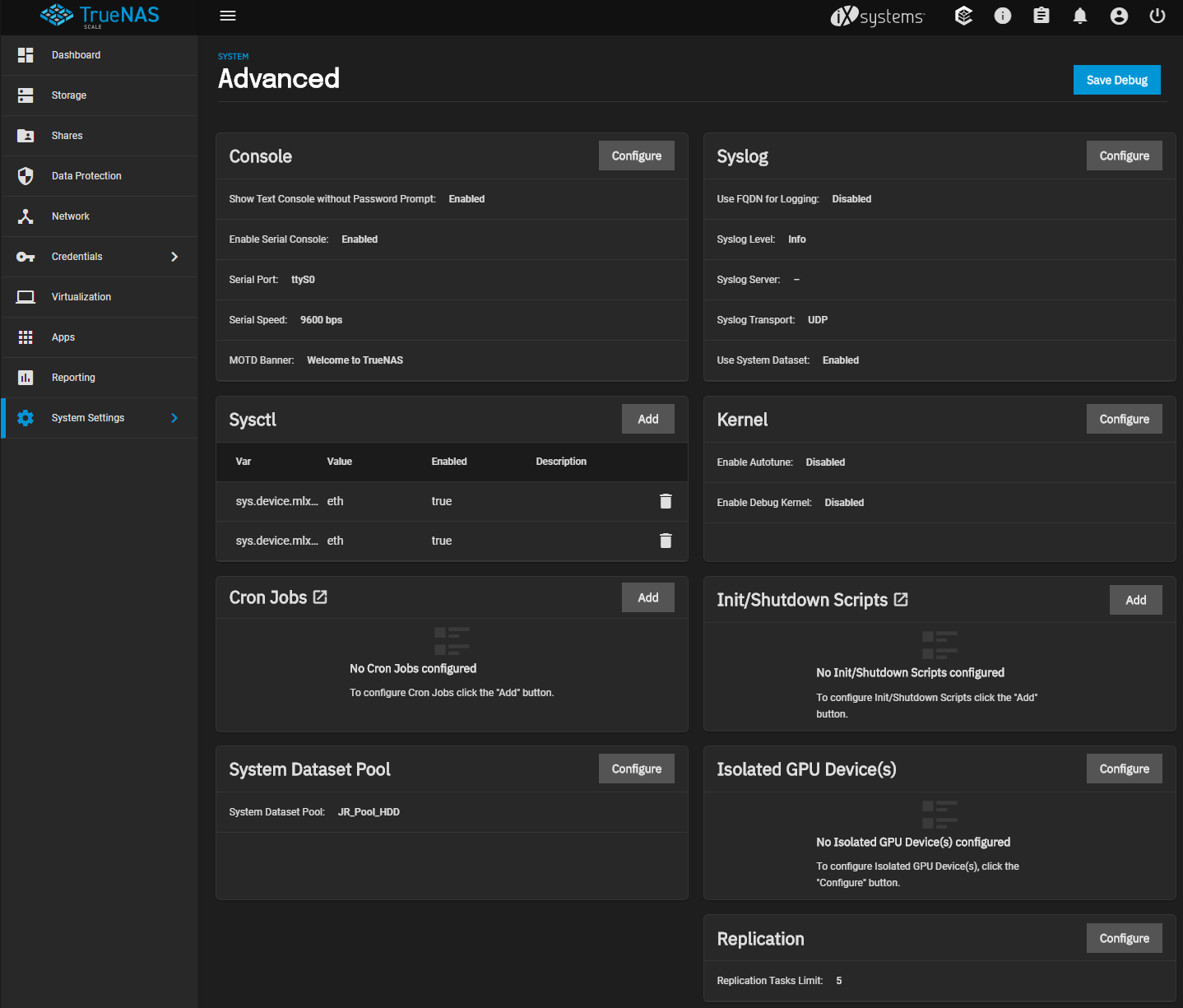

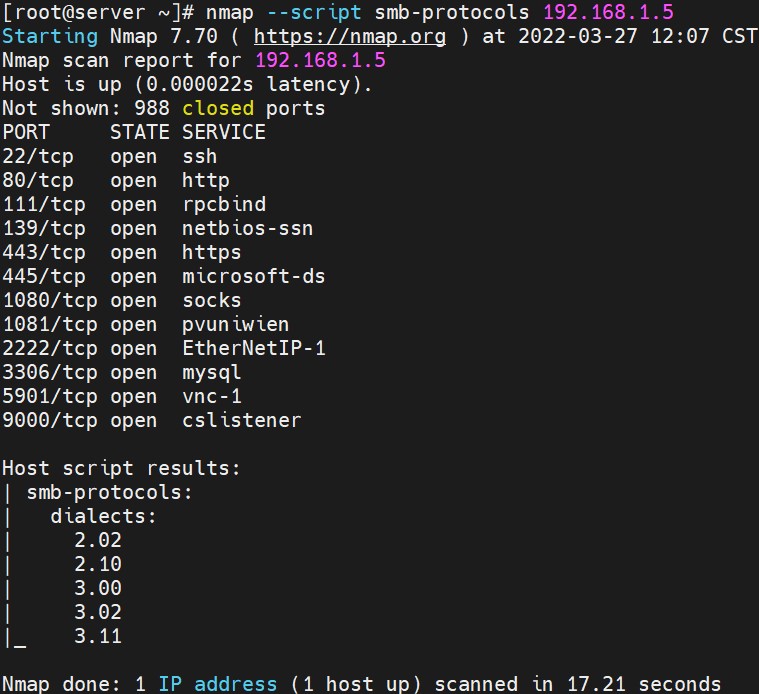

要是SCALE在smb上rdma跑40/56g就好了

有只老虎 发表于 2022-3-26 21:36

硬盘架上只能放16个

goat 发表于 2022-3-26 20:21

unraid直接不建议是因为收费吗

lovesb 发表于 2022-3-26 20:50

要是SCALE在smb上rdma跑40/56g就好了

oldnetdog 发表于 2022-3-26 21:17

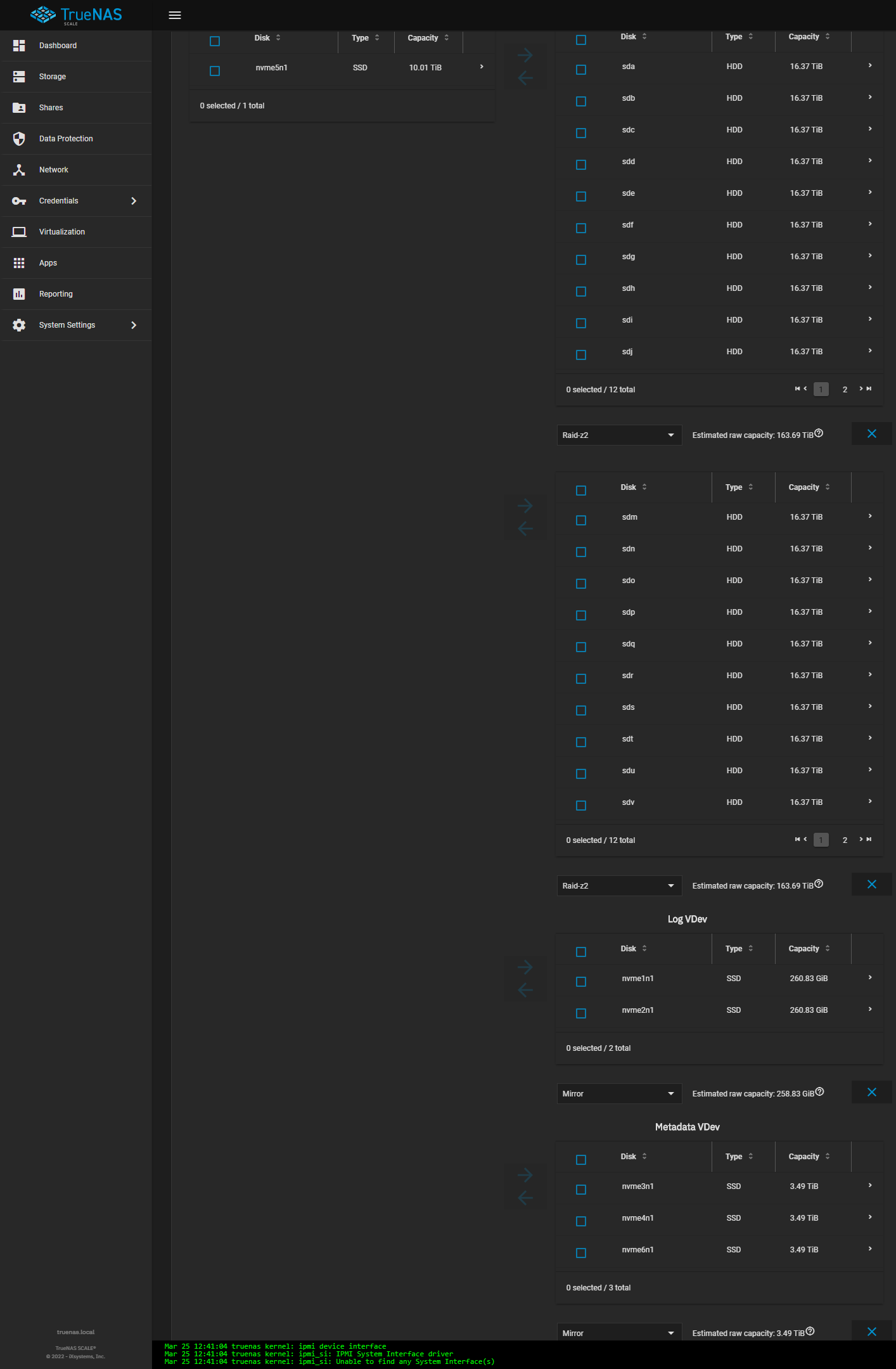

这个机箱不是只能18个3.5的HDD吗?怎么可以安装24块盘的?

linchen0950 发表于 2022-3-26 21:00

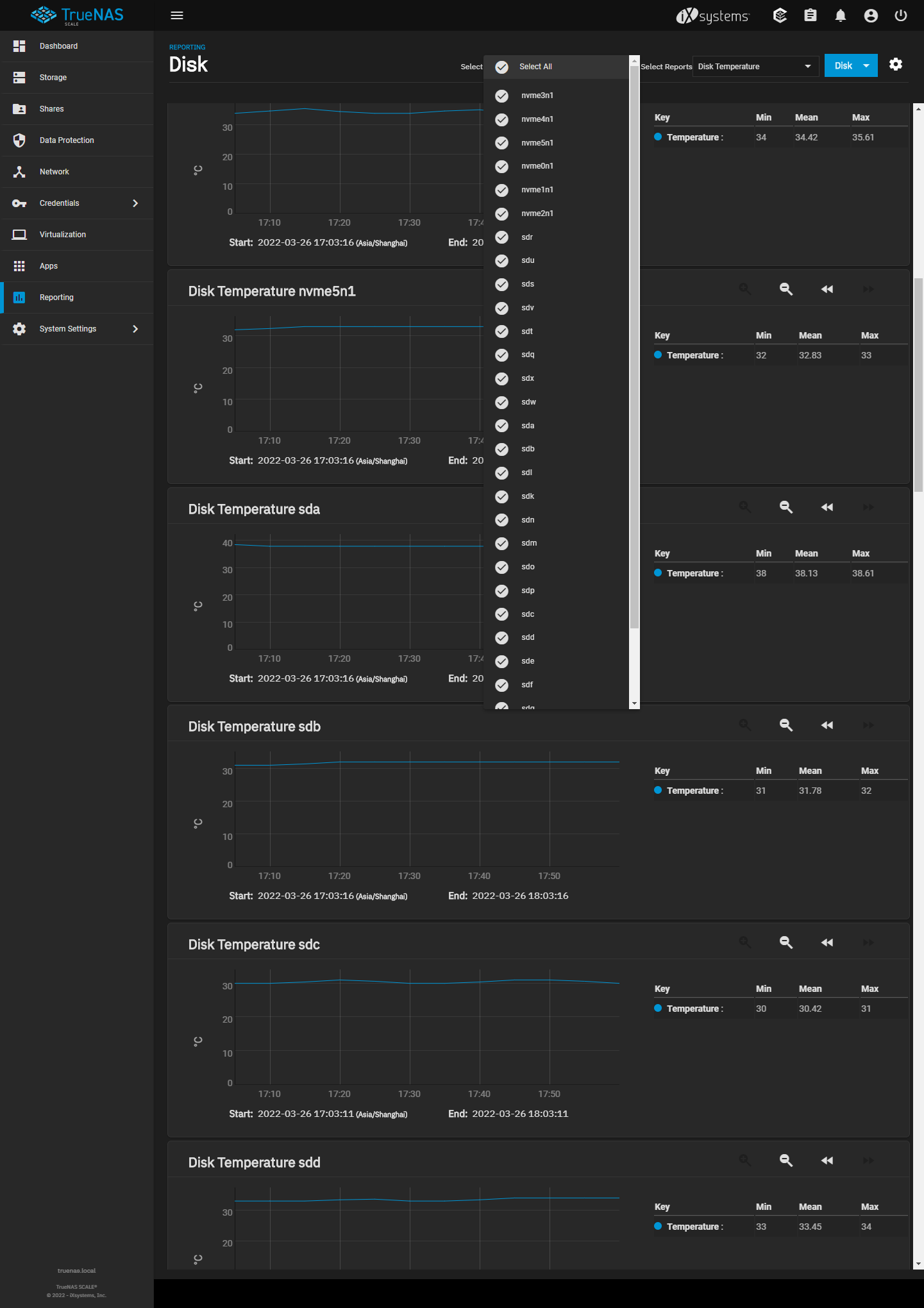

超过26个硬盘,编号是sdaa开始吗

oldnetdog 发表于 2022-3-26 21:45

J叔不是写了24块盘,不知道咋安装上的。

豪华

豪华堕天使星颖 发表于 2022-3-26 23:23

FlexRAID官网都没了。。

推荐列表里删掉

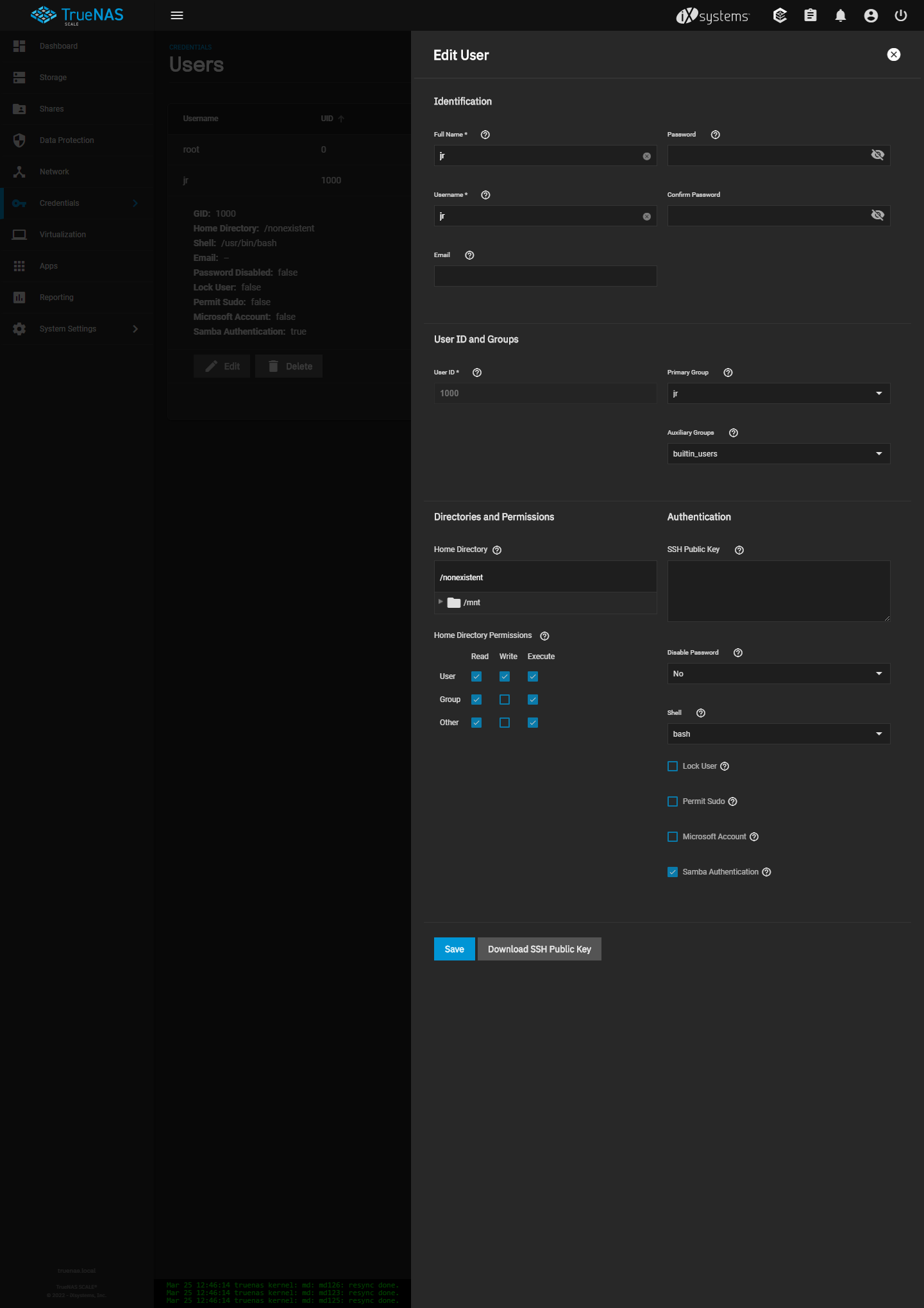

推荐列表里删掉T.JOHN 发表于 2022-3-26 22:39

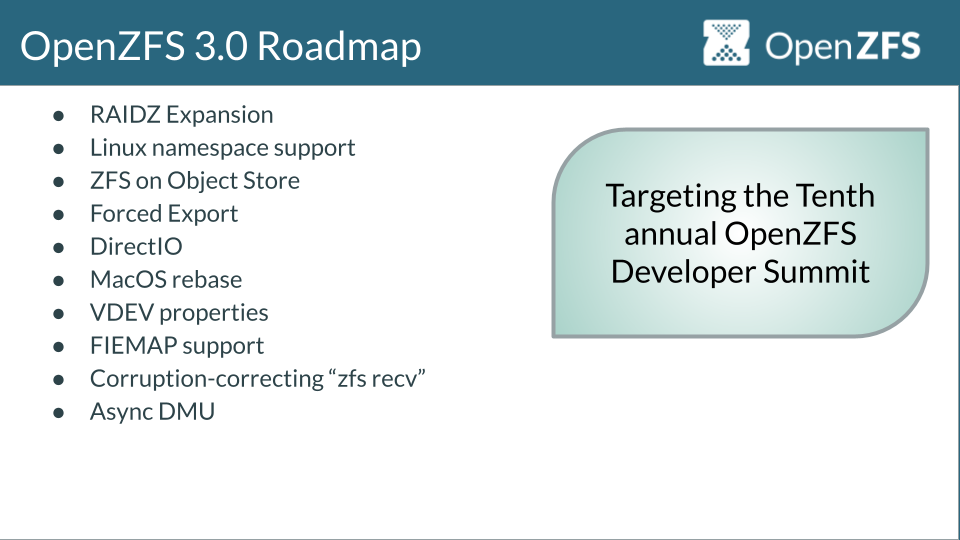

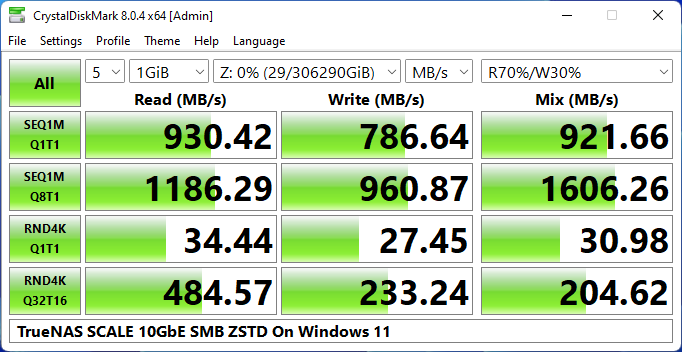

我并不觉得scale性能会比core差到哪里去,openzfs代码统一以后区别只是freebsd和linux两个底层操作系统较量 ...

jerrytsao 发表于 2022-3-26 21:46

UnRAID更多的是Marketing, 就像一个魔改版JBOD, Parity不完全, Reliability也不够, 还要付费, 唯一的强项 ...

T.JOHN 发表于 2022-3-26 22:39

我并不觉得scale性能会比core差到哪里去,openzfs代码统一以后区别只是freebsd和linux两个底层操作系统较量 ...

jerrytsao 发表于 2022-3-26 23:42

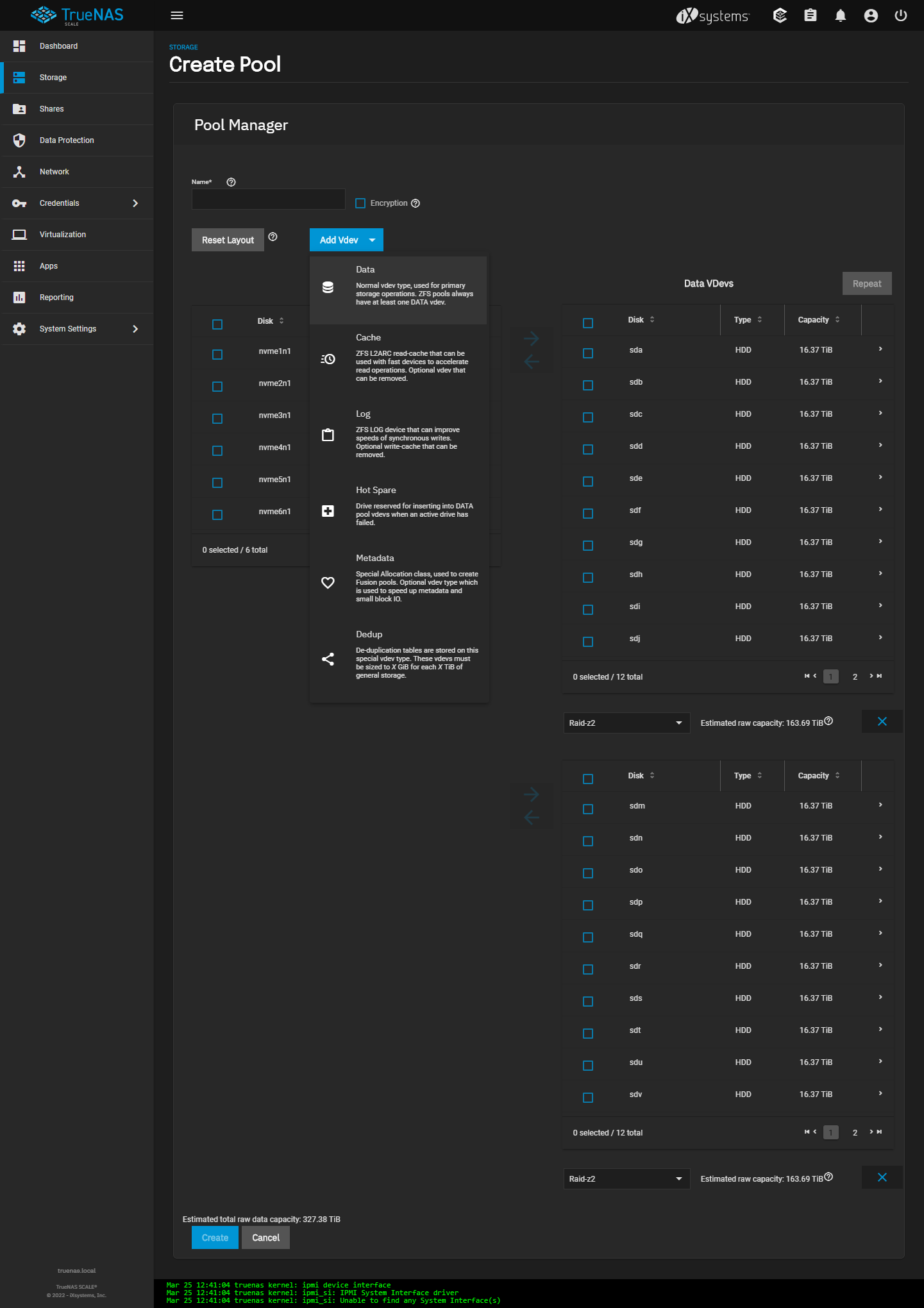

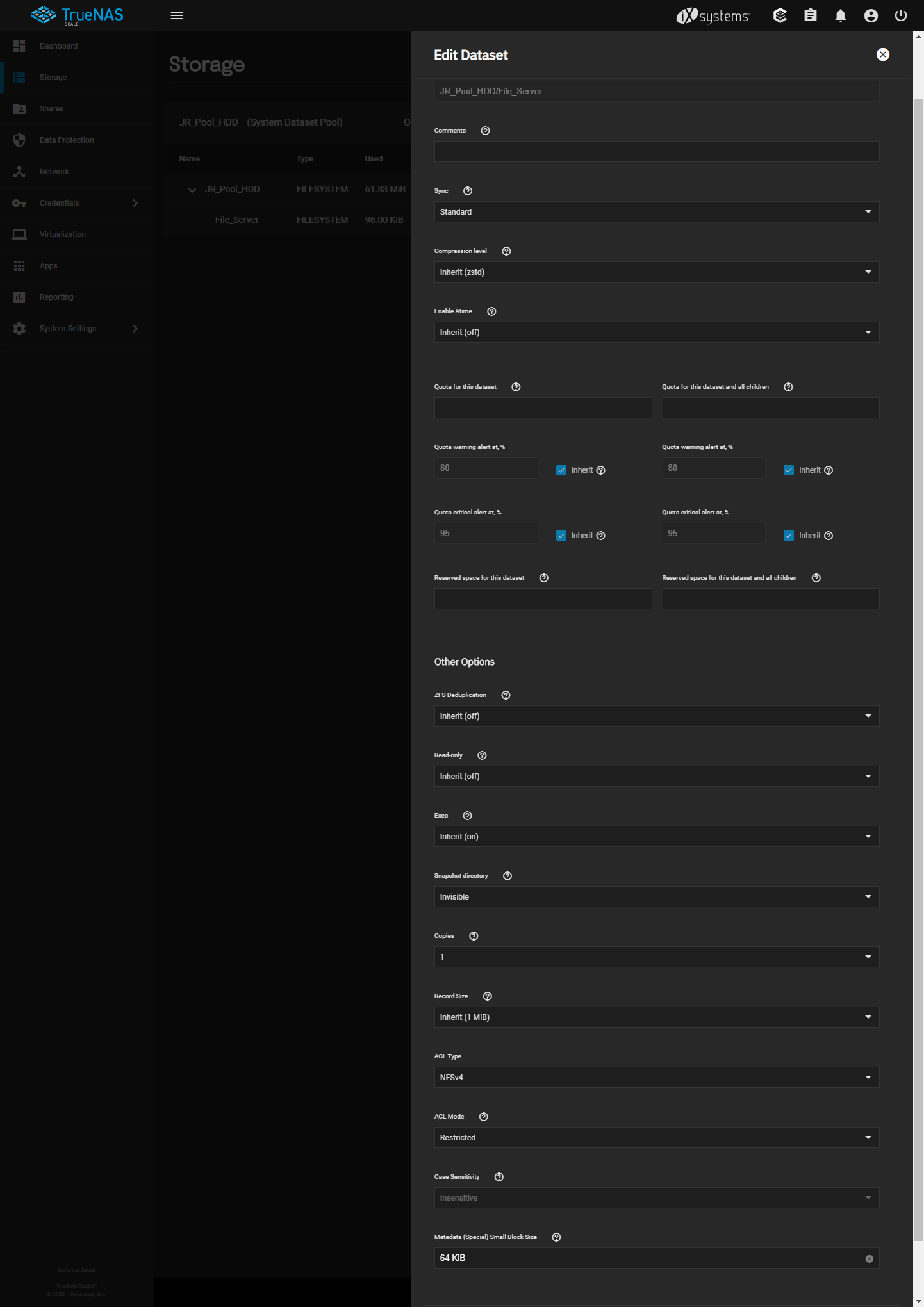

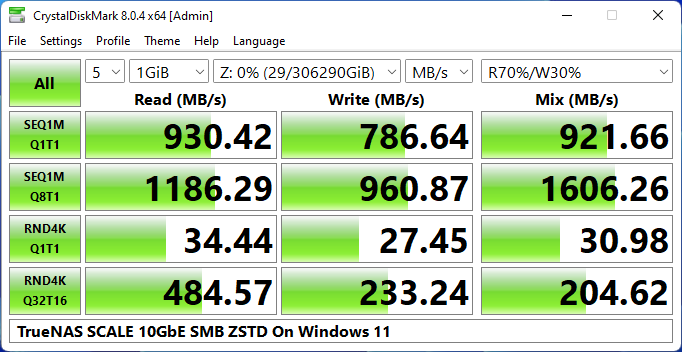

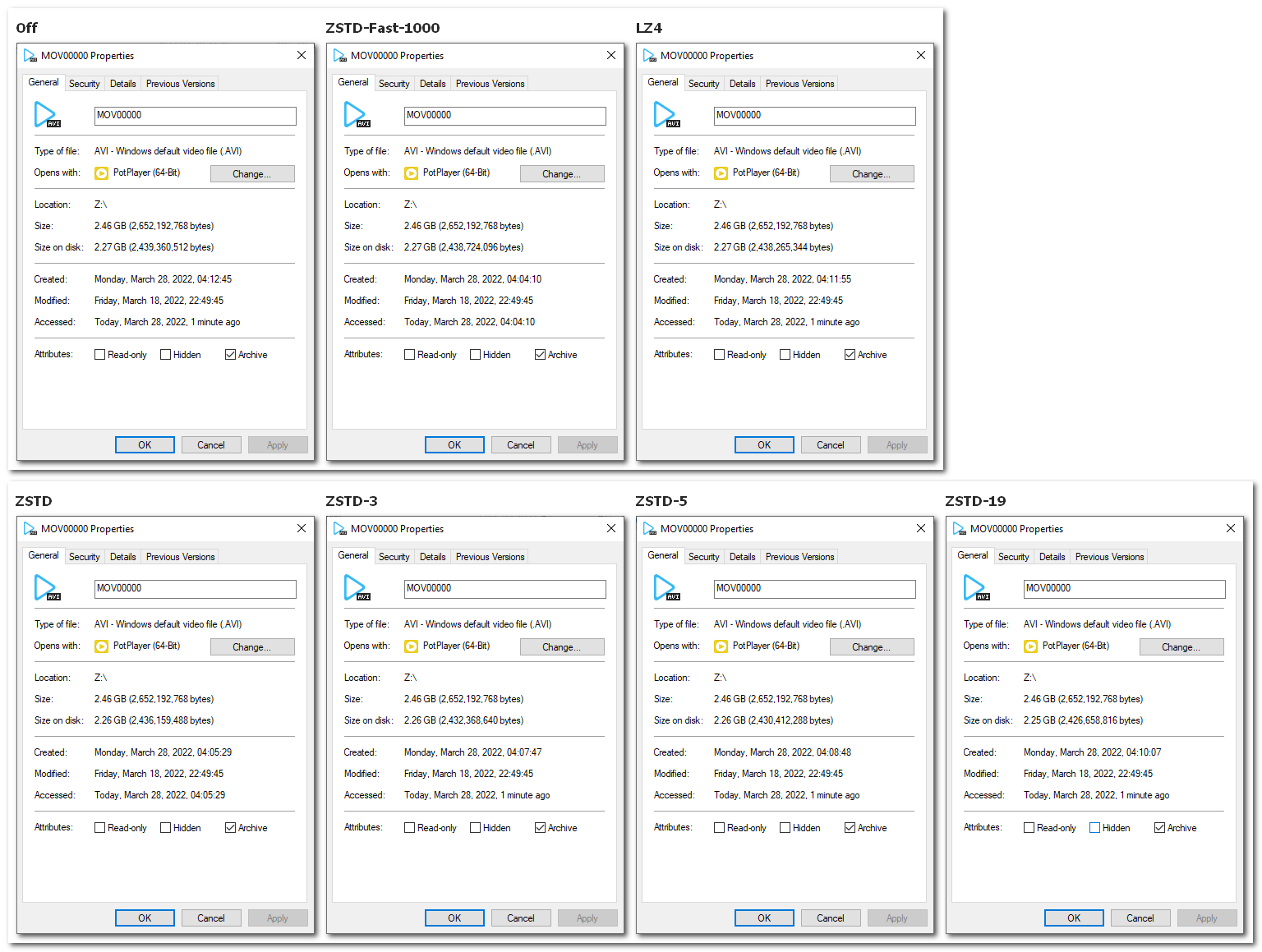

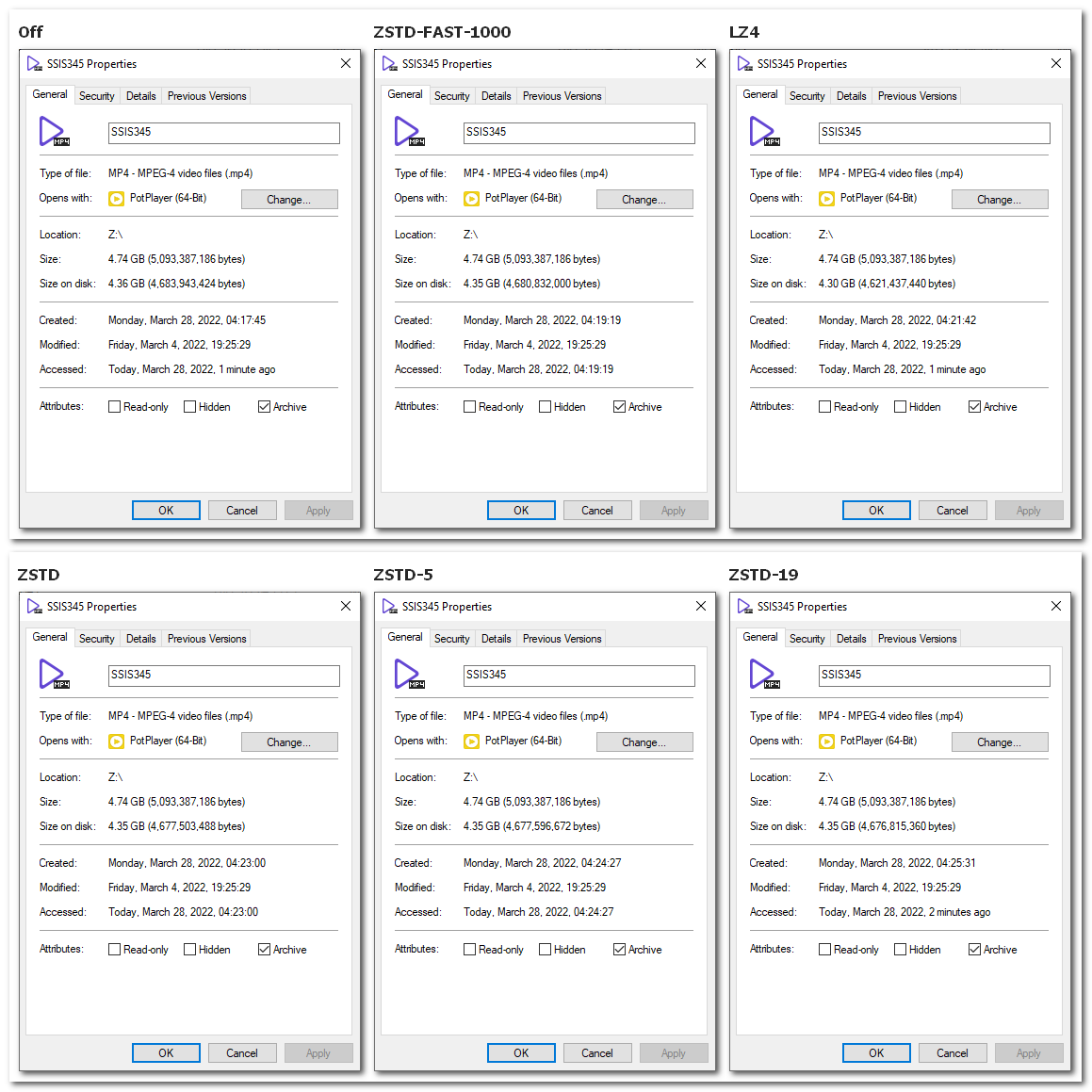

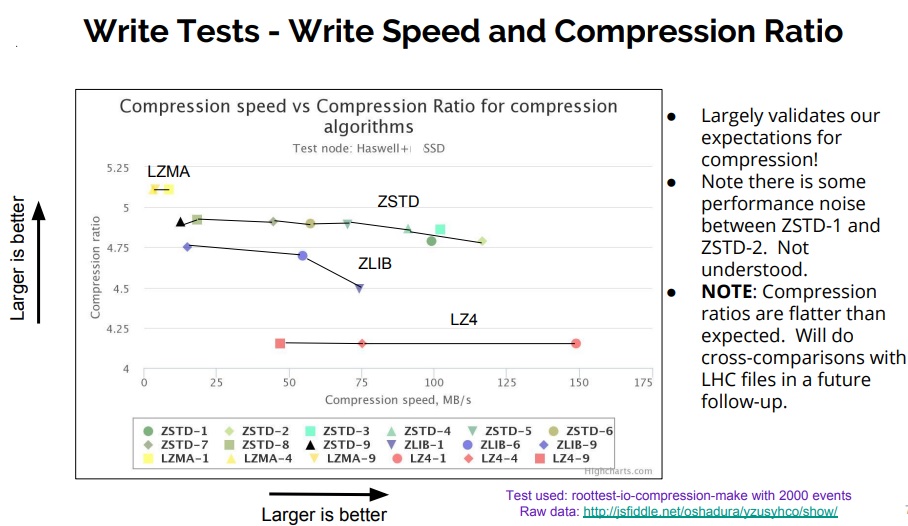

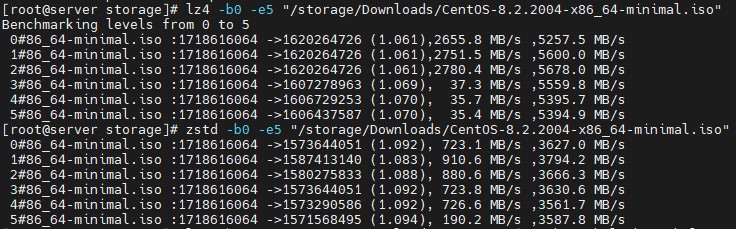

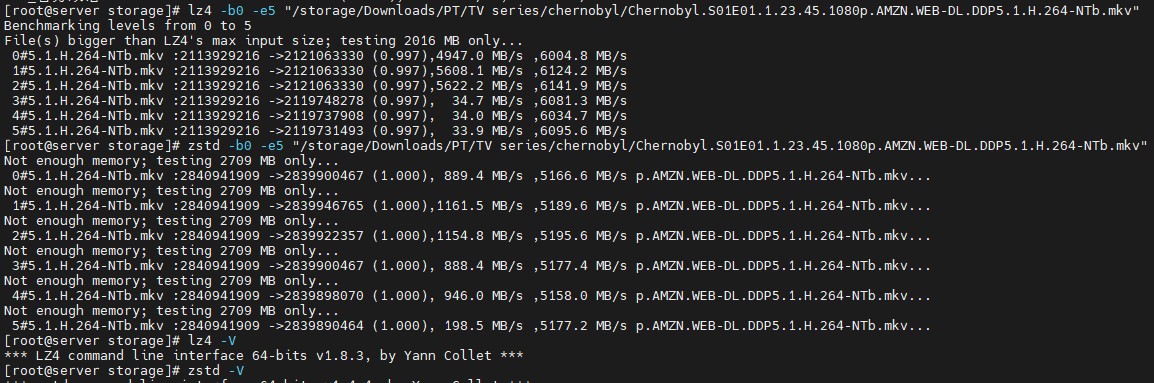

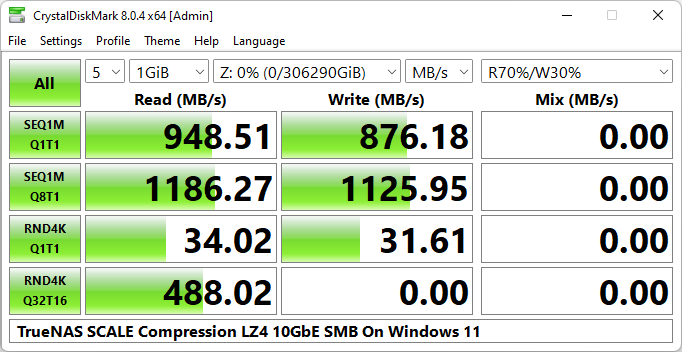

选ZSTD无后缀, ZSTD-1还是ZSTD-19, 看了些文档还不是很明确, 7T83确实应该利用其压缩/解压性能优势 ...

T.JOHN 发表于 2022-3-26 22:39

我并不觉得scale性能会比core差到哪里去,openzfs代码统一以后区别只是freebsd和linux两个底层操作系统较量 ...

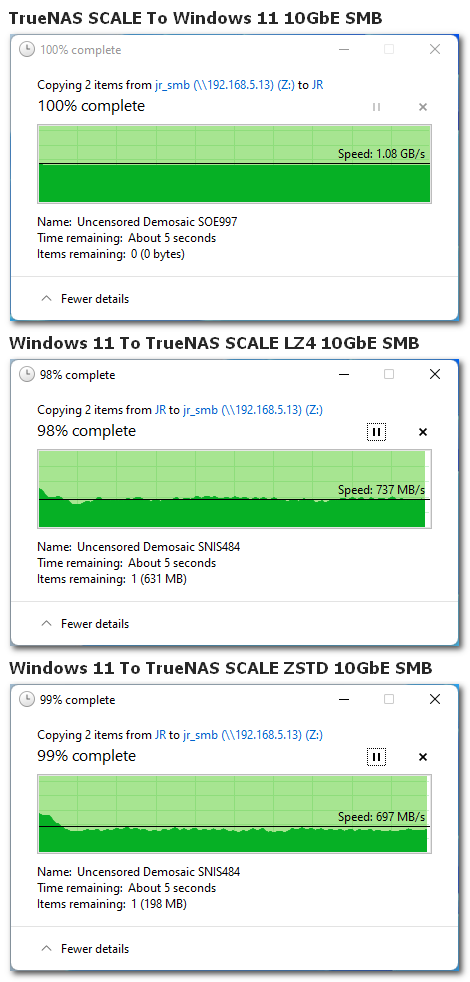

至于性能这个不信的话你可以自己测一下看看,我又不是瞎吹

至于性能这个不信的话你可以自己测一下看看,我又不是瞎吹jerrytsao 发表于 2022-3-26 23:42

选ZSTD无后缀, ZSTD-1还是ZSTD-19, 看了些文档还不是很明确, 7T83确实应该利用其压缩/解压性能优势 ...

Juzi丶 发表于 2022-3-27 06:12

至于性能这个不信的话你可以自己测一下看看,我又不是瞎吹

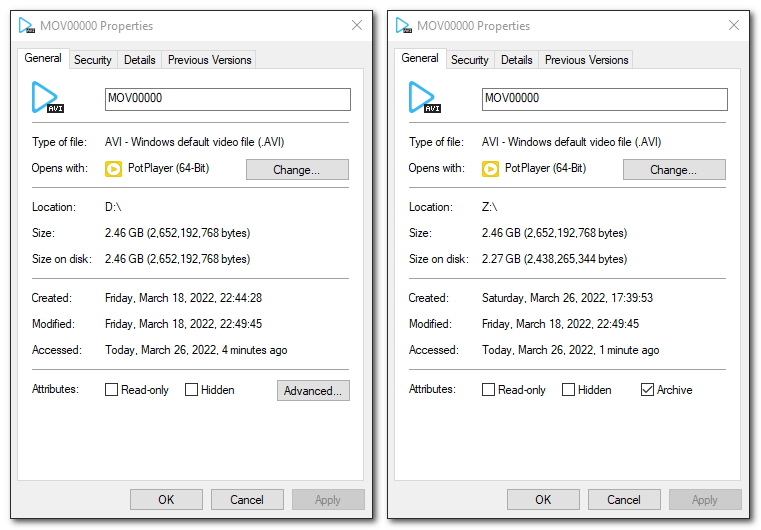

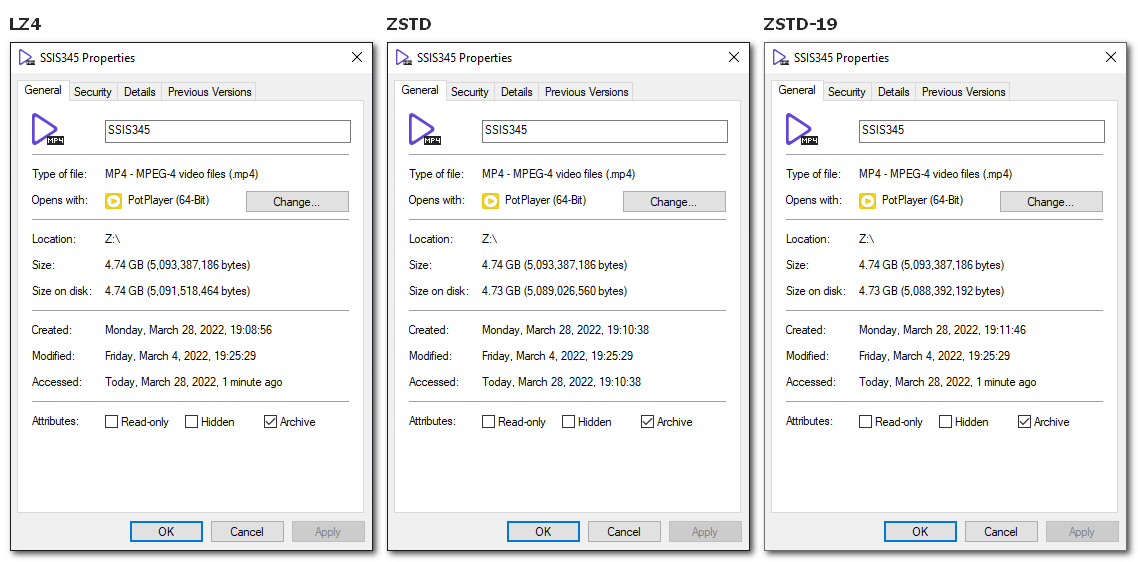

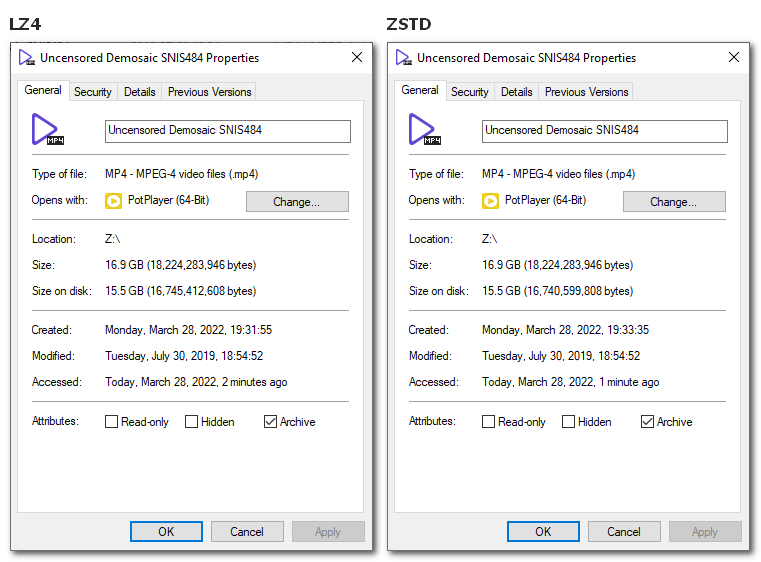

就记录大小来举例

leeosx 发表于 2022-3-26 23:53

大佬。我全默认设置 18个18t...为啥samba共享下面读写速度基本上就是600/200的样子raidz2...文件是单个60 ...

T.JOHN 发表于 2022-3-27 12:24

先查本地性能再查smb问题

1. 本地性能可以用fio测

T.JOHN 发表于 2022-3-27 12:24

先查本地性能再查smb问题

1. 本地性能可以用fio测

kingkiss 发表于 2022-3-27 19:02

大神 按照你的方法用FIO测试了一下各个池读取都正常但是写入诡异的只有430MB/S左右,一个8盘HDD raidz2, ...

T.JOHN 发表于 2022-3-27 19:51

上面给的命令是测区块大小128k,单线程,单队列深度的吞吐量。

8盘HDD raidz2 430MB/S偏低,但我不能说 ...

kingkiss 发表于 2022-3-27 19:57

用新的代码测试了一下,写入速度还是只有500M/S,盘是铠侠CD6 7.68T 4个,组的raidz1,读取速度倒是正常的 ...

T.JOHN 发表于 2022-3-27 20:25

读速度正常说明硬件都没问题,你所有池的写卡450MB/S就很奇怪了,所以我觉得测错目录了,除此之外我想不 ...

kingkiss 发表于 2022-3-27 20:46

我也觉得很奇怪,一直找不到原因

T.JOHN 发表于 2022-3-27 10:44

偏向省空间选5,偏向性能得选1,或者负值。可以参考 https://community.centminmod.com/threads/round-4- ...

jerrytsao 发表于 2022-3-27 23:04

每个原盘文件夹下(除BDMV子文件夹之外)有一些小文件, 其它基本都是视频文件了

反正CPU性能高, 主存容量 ...

T.JOHN 发表于 2022-3-28 00:26

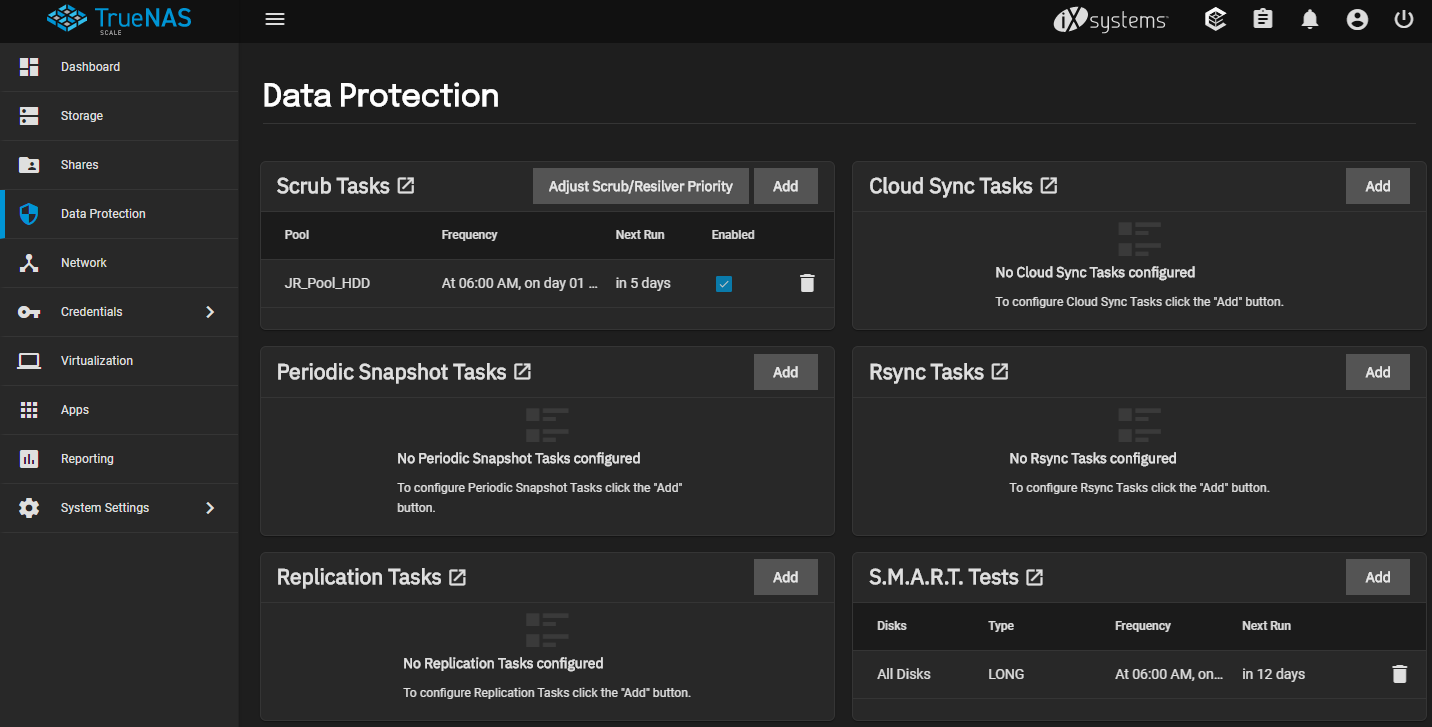

19我只能说充分利用CPU

scrub和smart长测我觉得不用两周一次那么频繁的,一个月一次就很充分了。白 ...

T.JOHN 发表于 2022-3-28 00:26

19我只能说充分利用CPU

scrub和smart长测我觉得不用两周一次那么频繁的,一个月一次就很充分了。白 ...

jerrytsao 发表于 2022-3-28 16:02

小试了下视频文件ZSTD-19是毫无意义了, 且传输变得非常不稳定, 我感觉TrueNAS似乎无法吃CPU多线程?

目测 ...

T.JOHN 发表于 2022-3-27 21:36

你写的时候clat percentiles(us)是HDD水平,lat(msec) 10=89.7%,意思延时总体是10ms,我看了下我之前机 ...

goat 发表于 2022-3-26 23:43

但是现在snapraid要跑crontab,flex好像几乎处于停滞状态。开箱即食,又可以整合一堆乱乱七八糟容量且带 ...

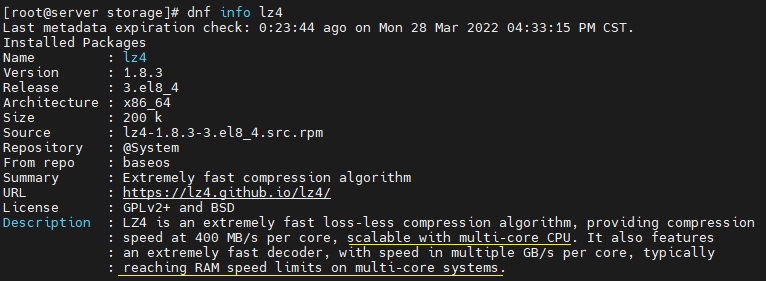

T.JOHN 发表于 2022-3-28 17:21

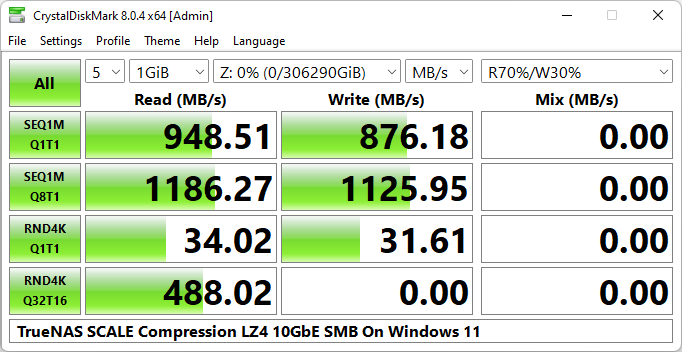

如果实测LZ4比ZSTD还好的话,那肯定用LZ4了,虽然这个结果和我测得不一样。

是否支持多线程取决于Truena ...

kingkiss 发表于 2022-3-28 18:54

我把fio命令里面的/zpool/GAMES替换成/mnt/GAMES写入速度就正常了,很神奇。

看来应该是truenas 共享的问 ...

jerrytsao 发表于 2022-3-28 19:36

感谢测试, 你这个应该是128KiB Record Size下的吧, 我刚才还是在Win下SMB简单测试了下128KiB, LZ4倒没有 ...

mkkkno1 发表于 2022-3-28 19:07

试试OMV(openmediavault)啥,虽然我用的是ubuntu+snapraid+mergerFS,因为我装OMV不是这里有点问题就是 ...

。其实snapraid+mergerFS是最经济+合理,但是因为万一手贱更新/bug导致cron没跑,又有硬盘下线就

。其实snapraid+mergerFS是最经济+合理,但是因为万一手贱更新/bug导致cron没跑,又有硬盘下线就

goat 发表于 2022-3-28 21:41

omv看功能里没提可以合并不同vol。我主要需求就是一堆旧硬盘塞归档,要求带校验。目前符合需求有人维护的 ...

mkkkno1 发表于 2022-3-28 21:46

你搜索下omv+mergerFS 呀。 肯定可以,不过要装omv-extras,而且名字变成了unionfilesystem ...

T.JOHN 发表于 2022-3-28 20:10

是的,我是用默认128KiB做的测试,看来应该是recordsize差异造成的测试结果不同。

看来1MiB确实非常适合 ...

leeosx 发表于 2022-3-26 23:53

大佬。我全默认设置 18个18t...为啥samba共享下面读写速度基本上就是600/200的样子raidz2...文件是单个60 ...

kingkiss 发表于 2022-3-27 08:23

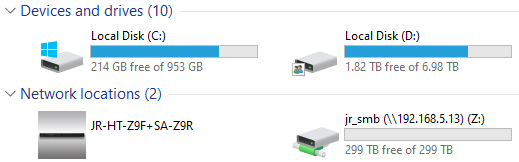

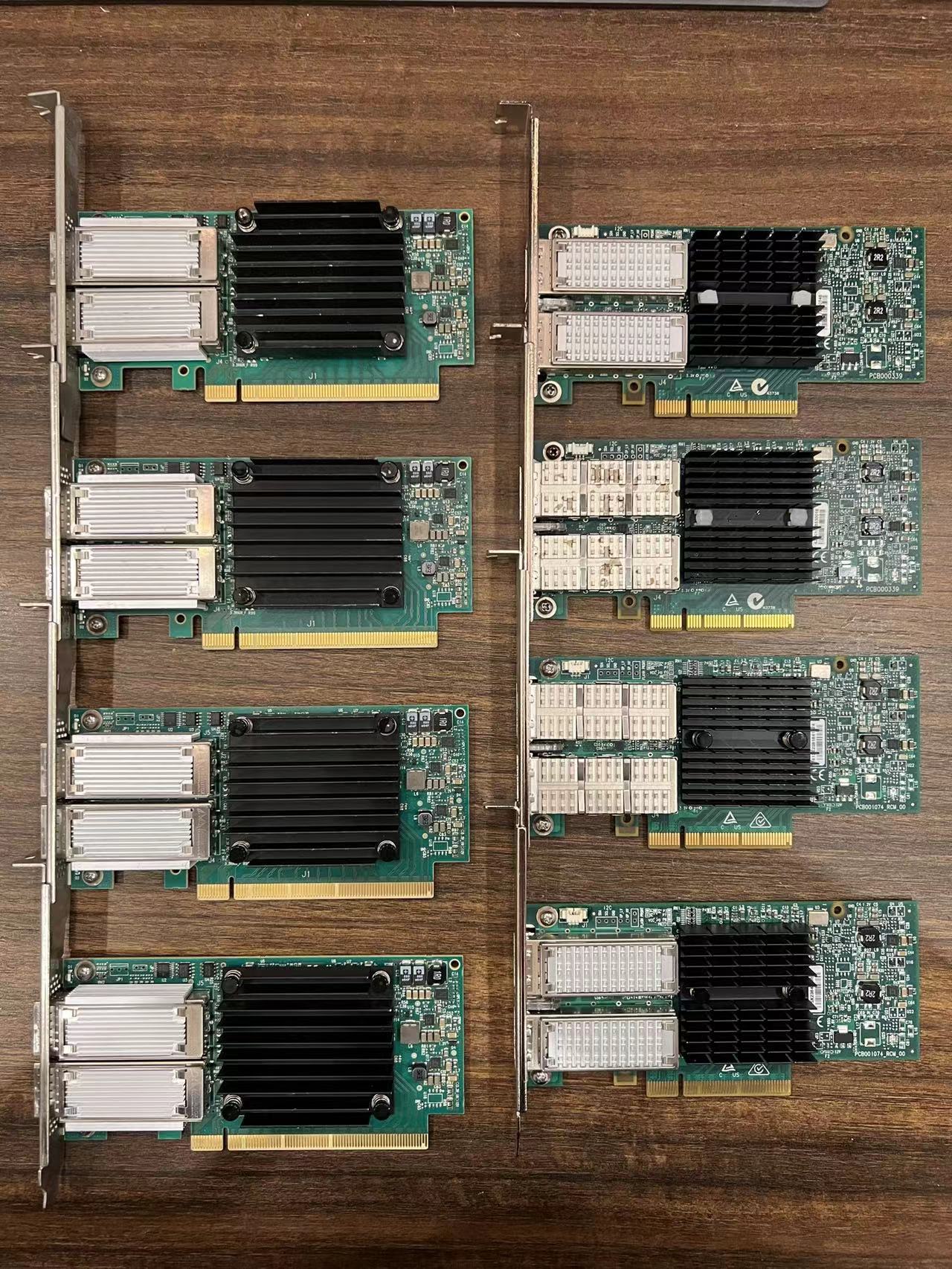

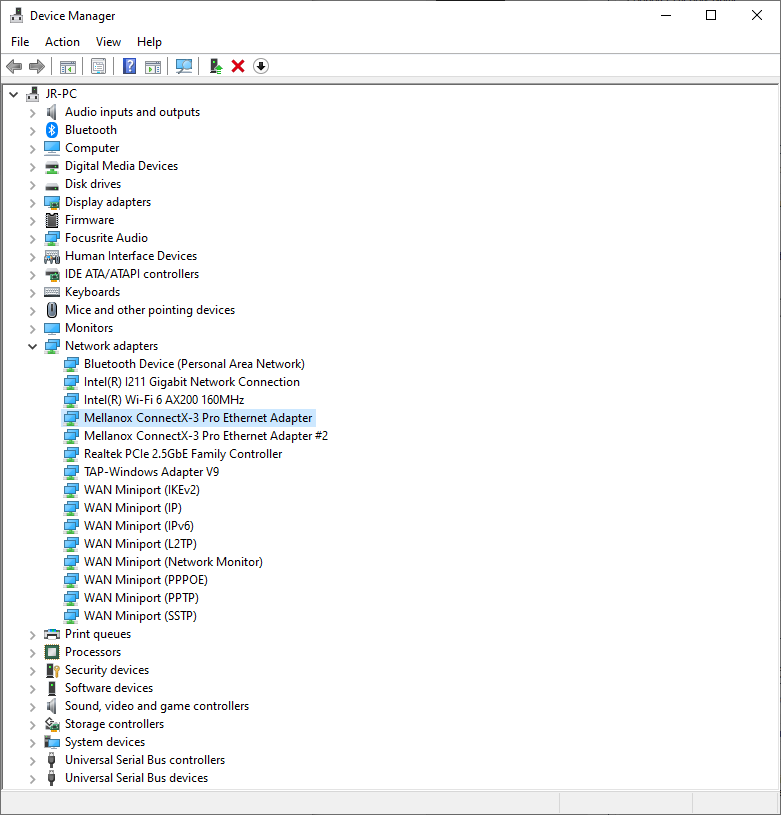

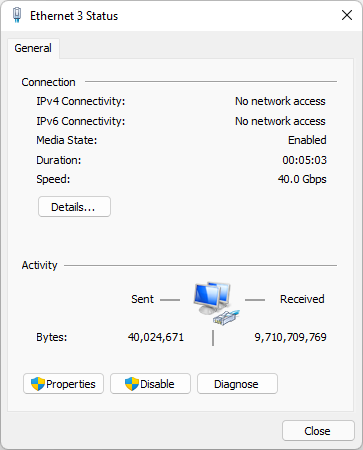

期待关于网络配置和测试的文章,我也组了个TRUENAS SCALE,全NVME固态池25G网卡SMB读取只能跑1.2G/S还很不 ...

MatthewLXJ 发表于 2022-3-29 09:10

太强了...7T83的NAS。

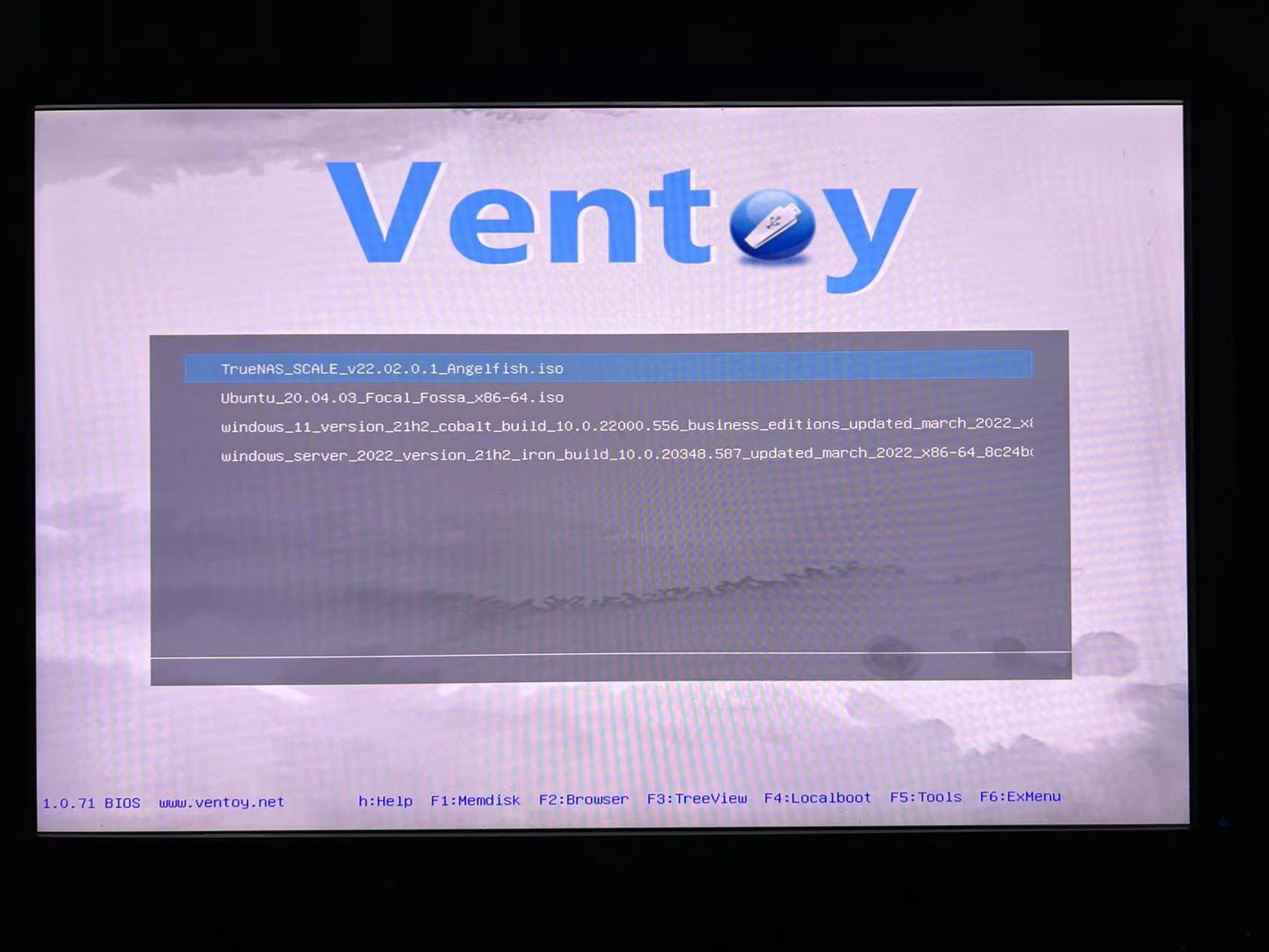

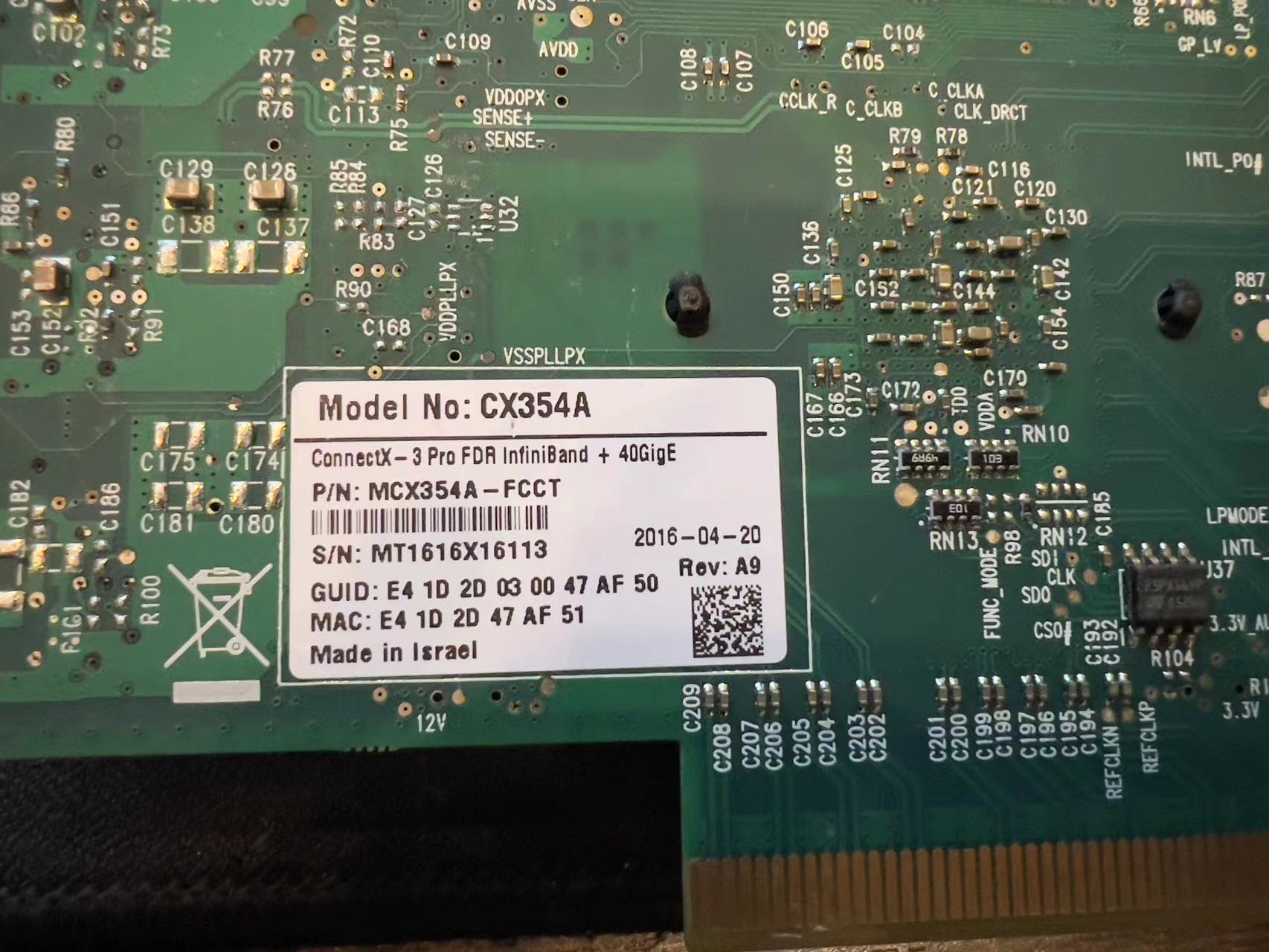

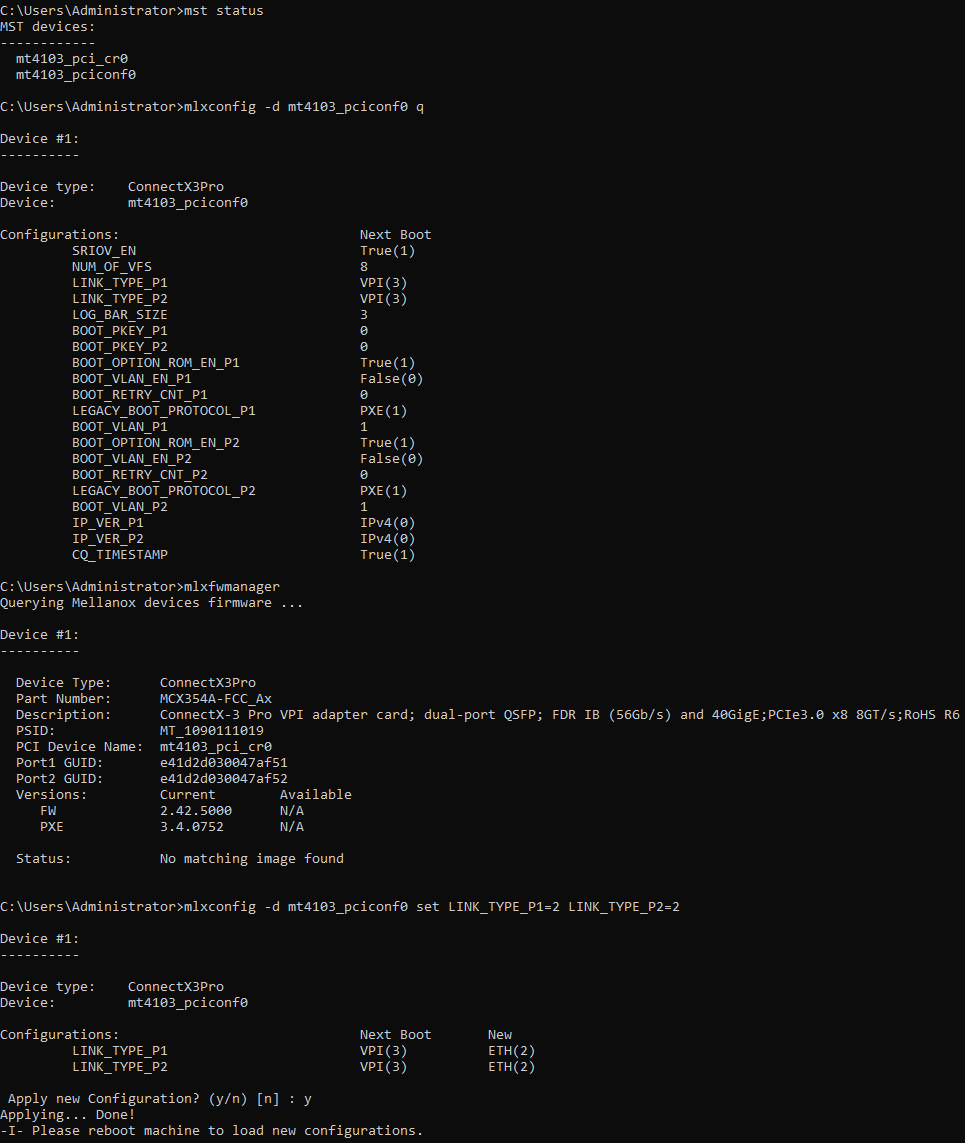

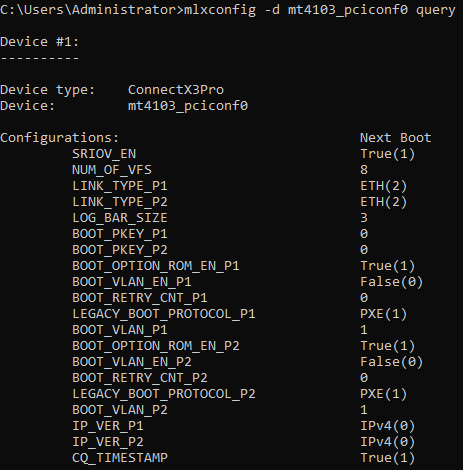

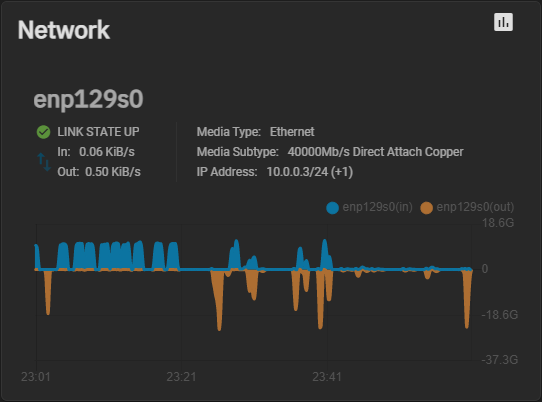

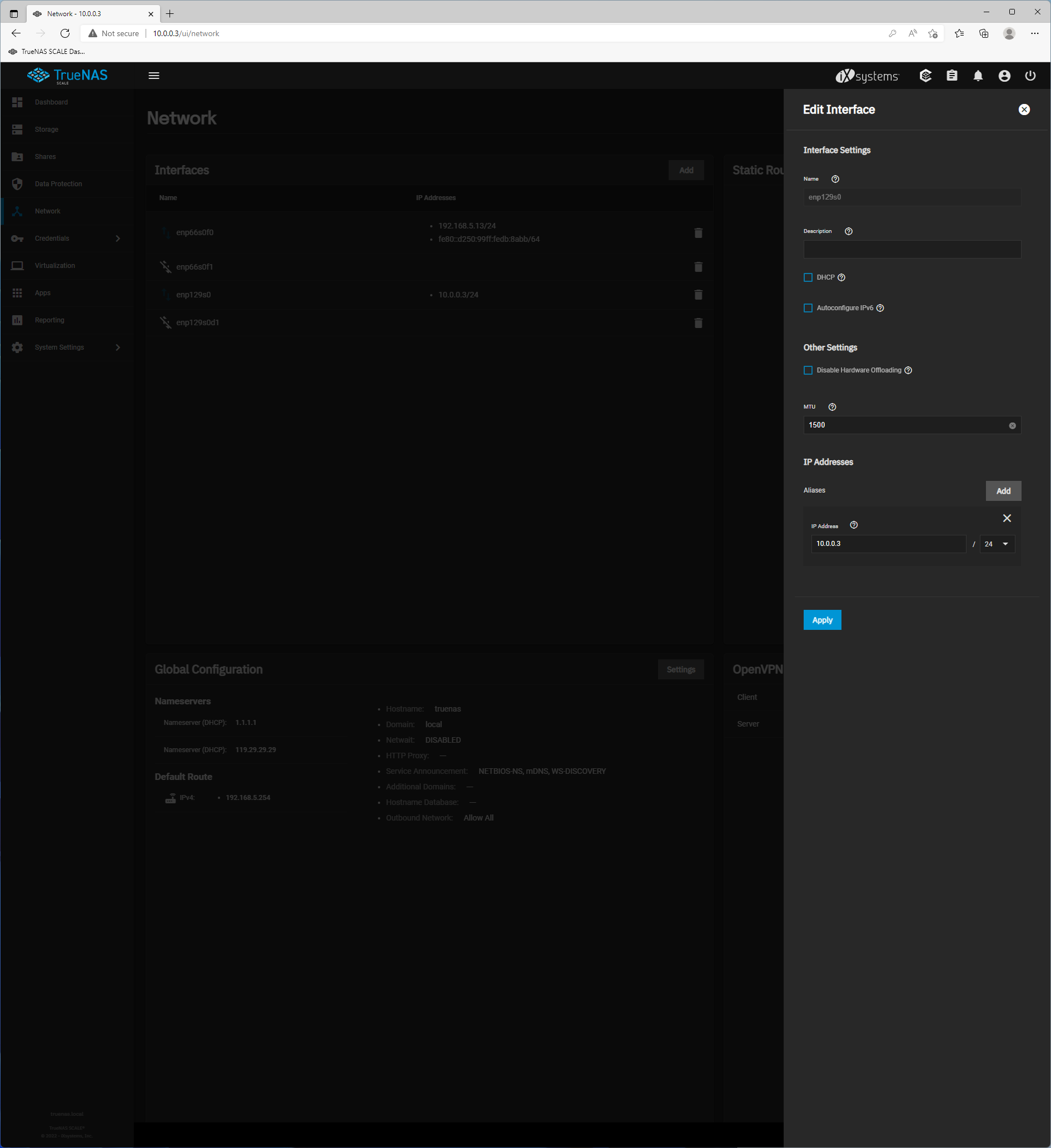

之前尝试过TrueNas scale和core做全机械纯存储的NAS,尝试搭配CX3 pro 40G eth ...

sunneyboy 发表于 2022-3-31 05:26

J大佬,我的nas10块6T HDD,8块sata ssd 1.46T,池建议怎么创建能保证性能。谢谢

jerrytsao 发表于 2022-3-31 10:16

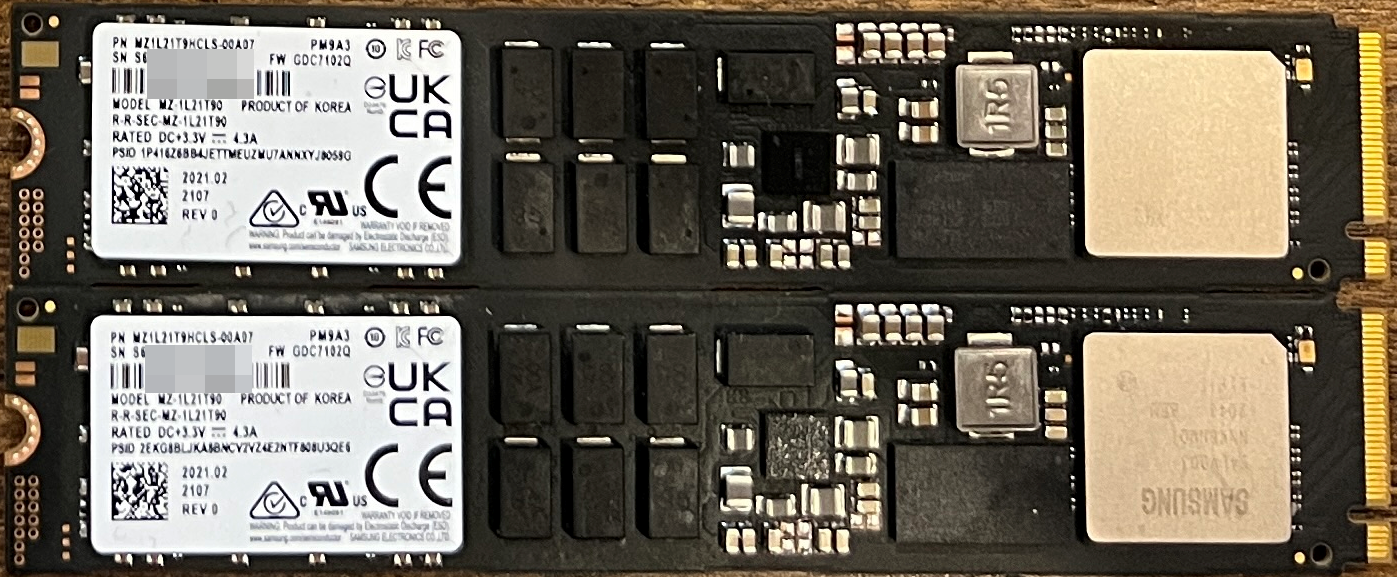

建议弄2-3个960GB或1.92T DWPD=1的数据中心NVMe SSD镜像组那个Special Vdev, SATA SSD的话怎么说呢, 还是 ...

jerrytsao 发表于 2022-3-31 10:16

建议弄2-3个960GB或1.92T DWPD=1的数据中心NVMe SSD镜像组那个Special Vdev, SATA SSD的话怎么说呢, 还是 ...

sunneyboy 发表于 2022-3-31 12:48

组Special Vdev性能会提升吗? 同平台TrueNAS SCALE比CORE慢了很多

dominicchen 发表于 2022-3-31 13:18

J大,问下,GEN8能装这个TrueNAS SCALE 么?能不能装在U盘上?还是必须装在SSD上呢? ...

明石的果汁 发表于 2022-3-31 15:29

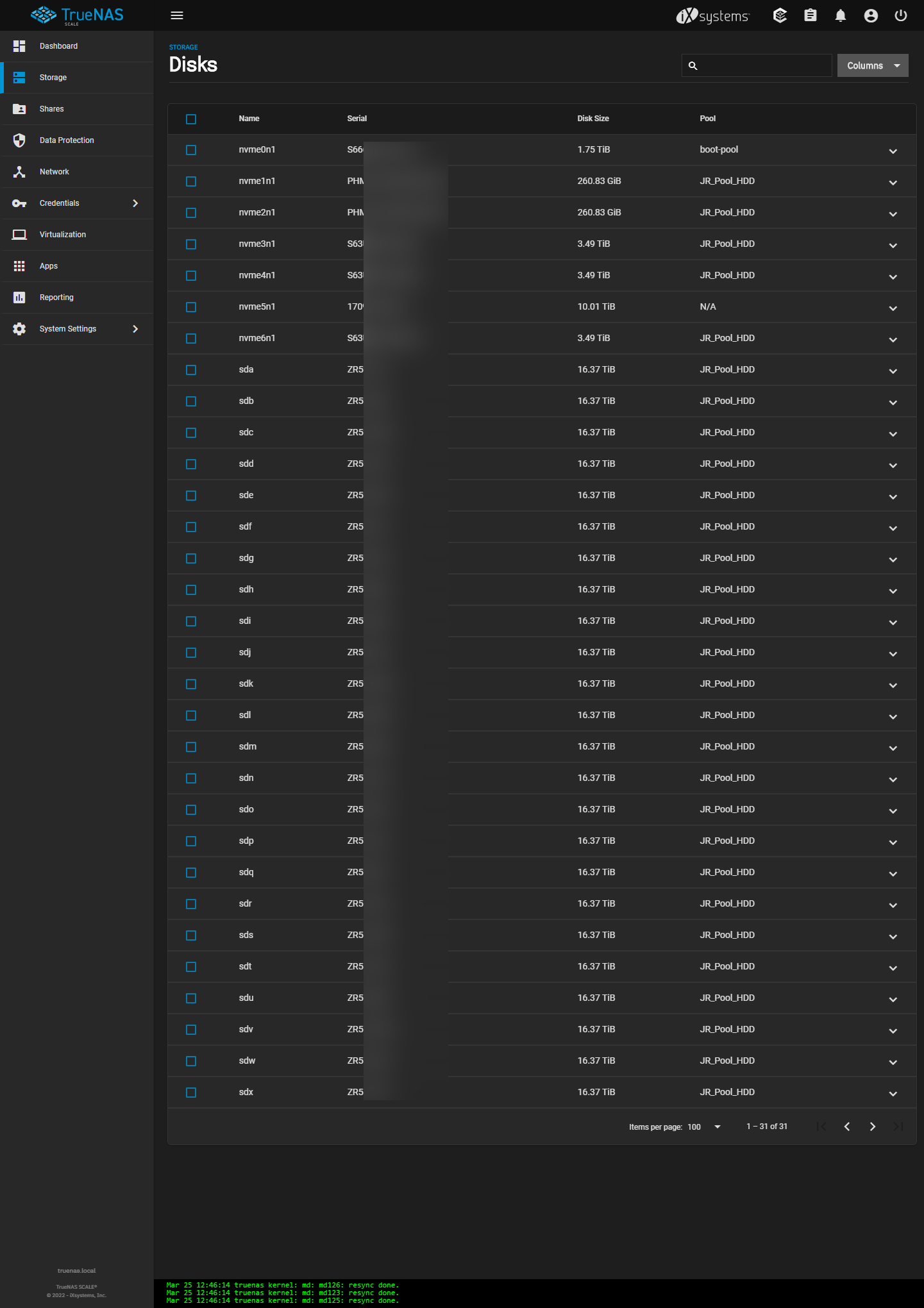

我也装了一个True nas 用了 12T*36 480G*2 系统 双万兆做的BOND 标准浪潮服务器来弄的。用于商用备份

S ...

leavelost 发表于 2022-3-31 20:19

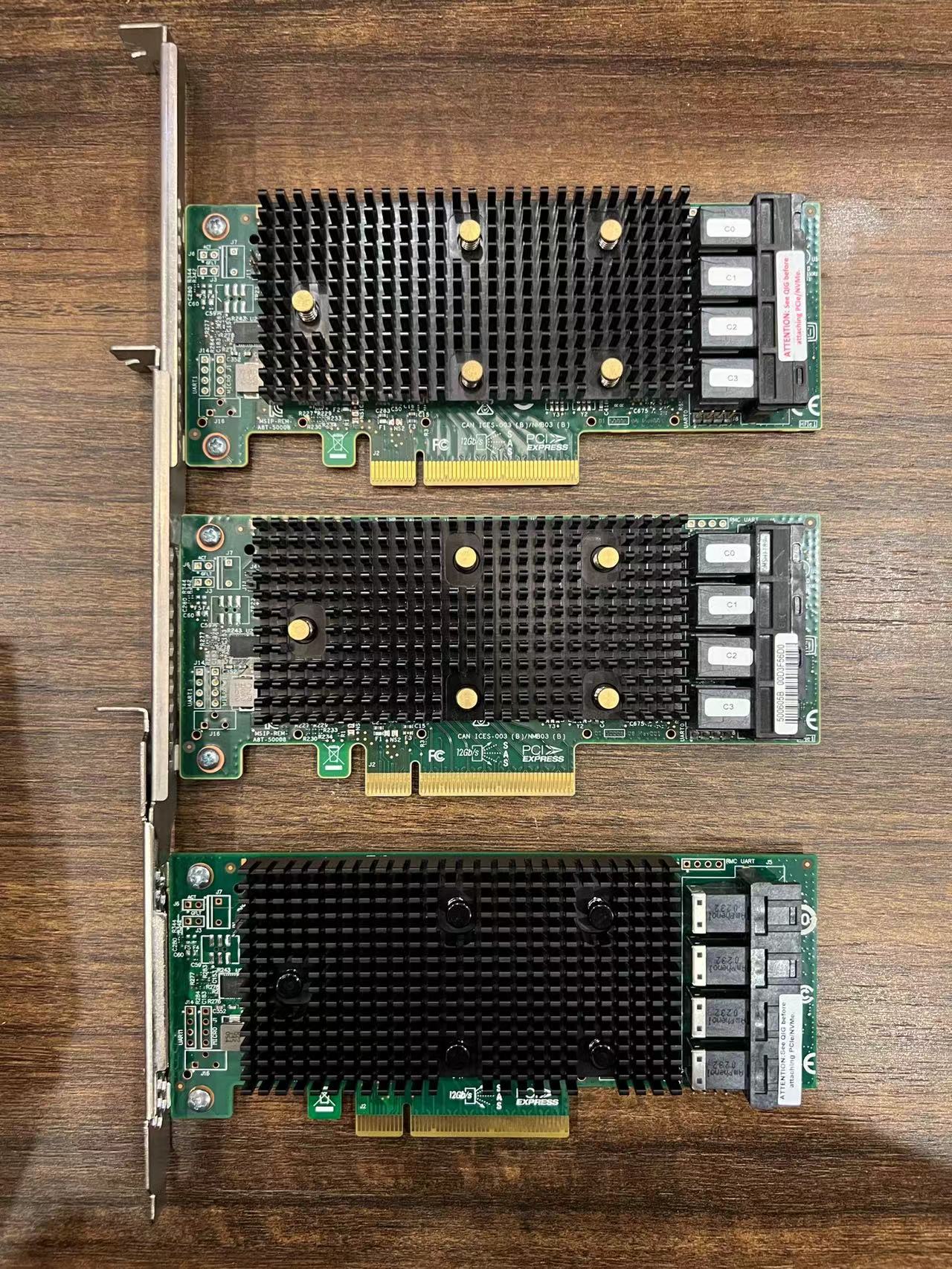

向LZ求助,新买的9405W-16i,刷了最近的P22 mix固件,接了P4510的4T盘(也是最近固件0184),跑分不正常, ...

jerrytsao 发表于 2022-4-1 02:22

3个12盘Pool? 还有个Pool做啥用, 2*10GbE速度如何?

明石的果汁 发表于 2022-4-1 09:15

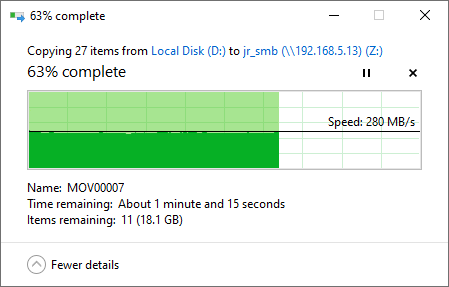

对,12盘一个组,最后一个组还未使用,速度没做测试,很快就拉完了,跟商用的华为集中存储也差不了太多, ...

明石的果汁 发表于 2022-4-1 09:15

对,12盘一个组,最后一个组还未使用,速度没做测试,很快就拉完了,跟商用的华为集中存储也差不了太多, ...

| 欢迎光临 Chiphell - 分享与交流用户体验 (https://www.chiphell.com/) | Powered by Discuz! X3.5 |