本帖最后由 gwha2 于 2025-12-2 16:29 编辑

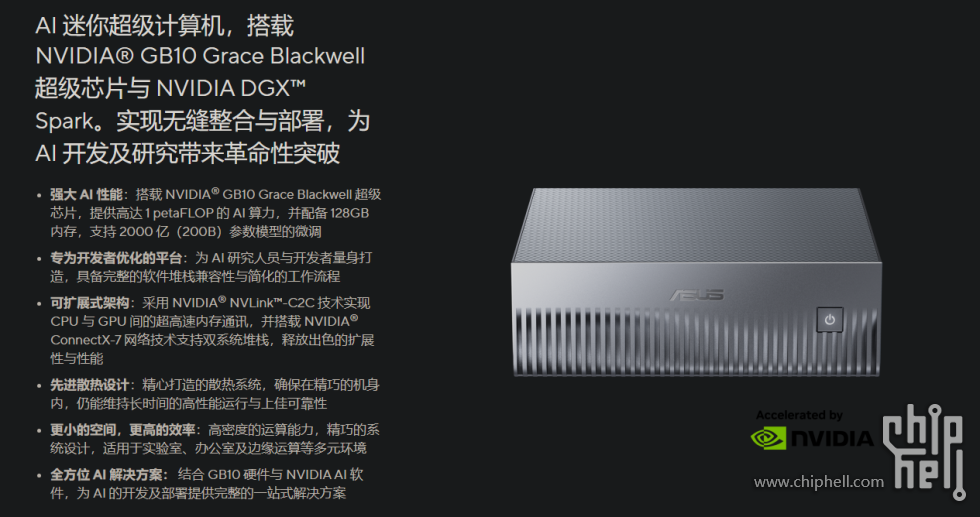

今年老黄拿出GB10核心之后,这个核心的讨论就在社区里面此起彼伏,就在前不久,搭载这个核心的DGX Spark也正式面世。核心的全称是GB10 Grace Blackwell Superchip,设计目的就是为了将以往超算级别的算力给移植到桌面mini主机。而到了各个厂商手中,这个芯片就被冠以各种形态,做成了各式各样的迷你主机,就像是非公版的显卡一样。华硕作为Nvidia正义的伙伴(确信),也推出了基于GB10的Ascent GX10。

在基础的DGX Spark底子上,华硕保留了这主机的全部功能,同时又大幅改进了机器的散热。于是就像非公显卡的散热更好那样,GX10的散热也比公版的DGX Spark要强上不少。这台主机的DGX环境和Nv官方提供的集群上是一模一样的,能给发开带来便利,在本地提供的强大算力也能实现大模型的定制化服务以及微调,128G的通用内存则让模型选择范围极大地扩宽。而这台主机除了这些之外还有什么亮点和槽点呢?我用这台主机大概有半个多月的时间了,所以这次我就来简单聊一聊华硕Ascent GX10这台主机

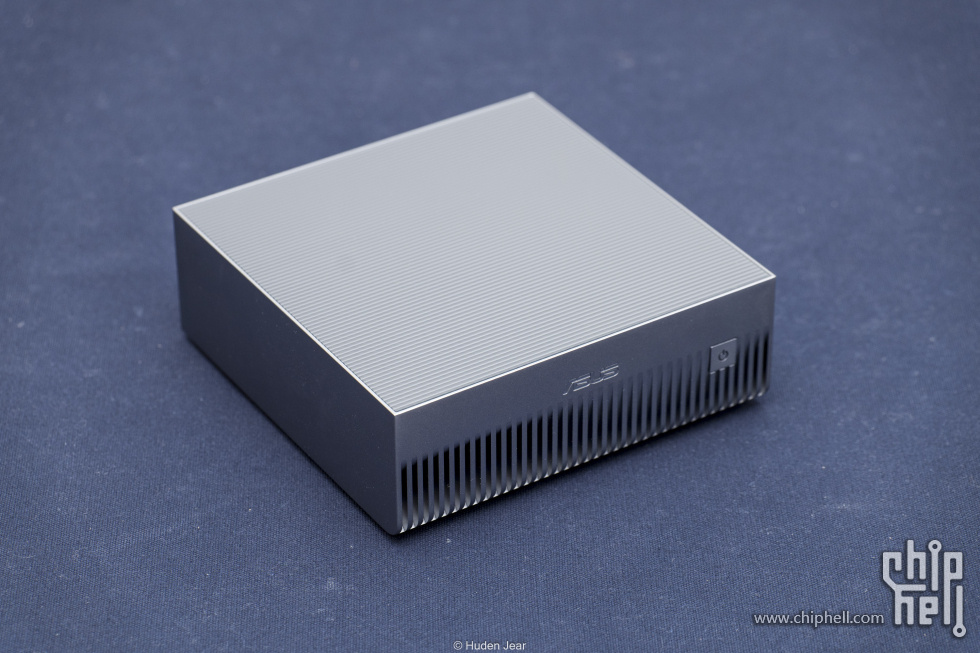

简介因为这台主机和Nv的合作很密切,所以Ascent GX10这个主机的包装简直就是公版显卡的风格,黑色+银色。打开包装之后就是机器的本体了,这个本体做工太好了,金属外壳的做工一下就把我吸引住了,机器正面还有不等深度的雕刻装饰

Ascent GX10的顶盖使用了非常细腻光滑的聚合材料,而且表面的纹理非常神奇,看上去是纵线,实际还隐藏着菱形的纹路,做工实在是太好了。前脸的竖线延伸到底部,正好就是散热的开孔,四个脚垫将机器抬起合适的高度。

机器的背部是IO的集中聚集地,4个Type-C其中一个是为了供电,另外三个都是高速的20G接口,同时还能转为DP或者提供一线通显示。另外接口还有一个HDMI,一个10G的RJ45网口,机器本身也有wifi。旁边这个宽的ConnectX-7就是集群用的接口了,这台机器可以和同型号的机器组成集群。

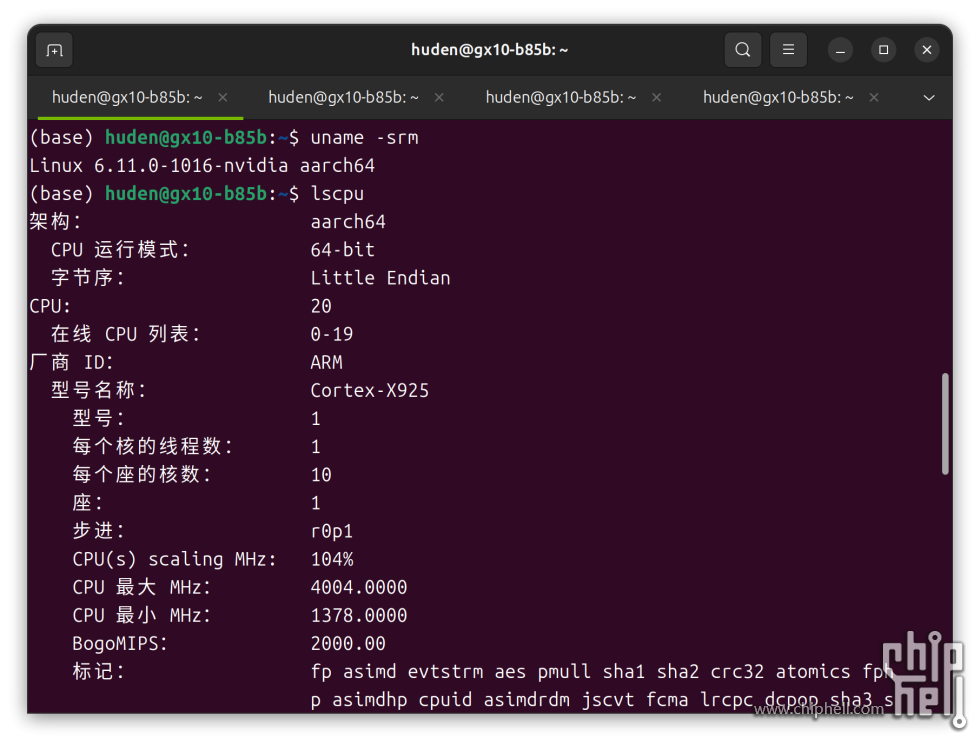

基础测试首先来看一下硬件信息,GX10使用的是nv官方给的系统镜像,构架为arm64的ubuntu,看着像是24.04。CPU部分则是cortex的X925,也就是目前手机上的超大核,一共有20颗,比较豪华。不过也是有代价的,这颗CPU的内存控制器使用LPDDR5X,即使纵有128G,带宽270GBps的速率还是有点难绷的

GPU部分则是GB10芯片,目前支持了CUDA13.0,以后也会随着系统更新而不断升级。但是这颗芯片直接使用nvidia-smi是不会显示名字的,显存也没法查看,好在是可以看到功耗,而且也自动打开了持续模式

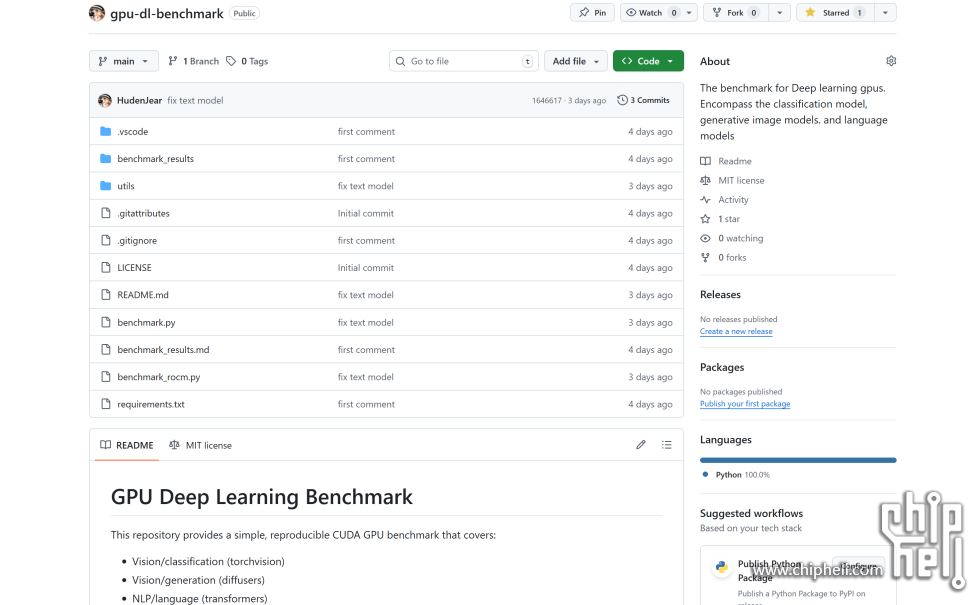

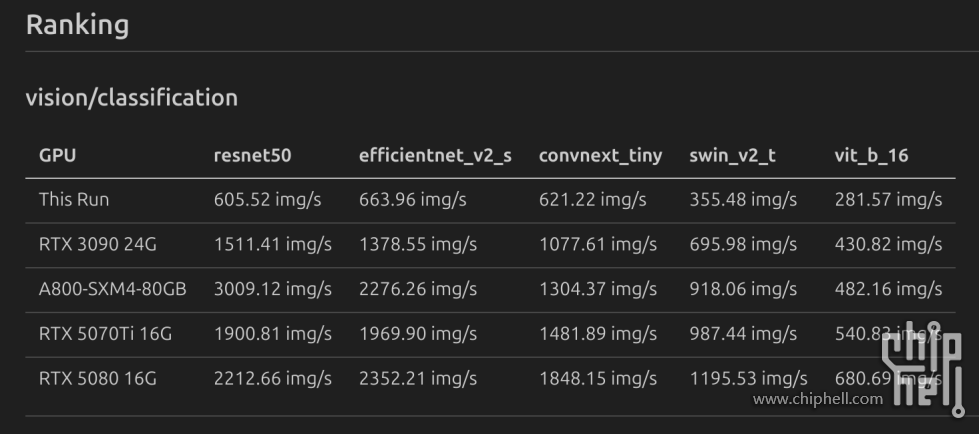

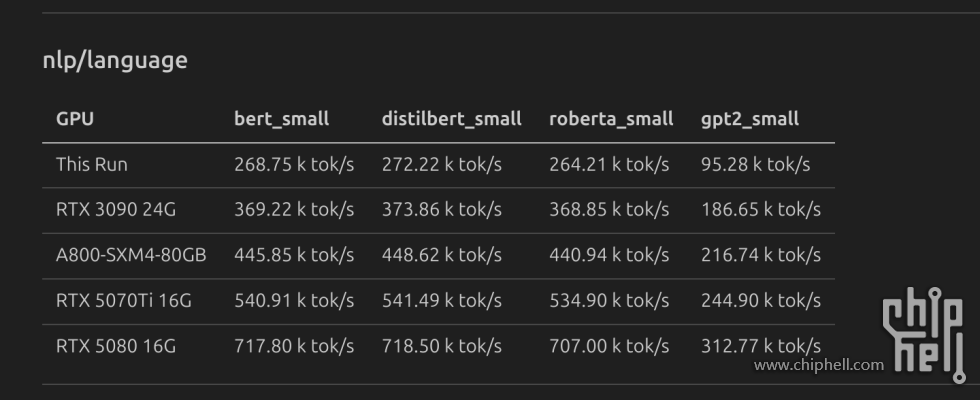

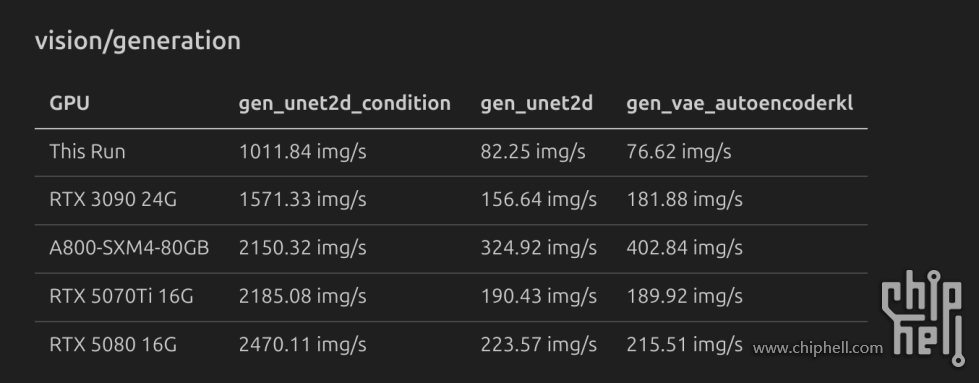

首先测试一下深度学习中的CNN和Transformer推理效果。这个benchmark是我自己收集了一些公开模型之后构建的,可以测试传统的神经网络和小语言模型的推理速率。

下面是视觉模型的推理速度,针对传统CNN,GB10没有太大的优势,一来是视觉模型的带宽需求比较大,二来新构架对于transformer的支持更好,所以可以看到ViT和SwinTransformer里面GB10核心的相对性能会高一些。小语言模型推理GB10还挺不错的,构架优势直接体现出来了,这还不是GB10优势最大的项目。

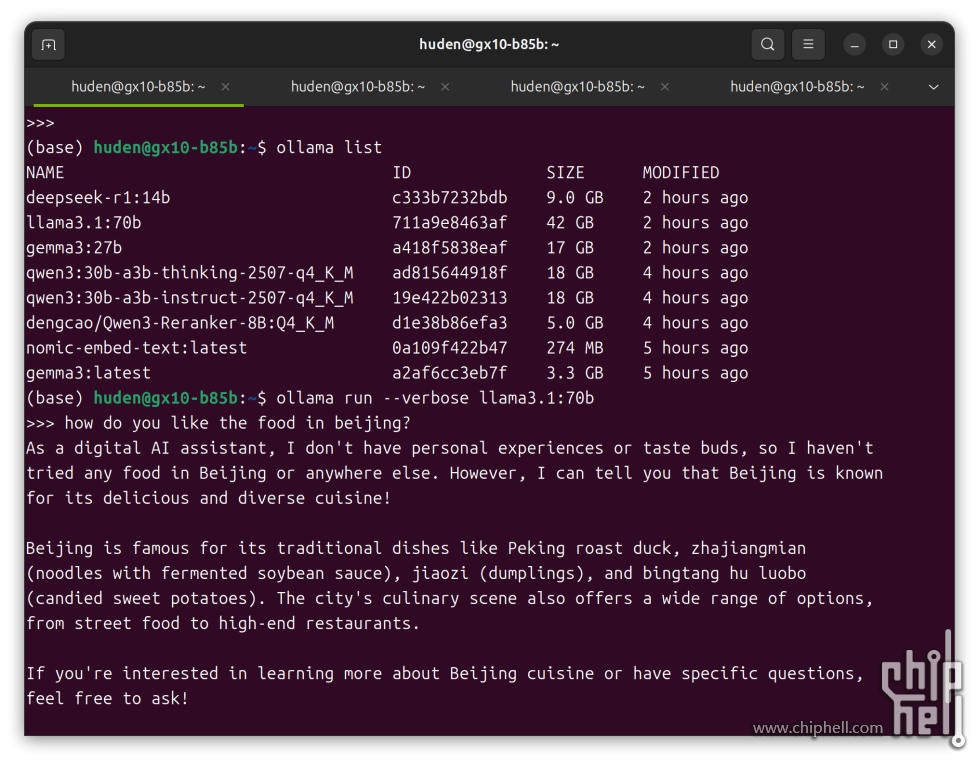

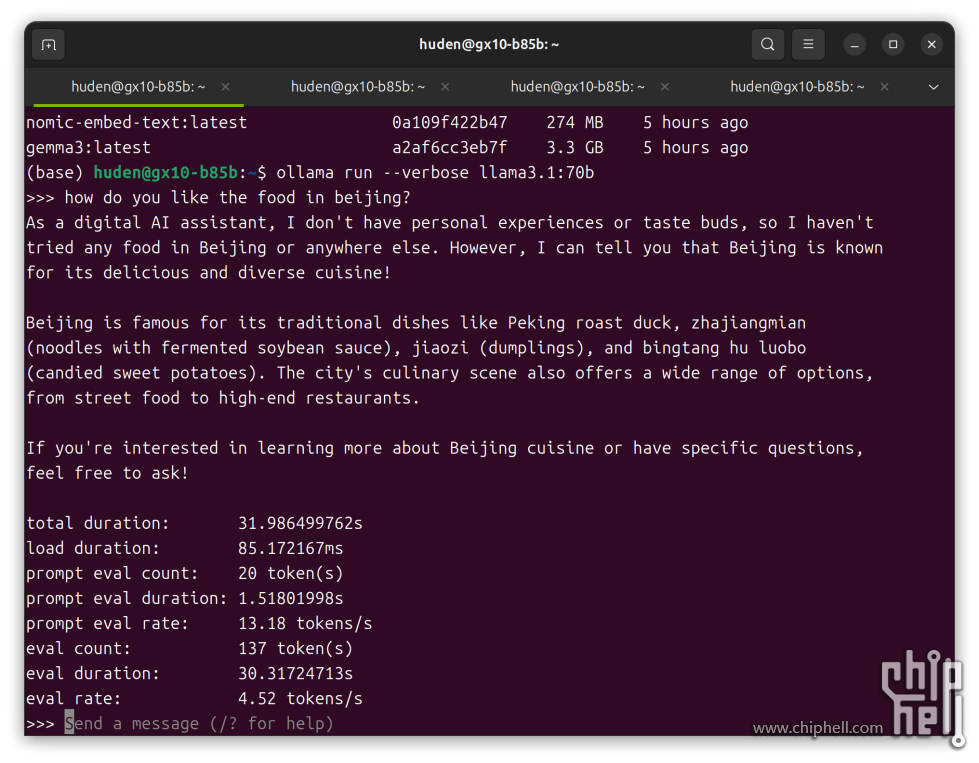

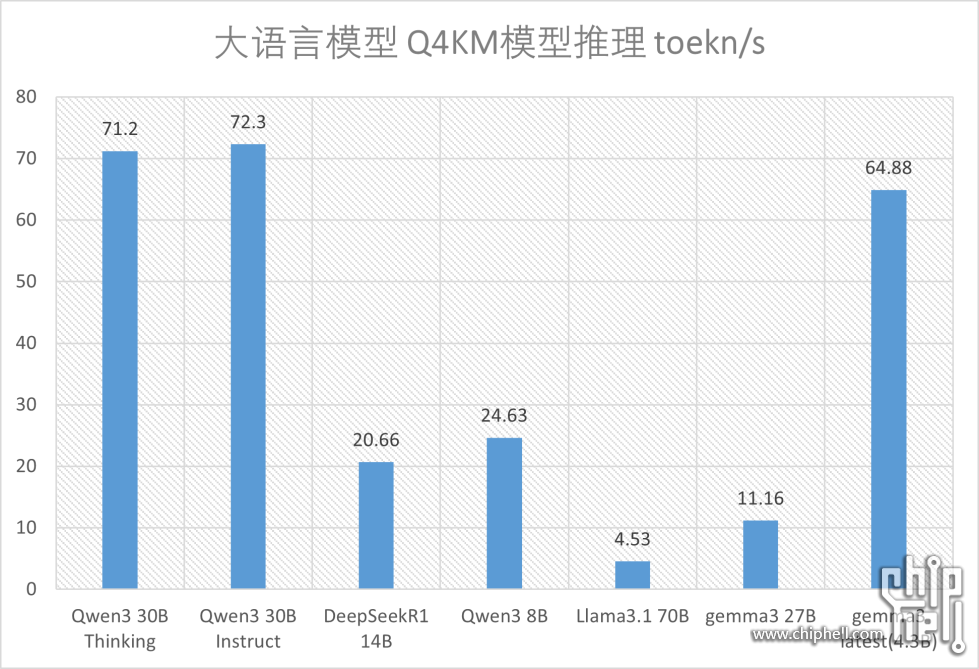

下面就是大预言模型的推理测试了,使用ollama后端,使用相同的提示词测试每一个模型,然后利用verbose选项统计性能。可以看到在性能汇总里面,针对小一点的模型,例如14B的DeepSeekR1和27B的Gemma,速度都非常不错,可以跑上20和10token/s,当模型达到了42G的70B规模,也就是llama3.1这个模型,速度就只有4.5token/s

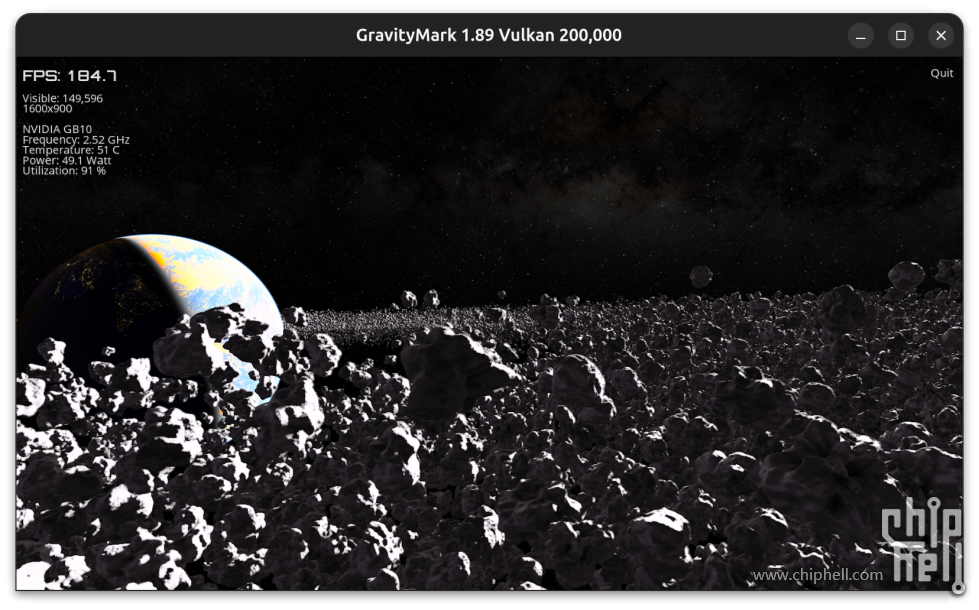

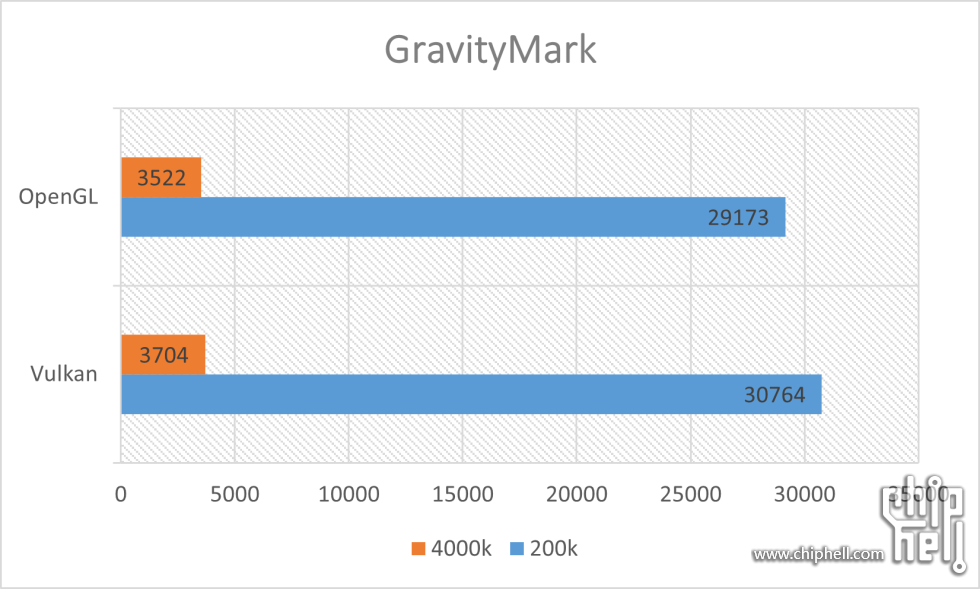

下面是GB10作为显卡的时候的性能测试。使用的软件是gravityMark,这个程序在win和linux上都能使用,而且支持vulkan和openGL两种API,可以代表通用性能了。我测试了200k和4000k点的性能,使用vulkan的性能会好一点点,绝对性能和RTX3080差不多

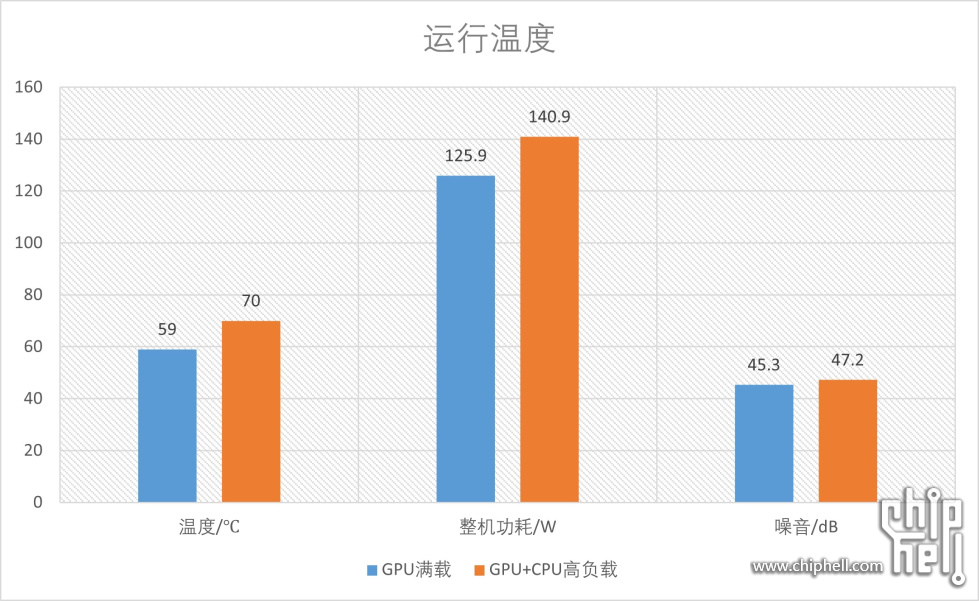

下面是运行功耗和温度的测试,仍然使用gravityMark的demo运行10min,测试环境下显卡都是满载的,使用4000k的时候就能代表CPU高负载的情况。GX10的散热相当不错,在GPU满载的情况下,功耗接近130W,但是烤机温度不到60℃,而且运行起来基本没有声音,贴近出风口的地方也只有45dB,这个声音实际在使用中是完全听不到的。

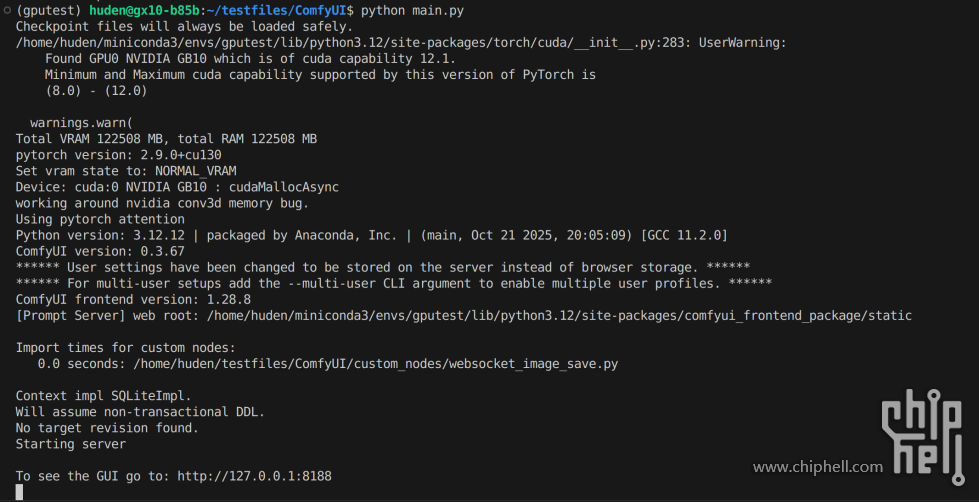

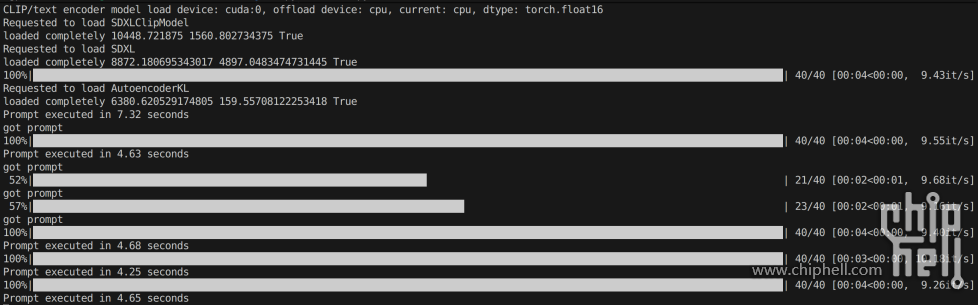

应用场景第一个应用场景是作为本地模型的部署工具,一般的大语言模型就不多赘述了,除了语言模型之外,这个主机也能用于ComfyUI的部署。相较于SD的整合包,ComfyUI的模块化非常便于部署,而且定制化程度更高,也能适应各种工作流。

具体部署也很简单,只需要将本地的部署映射到局域网内,就能实现别的电脑来使用GX10上的工作流和模型了。使用的时候只需要访问固定的网页或者接口,就能跑工作流,并且把图片保存到本地,图片视频都能用。

局域网内的接口的便利之处就在于可以多设备访问,且对设备性能没有太高要求,即使用平板等客户端,也能轻松跑AI绘画或者访问本地大模型

第二个应用场景是搭建自己的AI Agent。目前很多AI平台都给出了自己的agent构建解决方案,但是无一例外的都是用云端资源进行部署,如果工作学习的地方保密等级较高,这些联网的模型就完全无法访问了,而如果使用本地模型就不会有这些烦恼。

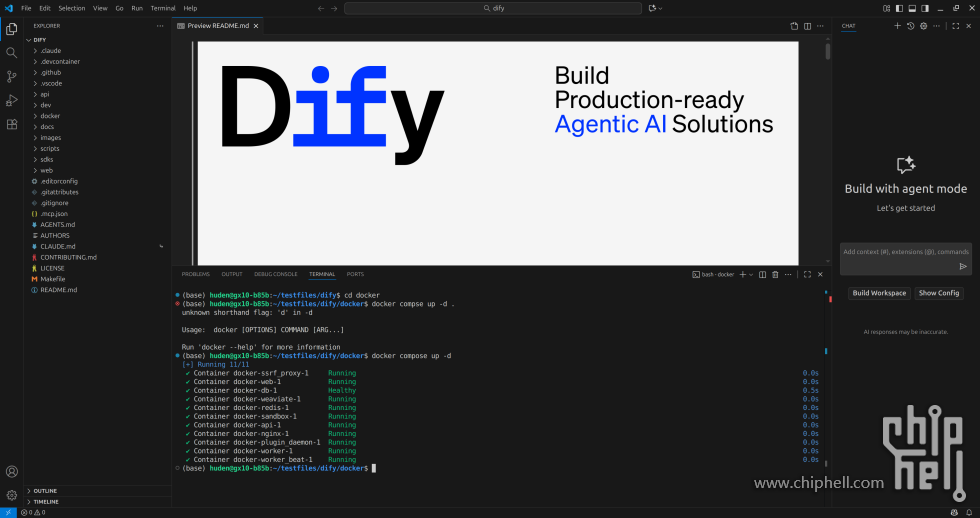

一般的LLM部署之后并没有很高垂直领域的智能,尤其是没有外置的知识库,针对一些专业场景的时候效果较差,比如查询本地文档中的一些特有信息,定位信息来源。一个简单的例子就是需要查阅法条或者查阅海量说明书的时候,常规大模型就远不如介入了本地知识库的Agent。所以为了提升这些场景的应用,支持定制知识库的Agent就很重要了。 针对这个场景,一般可以使用DIFY解决。我们只需要按要求部署好DIFY以及ollama,并且打开DIFY的页面,就可以开始定制自己的智能体平台。

我们首先添加ollama本地模型,GX10因为有超大的通用内存和不错的GPU,所以ollama部署模型非常轻松,也能支持不同模型的灵活切换。并且在同时需要调用嵌入模型和语言模型的Agent应用场景下,自身通用内存大是很重要的优势。

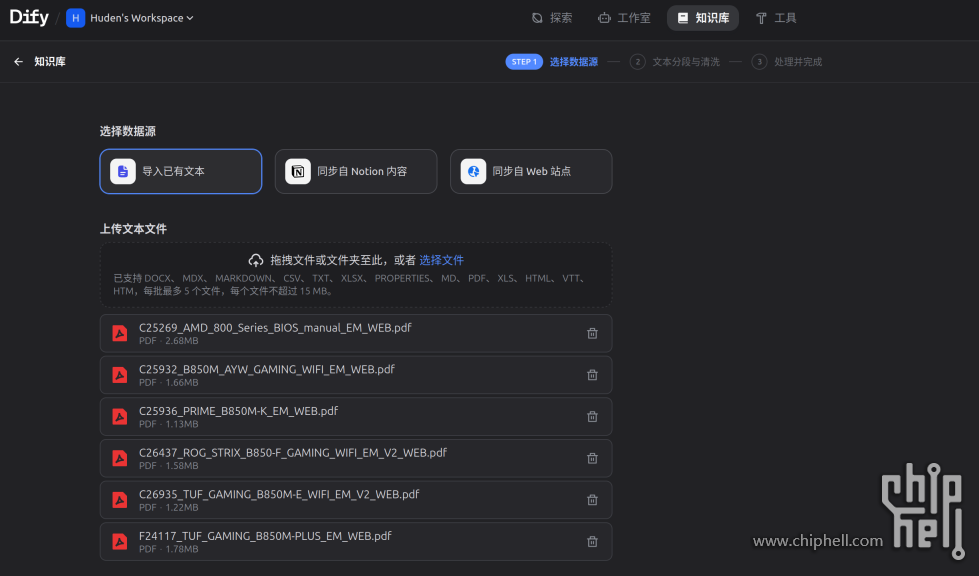

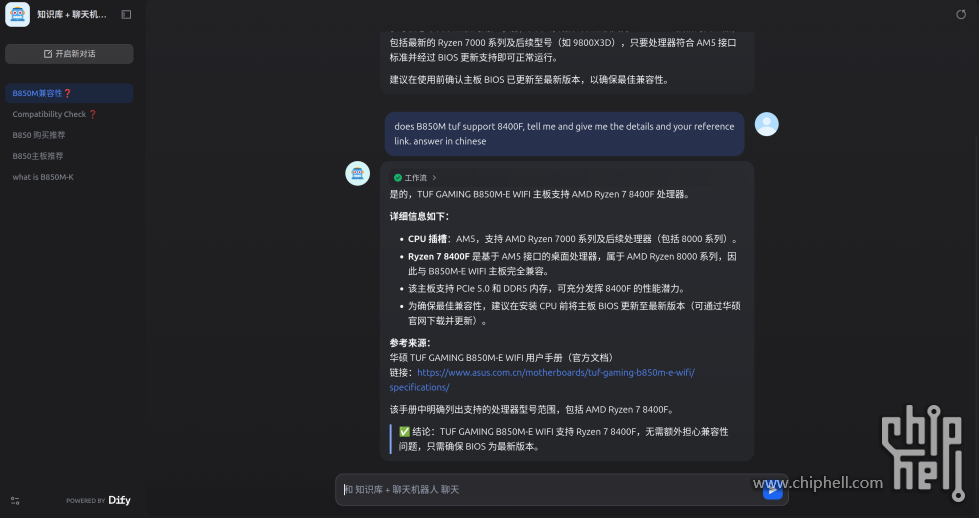

随后我们再定义一个知识库,比如这个知识库我们就放入一些华硕主板的说明书在里面。这些主板都是今年刚推出的主板,一般的本地大语言模型受限于语料的来源时间,无法查阅到这些主板的详细信息,而知识库就弥补了这一点。

然后我们设计一个工作流并且在DIFY中发布,这个工作流随时可以进行本地调试或者在其他机器上调试,比如这个工作流我就是在GX10之外的一台电脑上设计调试的。

经过发布后,就可以通过端口以及嵌入式的应用来访问agent,这个示例问题agent就可以通过本地知识库访问到,并且给出来源,提供完整引证来源。

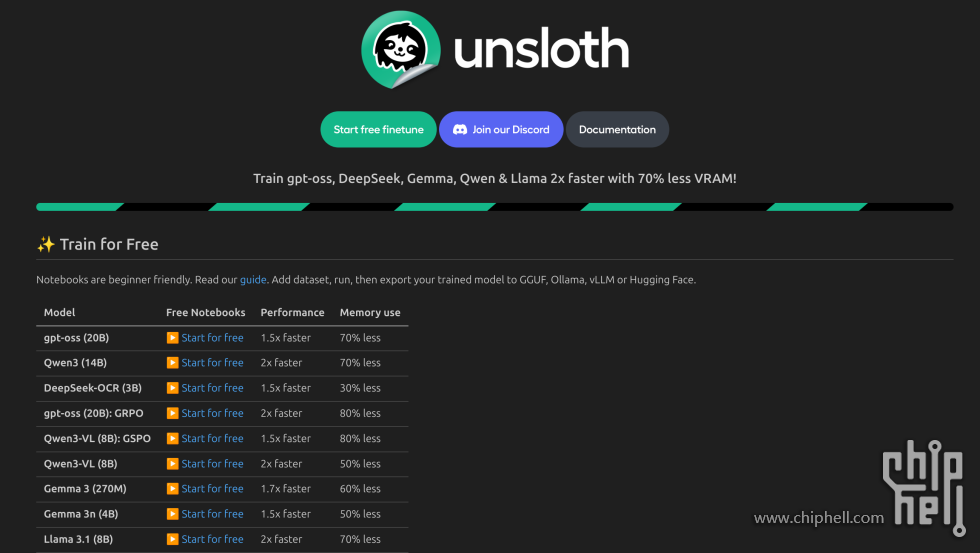

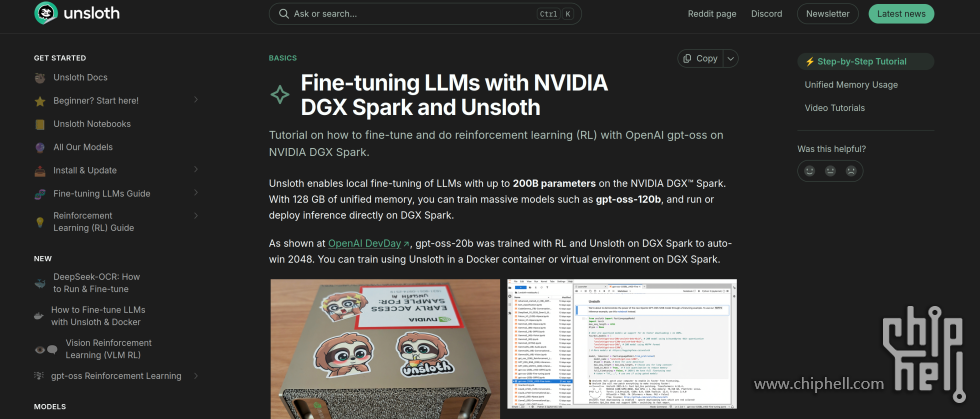

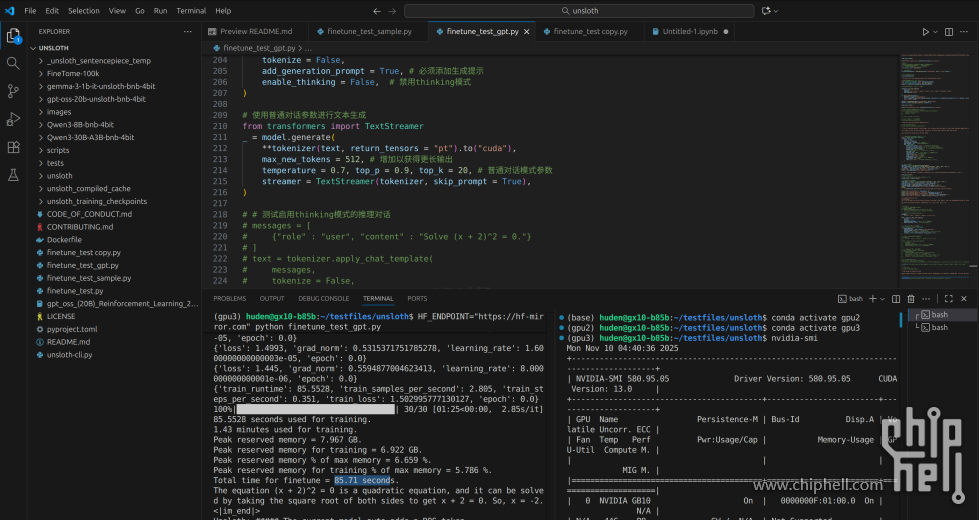

第三个应用场景就是微调属于自己的大语言模型。一般而言大模型都是很难做到本地微调的,原因主要是本地显卡的显存容量无法容纳大模型的参数,其次微调环境也很难搭建。而GX10因为使用了DGX 的定制系统,本地已经安装好了最新的CUDA和python,跑unsloth这样的微调repo就非常轻松了

而Unsloth官方也认识到了DGX Spark以及GX10这样的主机在微调方面的优势,所以专门在说明文档中为他单开了一页。这里面的介绍非常详细,还提供了SFT和RLHF这两种方式,只要按照操作来就完全不成问题。

不过为了测试流程标准化,我仍然使用了标准的Unsloth微调流程,测试了常见最小化模型Gemma0.5B的微调时间。使用Finetome100K和30轮微调,总的时间消耗只有90s左右,而且模型可以保存为Q4-k-m的GGUF进行本地部署或者放到其他机器上跑。因为GX10的显存最大可以达到120G,因此可以微调上100B的Q4模型,一般70B的模型智能程度就已经很高了,要定制自己的大模型,一台GX10就可以实现。

总结华硕Ascent GX10作为一台“非公版”的DGX Spark主机,我认为做到了超越原版的水平。这台主机在造型的设计上使用了完全一体化的外观,各个设计要素都有机地融合到了一起,并且加工工艺非常之高,光是放在桌面上就非常的赏心悦目。而GX10的散热是比原版要好的,在极高负载的情况下,机器的散热可以说是一点声音都没有,真正实现了让人感觉不到的同时,提供服务器级别性能。此外这台机器的应用情景也非常多样化,本地模型部署或者agent定制,甚至是大模型微调,都可以一台机器搞定。 这台机器的槽点我觉得主要还是源于产品线的不成熟,这是这个系列中的第一台主机,Nvidia明显不想在这台主机上步子太大,所以CPU部分仍然使用了cortex-X925的公版设计,通用内存带宽有限,GPU部分也只是放了一颗中等规模的GB10。系统的定制化程度不高,能看到Ubuntu系统原本的样子,而且也没有开机可用的demo项目。另外这台主机的售价3.2w,我觉得超出预期太多了,如果降价一些绝对是很有产品力。 不过我相信这些问题都是小问题,总的来说我觉得这台主机作为生产力工具是合格的,只要是开发者应该都会很喜欢这个主机带来的便利。如果Nv和华硕在之后不放弃这条产线,此类主机一定还会越做越好,并且会逐渐走入大家的工作学习生产环境中。

|  310112100042806

310112100042806