本帖最后由 gaojie20@ 于 2023-5-16 12:17 编辑

▐ INTEL Xeon w9-3495X&Supermicro X13SWA-TF Professional Review

(gaojie20@原创Chiphell首发,转载请注明出处)

0▐ 前言

Intel Sapphire Rapids Xeon Workstation 系列CPU W-3400/2400已经发布三个月了,但是因为其旗舰Xeon w9-3495X没有国行盒装,所以导致引进和购买困难,鲜有人发布专业性的评测,本次感谢深圳倍联德的快速产品引进,让我有了评测Xeon w9-3495X和W790的机会。

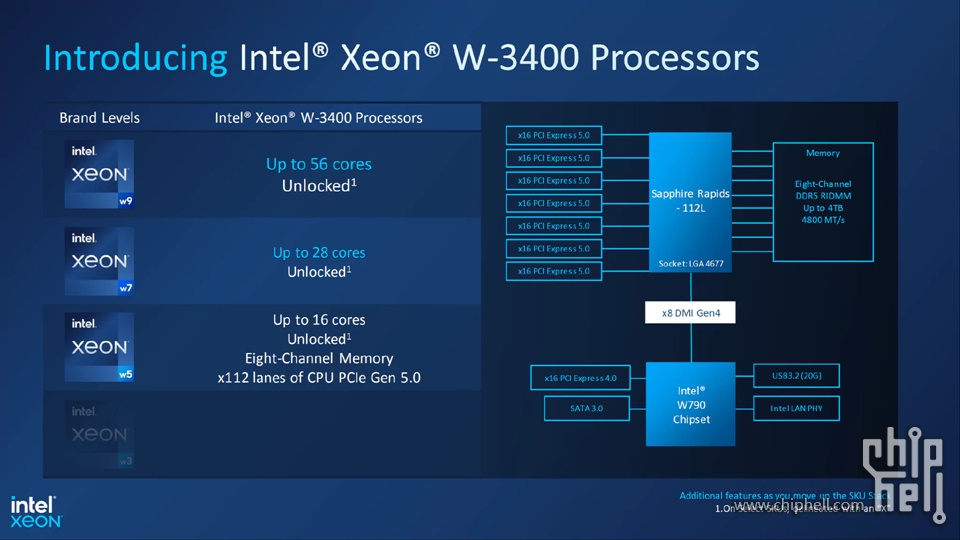

▲Intel Sapphire Rapids Xeon Workstation 系列CPU包括 Xeon w9、Xeon w7、Xeon w5 和 Xeon w3 细分市场。

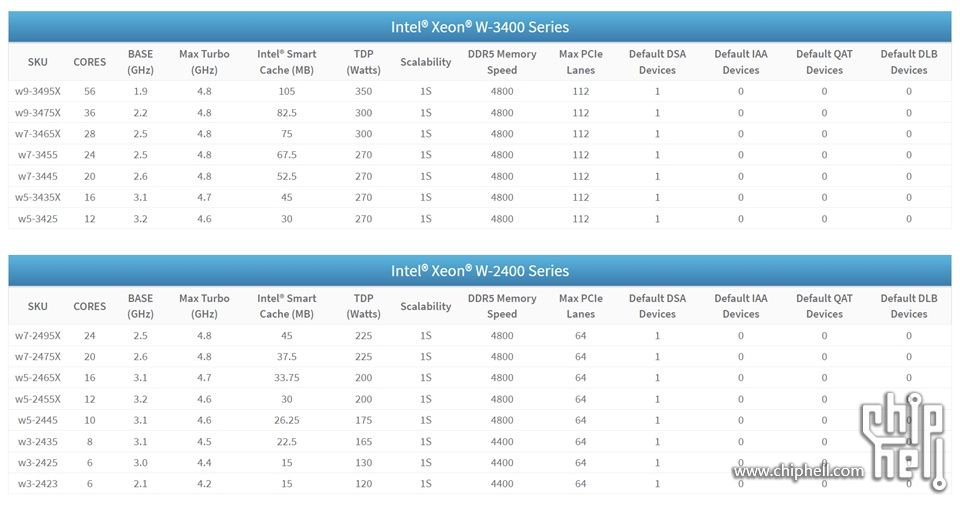

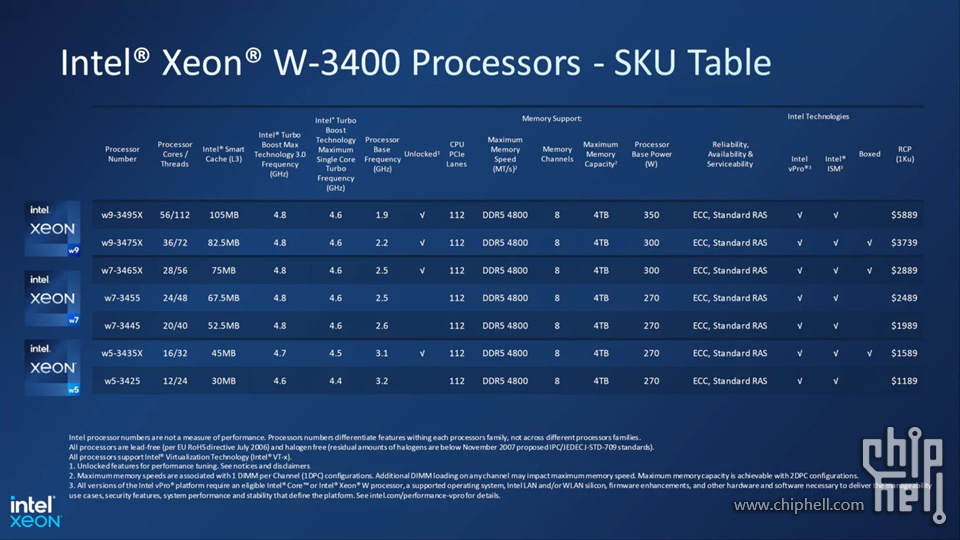

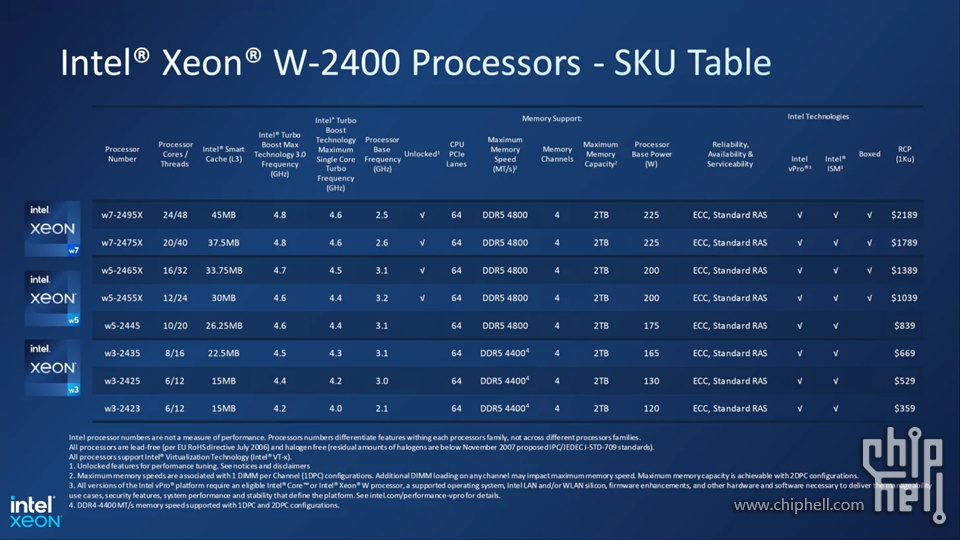

▲该系列共有 15 个 SKU,其中 7 个属于 Xeon W-3400,8 个属于 Xeon W-2400 系列。

▲所有 Intel Sapphire Rapids Xeon 工作站 CPU 都配备Intel Turbo Boost Max Technology 3.0、具有高达 105 MB L3 的 Intel Smart Cache、第三代 Deep Learning Boost(AVX-512 支持)和 Advanced Matrix Extensions( AMX),支持 INT8 和 BFLOAT16。

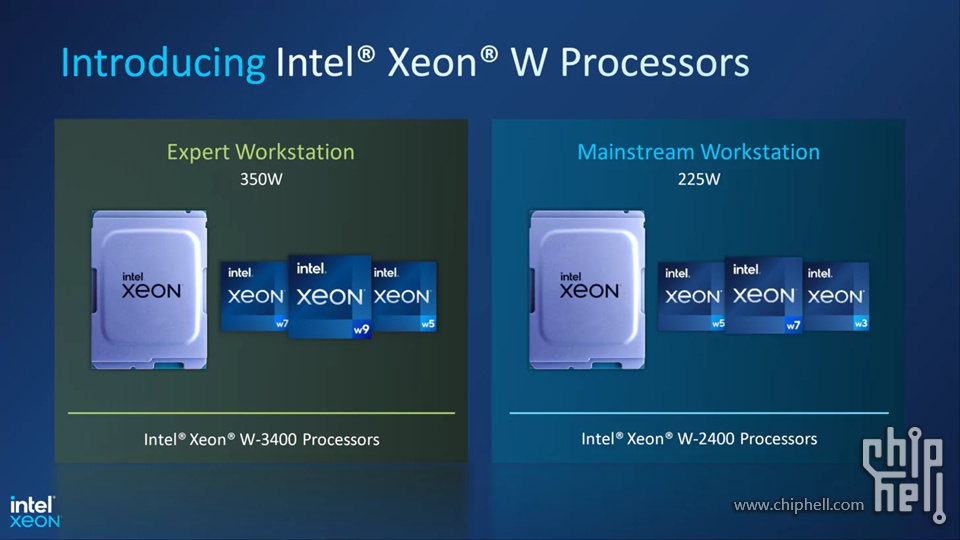

▲两个细分市场之间 SKU 的划分:

Xeon W-3400 CPU (350W) - Xeon w9 / Xeon w7 / Xeon w5

Xeon W-2400 CPU (225W) - Xeon w7 / Xeon w5 / Xeon w3

英特尔至强 W-3400“专家工作站”CPU 系列

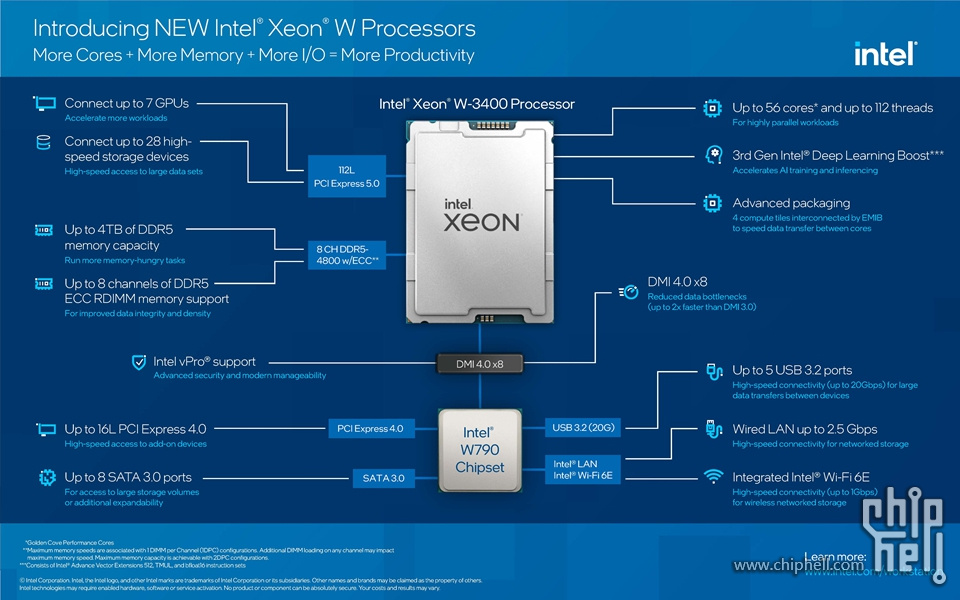

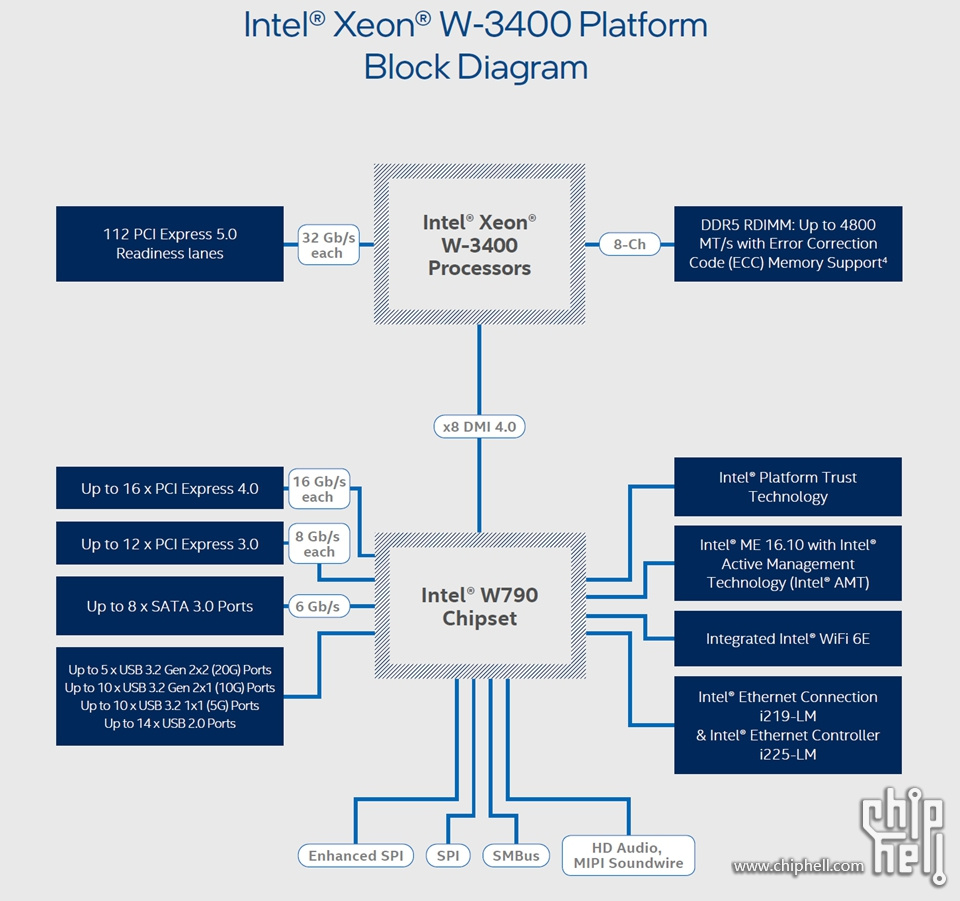

▲Intel Xeon W-3400 Sapphire Rapids 芯片属于“专家”工作站 CPU 系列。这些芯片提供多达 56 个内核、112 个线程、8 通道 DDR5-4800 内存支持和 112 个 PCIe Gen 5.0 通道。所有英特尔至强 W-3400 CPU 都支持高达 4 TB 的内存容量 (EEC/R-DIMM)

▲从 SKU 开始,阵容中的顶级芯片是 Xeon w9-3495X,它提供 56 个内核和 112 个线程。该芯片包含 105 MB 的 L3 缓存,具有 1.9 GHz 的基本时钟并可提升至 4.8 GHz。CPU 的 PL1 TDP 为 350W,PL2 TDP 为 420W。解锁模式应该将 TDP 推得更高。以下是各种 Xeon w-3400 SKU 的 PL1 和 PL2 分布:

Xeon w9-3400 - 350W (PL1) / 420W (PL2)

Xeon w7-3400 - 300W (PL1) / 360W (PL2)

Xeon w5-3400 - 270W (PL1) / 324W (PL2)

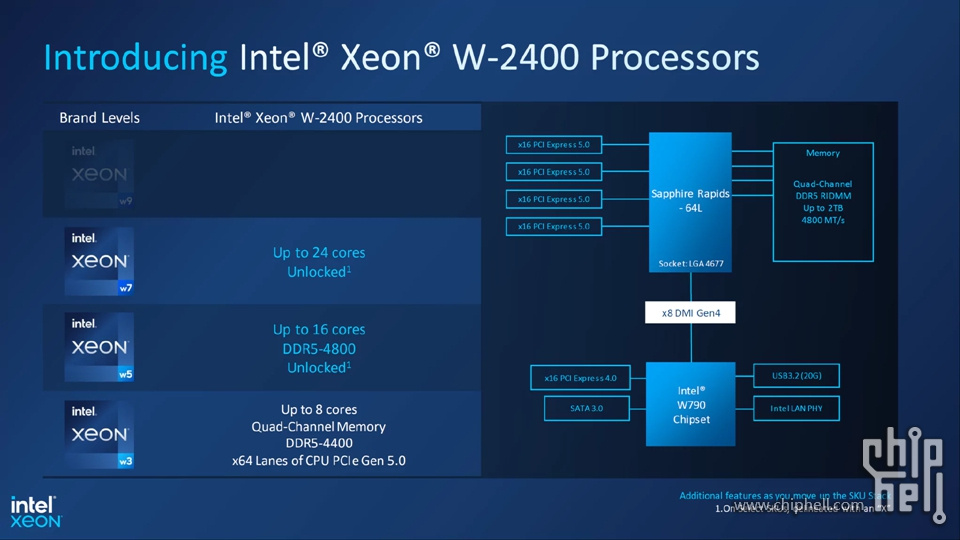

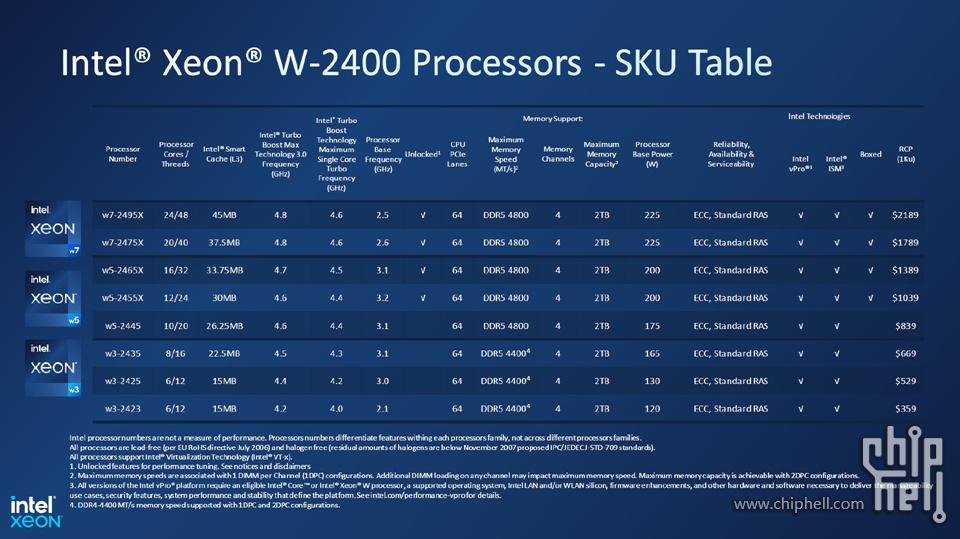

英特尔至强 W-2400“主流工作站”CPU 系列

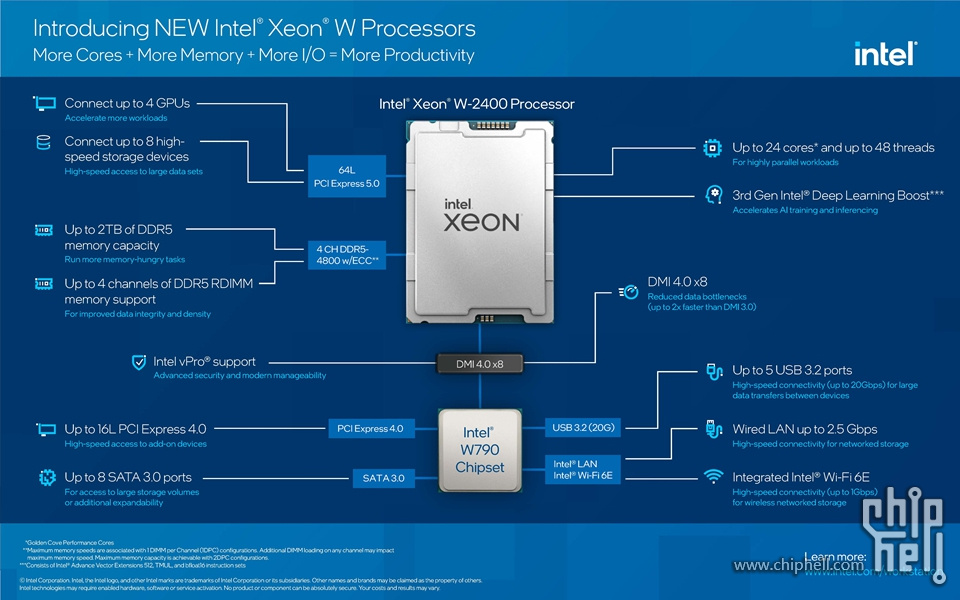

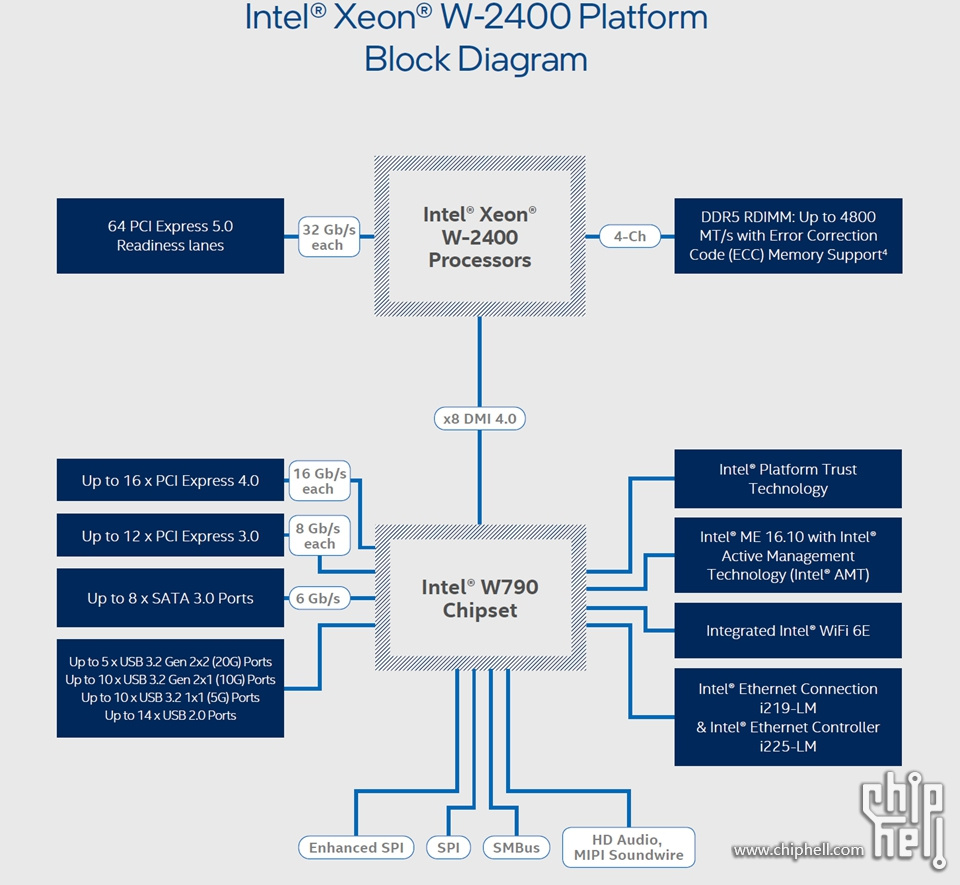

▲Intel Xeon W-2400 Sapphire Rapids 芯片属于“主流”工作站 CPU 系列。这些芯片提供多达 24 个内核、48 个线程、4 通道 DDR5-4800 内存支持和 64 个 PCIe Gen 5.0 通道。所有 Intel Xeon W-2400 CPU 都支持高达 2 TB 的内存容量 (ECC/R-DIMM)。

▲从 SKU 开始,阵容中的顶级芯片是 Xeon w7-2495X,它提供 24 个内核和 48 个线程。该芯片包含 45 MB 的 L3 缓存,具有 2.5 GHz 的基本时钟和高达 4.8 GHz 的提升。CPU 的 PL1 TDP 为 225W,PL2 TDP 为 270W。解锁模式应该将 TDP 推得更高。以下是各种 Xeon w-2400 SKU 的 PL1 和 PL2 分布:

Xeon w7-2400 - 225W (PL1) / 270W (PL2)

Xeon w5-2400 - 200W (PL1) / 240W (PL2)

Xeon w3-2400 - 165W (PL1) / 198W (PL2)

对于W790芯片组而言,简单看一眼Block Diagram就能看出这是专为Workstation而设计的,标准的HEDT定位

▲Xeon w9-3495X虽然相比Xeon Platinum 8480+或者8490H阉割了一些属性,但是其售价不到8480+的一半,也不到8490H的三分之一。

▲Xeon w7/5-2400虽然阉割很凶,但是价格是真香,毕竟64L PCIe Gen 5在这里。

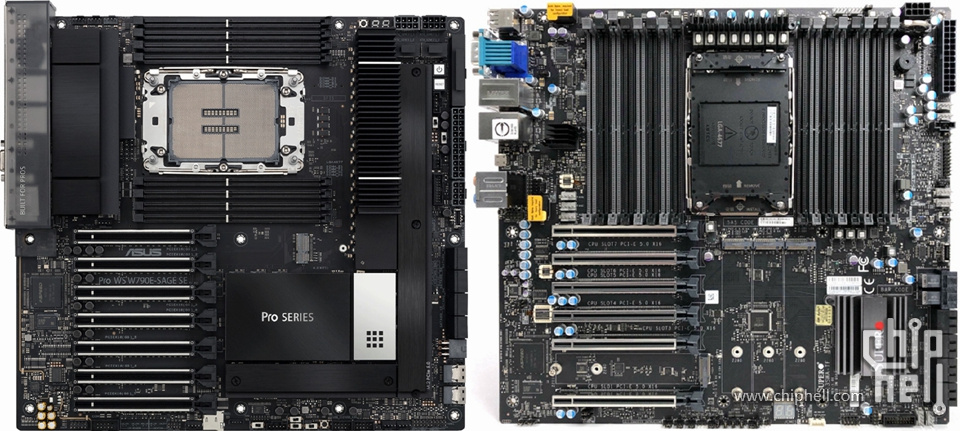

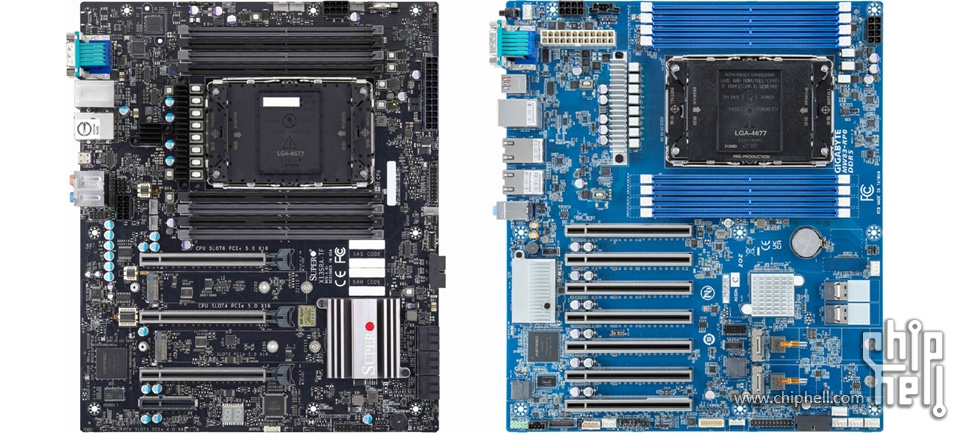

目前发布的W790主板我将其划分为以下三类产品:

Workstation & Gaming Station

ASUS Pro WS W790-ACE & ASRock W790 WS

▲这是一组坚持走INTEL工作站方向设计的产品,没有IPMI ASPEED芯片,这类产品会迅速在CHH以ARGB全塔方式出现在各大视觉设计师、游戏主播以及高玩的桌面上,新一代10W整机海景房的最佳载体,超频和大型游戏统统拿下无障碍,土豪最爱。

Server & Workstation Deluxe

ASUS Pro WS W790-SAGE SE & Supermicro X13SWA-TF

▲这一类适合对4th Gen Intel Xeon Scalable有想法,但是又米不动Xeon Platinum 8480+或者8490H,所以退而求其次接受单路Xeon W9的用户,360水冷前置,配四张RTX 4090 24GB Blower 或者Quadro RTX A6000 Ada 48GB,然后配一个SilverStone RM44 4U Rack机箱,上导轨上机柜,主板自带ASPEED芯片,用IPMI挂远程管理妥妥的AI生产力工具。

Server & Workstation Lite

Supermicro X13SRA-TF & GIGABYTE MW83-HP0

▲这类产品适合预算有限,贪图Xeon w7/5 2400便宜的用户,主板再丐也毕竟有ASPEED芯片,IPMI远程管理一样有,上4U Rack机箱然后上3-4张 RTX 3090 24GB Blower 跑跑DL也是很香的。

▲今天评测的产品是Intel Sapphire Rapids Xeon Workstation 中的旗舰CPU Xeon w-3495X以及美超微SuperMicro X13SWA-TF主板。

1▐ 开箱 1.1▐ Xeon w9-3495X 本次评测的主角是Intel Sapphire Rapids Xeon Workstation 系列的旗舰Xeon w-3495X。

1.1.1▐ 外观

▲Xeon w-3495X正面

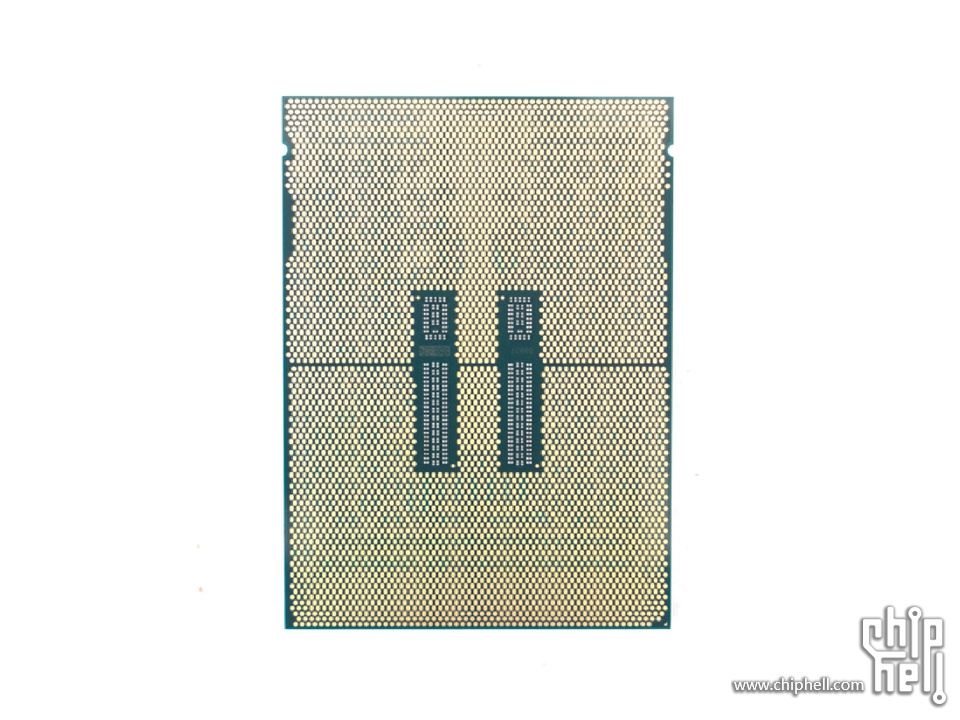

▲Xeon w-3495X背面

▲Xeon w-3495X顶盖

具体参数详见下面的SKU Table:

▲这两张图除了标明价格之外也说明了盒装零售只会出现7个型号,分别是w9-3475X、w7-3465X、w4-3435X、w7-2495X、w7-2475X、w5-2465X以及w5-2455X,其他型号均没有盒装零售版,所以无论谁拿到了w9-3495X一定是散片形式。同时按照JD的销售套路,非国行盒装,自营不上架,所以JD自营是一定买不到w9-3495X的。

▲求同存异,Xeon w9-3495X和Xeon Platinum 8480+/8490H虽然都是Sapphire Rapids,但是隶属不同的产品线,

对于需求是双路CPU而言,没有妥协的办法,只有选择4th Generation Intel Xeon Scalable系列,如果可以接受单路CPU的话,Xeon w9-3495X毫无疑问最具备诱惑力,56核112线程,最高4.8GHz的主频就卖5889刀。

1.1.2▐ Intel 加速器引擎

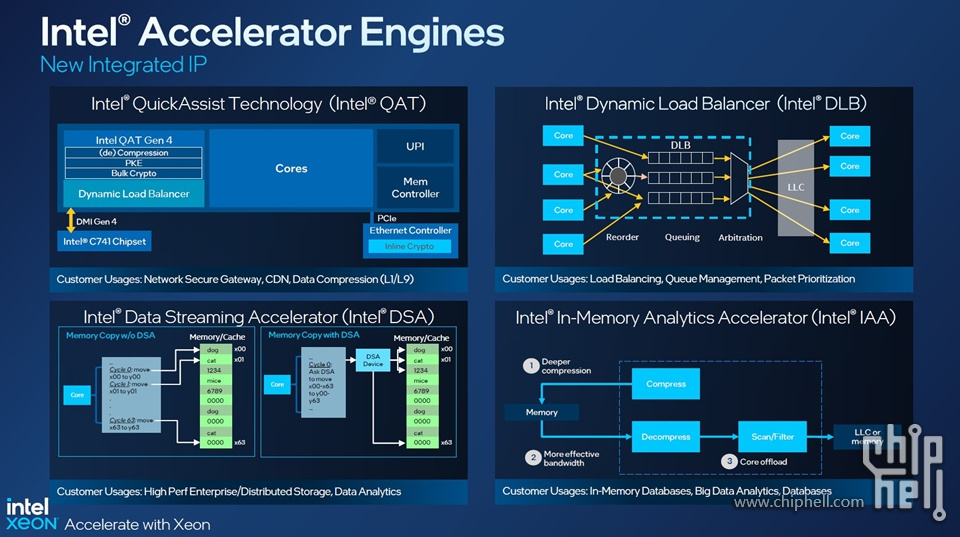

▲但是4th Generation Intel Xeon Scalable没那么简单,它是核心价值是四大可扩展内置加速器:QAT、DLB、DSA以及IAA:

英特尔® 数据流加速器(英特尔® DSA)

通过改进流数据移动和转换操作,推动存储、网络和数据密集型工作负载的高性能。英特尔® 数据流加速器(英特尔® DSA)旨在卸载导致数据中心规模部署开销的最常见数据移动任务。英特尔 DSA 有助于加快数据在 CPU、内存和高速缓存以及所有连接的内存、存储和网络设备之间的移动。

英特尔® 内存分析加速器(英特尔® IAA)

更快地运行数据库和分析工作负载,并可能具有更高的能效。英特尔® 内存分析加速器(英特尔® IAA)提高了查询吞吐量并减少了内存数据库和大数据分析工作负载的内存占用。英特尔 IAA 是内存数据库、开源数据库和数据存储(如 RocksDB 和 ClickHouse)的理想选择。

英特尔® QuickAssist 技术(英特尔® QAT)

通过使用英特尔® QuickAssist 技术(英特尔® QAT)加速加密和数据压缩,帮助减少系统资源消耗和 TCO。通过卸载加密、解密和压缩,这个内置加速器有助于释放处理器内核,以便系统可以为更多的客户端提供服务或使用更少的功率。合并压缩和加密时获得最大价值——借助英特尔 QAT,第四代英特尔® 至强® 可扩展处理器是性能最高的 CPU,可以在单个数据流中进行压缩和加密。

英特尔® 动态负载平衡器(英特尔® DLB)

提高与在多核英特尔® 至强® 可扩展处理器上处理网络数据相关的系统性能。英特尔® 动态负载平衡器(英特尔® DLB)支持在多个 CPU 内核/线程之间高效分配网络处理,并在多个 CPU 内核之间动态分配网络数据,以便在系统负载变化时进行处理。英特尔 DLB 还可以恢复在 CPU 内核上同时处理的网络数据包的顺序。

▲对于8490H而言,QAT、DLB、DSA以及IAA的的数量分别是4,不允许通过购买授权密钥来扩展加速器数量。

对于8480+而言,QAT、DLB、DSA以及IAA的的数量分别是1,可通过购买授权密钥来扩展加速器数量,但最多每个加速器拥有数量不超过4。

对于3495X而言,只有1个DSA,且不允许通过购买授权扩展。

其实Supermicro早已在做售卖加速器授权的生意了。溯源地址:https://www.supermicro.com/en/ac ... on-demand#learnmore

开箱即用:默认情况下,每个第 4 代英特尔至强 可扩展处理器包含 0 到 4 个默认“开启”的加速器。查看第四代英特尔至强可扩展处理器表,在下面突出显示的列中确定打开了多少英特尔加速器。

借助按需功能,客户可以根据他们的 CPU 选择升级加速器的数量。可以在第四代英特尔至强可扩展处理器表的最右侧列中找到能够升级英特尔加速器数量的第四代英特尔至强可扩展处理器。

第 4 代英特尔® 至强® 可扩展处理器可处理范围广泛的工作负载。不同的第 4 代英特尔至强可扩展处理器每个 CPU 包含不同数量的加速器。用户可以根据他们的工作负载升级(英特尔按需)英特尔加速器的数量。

有 4 种类型的许可证密钥选项(每种都需要额外费用)。

Analytic Suite 1(允许激活 1x IAA)

Analytic Suite 4(允许激活 4x IAA 和 4x DSA)

Communication/Storage Suite 2 (允许激活 2x QAT 和 2x DLB)。

Communication/Storage Suite 4 (允许激活 4x QAT、4x DLB 和 4x DSA)。

最多有 16 种或 4 x 4 种类型的加速器

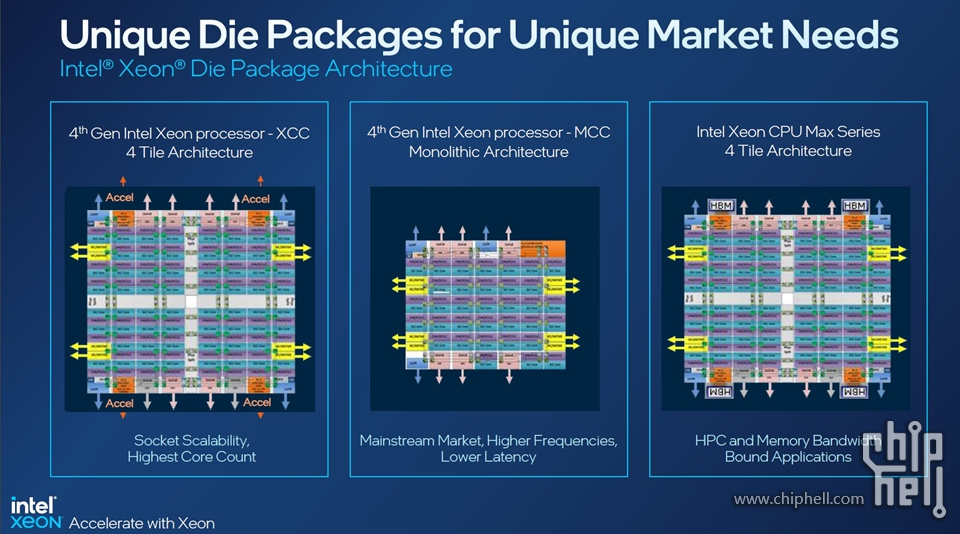

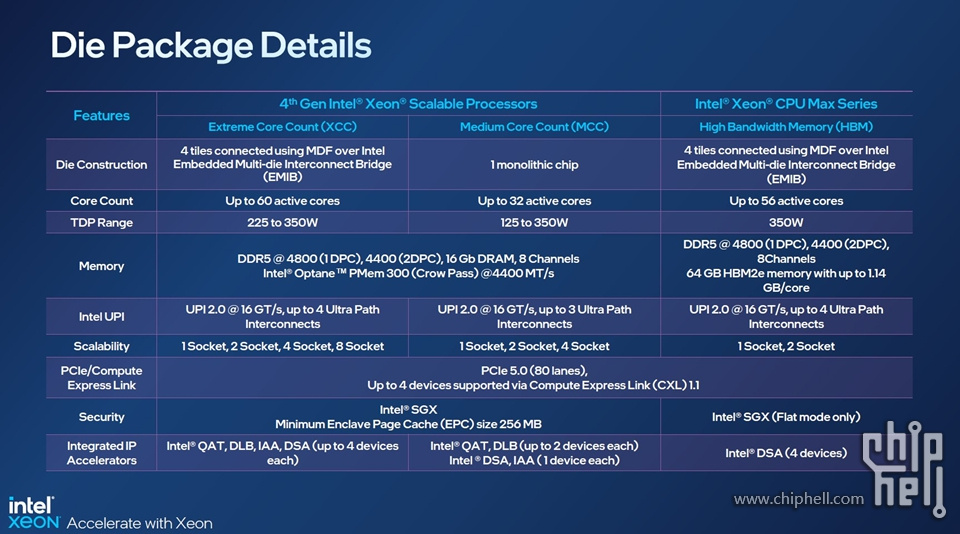

▲4th Gen Intel Xeon Scalable Sapphire Rapids Die Packages

基于 Sapphire Rapids 的 Xeon 有三种主要的封装配置:XCC、MCC 和 Max(XCC + HBM)。

▲4th Gen Intel Xeon Scalable Sapphire Rapids Die Package Details

XCC最多支持4组QAT、DLB、DSA、IAA加速器,而MCC仅支持2组。

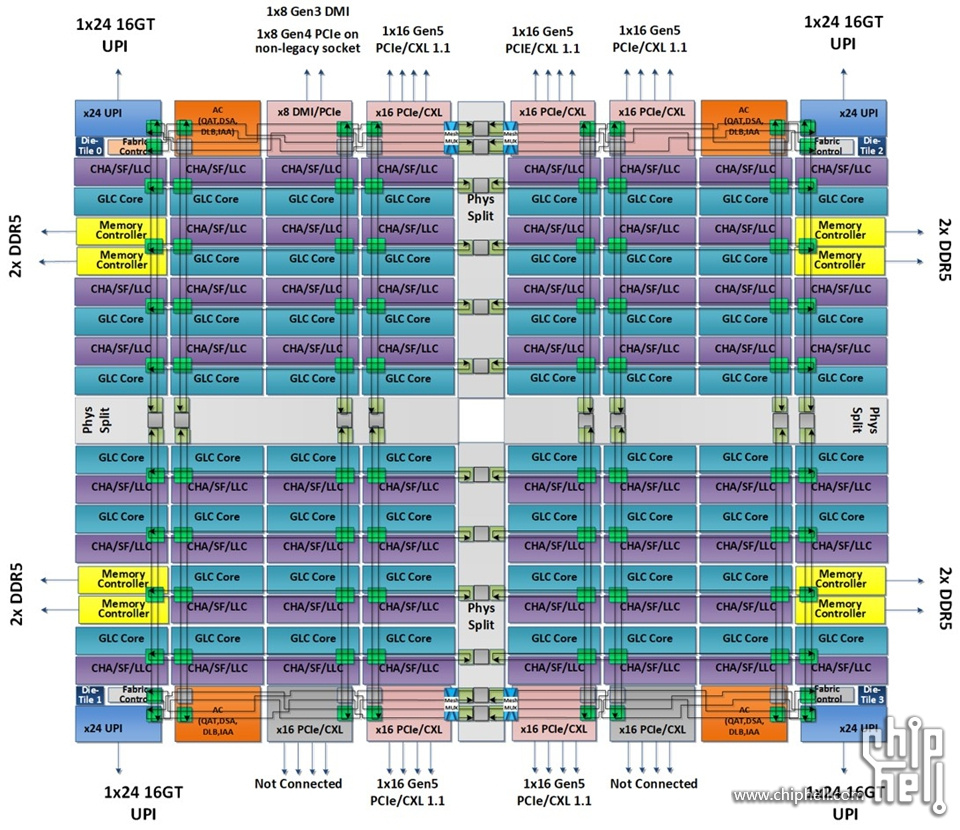

▲Intel Sapphire Rapids XCC (STH)

XCC(Extreme Core Count)由4个Tile组成,每个Tile支持1组QAT、DLB、DSA、IAA加速器,红色标注区域即加速器。

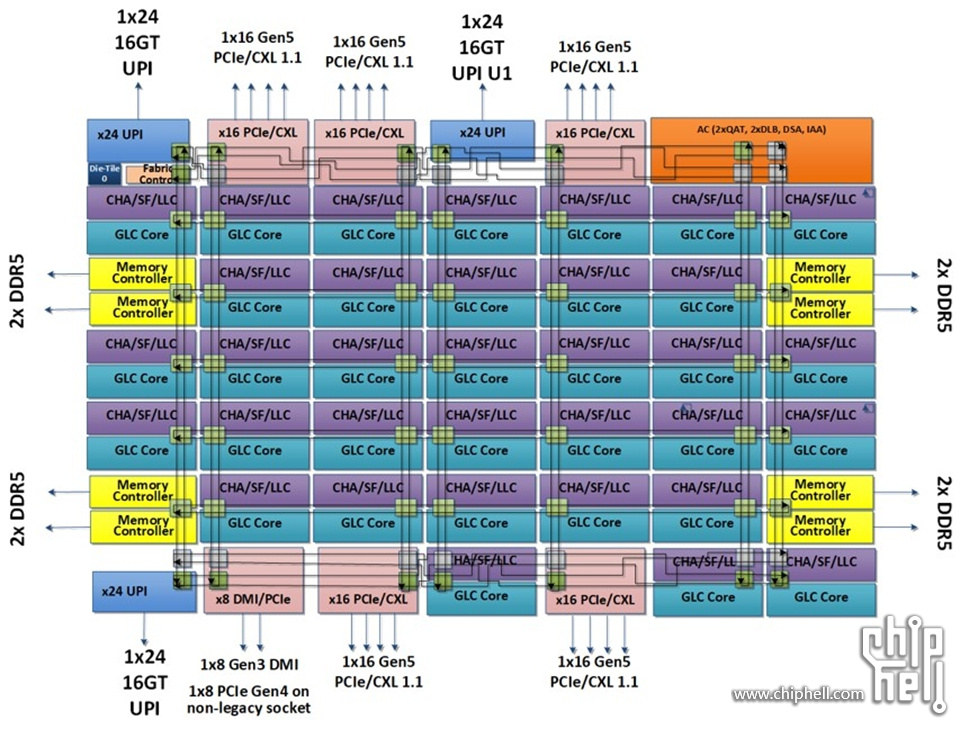

▲Intel Sapphire Rapids MCC Die Diagram(STH)

MCC(Medium Core Count)支持2组QAT、DLB、DSA、IAA加速器,右上方红色标注区域即加速器。

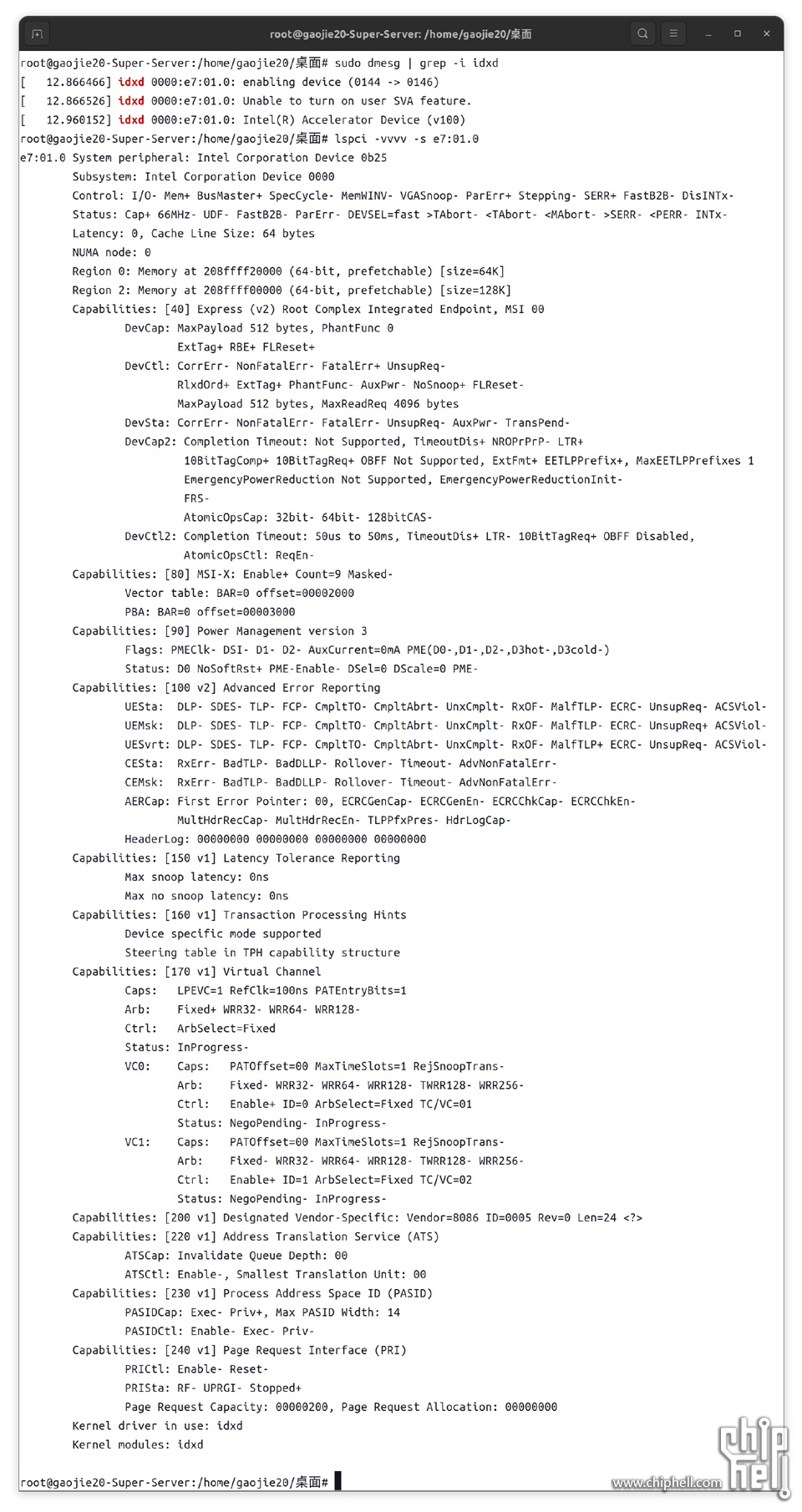

下面我对基于XCC的3495X进行加速器的检测,内核驱动程序英特尔® 数据加速器驱动程序 (IDXD) 是一种典型的内核驱动程序,用于识别系统中的设备实例。这也是英特尔® 可扩展 IOV 规范中称为虚拟设备组合模块 (VDCM) 的组件,它创建实例以促进将虚拟英特尔® DSA 实例暴露给来宾操作系统。

- sudo dmesg | grep -i idxd

▲先通过上述命令找到Intel DSA加速器设备ID

▲再通过设备ID查看设备详情,确实只有一组DSA加速器!

1.1.3▐ 拓扑结构

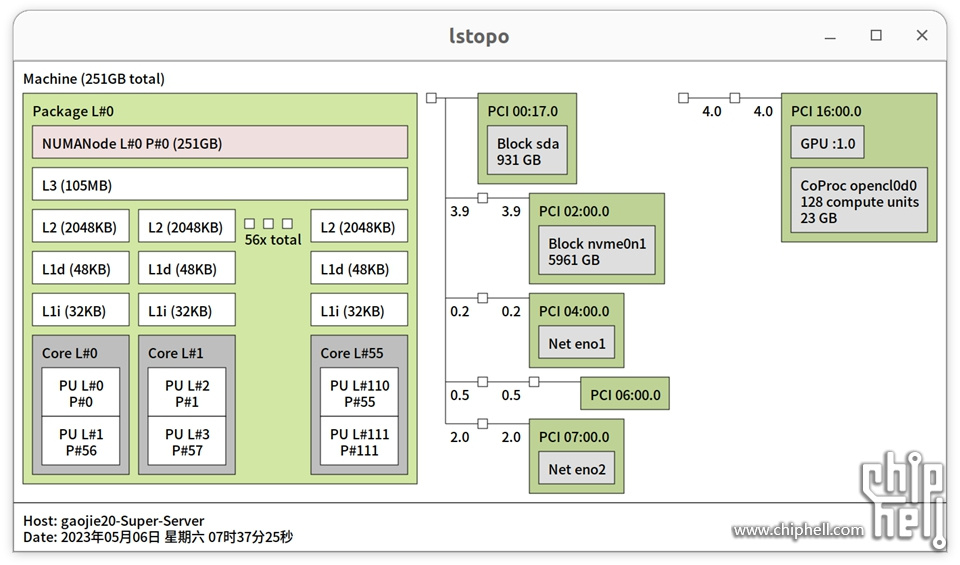

要了解一个CPU的拓扑结构最好的方法就是使用lstopo。

- sudo apt install hwloc

- stopo

▲Xeon w9-3495X(Sapphire Rapids)的拓扑结构图

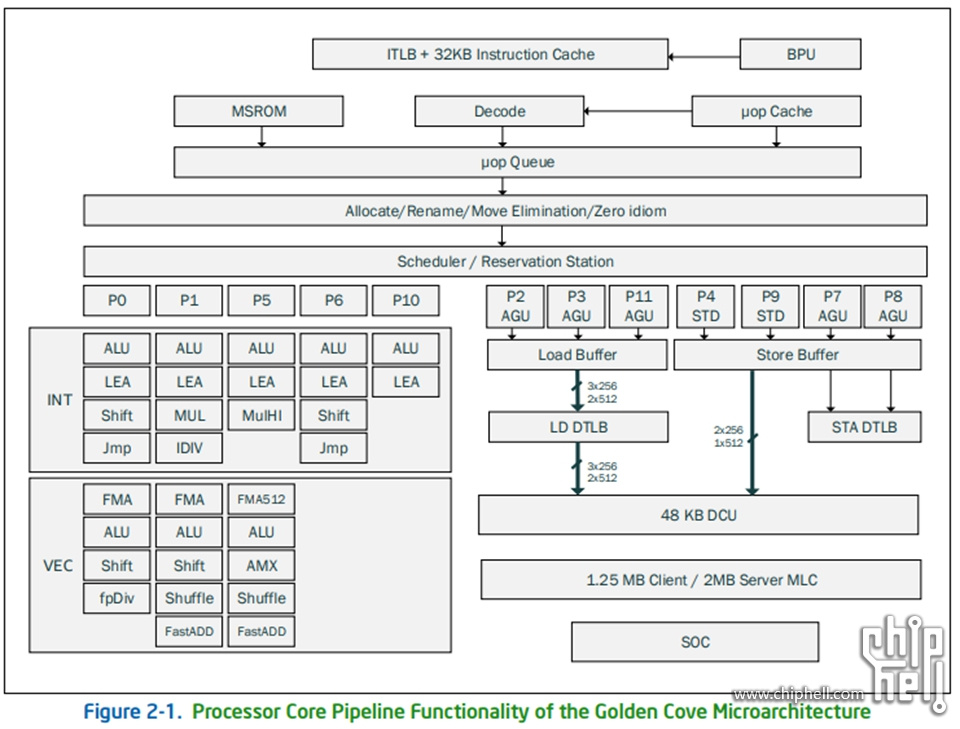

[1] 处理器56个P-Core(Golden Cove)

[2] 每个P-Core(Golden Cove)有独立的L2=2048KB,且有两个超线程。同一个核心的超线程顺序编号;56核心共享L3=105MB,

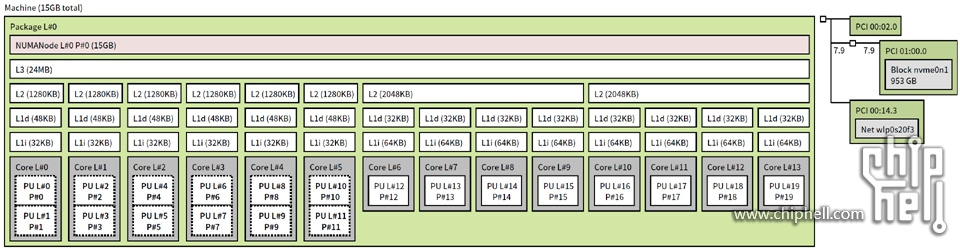

我们再找Alder Lake的拓扑图比较一下:

▲Core i7-1280P(Alder Lake)的拓扑结构图

[1] 处理器6个P-Core(Golden Cove),以及8个E-Core(Gracemont)都识别到了。编号上,Golden Cove在前,Gracemont在后,这个特性和arm在android下是相反的。

[2] 每个P-Core(Golden Cove)有独立的L2=1280KB,且有两个超线程。同一个核心的超线程优先编号,与早期Linux相反;

[3] 每个E-Core(Gracemont)只有一个线程。每四个E-Core(Gracemont)共享L2 cache=2048KB。

[4] 6个P-Core(Golden Cove)+8个E-Core(Gracemont)共享L3=24MB。

Alder Lake这种异构构架做多线程并行的方式,问题就很大了,大小核超线程的数量的不同,以及超线程的新的编号方式,导致线程池的亲和性设置很难自动且正确地完成。

Sapphire Rapids的架构,全部是同构核心,即便有NUMA这样非对称内存访问结构,也还算简单,并行程序在分配,管理,访问内存的时候注意区分本地内存和远端内存即可,在任务调度上不需要考虑因同样的任务在不同核心上计算效能的差异导致的负载不均衡问题。

这也是Sapphire Rapids Xeon为何全部使用P-Core(Golden Cove)的主要原因,服务器和工作站的部署要方便从上一代Xeon迁移过来,必须要具备完整的兼容性。Intel这么注重企业级客户的公司怎么可能在Xeon上犯异构构架这种低级错误!

1.1.4▐ 指令集

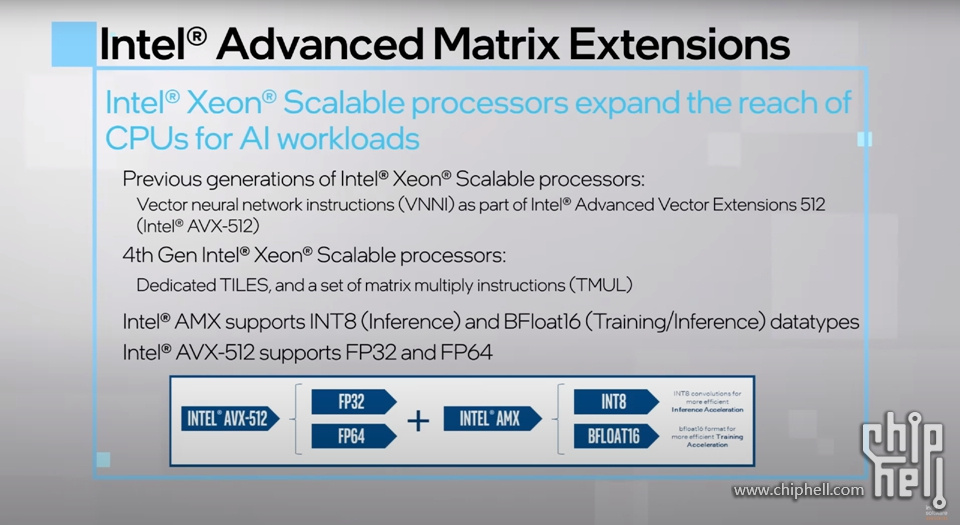

▲Sapphire Rapids Xeon W在官方宣传页一直主打3rd Deep Learning Boost(AVX-512 支持)和 Advanced Matrix Extensions( AMX)(INT8 和 BFLOAT16)。

▲而另外一张来自4th Generation Intel Xeon Scalable的官图则显示Intel指令集的布局:因为AVX512_VNNI加入AVX512作为子集,所以AVX512的FP32和FP64浮点计算得到加强。AMX则主打INT8和BF16。

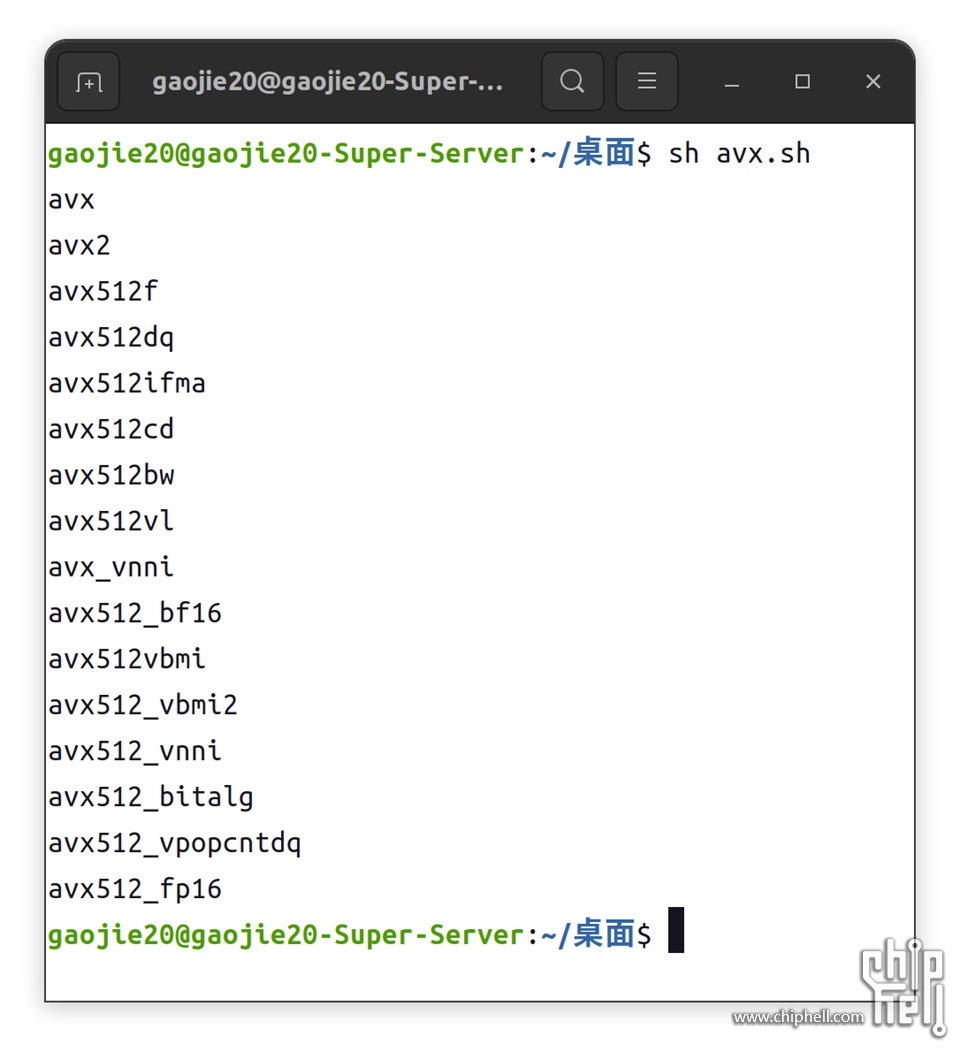

虽然cpuid或者lscpu可以很方便检测CPU所以的指令集,但是体现的信息量太多太杂,简单写几行代码就可以很方便的列举Xeon w9-3495X的关键指令集。

1.1.4.1▐ AVX512

显示AVX相关指令集

- for f in `cat /proc/cpuinfo |grep avx | uniq `

- do

- if [ "${f##avx}" != "$f" ]

- then

- echo $f

- fi

- done

保存为.sh,如下执行即可。

▲这里很多都是AVX和AVX512的子集,值得关注的是AVX512_VNNI已作为AVX512的子集存在,旨在加速基于卷积神经网络的算法。AVX512_VNNI 背后的主要动机是观察到许多紧密的循环需要两个 16 位值或两个 8 位值的重复乘法,并将结果累加到 32 位累加器。

▲利用基础AVX 512 vs. 利用AVX512_VNNI 做向量乘加

深度学习的核心计算可以简化为乘加运算。在 VNNI 之前,我们需要做上图中这样的向量乘加,使用AVX-512基础版AVX512_BW:

对于8位则使用三条指令实现:VPMADDUBSW将4个8位对相乘输出2个16位对,VPMADDWD 用于将两个 16 位对相乘并将它们加在一起,然后将 VPADDD 添加累加值输出32位。而AVX512_VNNI只需要 1 条指令VPDPDUSD就可以完成。通过将三条指令融合为一条,可以最大化利用计算资源,提升 cache 利用率及避免潜在的带宽瓶颈。

因此,AVX512_VNNI与AVX-512基础版AVX512_BW相比将为 INT8 带来 3倍峰值计算的提升。此外,由于在一个 AVX512 寄存器中,与 FP32 相比可以容纳 4 倍 INT8 数据,与 FP32 相比又可以带来 4倍峰值计算的提升。

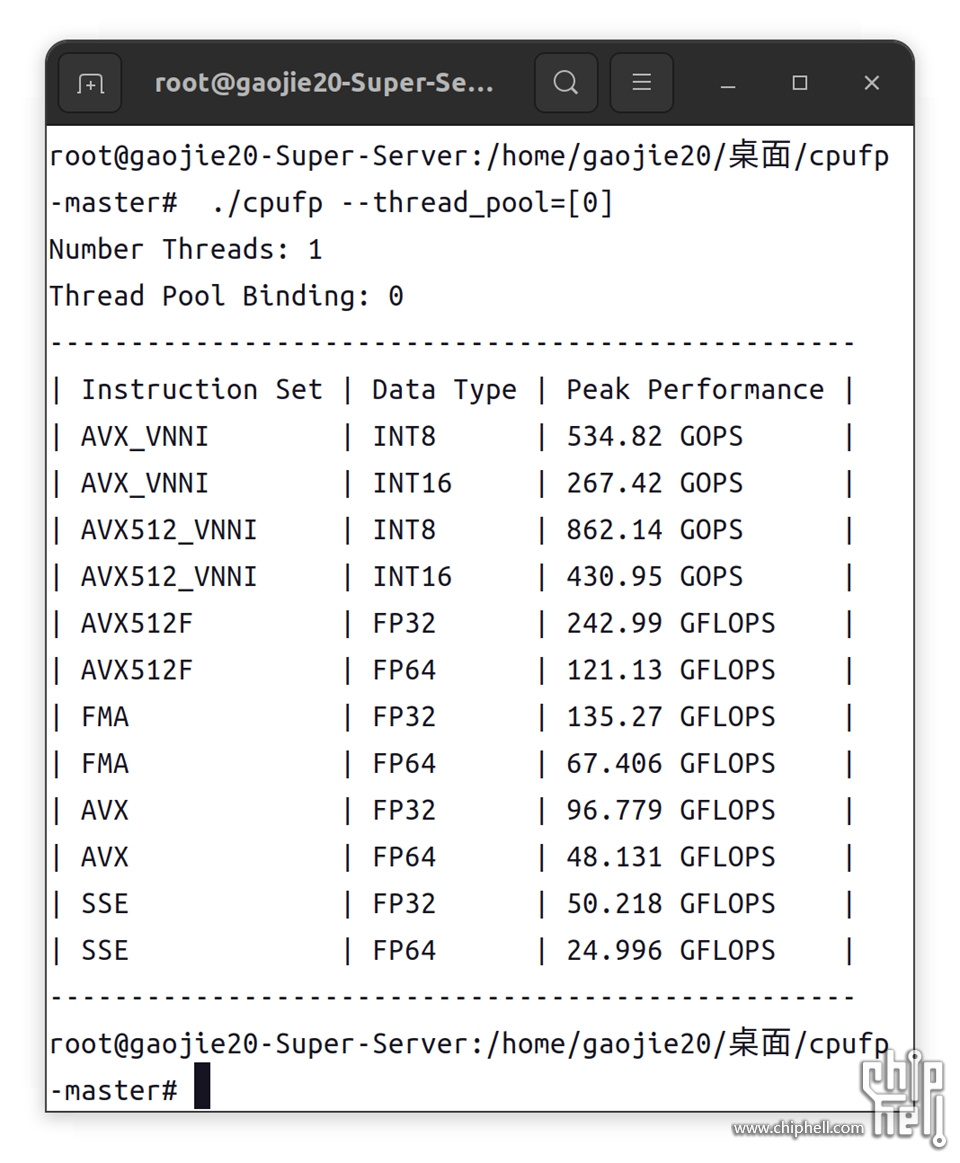

那么AVX512_VNNI到底有多强?相比起其他AVX512子集有多大优势?下面实测:

▲硬件与环境配置

cpufp是商汤科技的高洋高叔的作品,可以很简单的计算出CPU的浮点计算峰值

▲Xeon w9-3495X(Sapphire Rapids)的多核Golden Cove基准测试截图

▲Xeon w9-3495X(Sapphire Rapids)的单核Golden Cove基准测试截图

下面我们只看单核基准:

[1] AVX_VNNI指令集的INT8吞吐是FMA指令集中FP32的4倍,和前代保持一致。

[2] AVX_VNNI指令集的INT16吞吐则是FMA指令集中FP32的2倍,和前代保持一致。

[3] SSE指令集对应浮点类型的吞吐是AVX指令集的一半,和前代保持一致。

[4] AVX指令集对应浮点类型的吞吐是FMA指令集的大约71.5%。

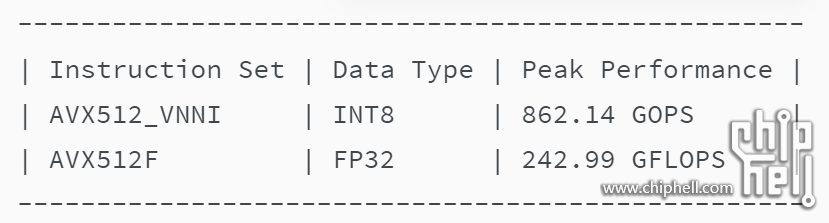

[5] AVX512_VNNI指令集INT8的吞吐是AVX512F指令集中FP32的3.56倍。

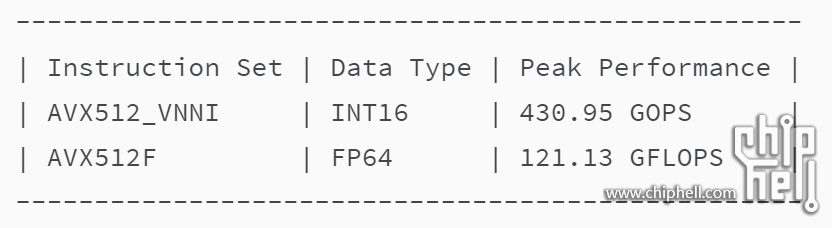

[6]AVX512_VNNI指令集INT16的吞吐是AVX512F指令集中FP32的1.78倍。

▲我实测是AVX512_VNNI指令集INT8的吞吐是AVX512F指令集中FP32的3.56倍。

▲我实测是AVX512_VNNI指令集INT16的吞吐是AVX512F指令集中FP64的3.56倍。

结论是Xeon w9-3495X(Sapphire Rapids)因为AVX512_VNNI的加入,使得AVX512在FP32、FP64的运算速度得到大规模加强。

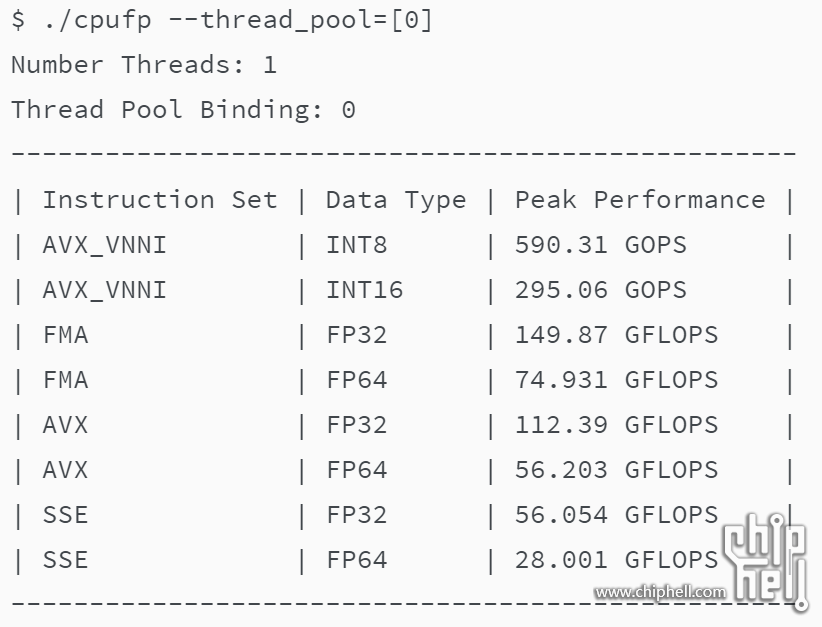

我知道此时又有人要问Alder Lake的情况,毕竟Alder Lake同样有Golden Cove核心。

- $ ./cpufp --thread_pool=[0]

- Number Threads: 1

- Thread Pool Binding: 0

▲Core i7-1280P(Alder Lake)的单核Golden Cove基准测试结果(来自商汤科技高洋高叔)

可以看出该架构中:

[1] AVX VNNI指令集的INT8吞吐是FMA指令集(CPU最大浮点吞吐指令)中FP32的4倍。

[2] AVX VNNI指令集的INT16吞吐则是FMA指令集(CPU最大浮点吞吐指令)中FP32的2倍。

[3] SSE指令对应浮点类型的吞吐是AVX指令的一半。

[4] AVX指令对应浮点类型的吞吐是FMA指令的大约3/4。

但是并不支持AVX512更不支持AVX512_VNNI!

▲Golden Cove微构架

首先Sapphire Rapids的Golden Cove支持AVX512F以及AVX512 VNNI,而Alder Lake的Golden Cove默认是不支持的,只有在关闭Gracemont核心时候才可以有限支持AVX512。

1.1.4.2▐ AMX

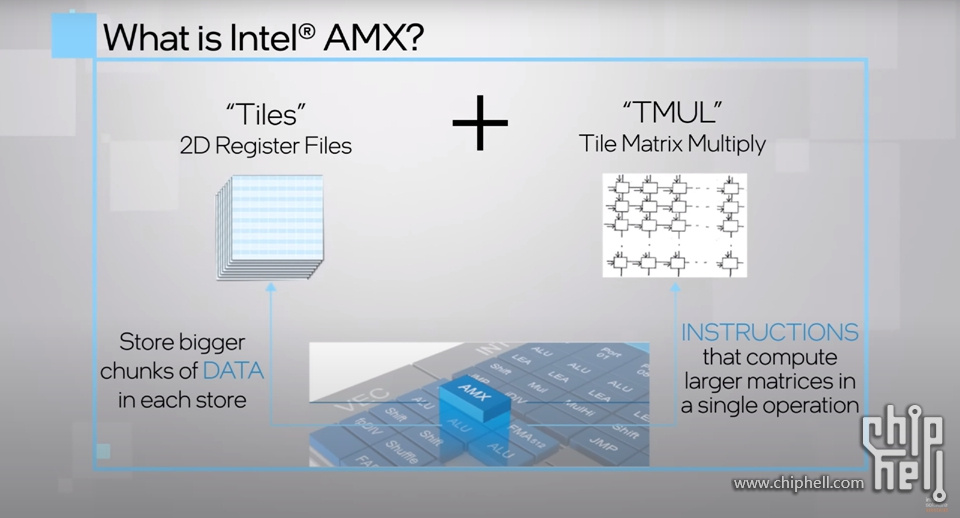

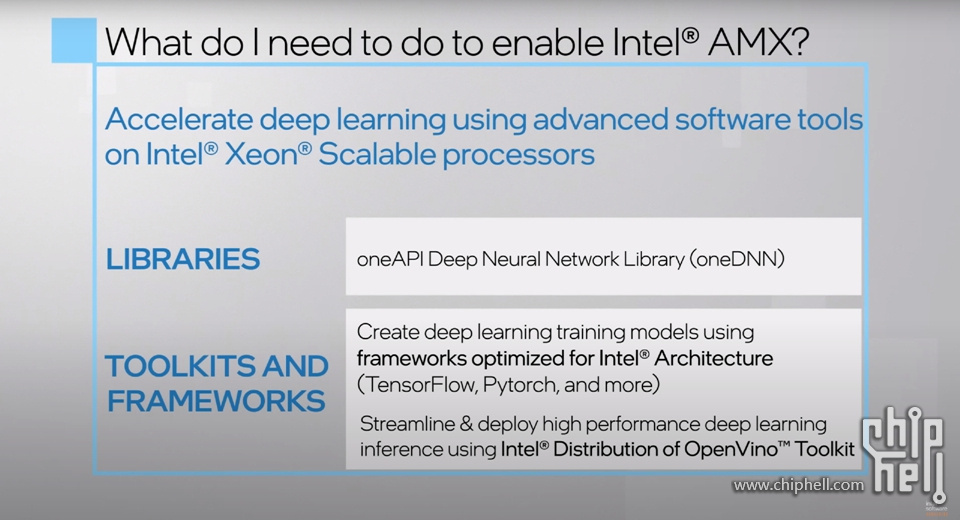

▲Intel AMX 是一种通过使用安装在 CPU 中的新运算单元“TMUL(Tile Matrix multiply Unit)”有效执行矩阵计算的机制,并安装在执行 AI 推理处理的最新处理器(CPU/GPU)中。正在成为趋势。支持 AMX 的 CPU 有两个内置的 TMUL 引擎,可用于高效地执行矩阵运算。结果,可以比以前更有效地执行机器学习(machine learning)/深度学习(deep learning)推理处理,例如图像识别和 NLP。

▲要使用Intel AMX需要安装intel oneDNN库,然后通过使用为Intel oneAPI优化过的TensorFlow、Pytorch等进行调用,也可以通过Intel自己开发的套件比如Openvino等套件进行使用。同时相关指令集也被命名为AMX加入Intel CPU指令集扩展中。

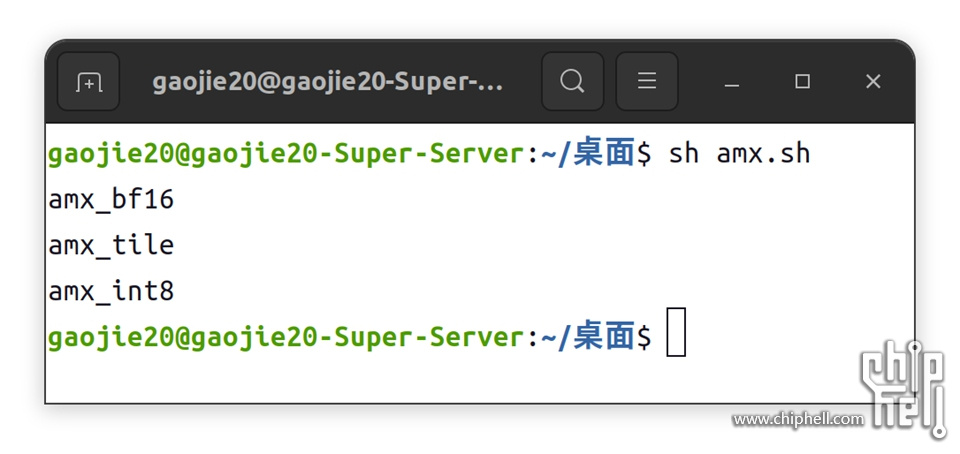

显示AMX相关指令集代码

- for f in `cat /proc/cpuinfo |grep avx | uniq `

- do

- if [ "${f##amx}" != "$f" ]

- then

- echo $f

- fi

- done

保存为.sh,如下执行即可。

▲AMX指令集扩展其实是以上AMX_BF16、AMX_TILE和AMX_INT8 3个指令集组成。

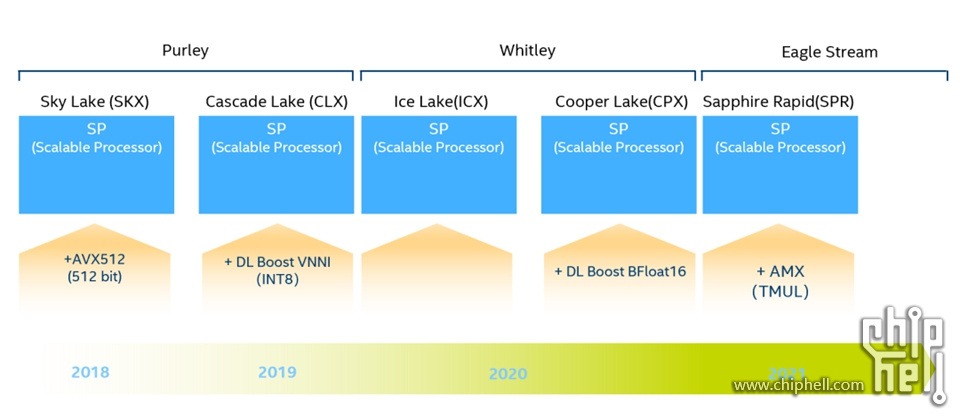

▲英特尔x86平台AI能力演进

Intel在2018年开始就一直致力跟进AI计算业务,2018年在Sky Lake上推出AVX512,2019年在Cascade Lake上推出AVX512_VNNI,2020年在Cooper Lake上推出AVX512_BF16,2022年底在Sapphire Rapids上推出AMX指令集,这就意味着AMX目前代表Intel最快的AI业务处理能力,在深度学习范畴逐渐取代了AVX512_BF16和AVX512_VNNI,成为当今最强DL指令集群。

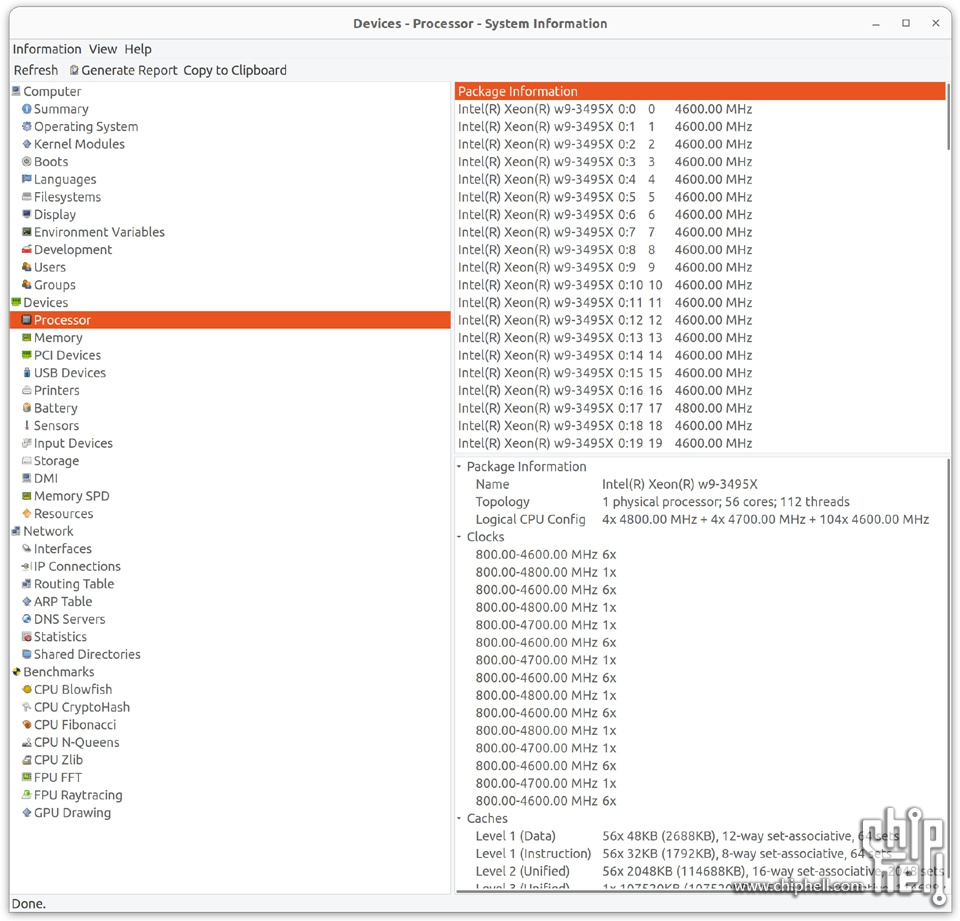

1.1.5▐ Boost主频

Xeon w9-3495X的主频Boost机制可以通过Ubuntu下的一个小工具hardinfo去检测:

▲图中可以看到Xeon w9-3495X的112线程的boost最高频率为4x4.8GHz+4x4.7GHz+104x4.6GHz,那么相应的56核心boost最高频率就是2x4.8GHz+2x4.7GHz+52x4.6GHz,而且相关高频核心可以被准确定位到:

Package Information

Intel(R) Xeon(R) w9-3495X 17 0:17 4800.00 MHz

Intel(R) Xeon(R) w9-3495X 34 0:34 4800.00 MHz

Intel(R) Xeon(R) w9-3495X 35 0:35 4700.00 MHz

Intel(R) Xeon(R) w9-3495X 37 0:37 4700.00 MHz

通过hardinfo可以定位到17和34号核心boost最高频率为4.8GHz,35和37号核心boost最高频率为4.7GHz,其余核心boost最高频率均为4.6GHz

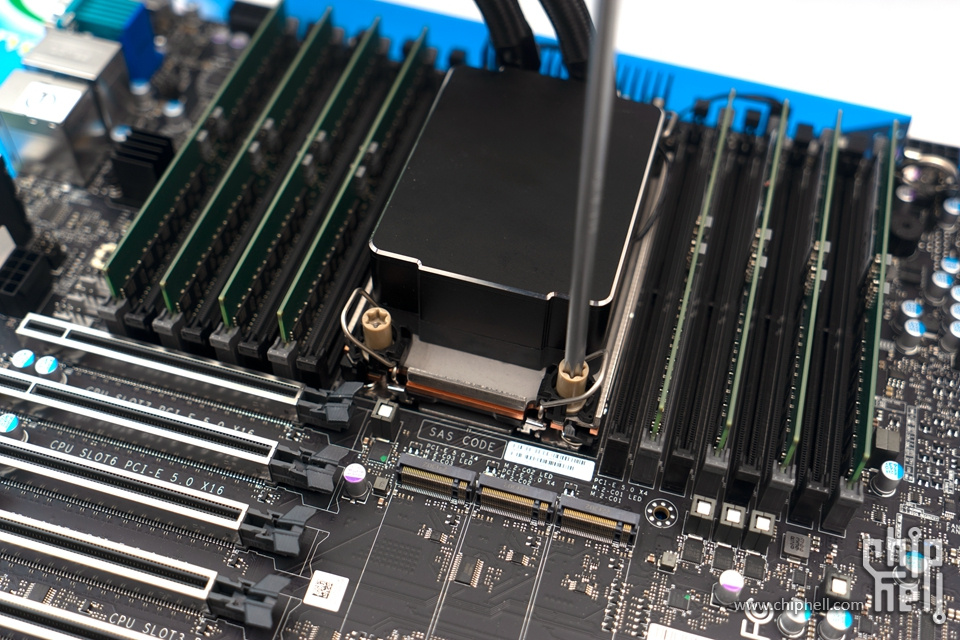

1.2▐ Supermicro X13SWA-TF

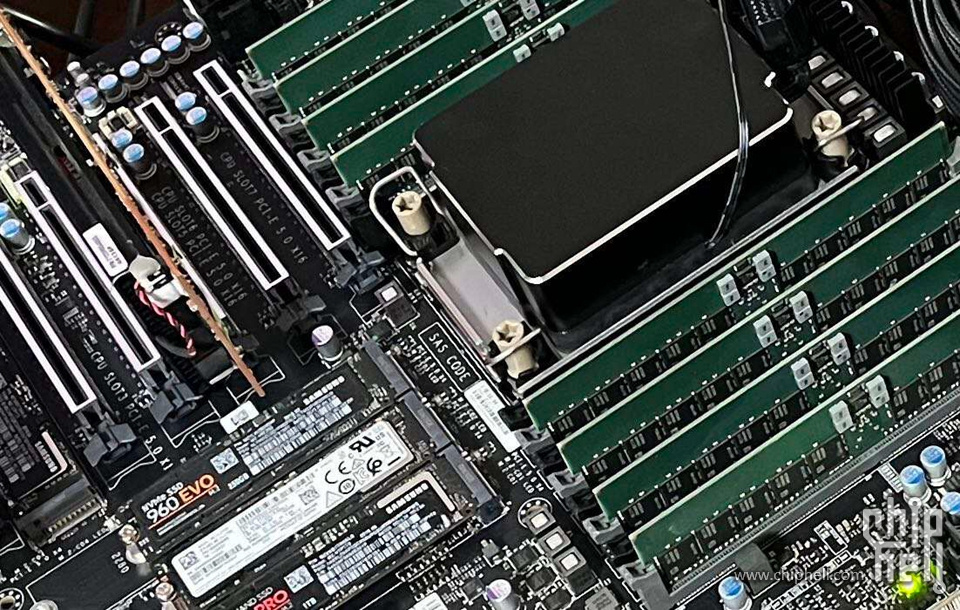

本次测试用来搭配Xeon w-3495X的主板是美超微SuperMicro X13SWA-TF

1.2.1▐ 外观

▲外盒

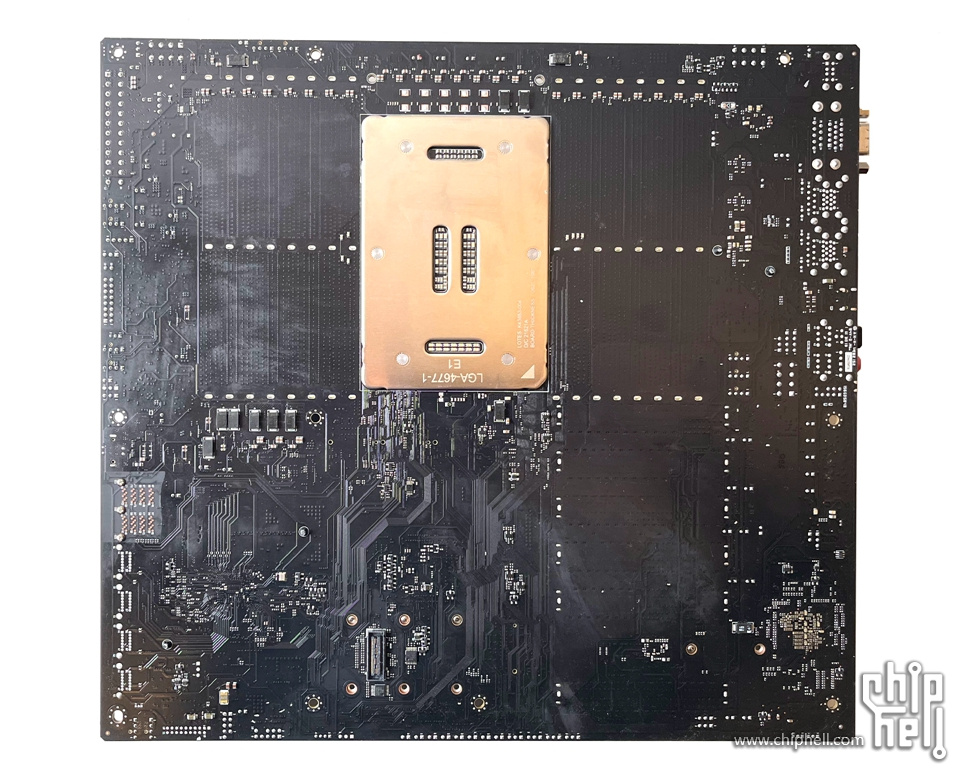

▲PCB正面

▲PCB背面

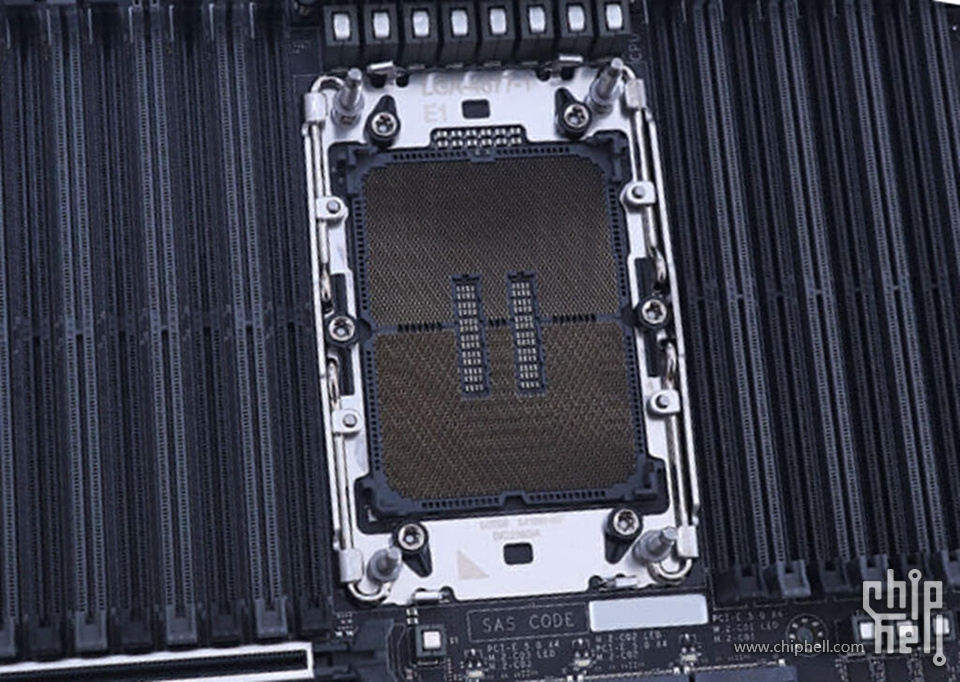

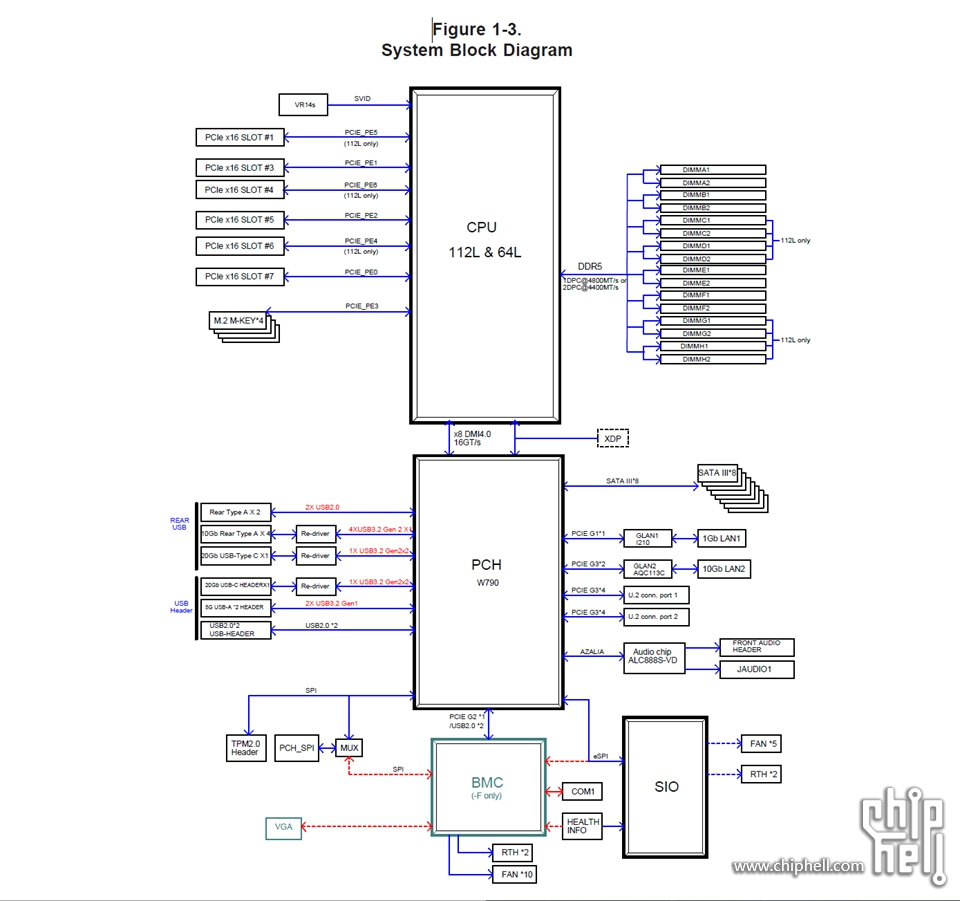

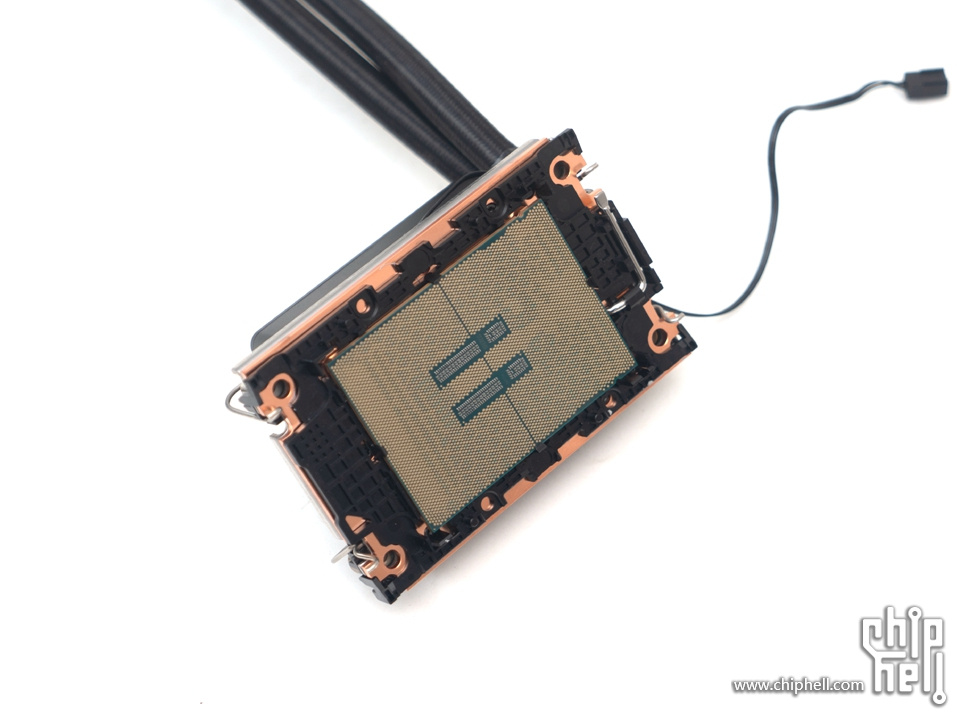

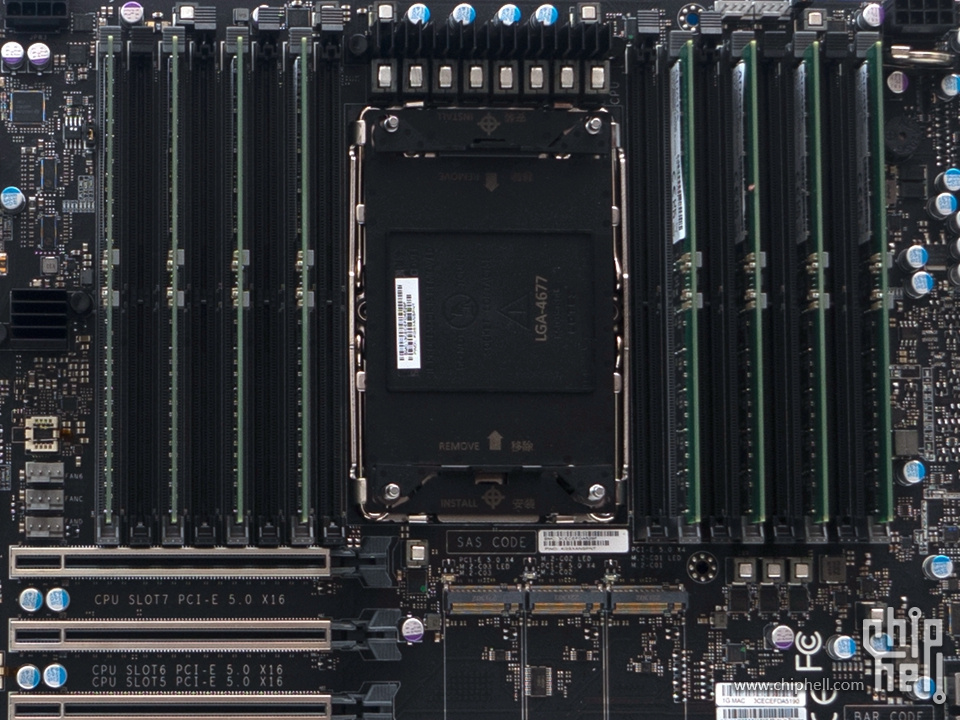

▲该主板的CPU接口为LGA4677,CPU最高支持到56 个内核112线程的XEON W-3495X,支持水冷散热 。 实测处理器超频功能可解锁CPU TDP至700W以上。

▲挡板的料号为MCP-260-00182-0B,SATA线的料号为MNL-2444-QRG,共八根。

▲CPU-GPU 电源连接适配器:CBL-PWEX-0663

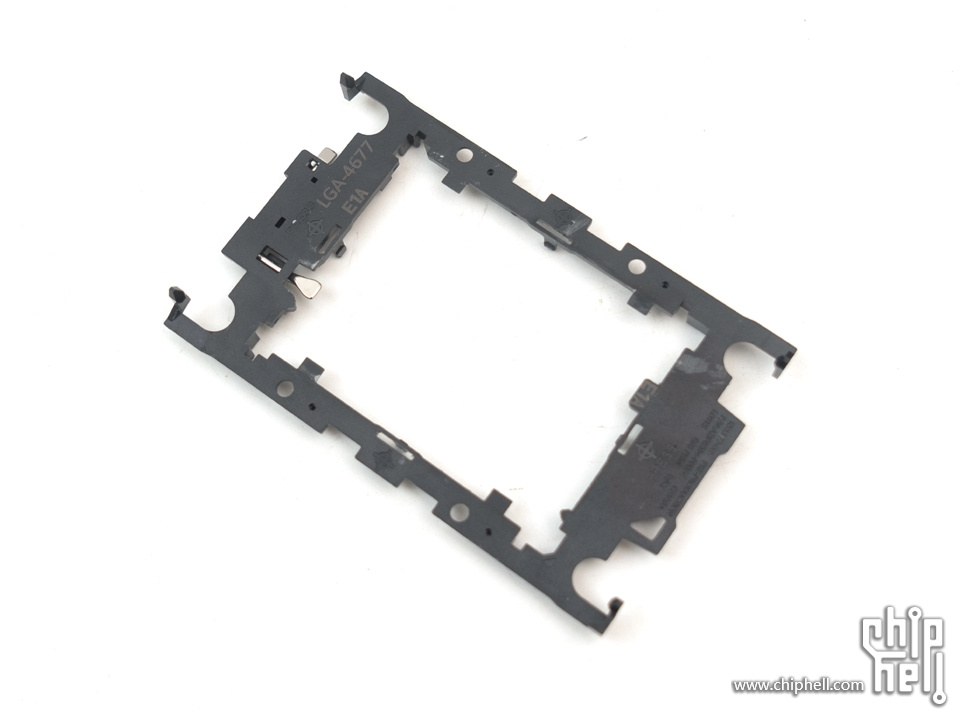

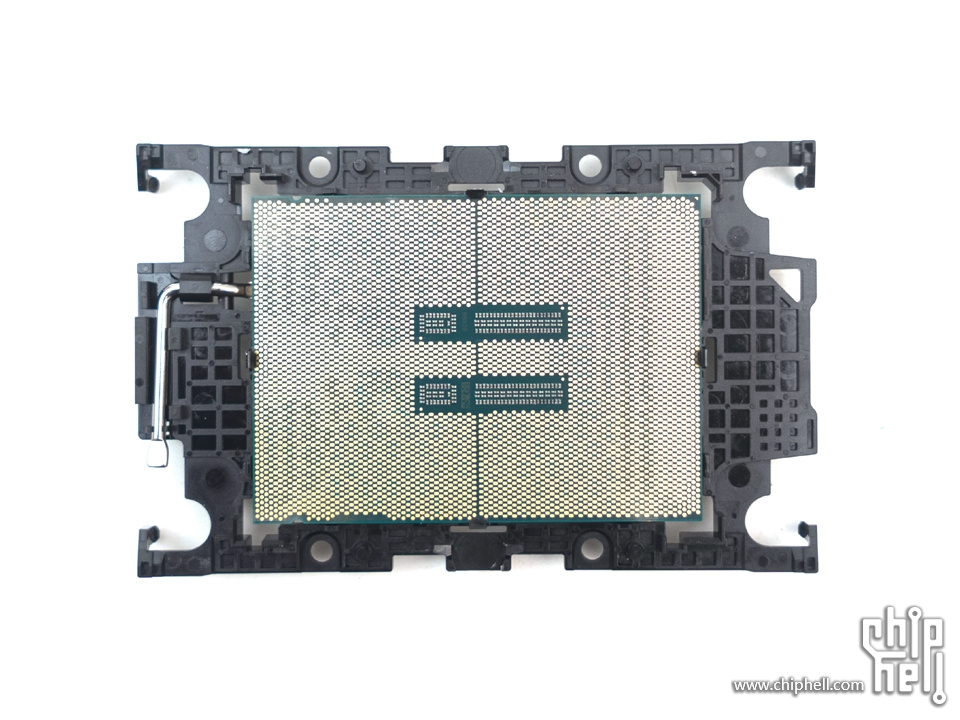

▲Intel® Xeon® W-3400 系列 (112L) 处理器的 E1A 载体:SKT-1333L-0001-LTS

▲安装需要首先将CPU安装在载体支架中,然后再安装在CPU插槽中即可。

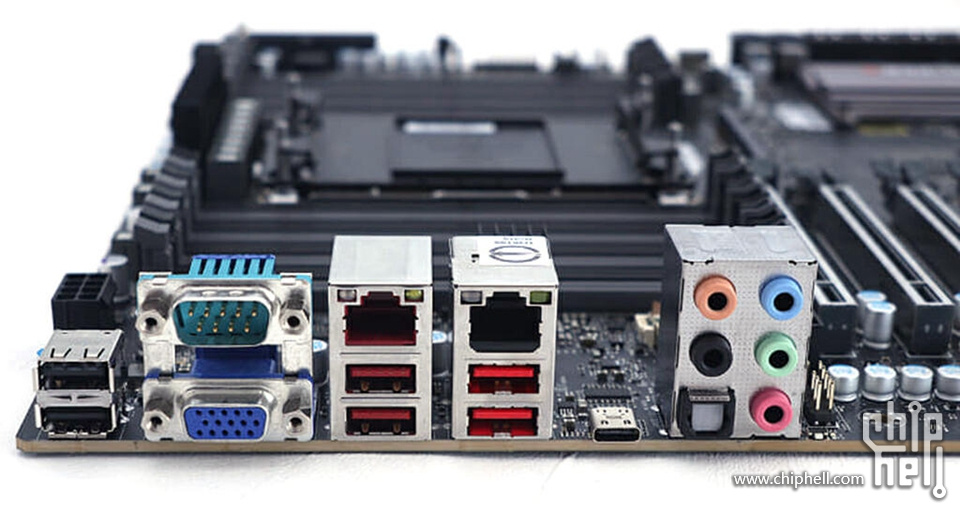

▲主板IO方面:

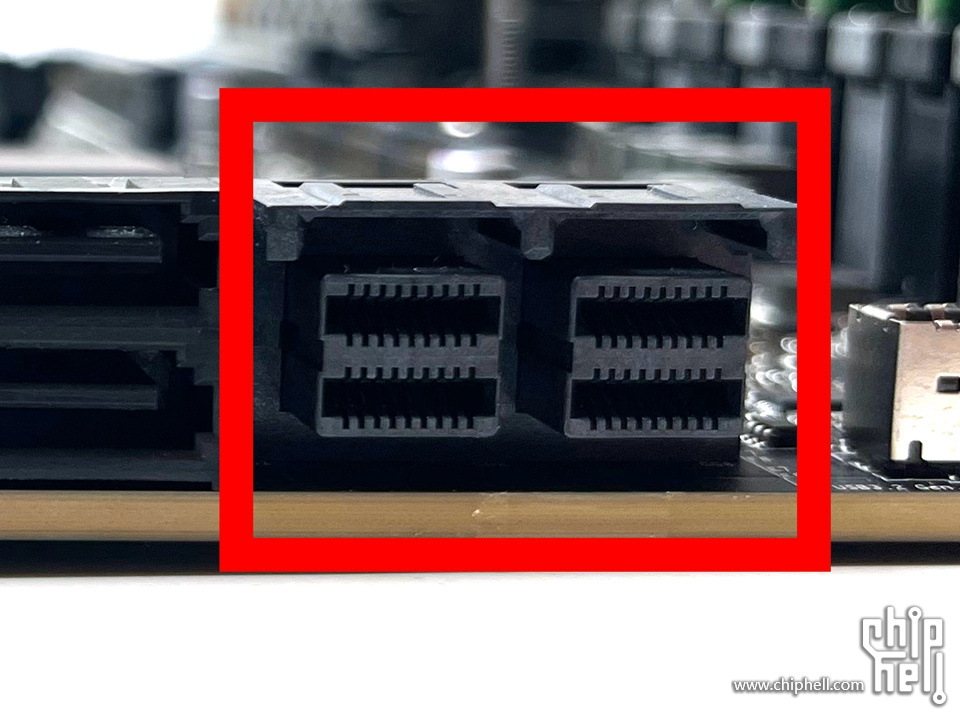

两个支持20Gb/S的速率的USB 3.2 Gen 2x2接口,设定为一个USB Type-C和一个USB Type-E前置接头。

四个支持10Gb/S的速率的USB 3.2 Gen 2x1接口,设定为USB Type-A。

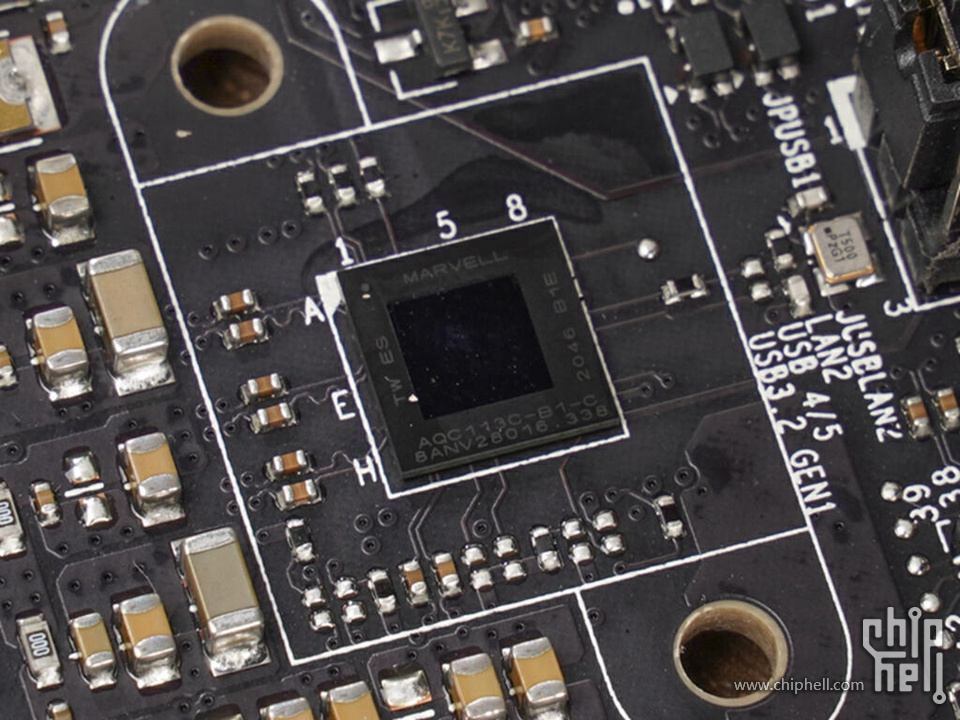

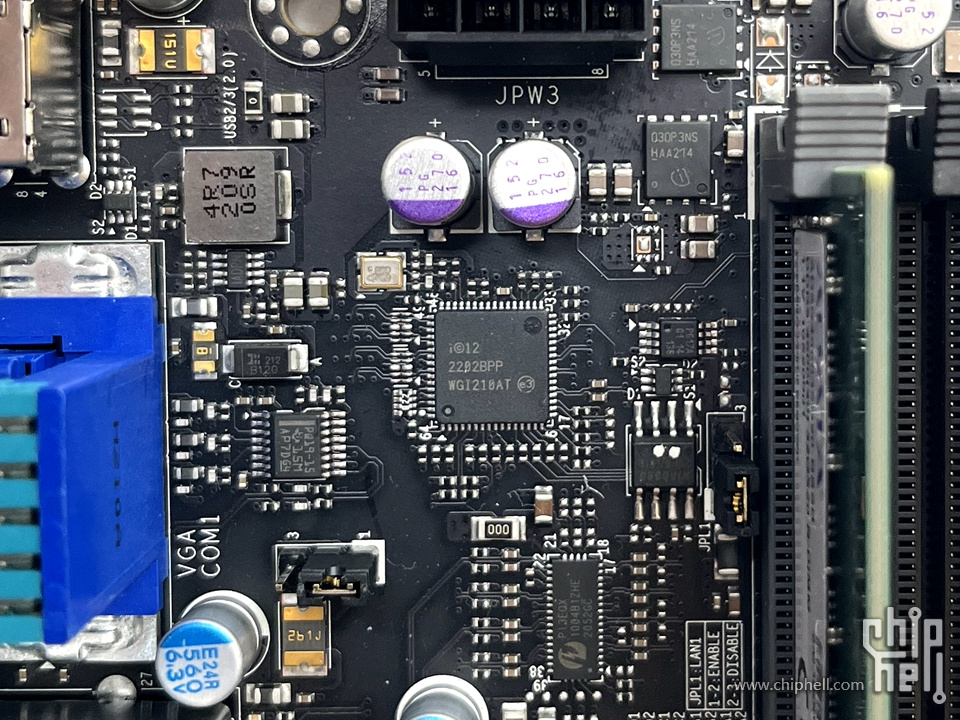

网络方面配置了一个基于AQC113C芯片的万兆网卡,以及一个基于i210AT芯片的千兆网络可与IPMI共享使用。视频输出方面提供一个VGA端口支持IPMI输出。

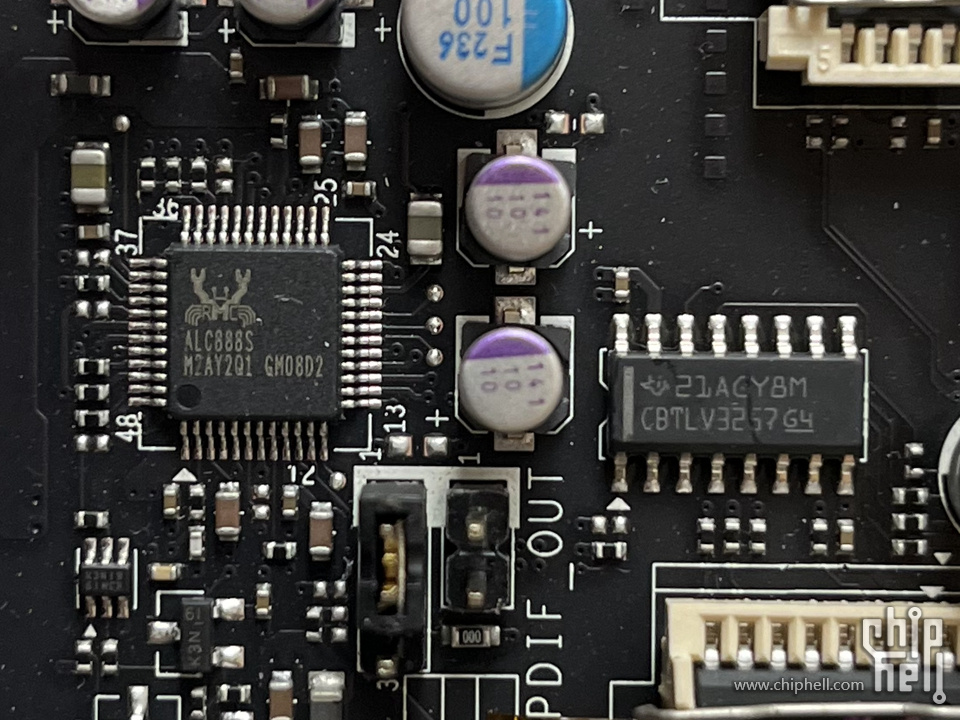

音频方面配置了Realtek ALC888S芯片支持7.1声道输出。

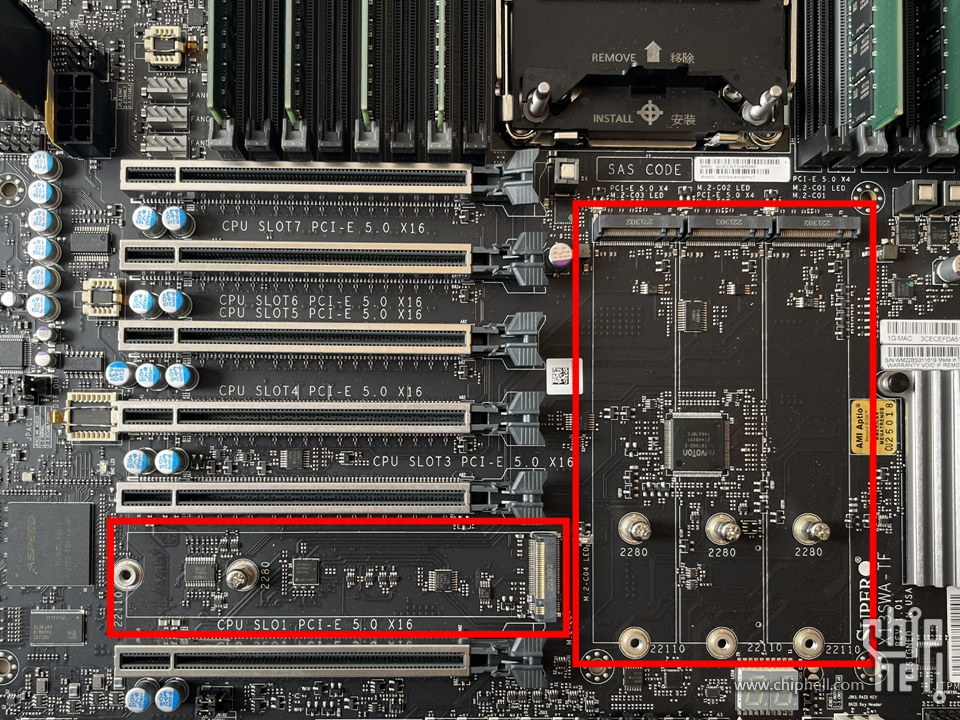

▲主板的右侧下方有8 个 SATA 3 (6Gbps) 端口以及两个U.2 端口,因为来自PCH的PCIe Lane,所以速度被设定在PCIe 3.0 x4。

▲在主板上面还设计有4个支持PCIe Gen5 X4的M.2,支持2260、2280以及22110规格的SSD。

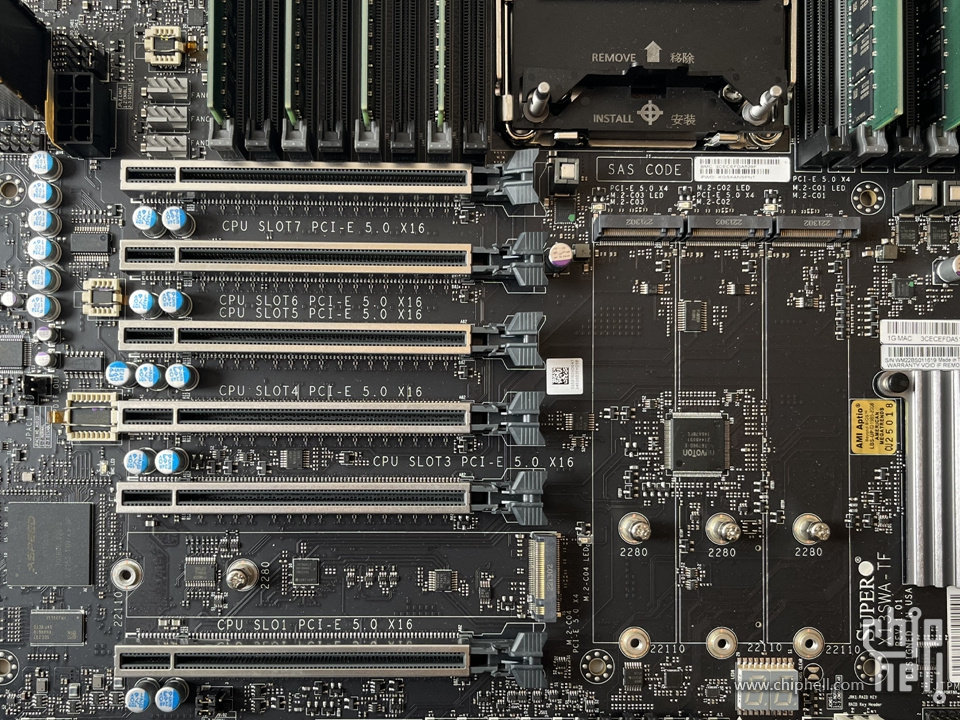

6条完整的PCIe Gen5 X16的PCIe插槽对于XEON W-3400和2400系列还是有区别的。

针对XEON W-3400:

SLOT7:PCIe Gen5 X16

SLOT6:PCIe Gen5 X16

SLOT5:PCIe Gen5 X16

SLOT4:PCIe Gen5 X16

SLOT3:PCIe Gen5 X16

SLOT1:PCIe Gen5 X16

针对XEON W-2400:

SLOT7:PCIe Gen5 X16

SLOT6:PCIe Gen5 X0

SLOT5:PCIe Gen5 X16

SLOT4:PCIe Gen5 X0

SLOT3:PCIe Gen5 X16

SLOT1:PCIe Gen5 X0

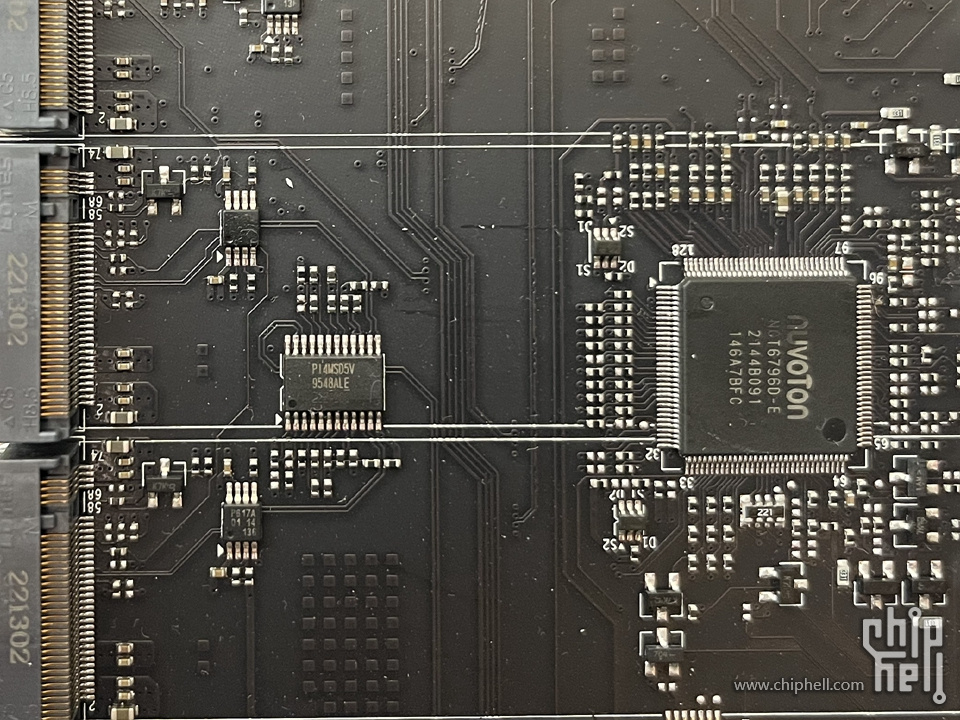

▲系统监控芯片为nuvoTon出品的NCT6796D-E,用来实现对主板设备的监控与管理。左方是PCIe切换器PI4MSD5V9548ALE。

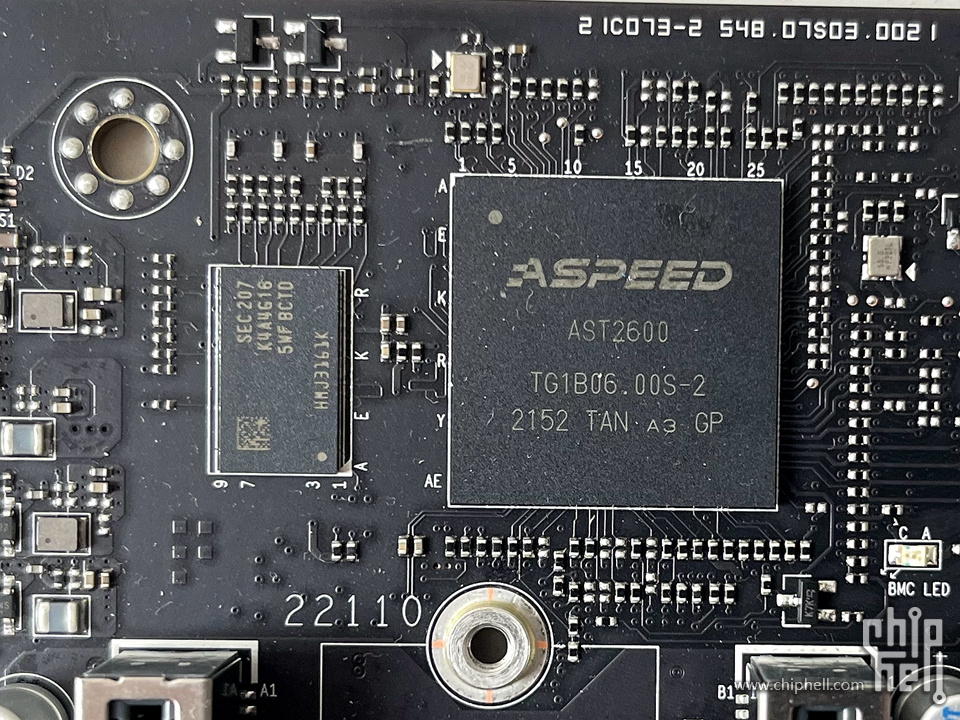

▲最新的BMC芯片 ASPEED AST2600,显存为Samsung K4A4G165WF-BCTD DDR4 RAM,容量为4Gb DDR4 RAM。走的是W790 PCH的PCIe Gen2 x1总线。

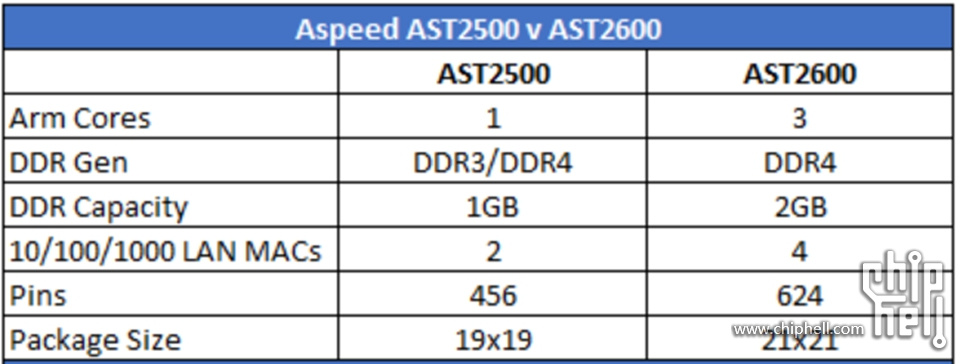

▲ASPEED公司新的AST2600芯片提供了3个ARM核心,核心数量相比上一代产品增加了2个。AST2600芯片中有两个Arm Cortex A7主核心,一个Arm Cortex M3嵌入式核心,相比AST2500的800MHz ARM11核心的性能有较大升级。

AST2600芯片可以最大对外提供4个1GbE以太网口,相比AST2500多增加了2个。这将可以使得带外管理(Out-of-Band)、低速管理控制等网口都直接从AST2600 BMC芯片上引出,不用再占据南桥(PCH)芯片的资源,从而留出更多的高速数据平面的资源。

比较可惜的是AST2600的分辨率和AST2400以及AST2500一样,依然还是1920x1200@60Hz 32bpp。

▲Mavell出品的AQC113C 10G网卡芯片。走的是W790 PCH的PCIe Gen3 x2总线。

▲Intel出品的WGI210AT 1G网卡芯片。走的是W790 PCH的PCIe Gen1 x1总线。

▲音频部分使用了Realtek出品的ALC888S,走的是W790 PCH的AZALIA总线。

1.2.2▐ 供电分析

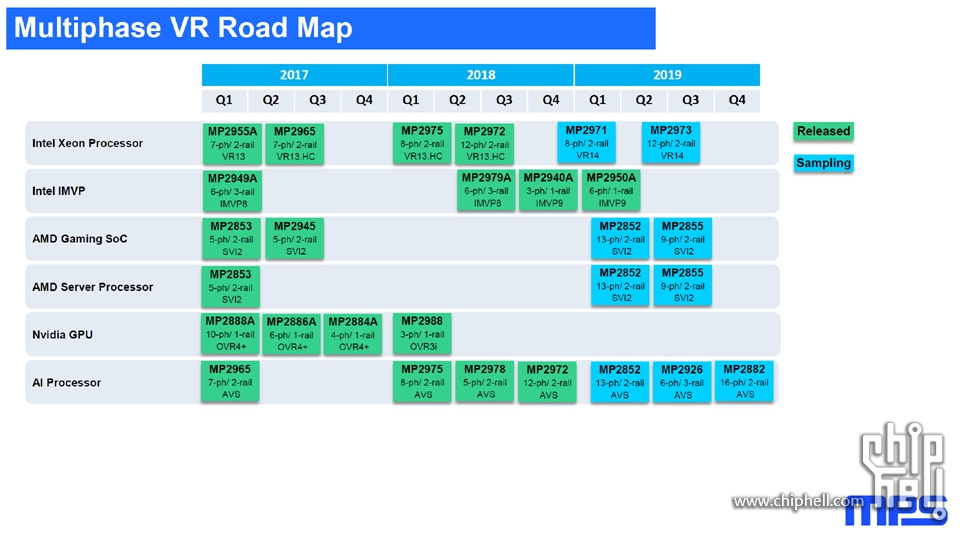

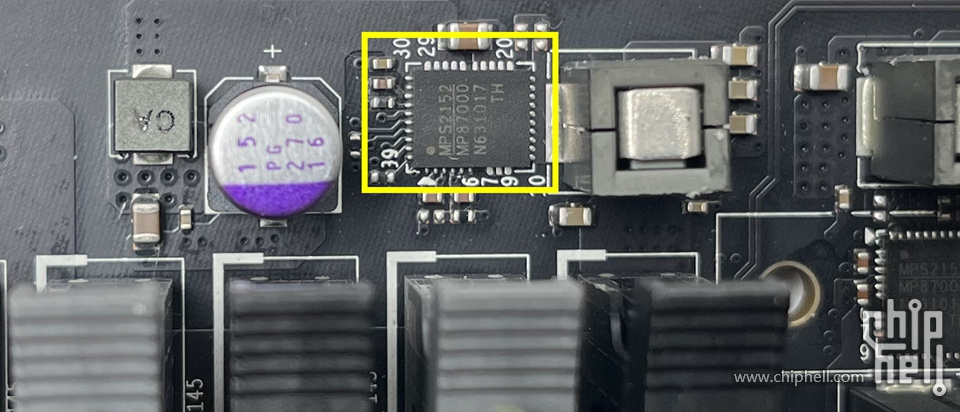

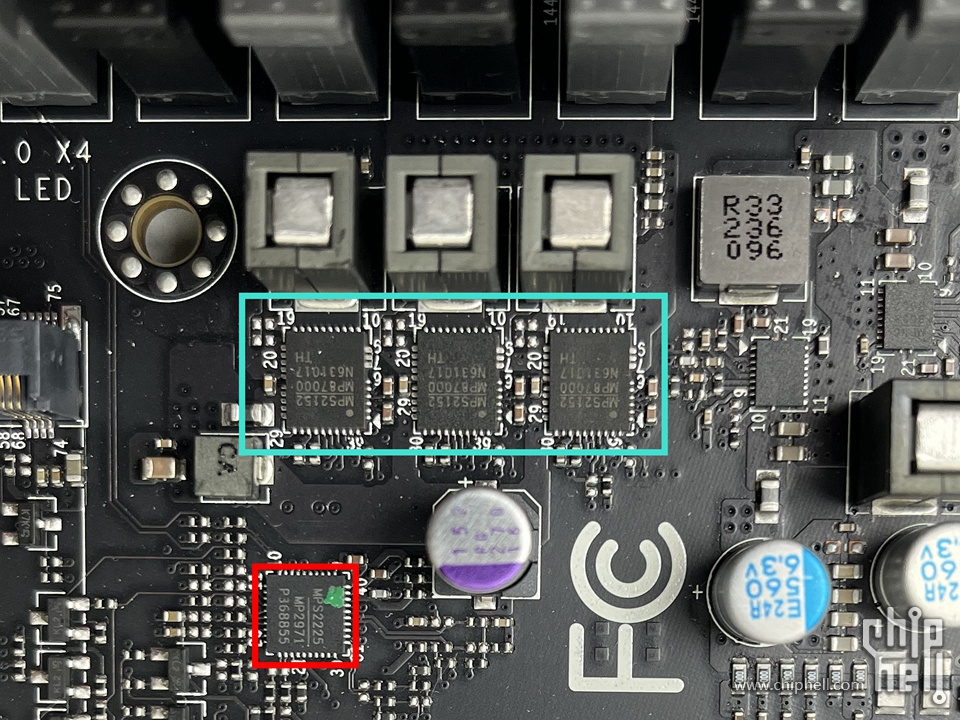

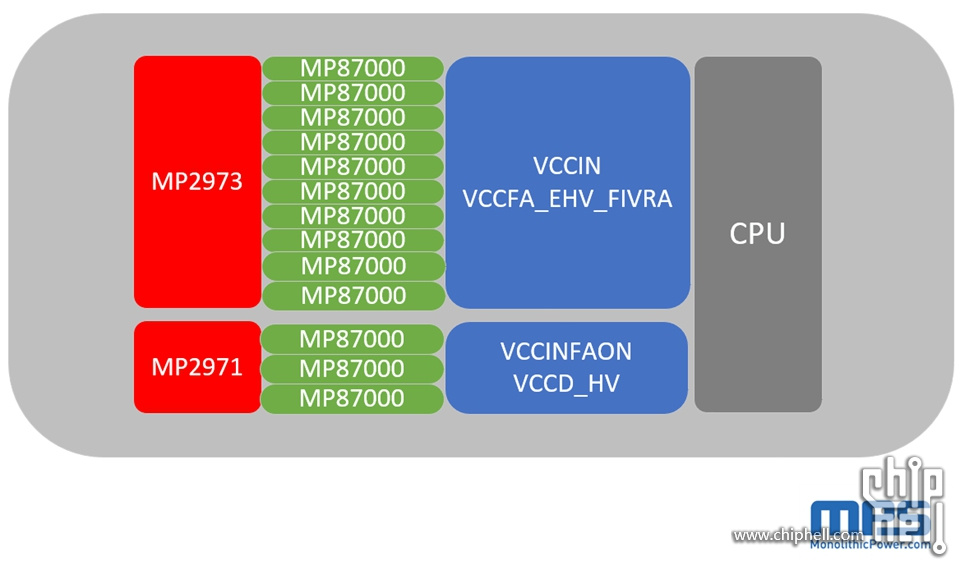

▲这片主板上的供电设计来自于MPS(Monolithic Power Systems )公司的VR14全套方案,上图中MPS公司VR14方案两颗PMW芯片MP2971和MP2971在X13SWA-TF中都出现了。

▲MP2973是一颗12相双路的PMW控制器,主管VCCIN和VCCFA_EHV_FIVRA。

MP87000是一颗80A的DrMOS,CPU上方由8颗MP87000组成VCCIN部分的供电。

▲在CPU的左上方有一颗MP87000

▲在CPU的右上方有一颗MP87000

左右这两颗MP87000负责VCCFA_EHV_FIVRA部分的供电。

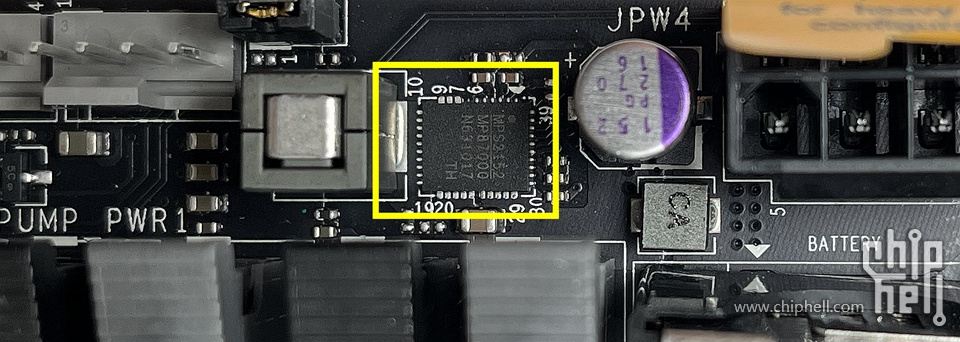

▲在CPU的右下方有一颗MP2971和3颗MP87000。

MP2971是一颗8相双路的PMW控制器,管理3颗MP87000负责VCCINFAON和VCCD_HV部分被的供电。

▲X13SWA-TF的供电构架如上。一共10+3相供电。

1.2.3 ▐ CPU适配性

▲美超微SuperMicro X13SWA-TF针对不同的CPU有不同的适配性,包括 Xeon W-3400 和 Xeon W-2400 在内的所有 Sapphire Rapids 工作站 CPU 。

▲对于最高64核112线程的Xeon W-3400系列CPU,该主板可使用6 个 PCIe 5.0 x16,支持 6 个单宽或 4 个双宽,或 2 个三宽 GPU 卡,内存支持8通道最大16根ECC RDIMM DDR5 4800MT/s(1DPC)/ 4400 MT/s(2DPC),最高容量至 RDIMM=1TB, RDIMM 3DS=4TB。

▲对于最高32核64线程的Xeon W-2400系列CPU,该主板可使用3 个 PCIe 5.0 x16,支持 3 个单宽或 3 个双宽,或 2 个三宽 GPU 卡(插槽 3/5/7)内存支持4通道最大 8 根 RDIMM DDR5 4800MT/s(1DPC)/ 4400 MT/s(2DPC),最高容量可达 RDIMM=512GB,RDIMM 3DS=2TB。

▲从官方的这张构架图来看,DIMM针对XEON W-3400是可以使用全部16条的,而针对XEON W-2400只能使用一半的DIMM。

1.3▐ ABEE SPR360

▲水冷散热器目前可选的也只有ABEE SPR360。

▲实在不认同水冷散热器弄的一陀线的现状,SPR360就很清爽,风扇线全部量好距离直接串联,安装完成后就两根线,水泵一根,风扇一根。

▲用硅脂压CPU顶盖一下,就可以看到大致的CPU顶盖表面积大小。

▲4677扣具安装散热器是需要额外的内六角工具的,这个扳手,主板以及水冷附件中都不附送,需要自行购买。

▲在CPU顶盖上扣上水冷,锁好四个U形扣具,使用扳手拧紧螺丝,CPU安装就完成了。

▲当然,当你取下水冷的时候是连着CPU一起取出的,这一点不用慌,正常情况,CPU和水冷头的剥离可以使用塑料三角片助力即可。

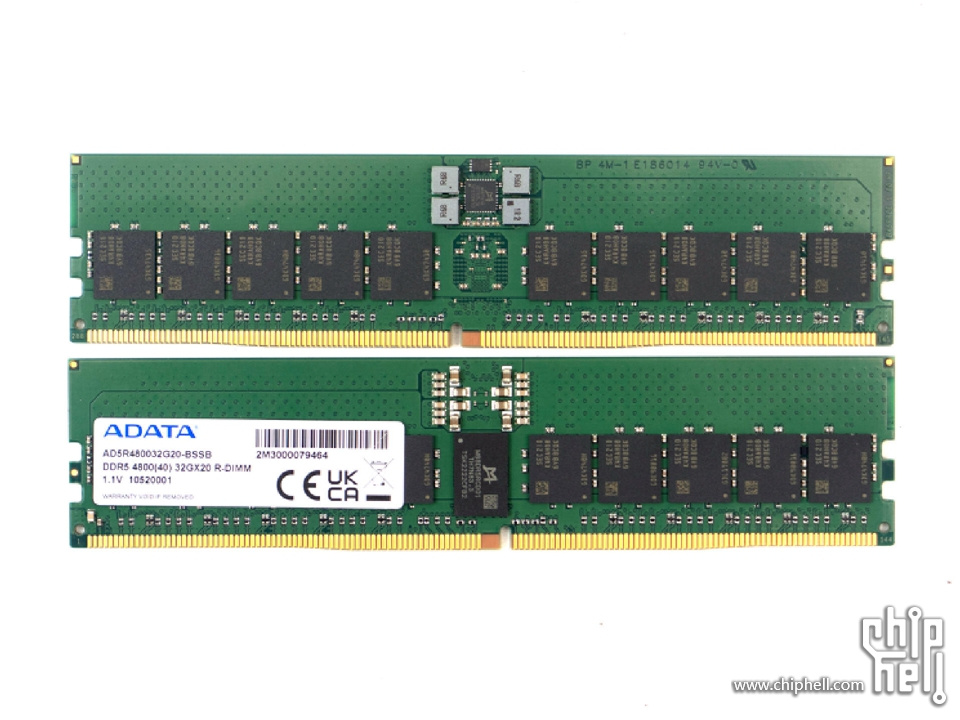

1.4▐ ADATA AD5R480032G20-BSSB x8

▲我选择的内存是来自ADATA的AD5R480032G20-BSSB,一共8根,DDR5-4800 REG ECC RDIMM,2RX8。

▲正反面照片

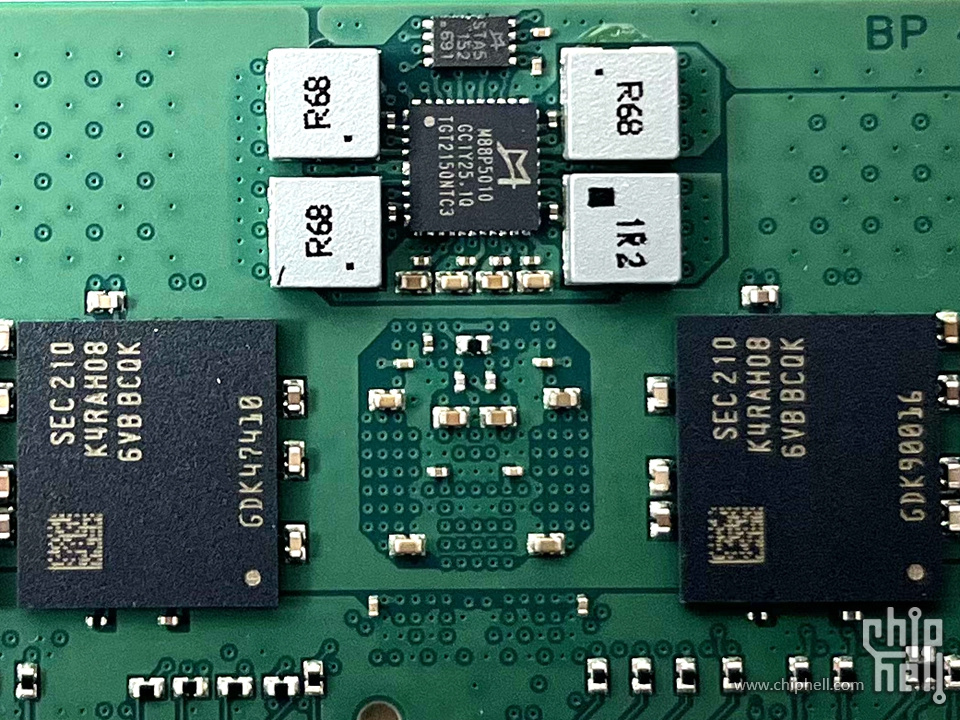

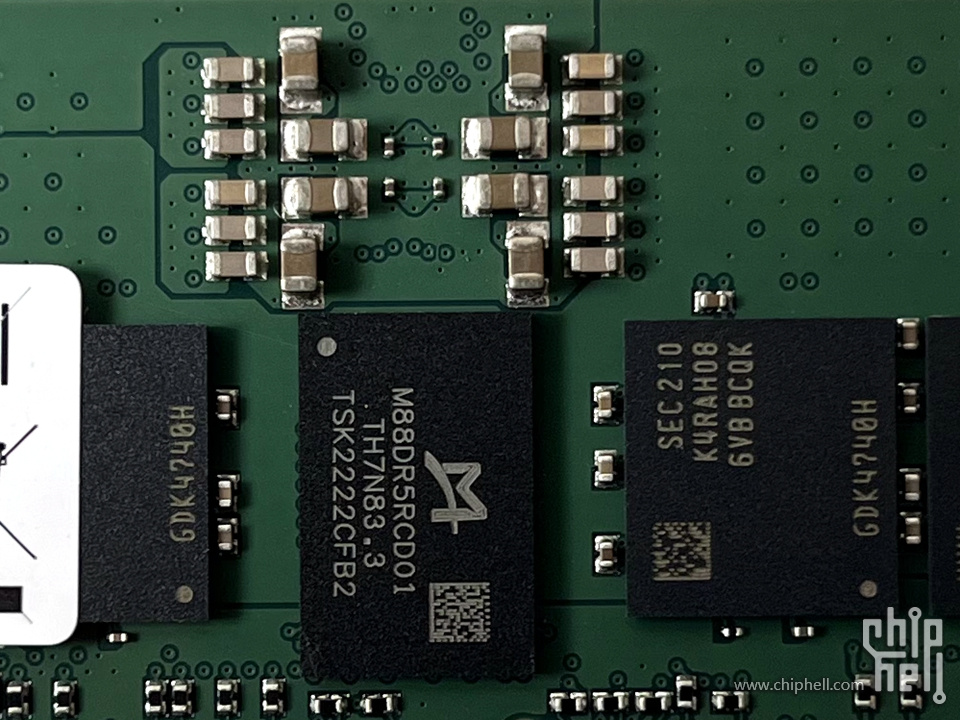

▲DRAM颗粒用的是Samsung K4RAH086VB BCQK,PMIC芯片使用的是澜起科技的Montage M88P5010

▲REG芯片使用澜起科技的第二代Montage M88DR5RCD01

关于目前ADATA已经上市的DDR5 RDIMM型号为:

DDR5-4800 R-DIMM

16GB:AD5R480016G10-BSSB

32GB:AD5R480032G20-BSSB

*Samsung C-Die

DDR5-5600 R-DIMM

16GB:AD5R560016G10-BHYA

32GB:AD5R560032G20-BHYA

*Hynix A-die

▲对于XEON W-3400而言,其实所有的DIMM都是可用的,无论黑色还是灰色DIMM,但是8根插入灰色的DIMM会是最优选择。对于XEON W-2400而言,8根内存只有插入另外的黑色DIMM才有效,因为灰色的DIMM是XEON W-3400独有专用。

目前可供使用英特尔第4代XEON W系列的消费者使用的 DDR5 内存模块有四种不同的组合。这包括单列 (1Rx8) 和双列 (2Rx8) DIMM,它们通常以两个或四个为一组,分别构成每通道 1 个 DIMM (1DPC) 或每通道 2 个 DIMM (2DPC)。

那么这里可以回答两个问题:

使用 DDR5 内存的 1Rx8 和 2Rx8 在性能上有区别吗?

用ADATA的DDR5 RDIMM举例,16GB:AD5R480016G10-BSSB是1RX8,32GB:AD5R480032G20-BSSB是2RX8,性能上几乎没有区别。

使用 1DPC 与 2DPC(2x32GB 与 4x16GB)时性能有差异吗?

用ADATA的DDR5 RDIMM举例:

32GB:AD5R480032G20-BSSB,插入8根是1DPC,速度会维持在DDR5-4800。

16GB:AD5R480016G10-BSSB ,插入8根是1DPC,速度会降低在DDR5-4800。

32GB:AD5R480032G20-BSSB,16根插满是2DPC,速度会降低在DDR5-4400。

16GB:AD5R480016G10-BSSB ,16根插满是2DPC,速度会降低在DDR5-4400。

这并不是主板BIOS的设定问题,而是XEON W-3400的IMC问题。

所以针对XEON W-3400而言,尽可能要选择1DPC的内存配置让DDR5速度维持在4800。

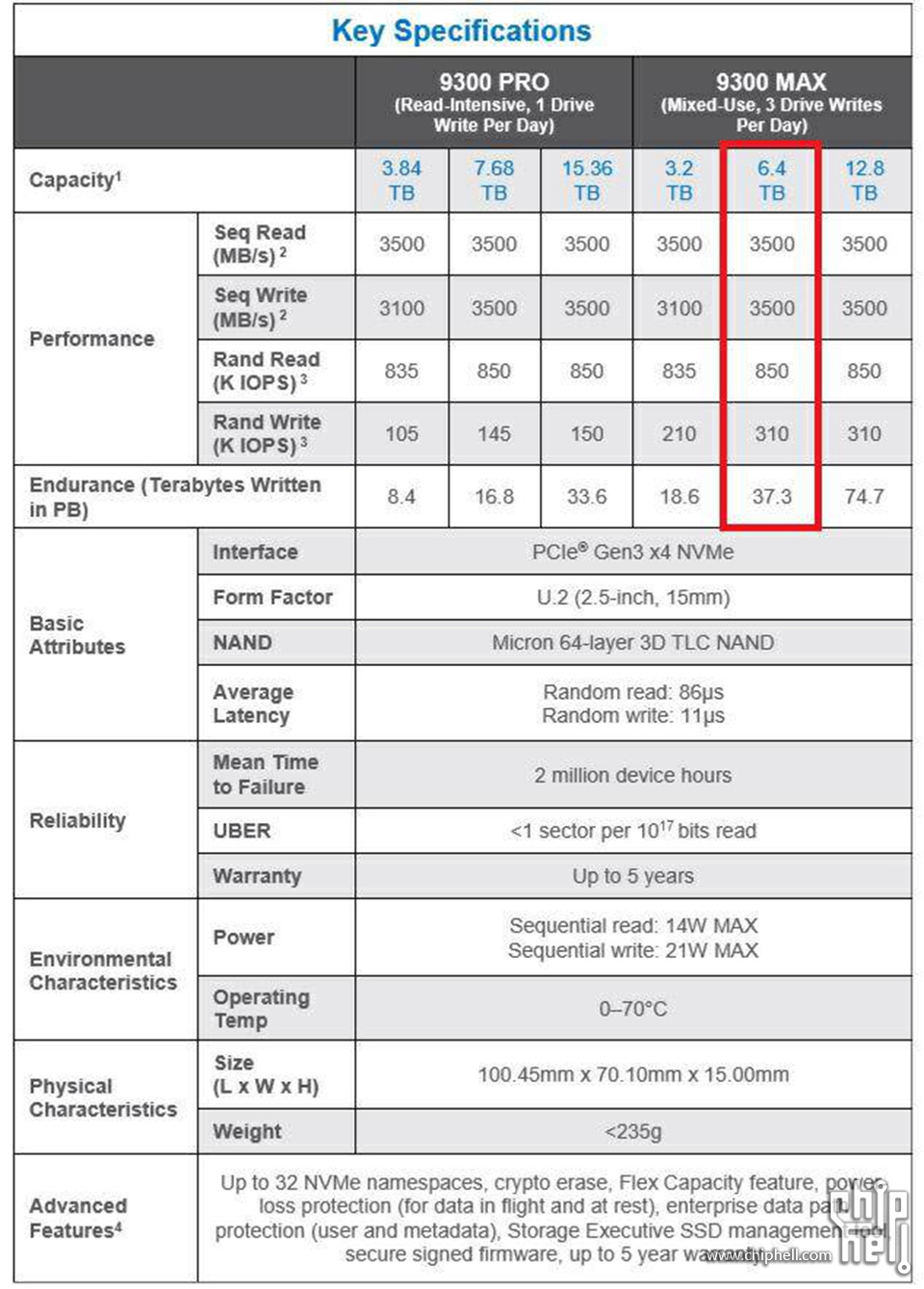

1.5▐ Micon 9300MAX 6.4TB U.2

▲板载的四条M2均支持2280和22110规格的PCIe Gen5 X4SSD,我不太建议上PCIe Gen5 SSD,因为M.2全部在GPU的下面,所以一定非常热,建议还是选择PCIe Gen4 X4的22110规格的企业级SSD比较可靠,如果找不到22110的企业级SSD,那么2280的消费级也可以。

▲板载的两个U.2来自于W790的PCH芯片组,都是PCIe Gen3 X4规格的,其实现在这种规格的大容量企业级SSD价格也很亲民了,是个便宜大碗的选择。我选择的是Micron 9300MAX 6.4TB U.2。

▲作为Micron光目前的高端旗舰级NVMe企业级产品,9300MAX无疑是与INTEL P4610对敲的重头戏产品,但是镁光不太在大陆推广,导致9300MAX系列的产品信息非常少。6.4TB容量37.3TBW的写入量是其与INTEL P4610对抗的重要指标。

▲盘体全新未拆封

▲正面

▲背面

▲左侧

▲右侧

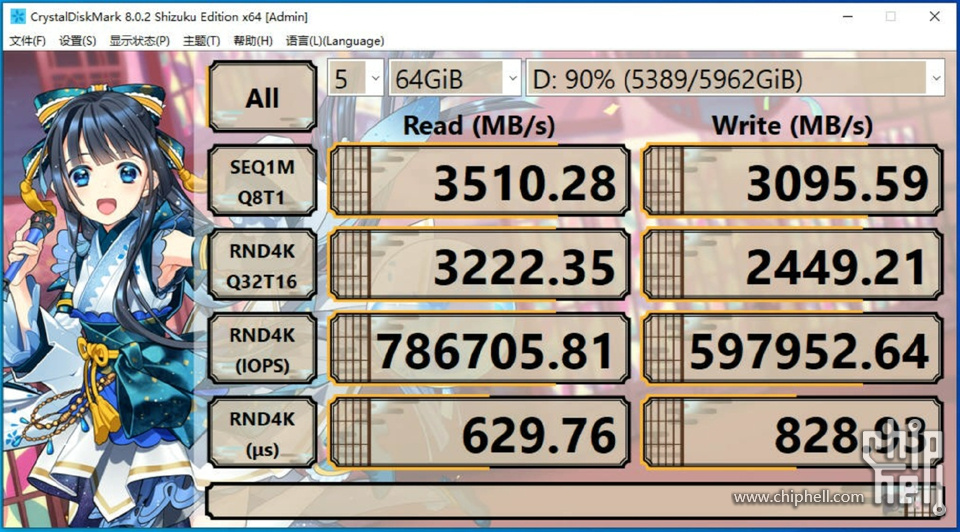

▲用Micron 9300MAX 6.4TB NVMe SSD进行90%满盘情况下的64GB Block Size的CrystalDiskMark 8.0.2的峰值测试。

90%满盘64GB数据块大小,属于比较恶劣的情况,持续读取 3510.25MB/s,持续读写3095.59MB/s,4K随机读取786705.81 IOPS,4K随机写入597952.64 IOPS。

1.6▐ NVIDIA Geforce RTX4090 24GB Found Edition

▲测试显卡选择了一张NVIDIA Geforce RTX 4090 24GB FE公版

▲开箱所见即所得,此卡无需多言。

1.7▐ Cooler Master MWE GOLD V2 1250

本次测试使用了一颗来自Cooler Master的ATX3.0规格的1250W电源,MWE GOLD V2 1250。

▲外盒

▲全家福:原生12VHPWR PCIe供电线是蛇皮包网,其余全部扁平化线材,

▲电源本体:180mmx150mmx86mm规格;风扇:14025规格

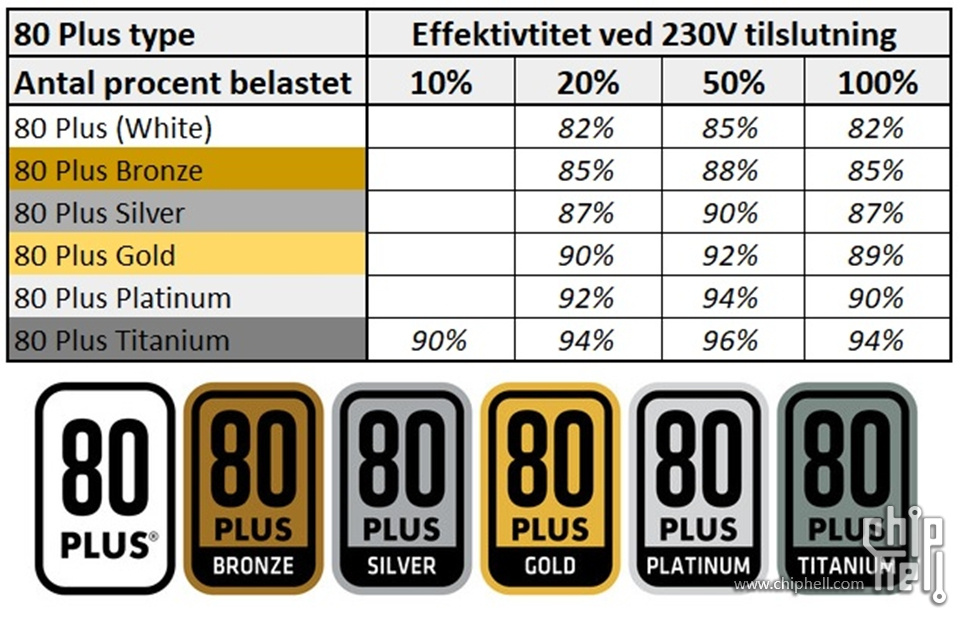

▲虽然是80PLUS GOLD认证,但也需要知道80PLUS GOLD在100%功率输出的时候负载达标转换效率是89%,这款电源100%负载转换效率在GEARKASSEN.NU实测是89.09%,那么要产出1250W的功率,需要给电源输入1250W/0.8909=1403W。这颗电源的风扇在400W负载以内是不转的,过了400W负载才转,您可以理解为电脑待机时电源风扇不转就好了。

▲其实我觉得这个89.09%是合理的,假如调校一下稍微转换效率高一点,20%负载转换效率高2个点,50%高两个点,100%高一个点到90%,就可以做80PLUS PLATINIM出售了,毕竟在商言商,所以花过多的钱去追求80PLUS PLATINIM还不如直接GOLD,要追求就去追求80PLUS TITANIUM。这就当做给大家购买电源的扫盲小知识科普一下。

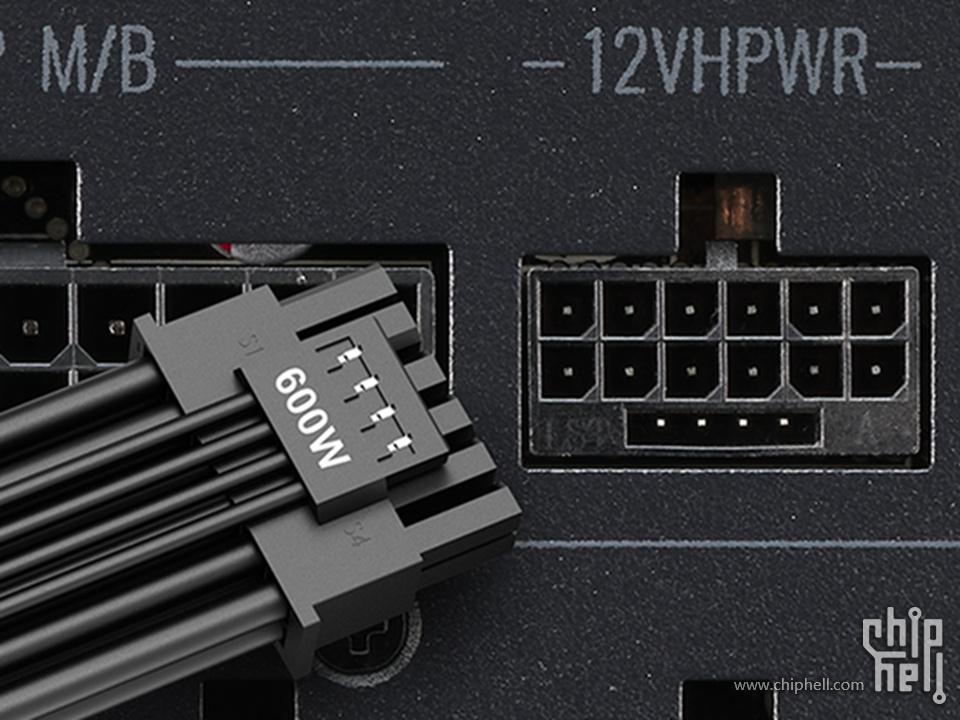

▲电源接口部分含有一个原生12VHPWR接口直出接驳RTX 4000系列显示卡。

▲12VHPWR直插电源,ATX3.0规格

▲12VHPWR直插我的RTX 4090时是90度上弯的,走线非常方便,也保持机箱正面的美观。可惜12VHPWR只有一根,对于一颗1250W 80PLUS GOLD的电源来说,有点少。

▲好在MWE GOLD V2 1250有3个PCIe 8P,CoolMaster现在也准备单独出12VHPWR的线材供用户扩容,马云家也有第三方制造的双PCIe 8P转12VHPWR的黑色扁平线材,这样就可以多提供一组12VHPWR。

1.8▐ Cooler Master HAF700

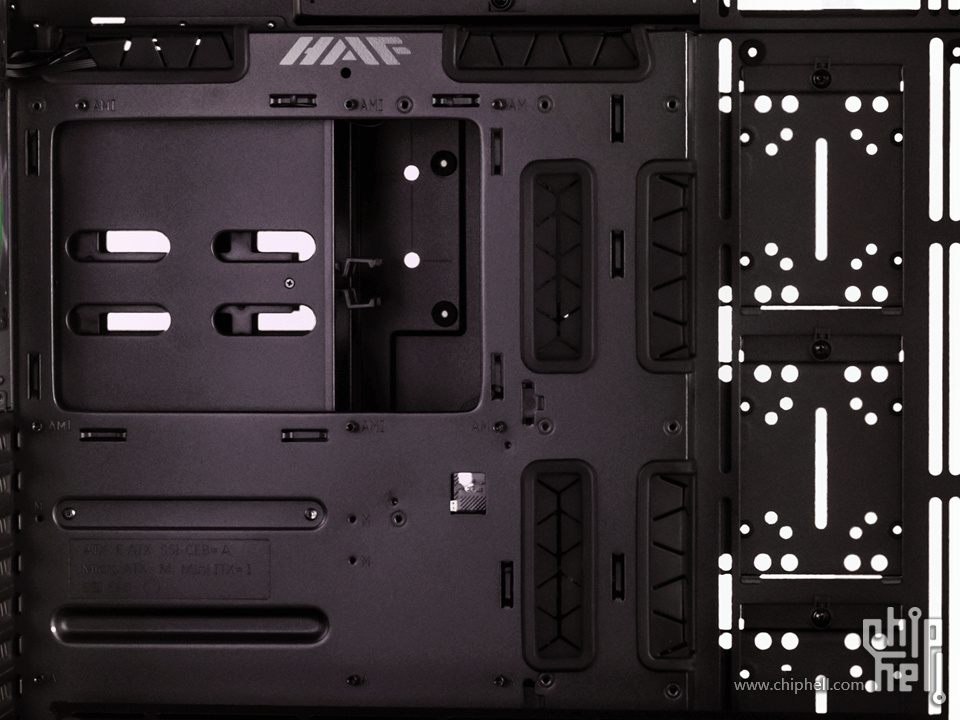

因为X13SWA-TF的规格是12X13寸的超宽EATX,所以适配机箱选择了Cooler Master HAF700

▲包装正面

▲包装背面

▲左前45度视角

▲右后45度视角,可以看到8槽PCIe位,这意味着可以安装四张双槽涡轮版或者水冷版显卡。

▲首先HAF700可以装得下全尺寸的EATX主板,比如ASUS Pro WS W790-SAGE SE & Supermicro X13SWA-TF,且EATX所有的螺丝位都有对应的孔位,这很重要!很多机箱空间上是可以容纳EATX,但是螺丝位总会空几个,甚至有对不上孔位的情况。再者HAF700为EATX预设的出线孔非常合适,刚好在主板托盘的90度弯折处。

▲下部的风扇架空间充足,足够给最下面7-8槽的显卡进风散热

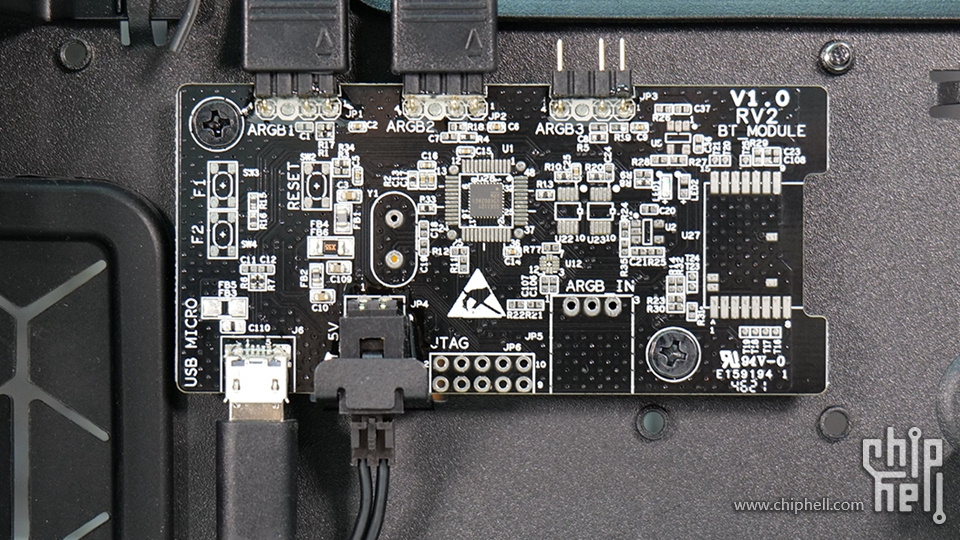

▲机箱的背面理线槽内部有两块电路板,下部的一块是ARGB Gen2控制器

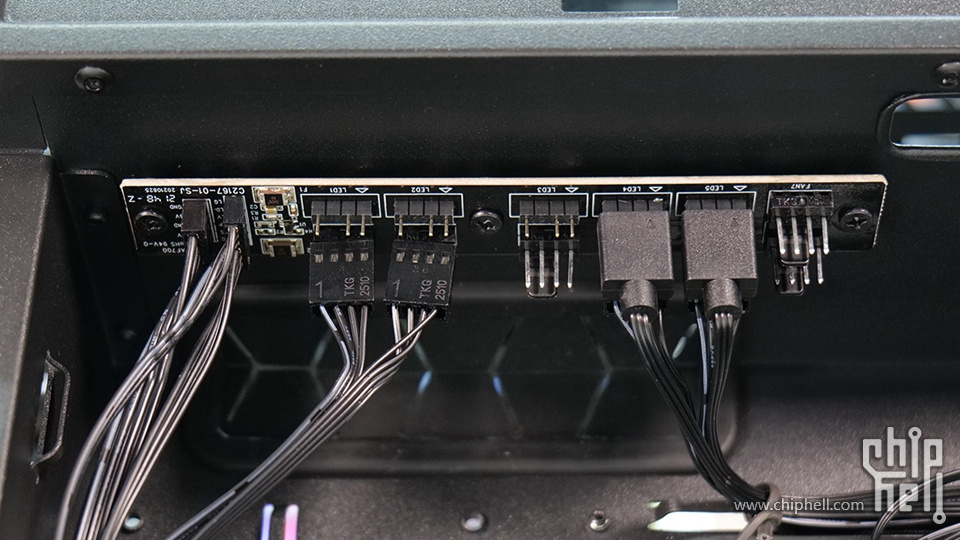

▲顶部的一块是7pmw+5ARGB gen2 集线器

1.9▐ 装机成品

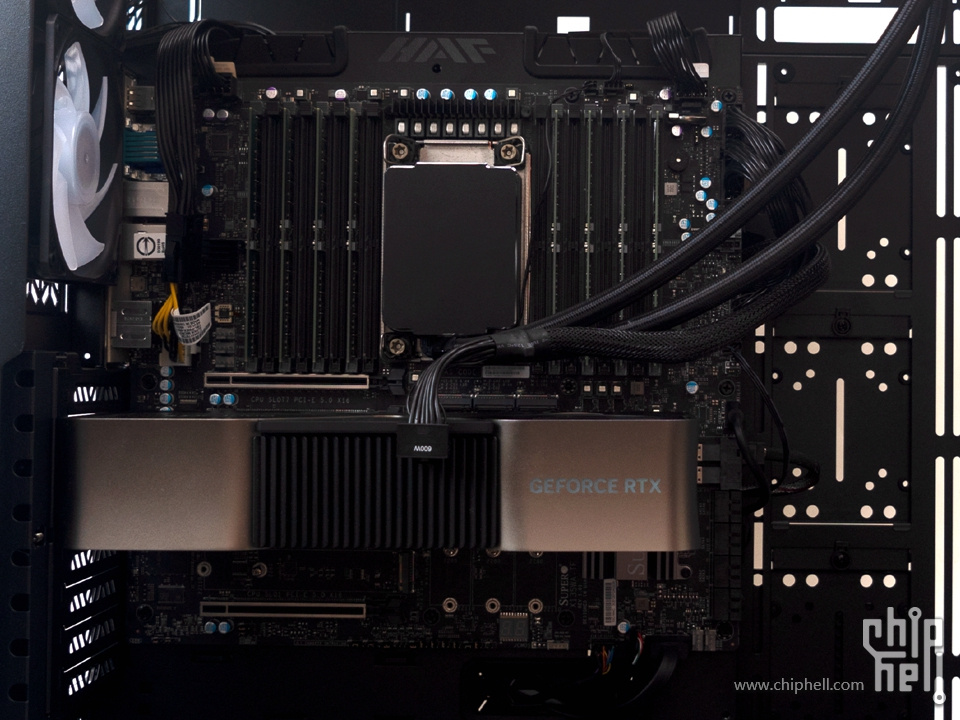

以上这些产品组成了本次的测试平台:

【CPU】: Intel Xeon w9-3495X

【主板】: SuperMicro X13SWA-TF(Bios Rev:1.1a)

【内存】: ADATA AD5R480032G20-BSSB 32GB DDR5-4800 ECC RDIMM X8

【硬盘】: Micron 9300MAX 6.4TB U.2 Gen 3X4 SSD

【显卡】: NVIDIA Geforce RTX 4090 24GB Founder Edition

【散热】: ABEE SPR360

【机箱】: Cooler Master HAF700

【电源】: Cooler Master MWE GOLD V2 1250

2▐ Ubuntu 22.10 x64 测试

▲Phoronix test suite测试套件是目前LINUX下可用的最全面的测试和基准测试平台,它提供了可扩展的框架,可以轻松地添加新的测试。该软件旨在以干净,可复制且易于使用的方式有效地执行定性和定量基准。Phoronix test suite测试套件可用于比较计算机的性能,硬件验证以及持续集成/性能管理。所以以下测试集成在Phoronix test suite框架下进行。。

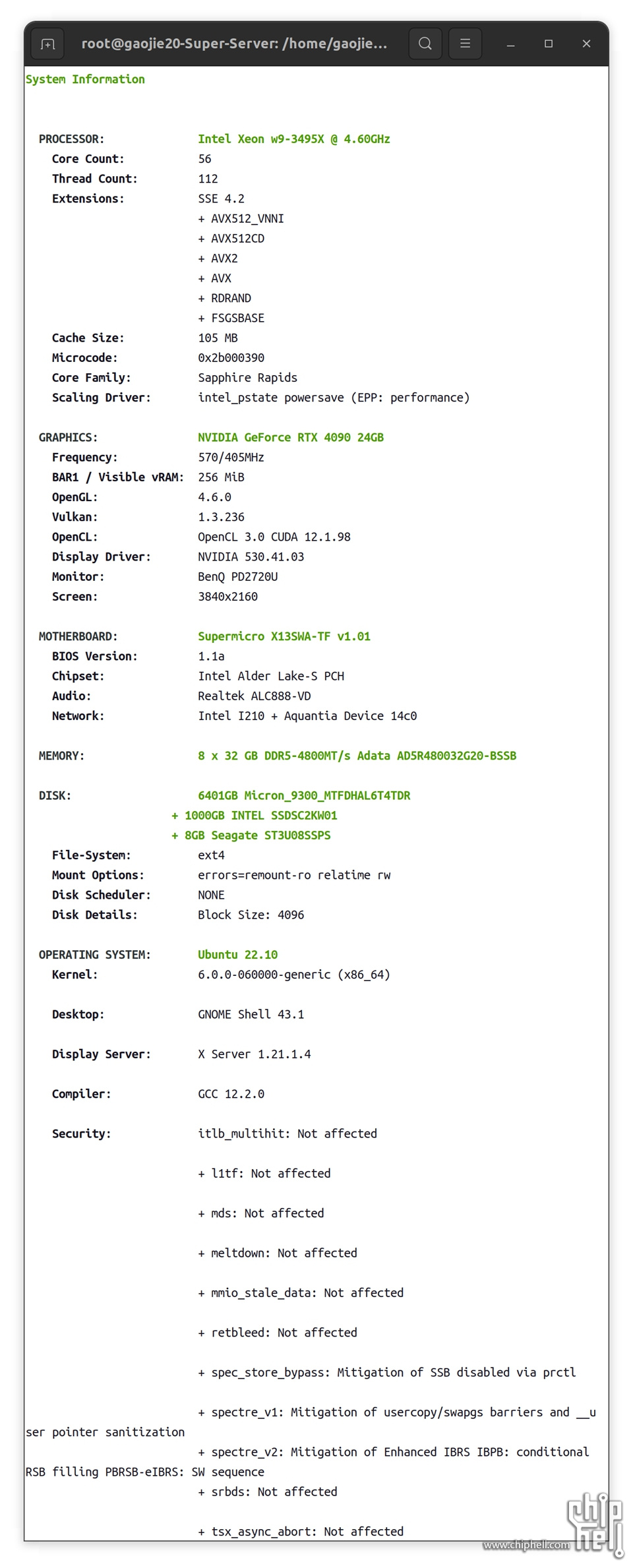

▲phoronix-test-suite硬件与环境配置一览表

一个小细节,上图中Scaling Driver显示的Intel_pstate powersave也就是电源模式请务必调节为Performance模式,否则性能会跌10-20%。

因为有Michael Larabel的测试数据以及phoronix-test-suite良好的同步测量能力,所以我才有了远程对比的测试对象:

AMD DAYTONA_X(RYM1009B BIOS)

8 x DDR4-3200 ECC RDIMM 32GB

AMD EPYC 7713 64-Core @ 2.00GHz (64 Cores / 128 Threads),

AMD EPYC 7763 64-Core @ 2.45GHz (64 Cores / 128 Threads),

AMD EPYC 7773X 64-Core @ 2.20GHz (64 Cores / 128 Threads),

AMD DAYTONA_X(RYM1009B BIOS)

16 x DDR4-3200 ECC RDIMM 32GB

2 x AMD EPYC 7713 64-Core @ 2.00GHz (128 Cores / 256 Threads),

2 x AMD EPYC 7763 64-Core @ 2.45GHz (64 Cores / 128 Threads),

2 x AMD EPYC 7773X 64-Core @ 2.20GHz (64 Cores / 128 Threads),

AMD Titanite_4G (RTI1002E BIOS),

12 x DDR5-4800 ECC RDIMM 64GB

AMD EPYC 9374F 32-Core @ 4.31GHz (32 Cores / 64 Threads),

AMD EPYC 9554 64-Core @ 3.76GHz (64 Cores / 128 Threads),

AMD EPYC 9654 96-Core @ 3.71GHz (96 Cores / 192 Threads),

AMD Titanite_4G (RTI1002E BIOS),

24 x DDR5-4800 ECC RDIMM 64GB

2 x AMD EPYC 9374F 32-Core @ 4.31GHz (32 Cores / 64 Threads),

2 x AMD EPYC 9554 64-Core @ 3.76GHz (64 Cores / 128 Threads),

2 x AMD EPYC 9654 96-Core @ 3.71GHz (96 Cores / 192 Threads),

Intel M50CYP2SB2U(SE5C6200.86B.0022.D08.2103221623 BIOS),

8 x DDR4-3200 ECC RDIMM 32GB

Intel Xeon Platinum 8362 @ 3.60GHz (32 Cores / 64 Threads),

Intel Xeon Platinum 8380 @ 3.40GHz (40 Cores / 80 Threads),

Intel M50CYP2SB2U(SE5C6200.86B.0022.D08.2103221623 BIOS),

16 x DDR4-3200 ECC RDIMM 32GB

2 x Intel Xeon Platinum 8362 @ 3.60GHz (64 Cores / 128 Threads),

2 x Intel Xeon Platinum 8380 @ 3.40GHz (80 Cores / 160 Threads),

Quanta Cloud S6Q-MB-MPS (3A10.uh BIOS),

8 x DDR5-4800 ECC RDIMM 64GB

Intel Xeon Platinum 8490H @ 3.50GHz (60 Cores / 120 Threads),

Quanta Cloud S6Q-MB-MPS (3A10.uh BIOS),

16 x DDR5-4800 ECC RDIMM 64GB

2 x Intel Xeon Platinum 8490H @ 3.50GHz (120 Cores / 240 Threads),

SuperMicro X13SWA-TF(v1.1a BIOS),

8 x DDR5-4800 ECC RDIMM 32GB

Intel Xeon w9-3945X@ 4.80GHz (56 Cores / 112 Threads),

OS: Ubuntu 22.10,

Kernel: 6.0.0-060000rc3daily20220904-generic (x86_64),

Desktop: GNOME Shell,

Display Server: X Server 1.21.1.3,

Vulkan: 1.3.211,

Compiler: GCC 12.2.0,

File-System: ext4,

Screen Resolution: 1920x1080

这里我其实对3颗CPU的性能对比非常有兴趣:

Intel Xeon w9-3945X @ 4.80GHz (56 Cores / 112 Threads),

Intel Xeon Platinum 8490H @ 3.50GHz (60 Cores / 120 Threads),

AMD EPYC 9554 64-Core @ 3.76GHz (64 Cores / 128 Threads),

在下面的测试中我会着重关注这三颗的单路性能。

2.1▐ 深度学习

2.1.1▐ OneDNN

这是对英特尔 oneDNN 作为深度神经网络的英特尔优化库的测试,并利用其内置的 benchdnn 功能。结果是报告的总执行时间。在更名为英特尔 oneAPI 工具包的一部分之前,英特尔 oneDNN 以前称为 DNNL(深度神经网络库)和 MKL-DNN。

oneDNN 是一个开源的跨平台高性能库,包含用于深度学习应用程序的基本构建模块。基于英特尔平台,oneDNN 对深度神经网络进行 op 级以及指令集级的优化。

支持关键数据类型:float32、float16、bfloat16 和 int8实现了丰富的操作:convolution, matrix multiplication, pooling, batch normalization, activation functions, recurrent neural network (RNN) cells, and long short-term memory (LSTM) cells支持自动检测硬件指令,提高神经网络在指定硬件,特别是英特尔 CPU 和 GPU 上的执行速度。

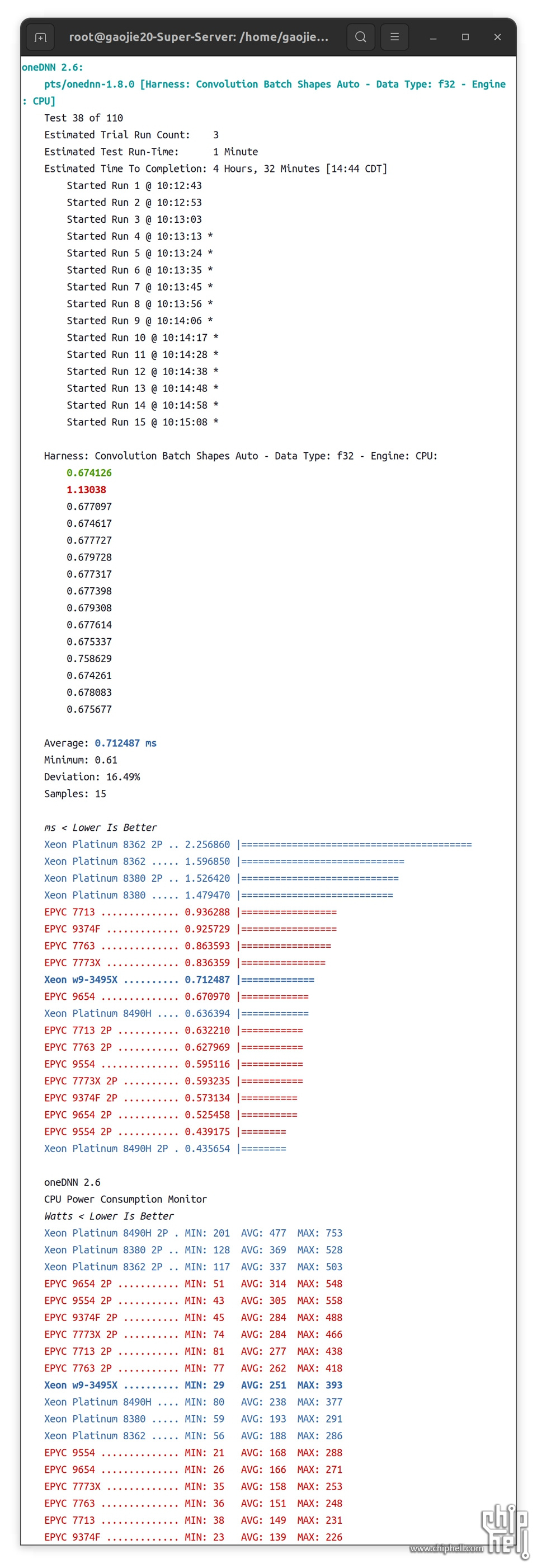

2.1.1.1 ▐ 数据类型:f32

▲F32中,单路之王依然是EPYC 9554,双路之王依然是Xeon Platinum 8490H 2P,双路AMD依然优化不佳。

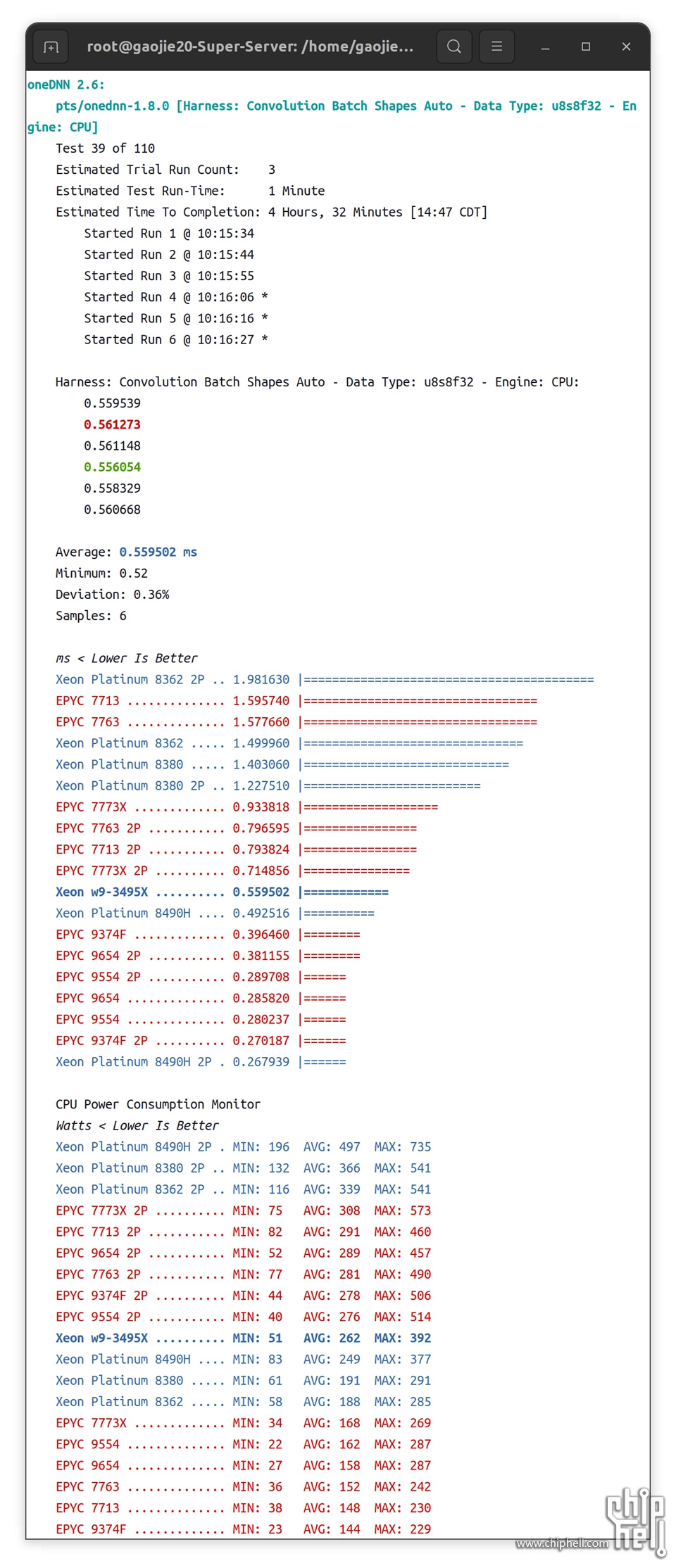

2.1.1.2 ▐ 数据类型:u8s8f32,Optimized For AVX-512

▲对于像 Intel oneDNN 这样可以大量利用 AVX-512 的工作负载,Xeon w9-3495X仅次于Xeon Platinum 8490H,单路而言EYPC 9554无疑是性能最佳,但是双路AMD优化不佳相对单路几乎没有提升,所以双路之王依然是Xeon Platinum 8490H 2P。

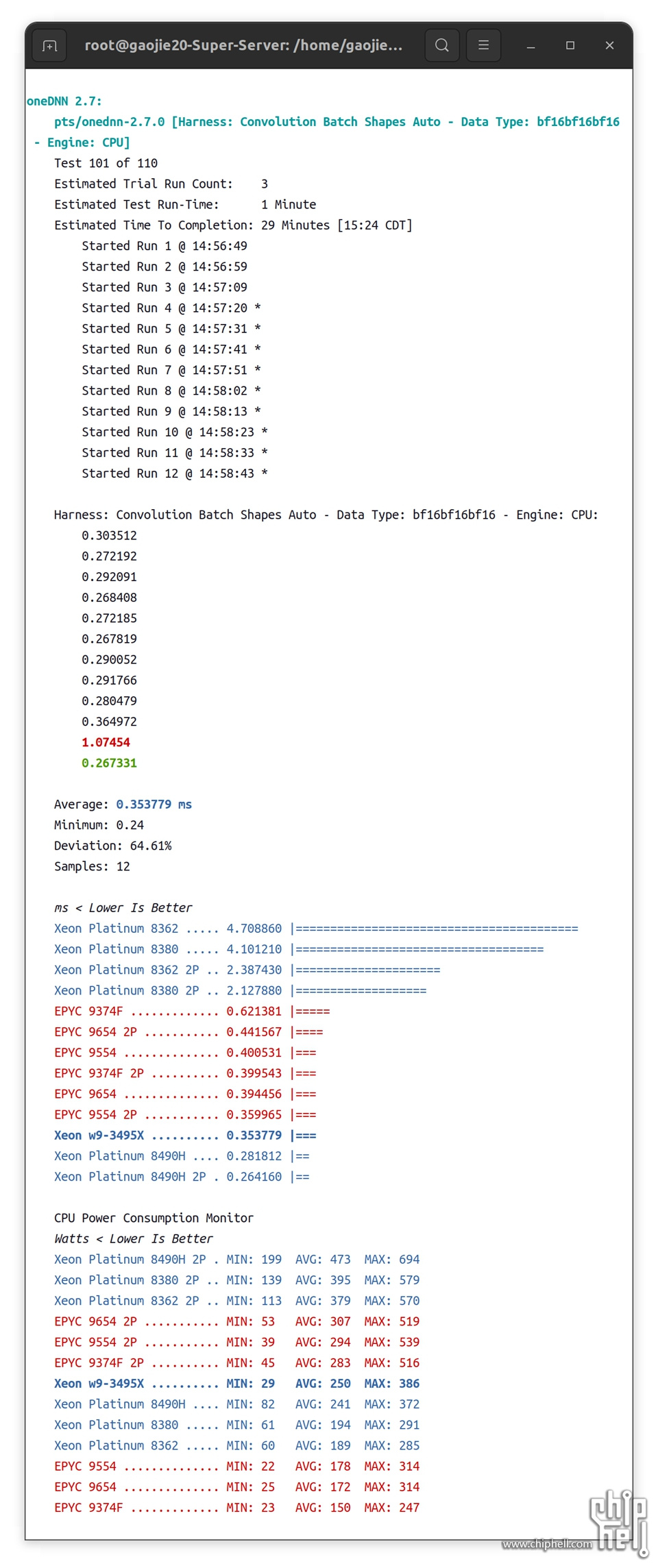

2.1.1.3 ▐ 数据类型:bf16bf16bf16,Optimized For AVX-512 + VNNI

▲当用上AVX-512 BF16之后,前三甲的位置分别是Xeon Platinum 8490H 2P、Xeon Platinum 8490H和Xeon w9-3495X,AMD全线被性能压制。

单路1P下:

当数据类型为F32时候,Xeon w9-3495X#0.712ms、EPYC 9554#0.595ms

当数据类型为u8f8f32时候,Xeon w9-3495X#0.559ms、EPYC 9554#0.280ms

当数据类型为bf16bf16bf16时候,Xeon w9-3495X#0.353ms、EPYC 9554#0.400ms

通过AVX-512 + VNNI的调整优化,Xeon w9-3495X的提升超过100%,而EPYC 9554明显在传统AVX512调整优化下收益更好,提升超过100%。

双路2P下:

当数据类型为u8f8f32时候,EPYC 9554 2P比单路就没有任何提升,而Xeon Platinum 8490H 2P提升接近100%。

当数据类型为bf16bf16bf16时候,EPYC 9554 2P比单路提升约12.5%,而Xeon Platinum 8490H 2P提升接近8%。

就这个测试而言,单路的Xeon w9-3495X以及EPYC 9554才是性价比较高的选择。

2.1.2▐ OpenVINO 2022.2 de

▲这是对英特尔 OpenVINO 的测试,这是一个围绕神经网络的工具包,使用其内置的基准测试支持并分析各种模型的吞吐量和延迟。

项目溯源:https://github.com/openvinotoolkit/openvino

2.1.2.1 ▐ Model:face-detection-0206

基于 ResNet152 作为backbone的人脸识别

模型溯源:https://github.com/openvinotoolk ... face-detection-0206

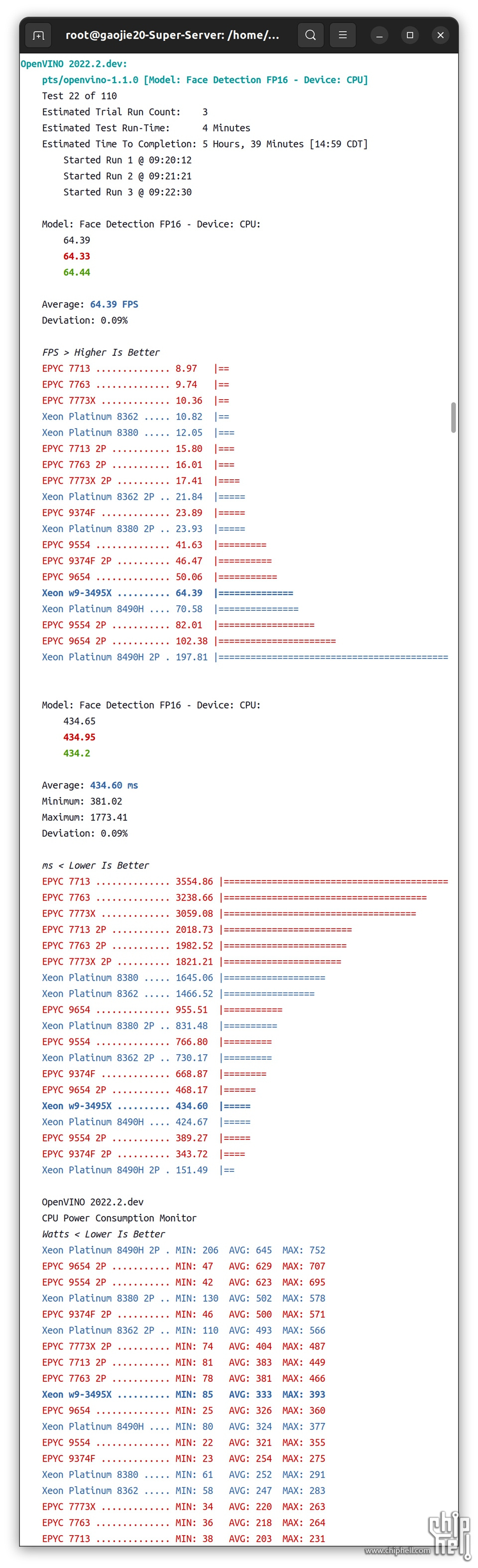

▐ FP16

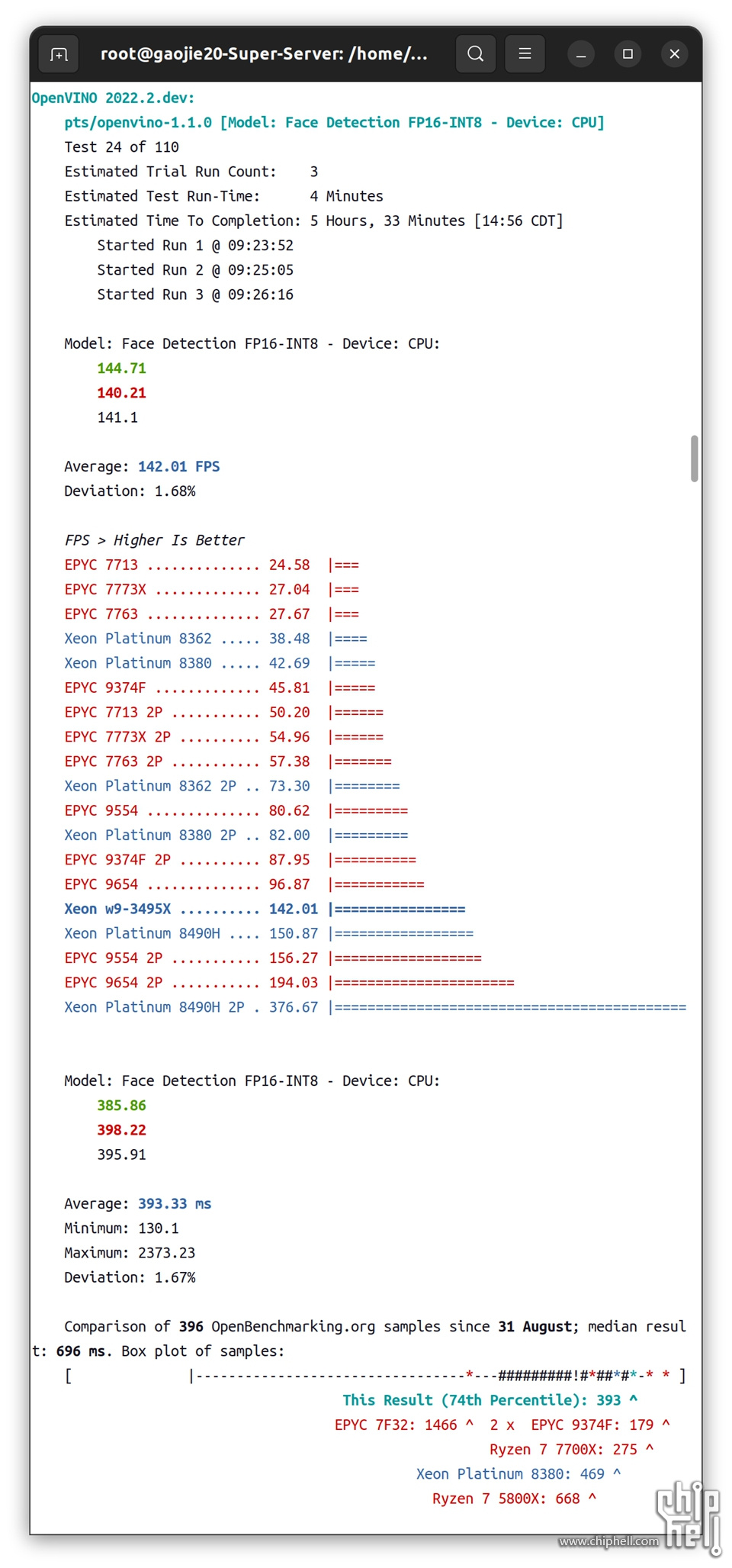

▐ FP16-INT8

▲这个测试无论是FP16还是FP16-INT8,双路最佳是Xeon Platinum 8490H 2P,单路之王是Xeon Platinum 8490H,而Xeon w9-3495X紧随其后。

单路1P:FP16

Xeon w9-3495X#64.39FPS

Xeon Platinum 8490H#0.58FPS

EPYC 9554#41.63FPS

单路1P:FP16-INT8:

Xeon w9-3495X#142.01FPS

Xeon Platinum 8490H #150.87FPS

EPYC 9554#80.62FPS

把模型的数据精度从FP16调整到FP16-INT8混合精度,以上三颗CPU的性能都出现了翻倍提升。不知为何,EPYC 9554在ResNet152 backbone下的FP16精度性能只有Xeon w9-3495X的60-70%。

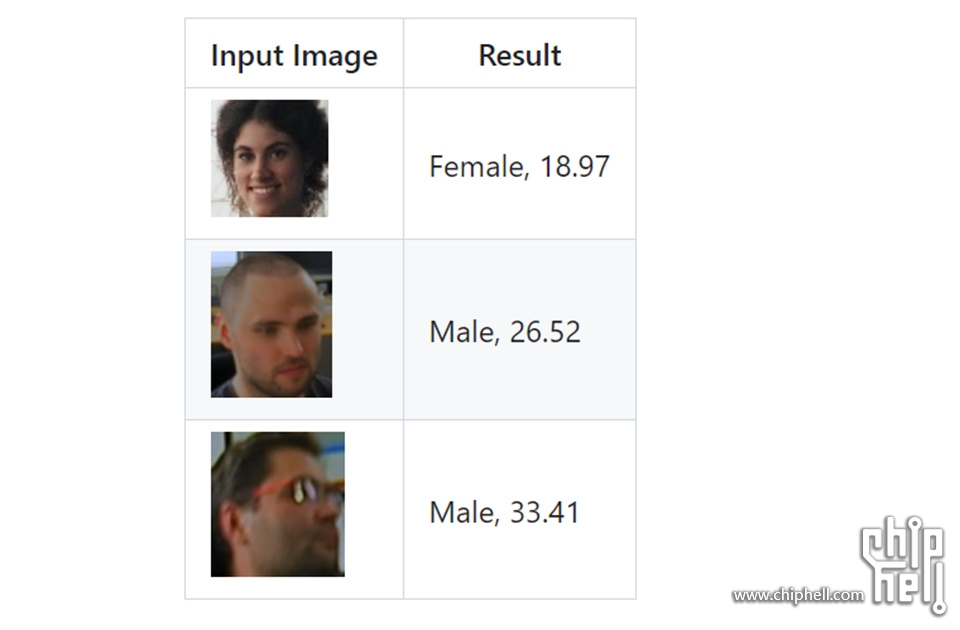

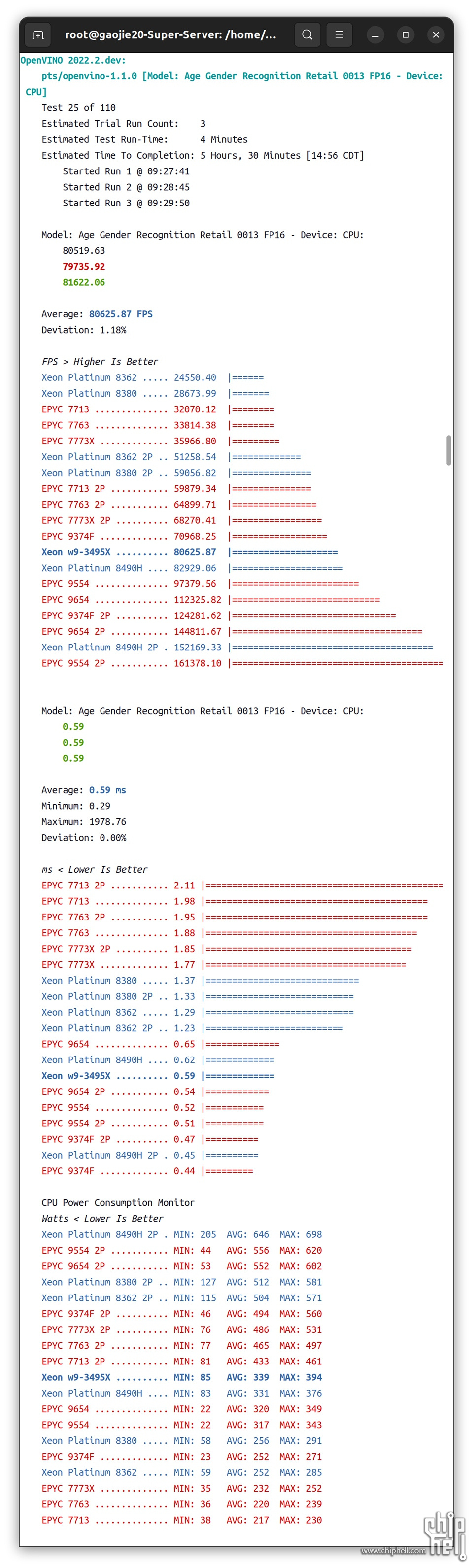

2.1.2.2 ▐ Model:age-gender-recognition-retail-0013

用于同步年龄/性别识别的全卷积网络。该网络能够识别 [18, 75] 岁范围内的人的年龄/性别。

模型溯源:https://github.com/openvinotoolk ... gnition-retail-0013

▐ FP16

▲单路1P:FP16

Xeon w9-3495X#80625.87FPS

Xeon Platinum 8490H#82929.06FPS

EPYC 9554#97379.56FPS

双路2P:FP16

Xeon Platinum 8490H 2P#152169.33FPS

EPYC 9554#161378.10FPS

这个目标检测测试无疑EPYC 9554更加优秀。

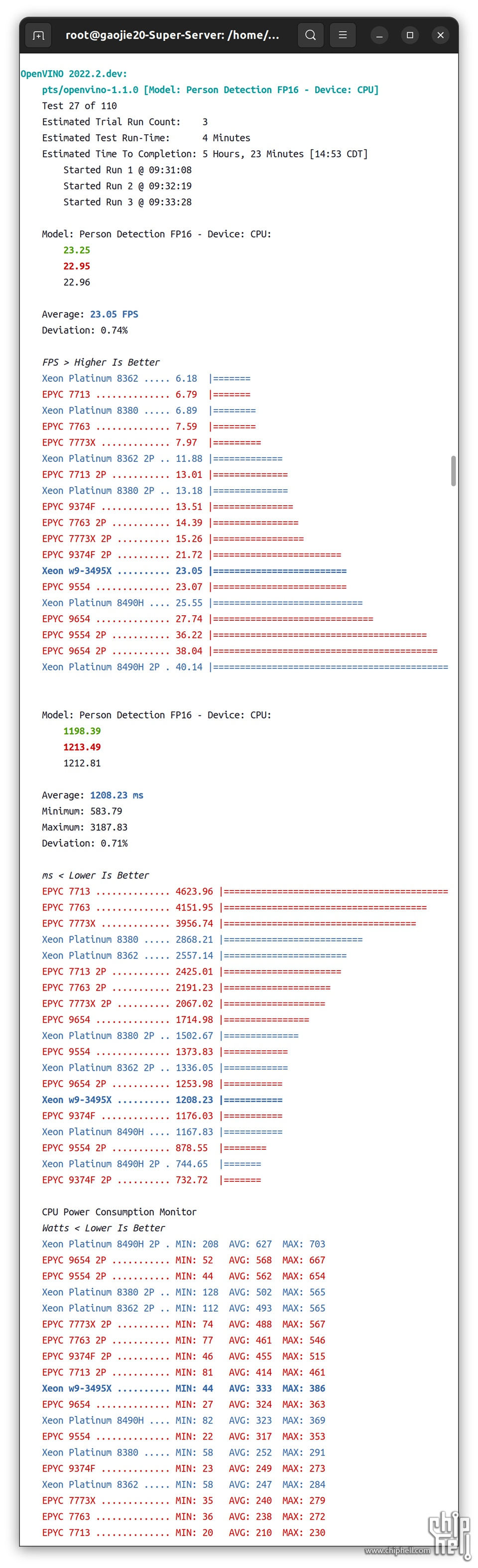

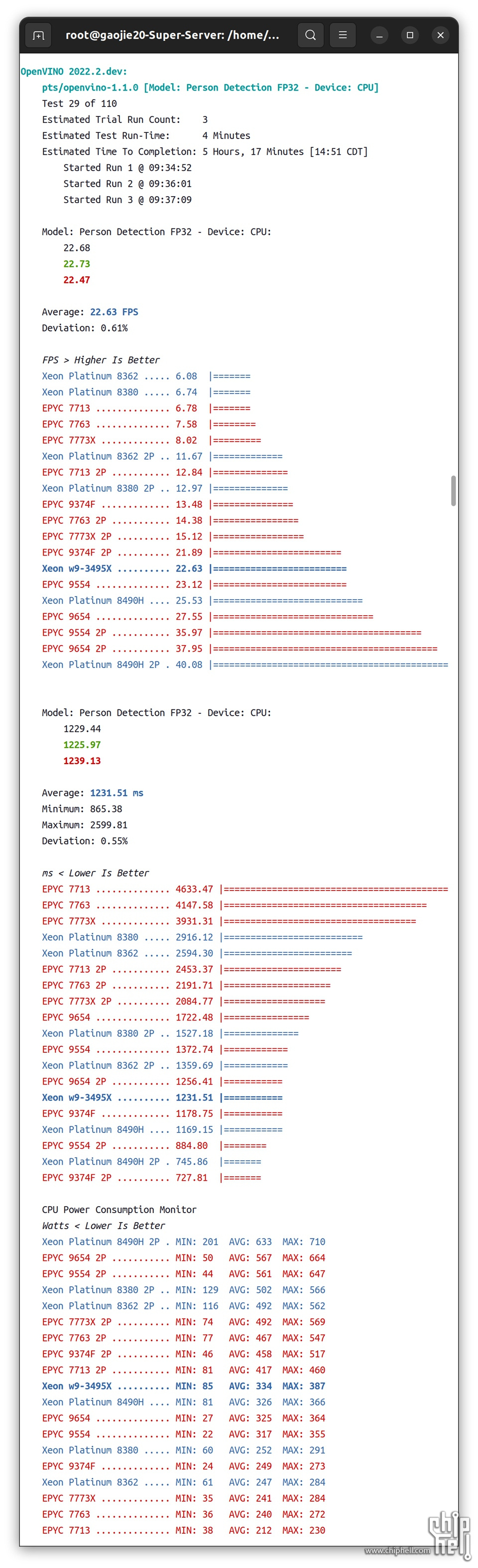

2.1.2.3 ▐ Model:person-detection-0106

这是一个基于 ResNet50为Backbone的Cascade R-CNN 架构的人体检测器。

模型溯源:https://github.com/openvinotoolk ... rson-detection-0106

▐ FP16

▐ FP32

▲单路1P:FP16

Xeon w9-3495X#23.05FPS

Xeon Platinum 8490H#25.55FPS

EPYC 9554#23.07FPS

单路1P:FP32

Xeon w9-3495X#22.63FPS

Xeon Platinum 8490H#25.53FPS

EPYC 9554#23.12FPS

这个目标检测测试Xeon w9-3495X和EPYC 9554性能基本一致,Xeon Platinum 8490H略好。

只能说对于大众化的基于 ResNet50为Backbone的Cascade R-CNN 架构,两家的CPU都优化到位了。

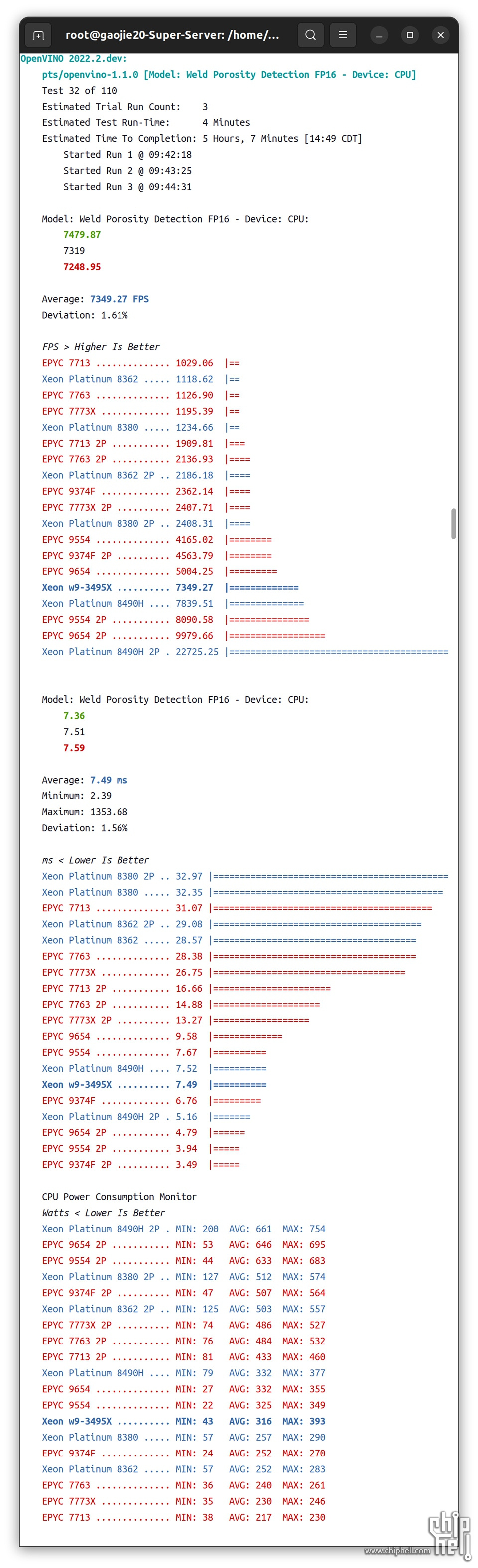

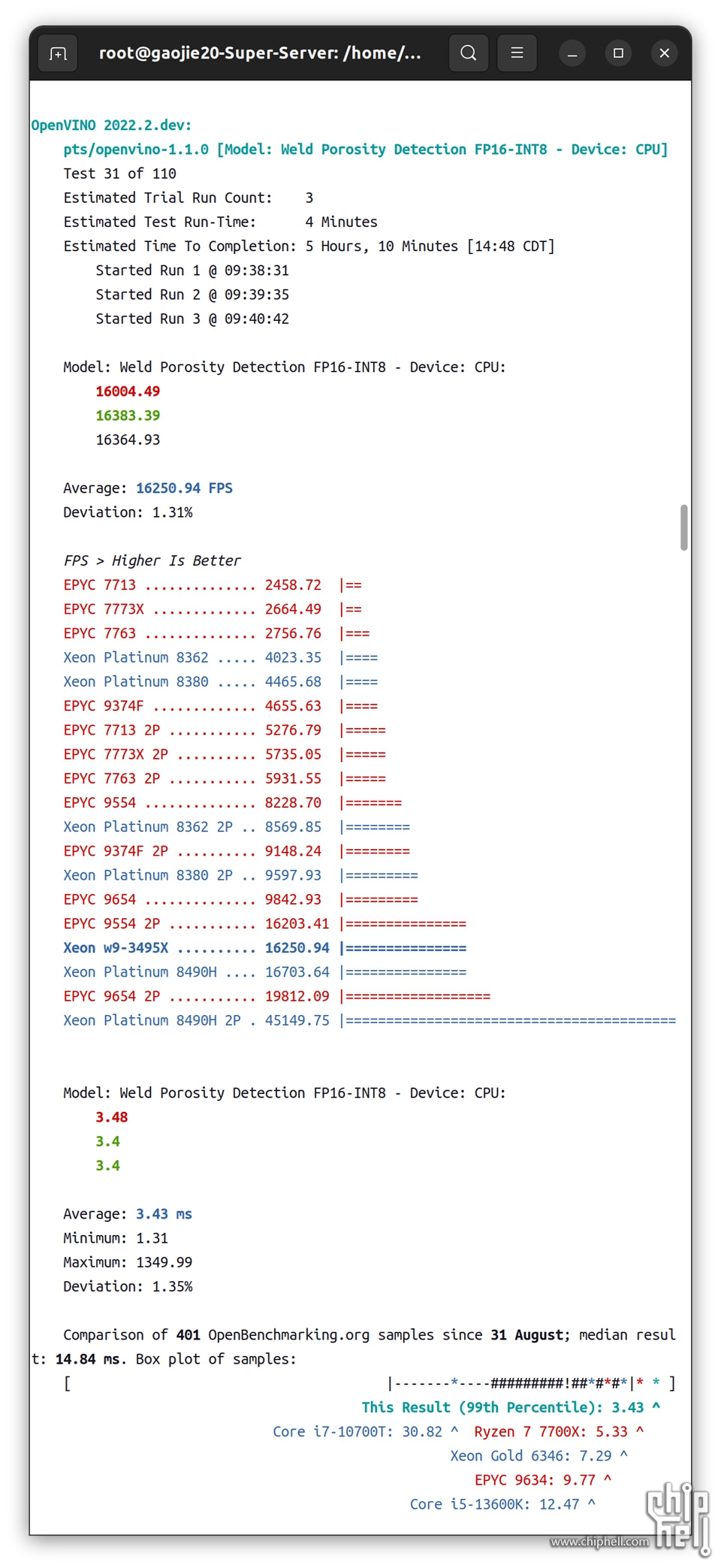

2.1.2.4 ▐ Model:weld-porosity-detection-0001

这是一个气孔焊缝识别模型。它在捕获焊嘴的视频流上运行,并报告是否未发生焊接、产生的焊缝是否良好或焊缝是否多孔。

模型溯源:https://github.com/openvinotoolk ... sity-detection-0001

▐ FP16

▐ FP16-INT8

▲

单路1P:FP16

Xeon w9-3495X#7349.27FPS

Xeon Platinum 8490H#7839.51FPS

EPYC 9554#4165.02FPS

单路1P:FP16-INT8

Xeon w9-3495X#16250.94FPS

Xeon Platinum 8490H#16703.64FPS

EPYC 9554#8228.7FPS

把模型的数据精度从FP16调整到FP16-INT8混合精度,以上三颗CPU的性能都出现了翻倍提升。EPYC 9554只有Xeon w9-3495X性能的50-60%。

值得一提的是,双路2P相比单路1P,Xeon Platinum 8490H 2P测试性能接近1P的300%,而EPYC 9554 2P测试性能接近1P的200%,所以这一轮无需多言,Xeon Platinum 8490H 单路双路都是最佳。

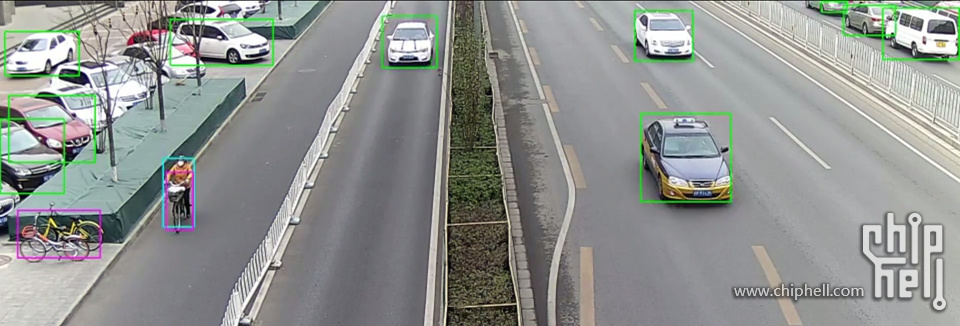

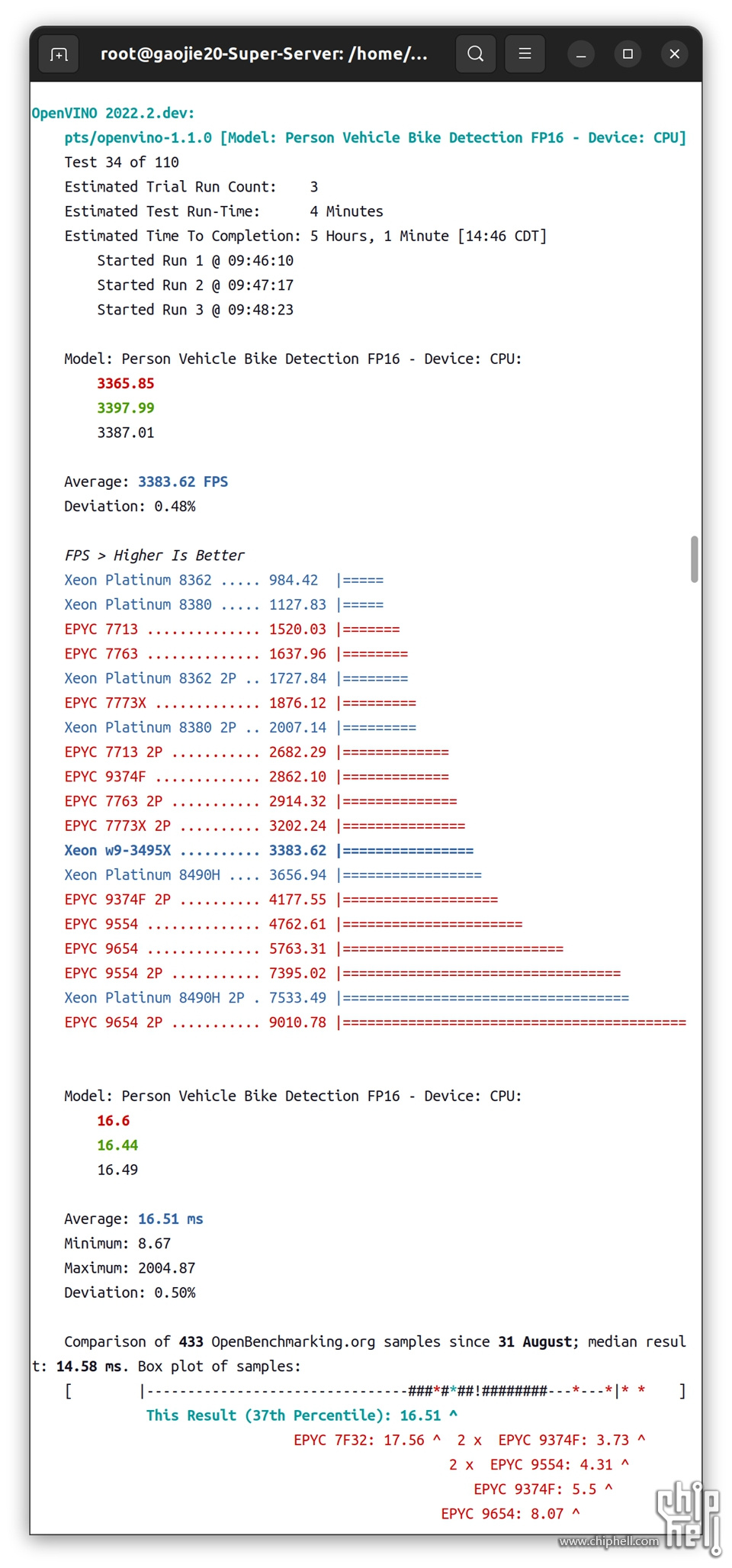

2.1.2.5 ▐ Model:person-vehicle-bike-detection-2004

这是一个基于MobileNetV2 为Backbone的人、车辆、自行车检测器。

模型溯源:https://github.com/openvinotoolk ... bike-detection-2004

▐ FP16

▲

单路1P:FP16

Xeon w9-3495X#3383.62FPS

Xeon Platinum 8490H#3656.94FPS

EPYC 9554#4762.61FPS

双路2P:FP16

Xeon Platinum 8490H 2P#7355.49FPS

EPYC 9554#7395.02FPS

这个目标检测测试无疑EPYC 9554更加优秀。

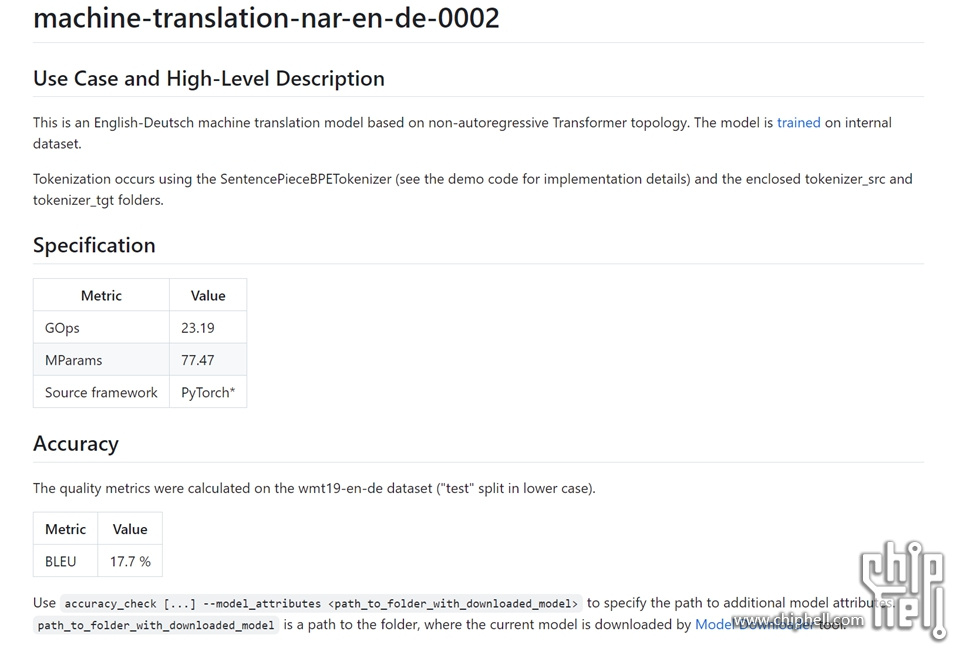

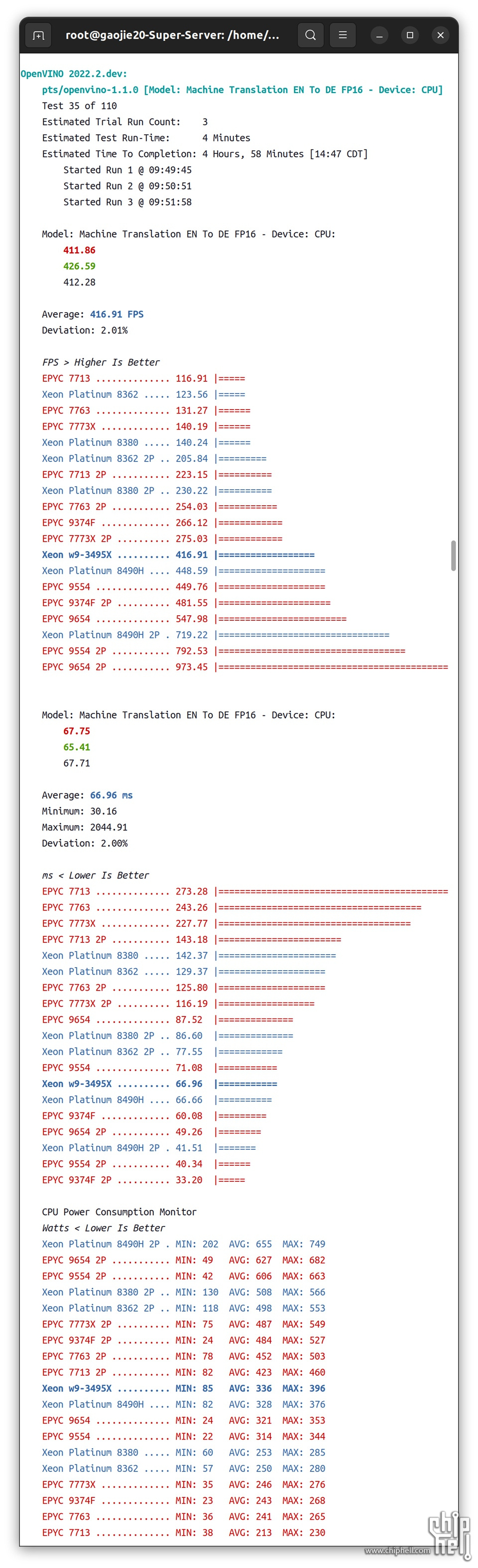

2.1.2.6 ▐ Model:machine-translation-nar-en-de-0002

▲这是一个基于非自回归 Transformer 拓扑结构的英德机器翻译模型。该模型是在内部数据集上训练的。

模型溯源:https://github.com/openvinotoolk ... tion-nar-en-de-0002

▐ FP16

▲

单路1P:FP16

Xeon w9-3495X#416.91FPS

Xeon Platinum 8490H#448.59FPS

EPYC 9554#449.76FPS

双路2P:FP16

Xeon Platinum 8490H 2P#719.22FPS

EPYC 9554#792.53FPS

这个测试EPYC 9554更加优秀。

2.1.3▐ Neural Magic DeepSparse 1.1

这是 Neural Magic 的 DeepSparse 的基准测试,使用其内置的 deepsparse.benchmark 实用程序和来自他们的 SparseZoo (https://sparsezoo.neuralmagic.com/) 的各种模型。溯源:https://github.com/neuralmagic/deepsparse

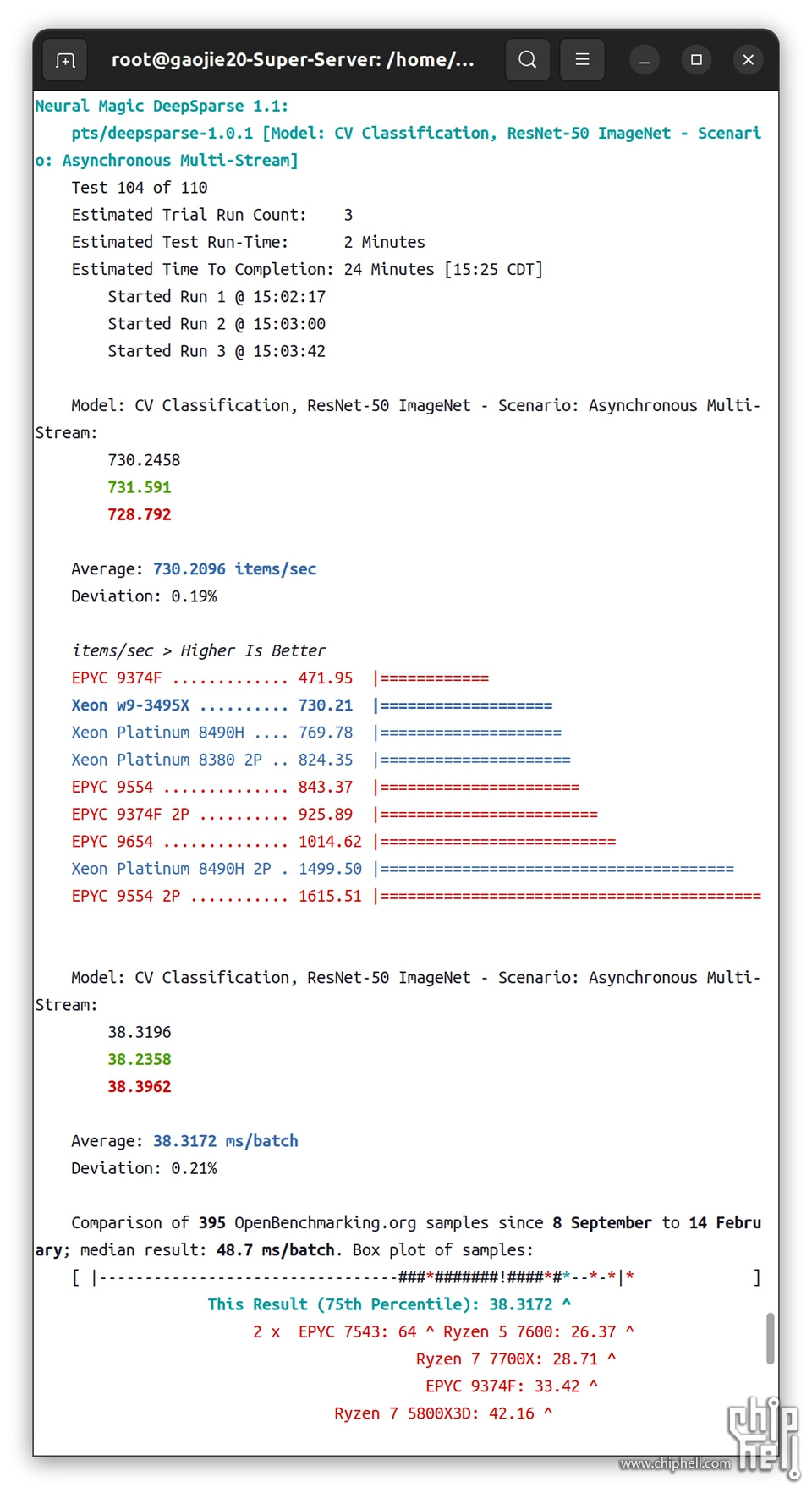

2.1.3.1 ▐ Model:CV Classification,ResNet-50 ImageNet - Asynchronous Multi-Stream

▲

单路1P:

Xeon w9-3495X#730.21 items/sec

Xeon Platinum 8490H#769.78 items/sec

EPYC 9554#843.37 items/sec

单路EPYC 9554更佳。

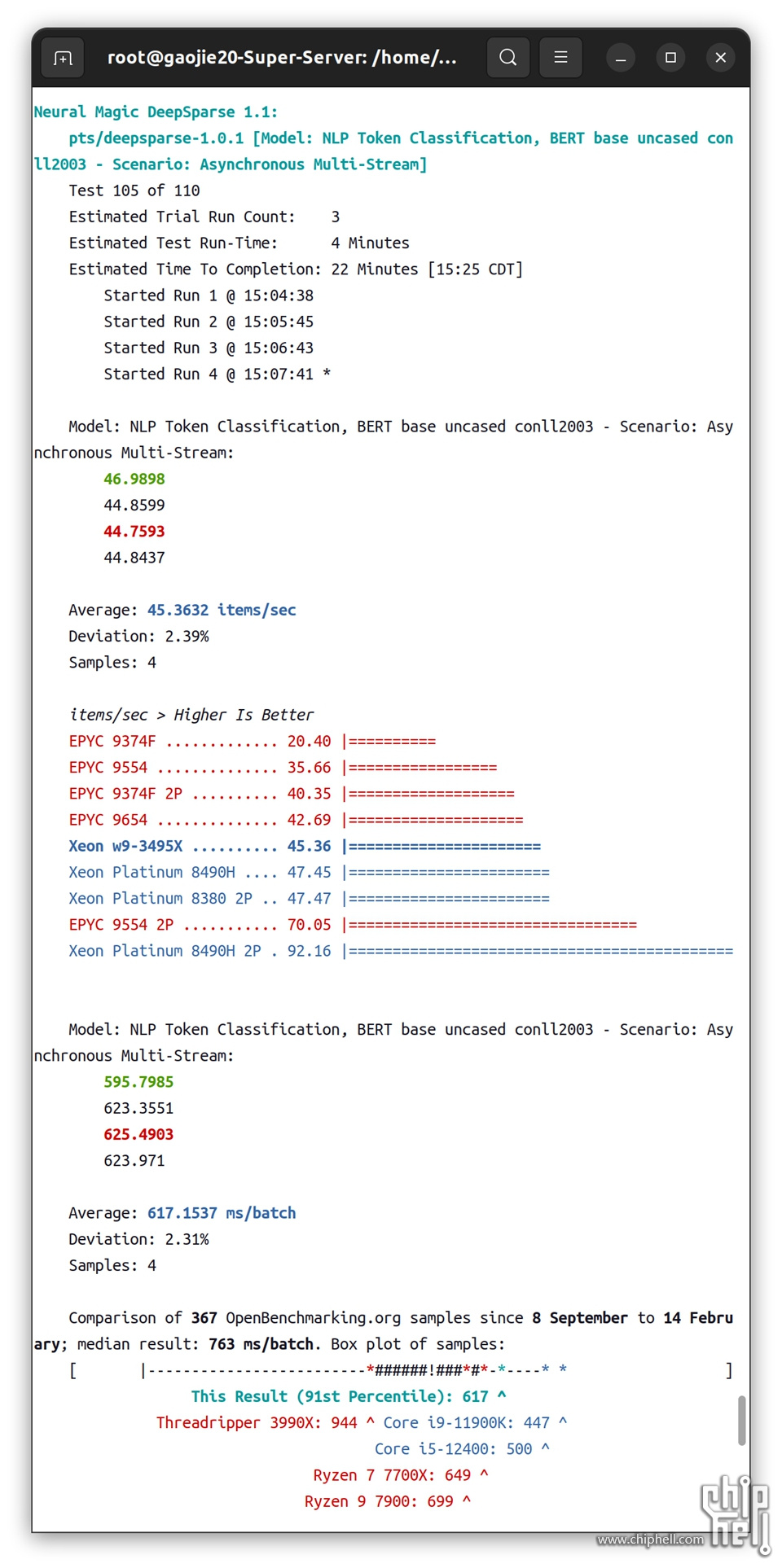

2.1.3.2 ▐ NLP Token Classification, BERT base uncased conll2003 - Asynchronous Multi-Stream:

▲

单路1P:

Xeon w9-3495X#45.36 items/sec

Xeon Platinum 8490H#47.45 items/sec

EPYC 9554#35.66 items/sec

单路Xeon Platinum 8490H更佳

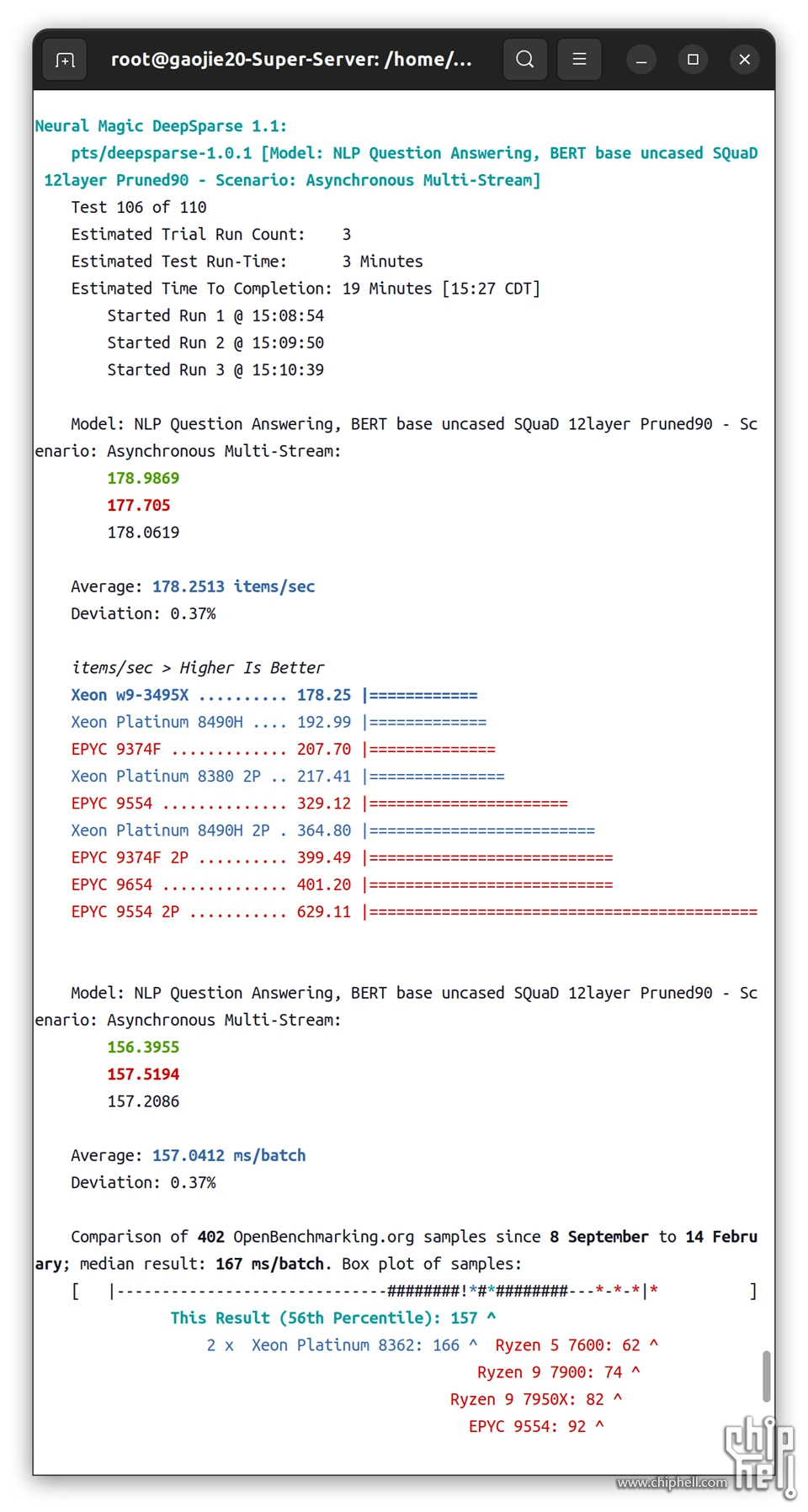

2.1.3.3 ▐ NLP Question Answering, BERT base uncased SQuaD 12layer Pruned90 - Asynchronous Multi-Stream

▲

单路1P:

Xeon w9-3495X#178.25 items/sec

Xeon Platinum 8490H#192.99 items/sec

EPYC 9554#329.12 items/sec

单路EPYC 9554更佳。

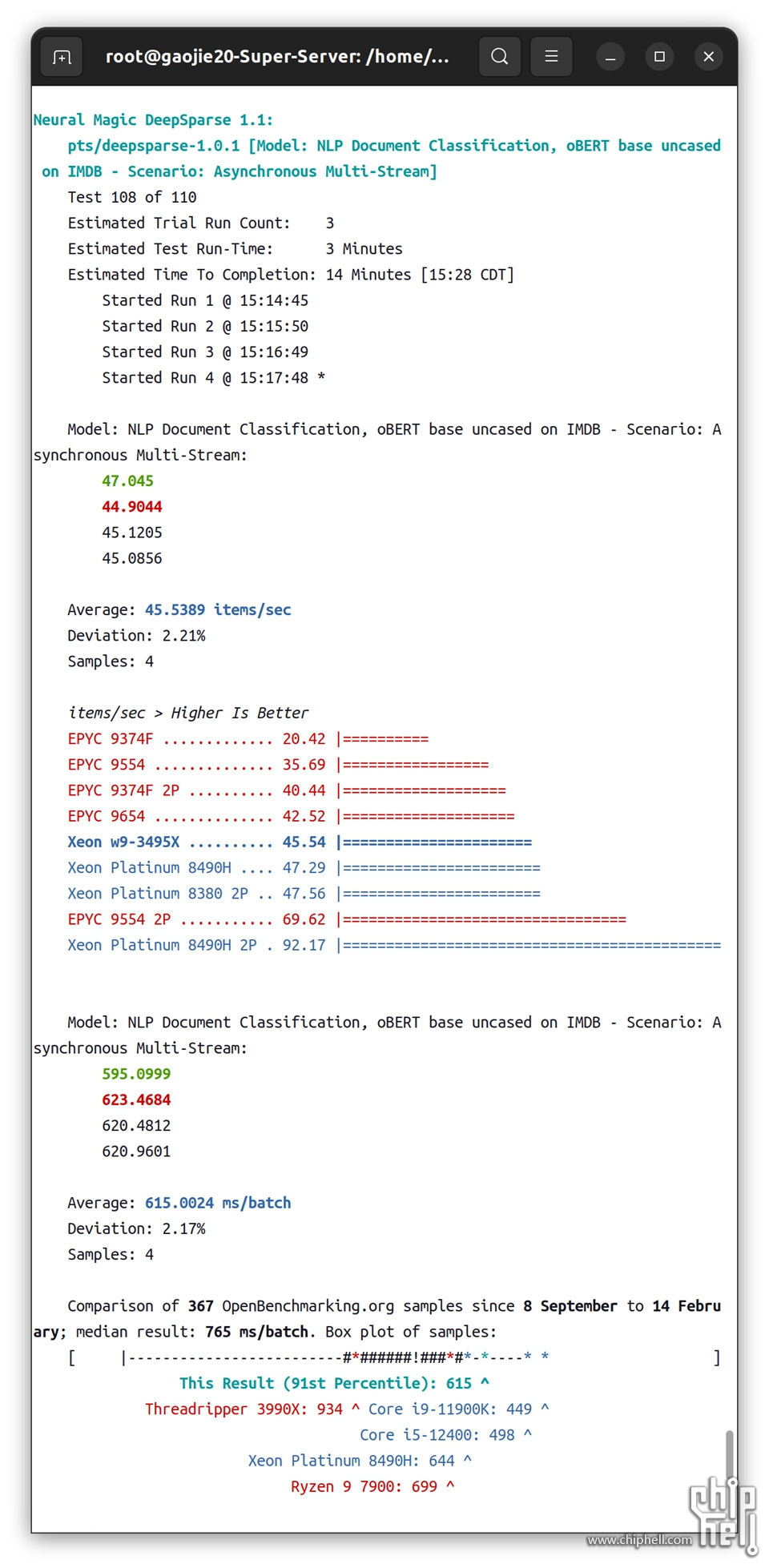

2.1.3.4 ▐ NLP Document Classification, oBERT base uncased on IMDB - Asynchronous Multi-Stream

▲

单路1P

Xeon w9-3495X#45.54 items/sec

Xeon Platinum 8490H#47.29 items/sec

EPYC 9554#35.69 items/sec

单路Xeon Platinum 8490H更佳。

2.2▐ 分子动力学

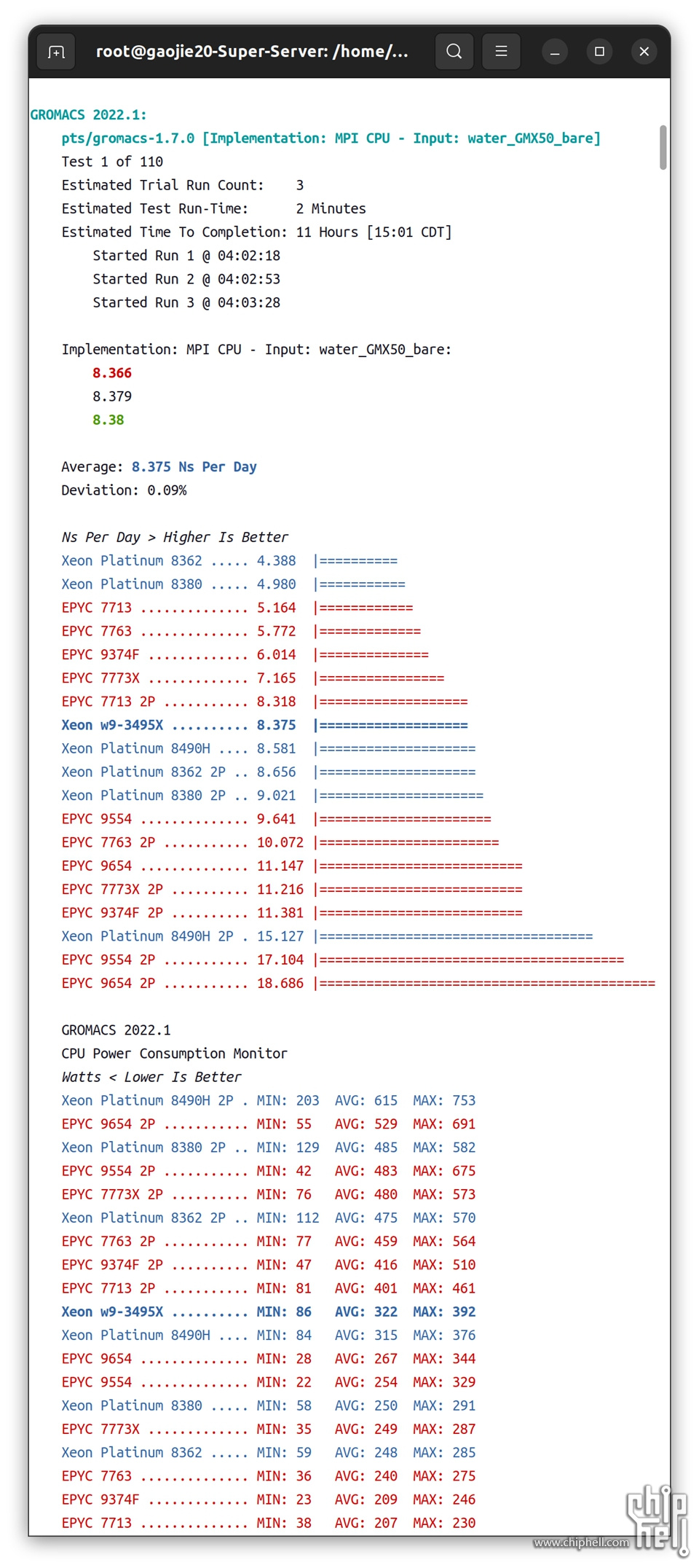

2.2.1▐ GROMACS 2022.1

使用 water_GMX50 数据的 GROMACS(GROningen MAchine for Chemical Simulations)分子动力学包测试。此测试配置文件允许在基于 CPU 和 GPU 的 GROMACS 构建之间进行选择。

▲

单路1P:

Xeon w9-3495X#8.375 Ns/day

Xeon Platinum 8490H#8.581 Ns/day

EPYC 9554#9.641 Ns/day

单路EPYC 9554更佳。

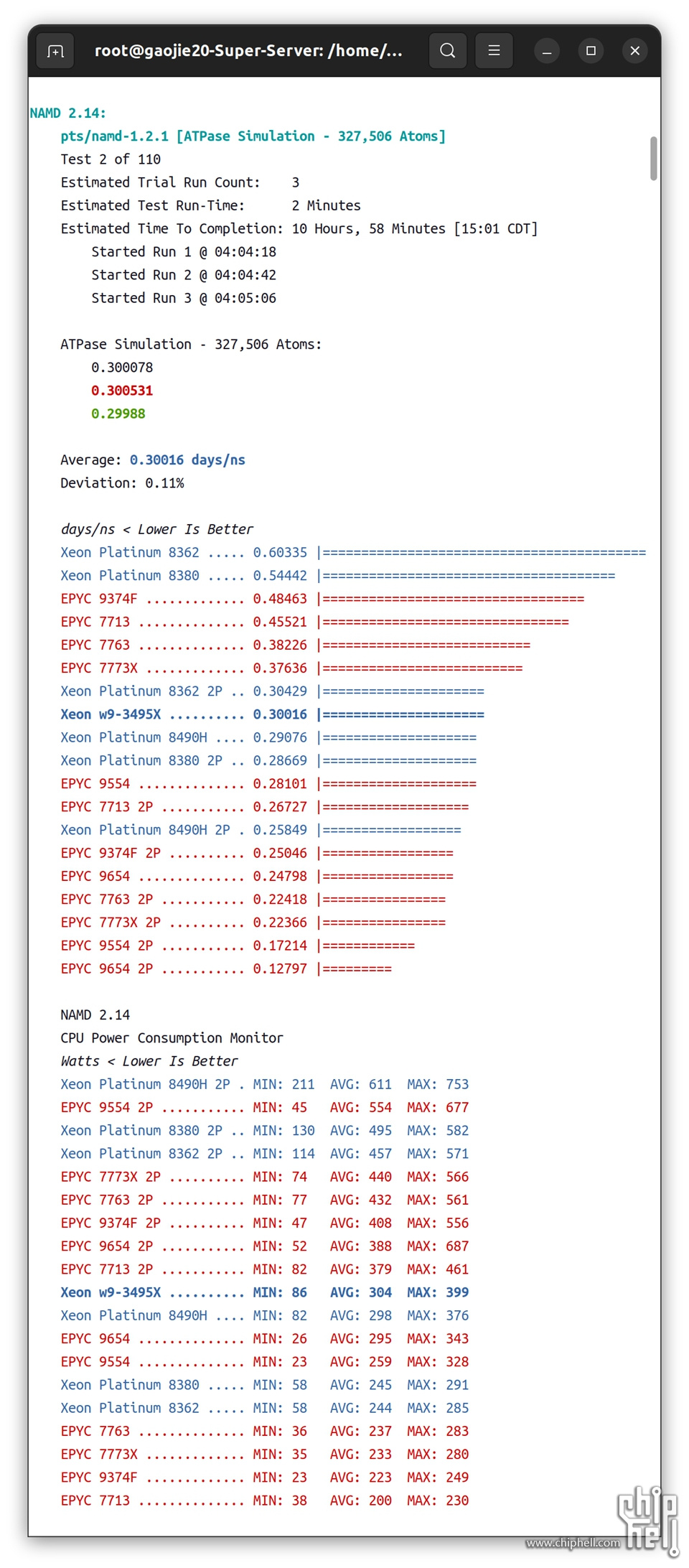

2.2.2▐ NAMD 2.14

NAMD 是一种并行分子动力学代码,专为大型生物分子系统的高性能模拟而设计。NAMD 由伊利诺伊大学香槟分校贝克曼高级科学技术研究所的理论与计算生物物理学组开发。

▲

单路1P:

Xeon w9-3495X#0.30016 days/ns

Xeon Platinum 8490H#0.29076 Ns/day

EPYC 9554#0.28101 Ns/day

单路EPYC 9554更佳。

2.3▐ HPC

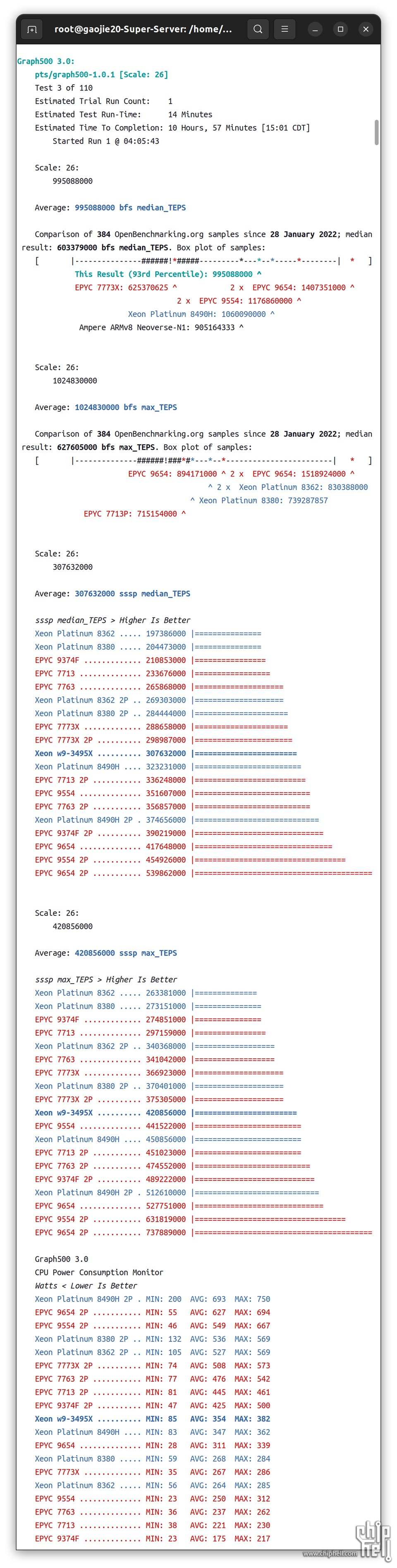

2.3.1▐ Graph500 3.0

这是 Graph500 参考实现的基准测试,Graph500 是一个专注于数据密集型负载的 HPC 基准测试,通常在超级计算机上针对复杂的数据问题进行测试。Graph500主要强调被测硬件的通信子系统。

▲

单路1P:

Xeon w9-3495X

#307632000 sssp median_TEPS

#420856000 sssp max_TEPS

Xeon Platinum 8490H

#323231000 sssp median_TEPS

#450856000 sssp max_TEPS

EPYC 9554

#351607000 sssp median_TEPS

#441522000 sssp max_TEPS

单路EPYC 9554性能更佳,平均TDP也更低。

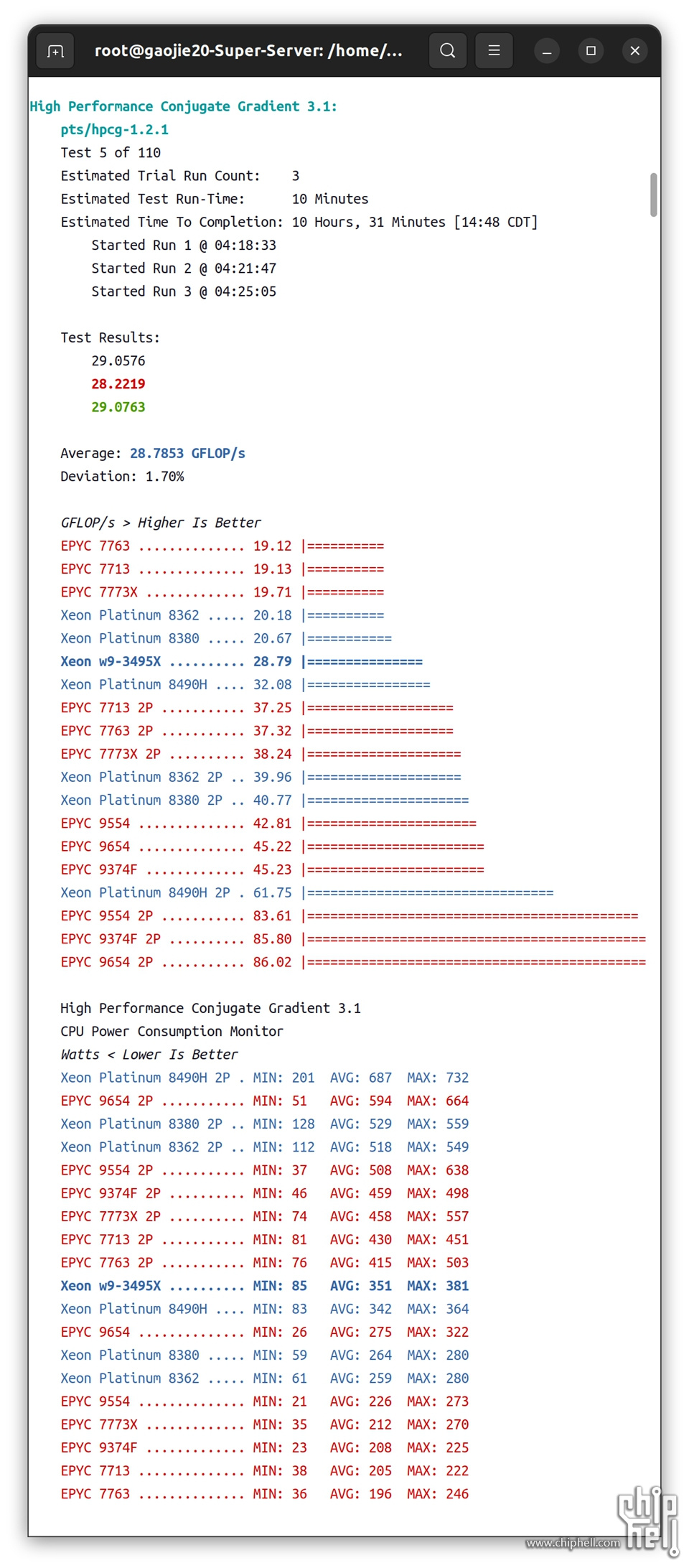

2.3.2▐ High Performance Conjugate Gradient 3.1

HPCG 是高性能共轭梯度,是 Sandia National Lans 的一项新科学基准,与 HPCC 相比,它专注于使用现代现实世界工作负载进行超级计算机测试。

▲

单路1P:

Xeon w9-3495X#28.79 GFLOPS

Xeon Platinum 8490H#32.08 GFLOPS

EPYC 9554#42.81 GFLOPS

单路EPYC 9554性能更佳,平均TDP也更低。

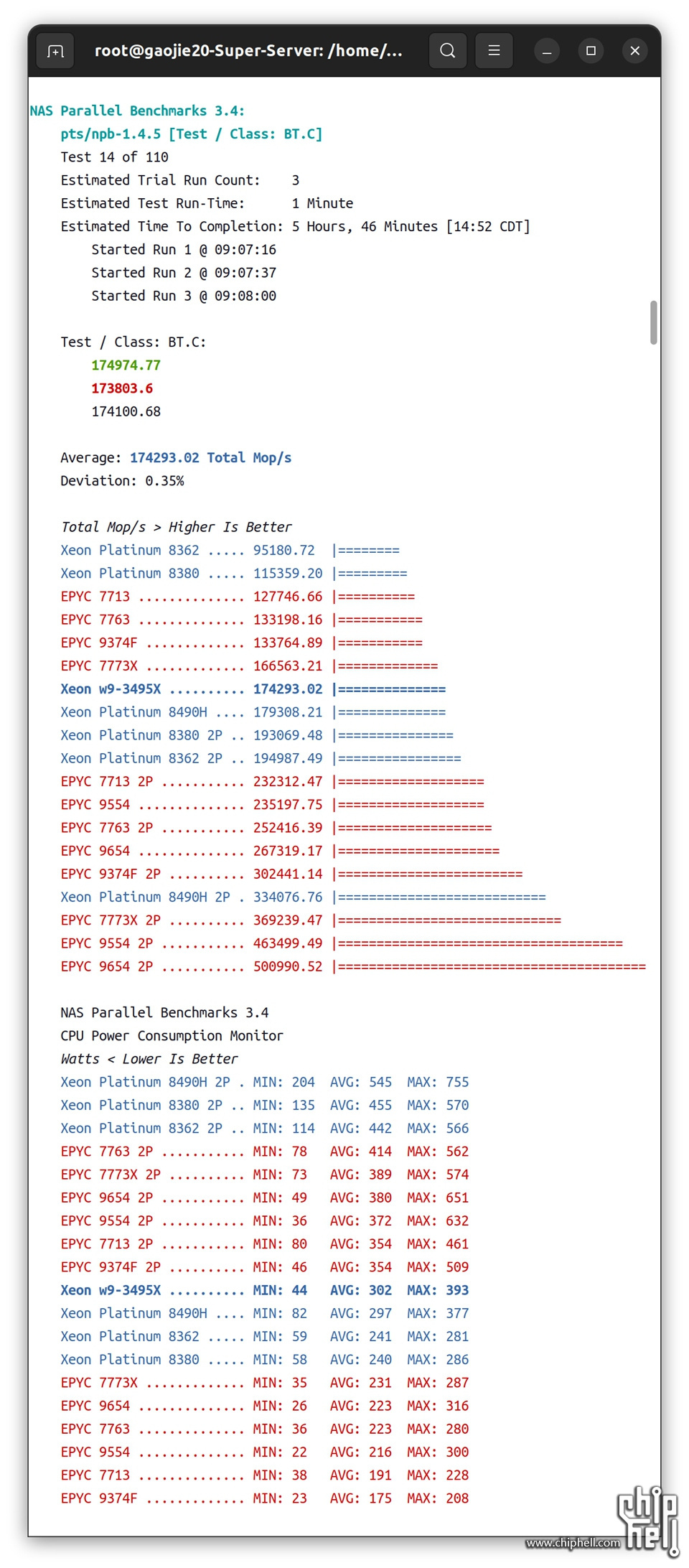

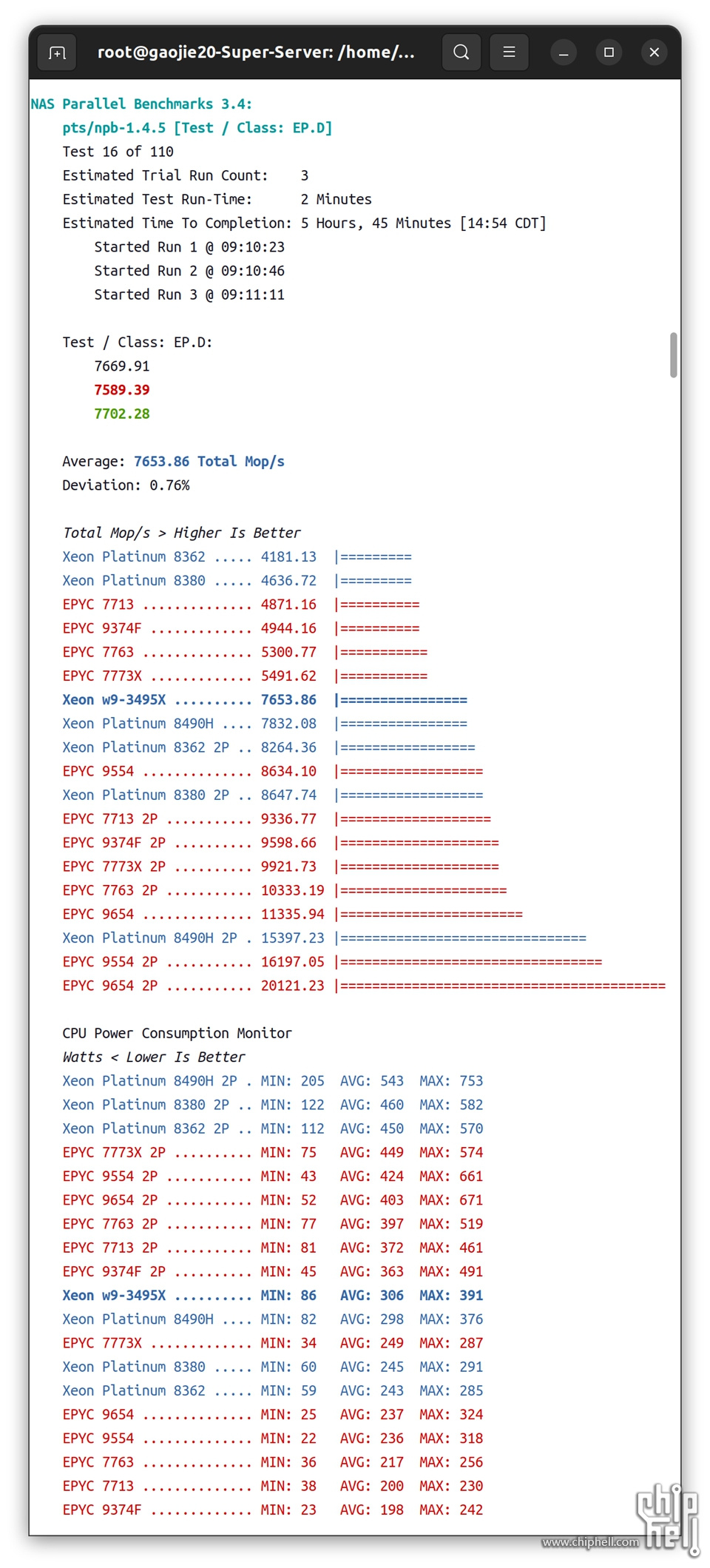

2.3.3▐ NAS Parallel Benchmarks 3.4

NPB,NAS Parallel Benchmarks,是美国宇航局为高端计算机系统开发的基准测试。此测试配置文件当前使用 NPB 的 MPI 版本。

▲

单路1P:

EPYC 9554无论在性能还是功耗已经彻底碾压Xeon w9-3495X和Xeon Platinum 8490H。

2.4▐ 编译和构建

2.4.1▐ Timed LLVM Compilation 13.0

该测试计算编译/构建 LLVM 编译器堆栈所需的时间。

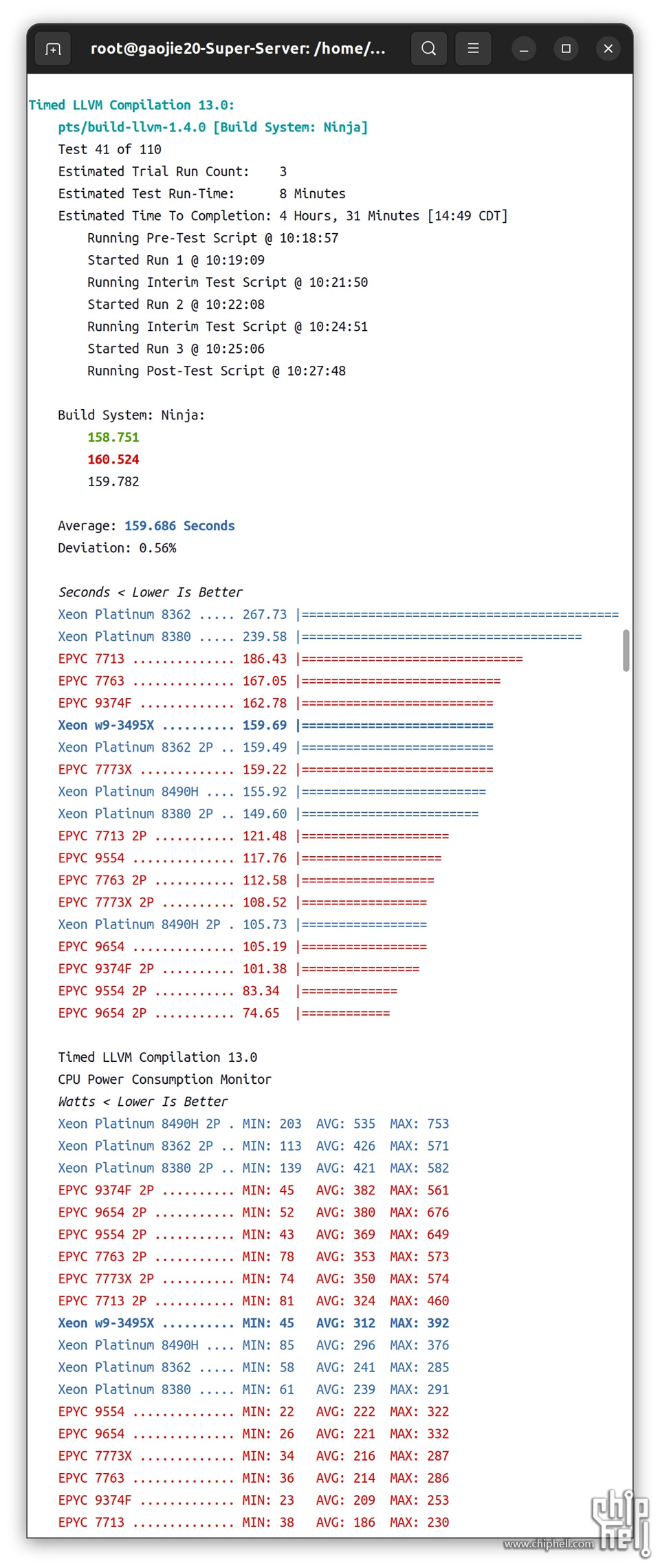

2.4.1.1 ▐ Build System:Ninja

▲

单路1P:

Xeon w9-3495X#159.69 seconds

Xeon Platinum 8490H#155.92 seconds

EPYC 9554#117.76 155.92 seconds

单路EPYC 9554构建项目时间更短,平均TDP也更低。

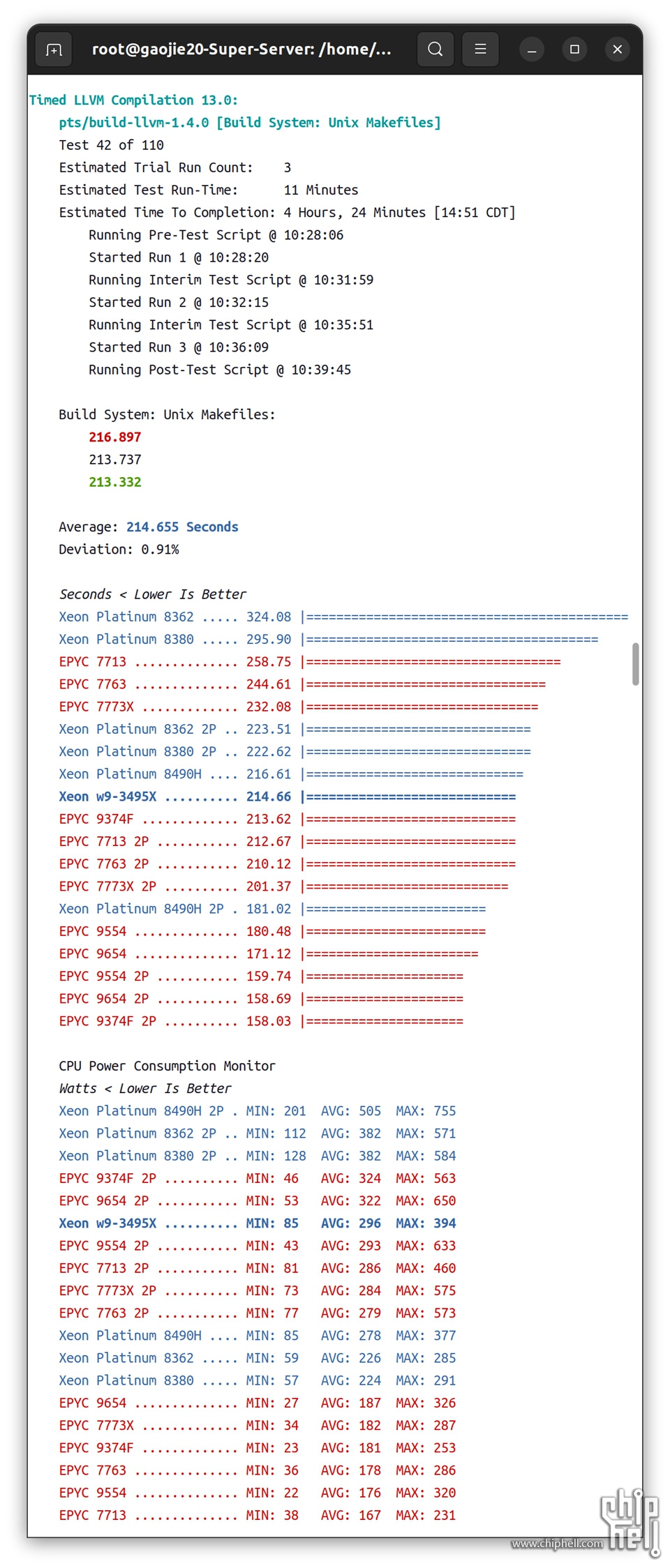

2.4.1.1 ▐ Build System:Unix Makefile

▲

单路1P:

Xeon w9-3495X#214.66 seconds

Xeon Platinum 8490H#216.61 seconds

EPYC 9554#180.48 seconds

单路EPYC 9554构建项目时间更短,平均TDP也更低。

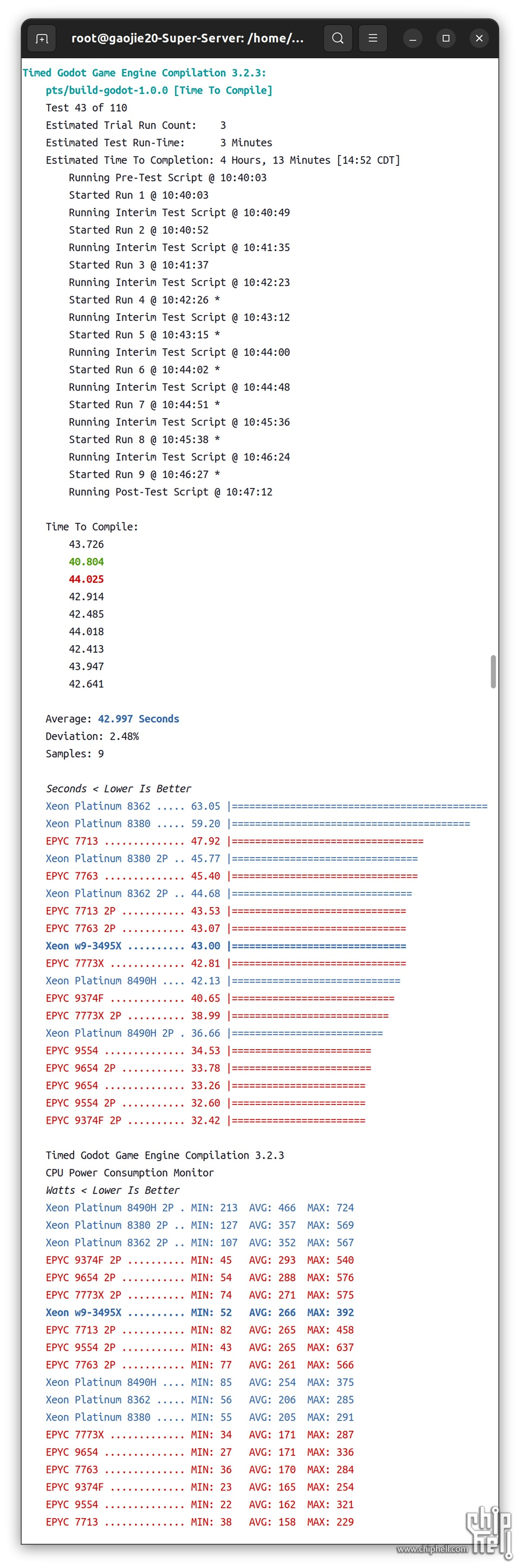

2.4.2▐ Timed Godot Game Engine Compilation 3.2.3

此测试计算编译 Godot 游戏引擎所需的时间。Godot 是一种流行的开源跨平台 2D/3D 游戏引擎,使用 SCons 构建系统构建并面向 X11 平台。

▲

单路1P:

Xeon w9-3495X#43 seconds

Xeon Platinum 8490H#42.13 seconds

EPYC 9554#34.53 seconds

单路EPYC 9554构建项目时间更短,平均TDP也更低。

2.4.3▐ Timed Linux Kernel Compilation 5.18

该测试计算在默认配置下构建 Linux 内核所需的时间。

2.4.3.1 ▐ Build:defconfig

▲

单路1P:

Xeon w9-3495X#43 seconds

Xeon Platinum 8490H#42.13 seconds

EPYC 9554#34.53 seconds

单路EPYC 9554构建项目时间更短,平均TDP也更低。

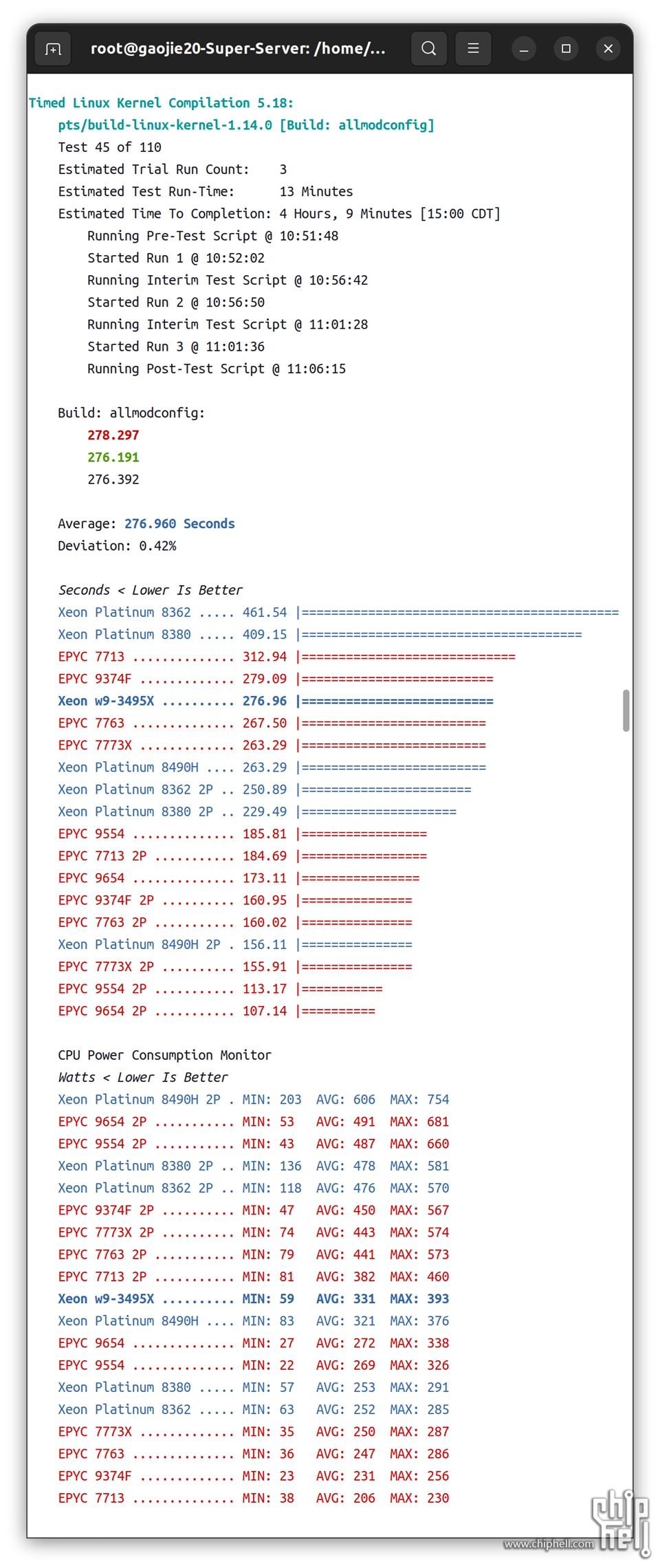

2.4.3.2 ▐ build:allmodconfig

▲

单路1P:

Xeon w9-3495X#276.96 seconds

Xeon Platinum 8490H#263.29 seconds

EPYC 9554#185.81 seconds

单路EPYC 9554构建项目时间更短,平均TDP也更低。

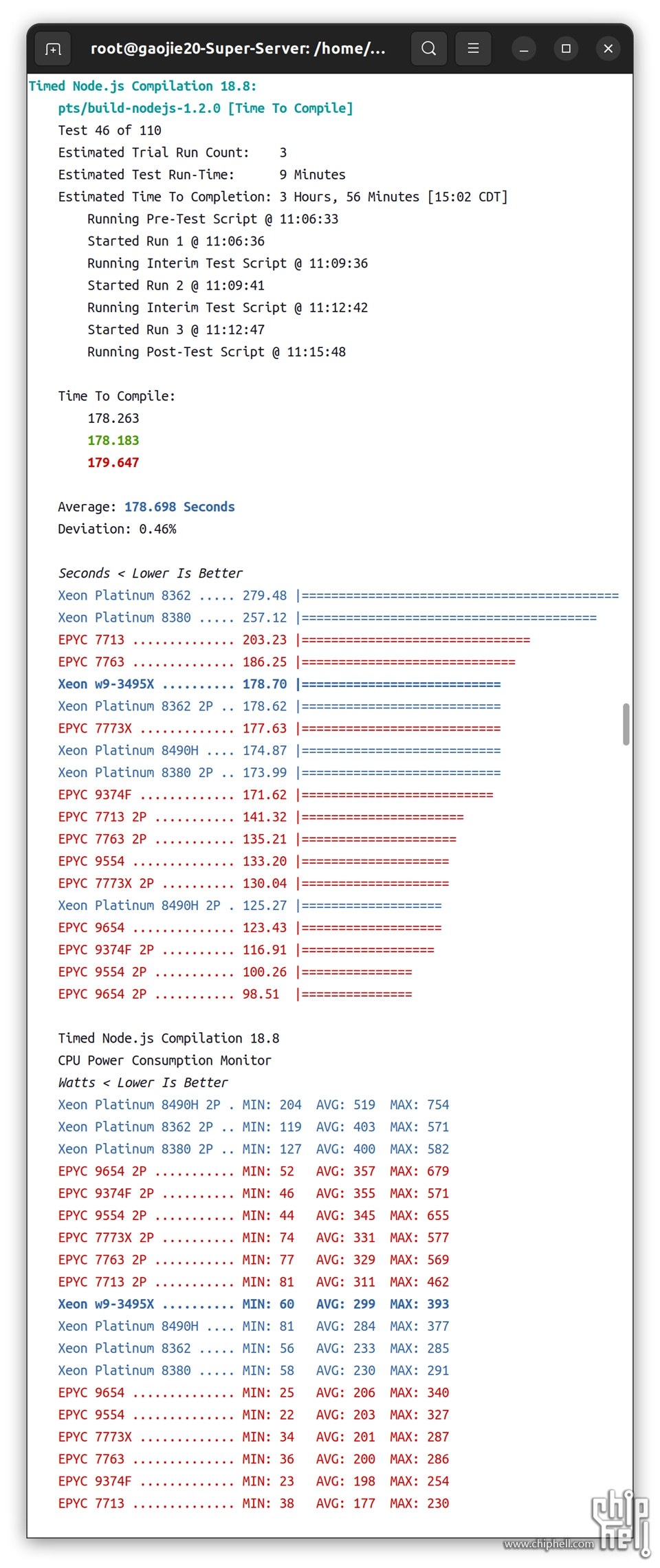

2.4.4▐ Timed Node.js Compilation 18.8

这个测试配置文件计算了从源代码构建/编译 Node.js 本身所花费的时间。Node.js 是一个基于 Chrome V8 JavaScript 引擎构建的 JavaScript 运行时,而它本身是用 C/C++ 编写的。

▲

单路1P:

Xeon w9-3495X#178.70 seconds

Xeon Platinum 8490H#174.87 seconds

EPYC 9554#133.20 seconds

单路EPYC 9554构建项目时间更短,平均TDP也更低。

2.5▐ 渲染

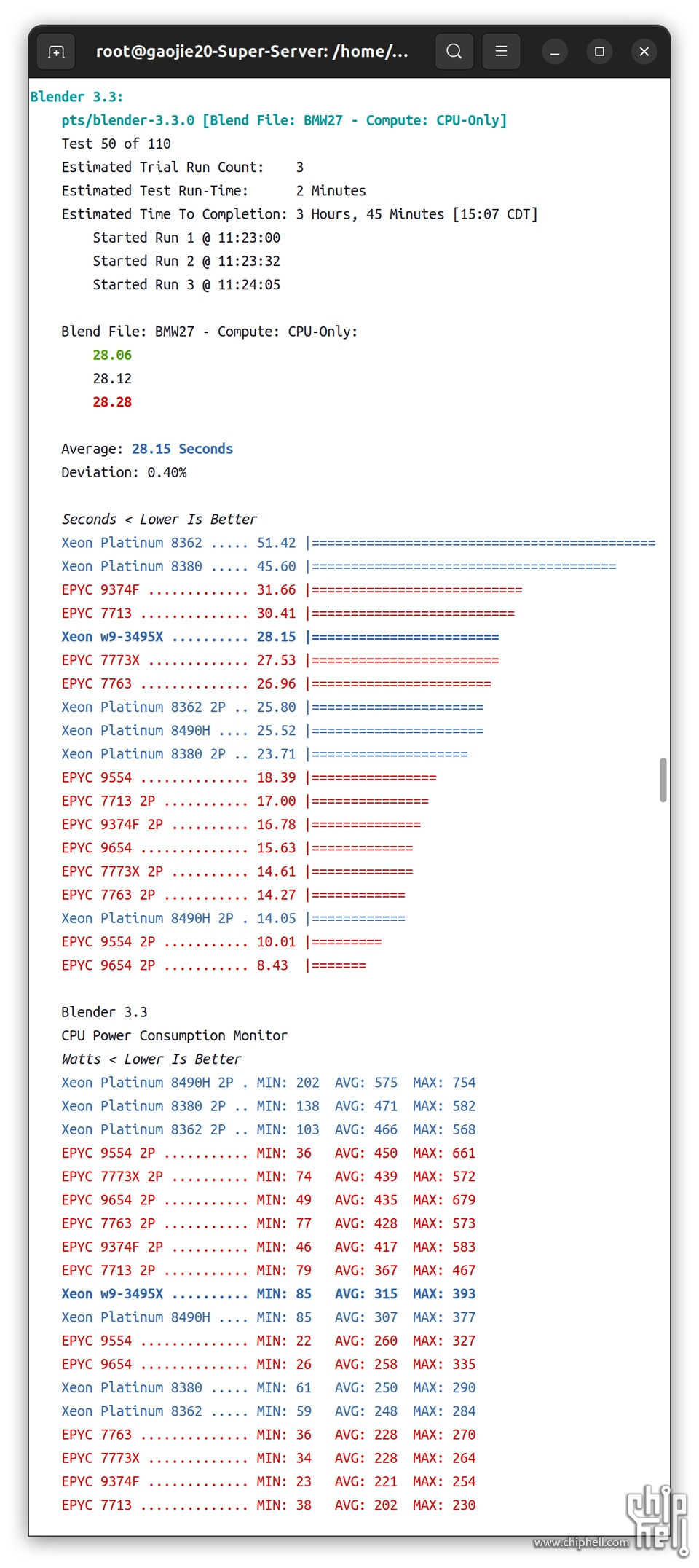

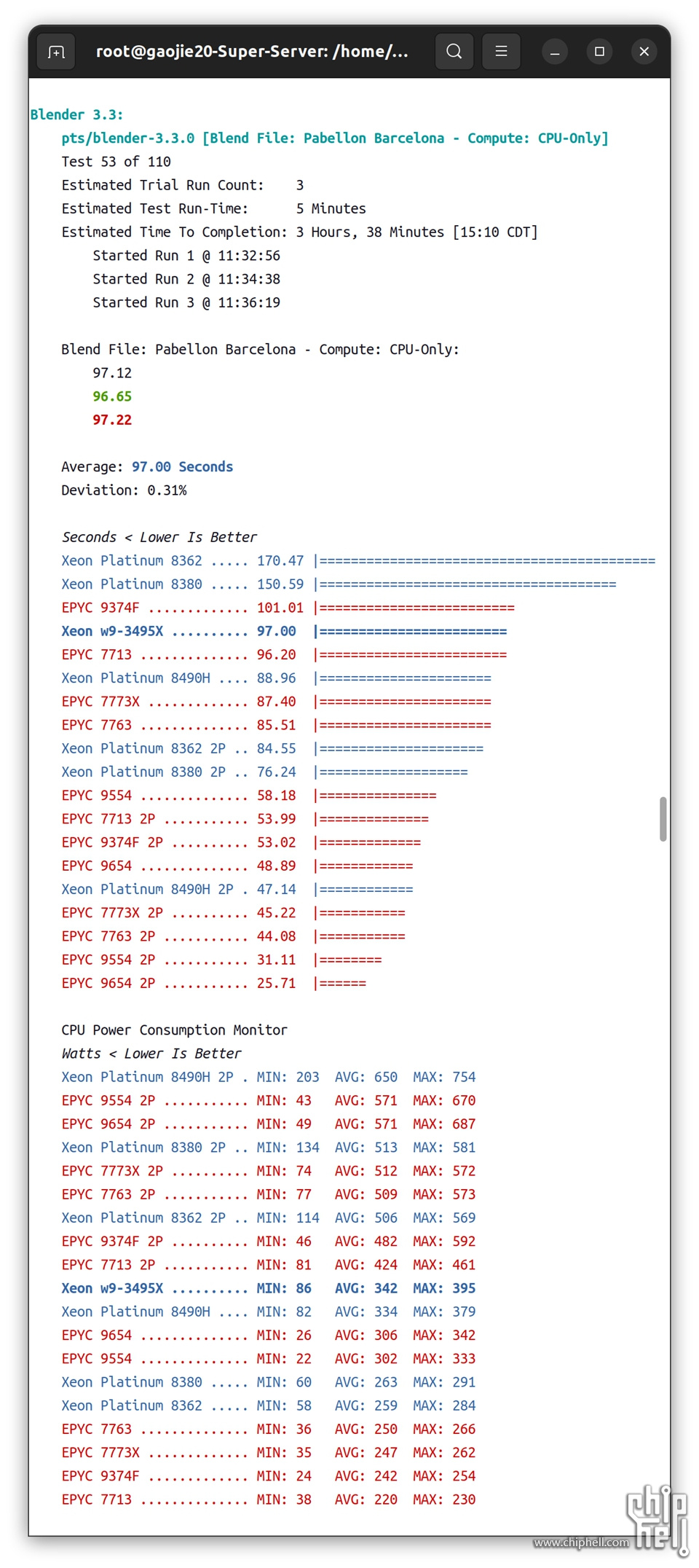

2.5.1▐ Blender 3.3

Blender 是一个开源 3D 创建和建模软件项目。该测试是使用各种示例文件对 Blender 的 Cycles 性能进行的测试。目前支持通过 NVIDIA OptiX 和 NVIDIA CUDA 进行的 GPU 计算,以及用于 AMD Radeon GPU 的 HIP 和用于 Intel Graphics 的 Intel oneAPI。本次测试我们使用纯CPU进行渲染。

2.5.1.1 ▐ Model:BMW27

▲

单路1P:

Xeon w9-3495X#28.15 seconds

Xeon Platinum 8490H#25.52 seconds

EPYC 9554#18.39 seconds

单路EPYC 9554渲染时间更短,平均TDP更低。

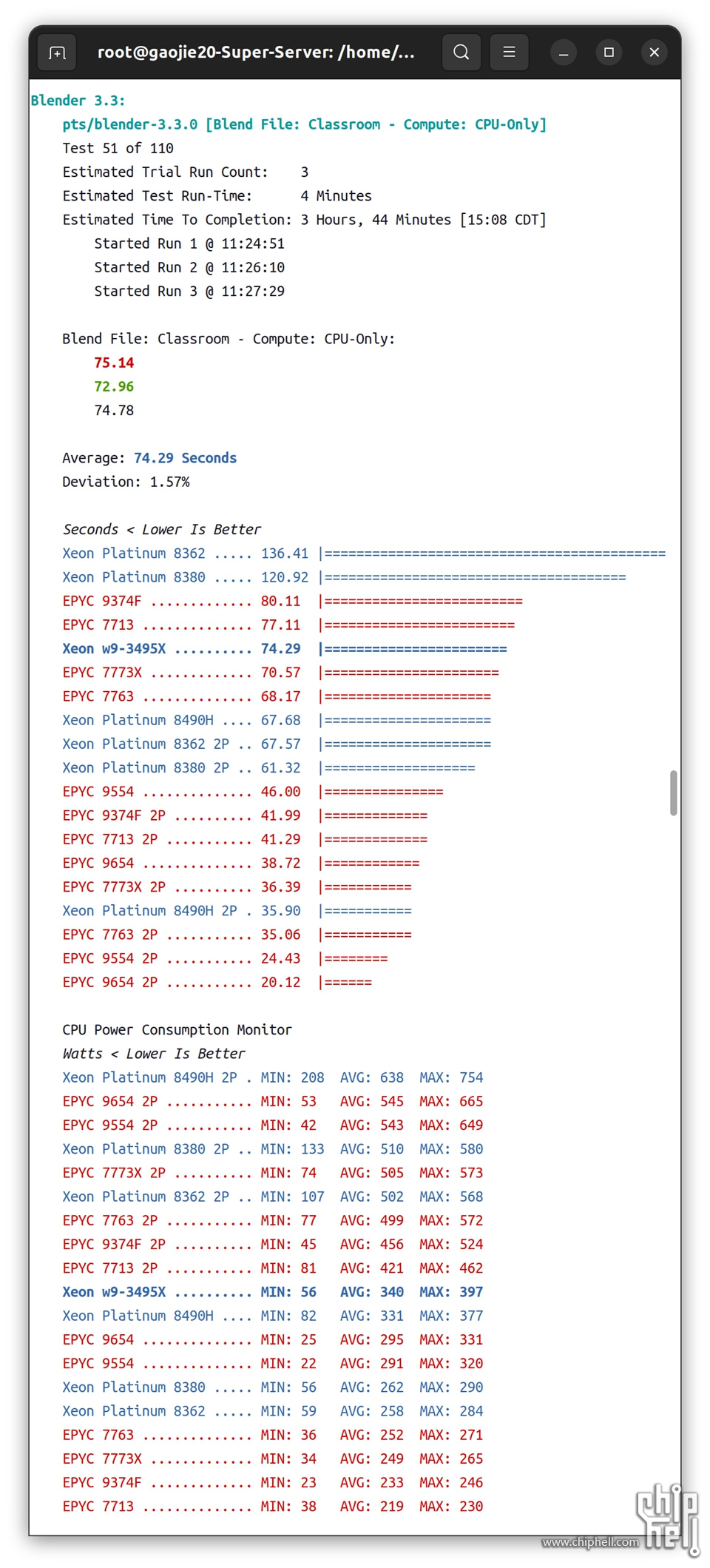

2.5.1.2 ▐ Model:Classroom

▲

单路1P:

Xeon w9-3495X#74.29 seconds

Xeon Platinum 8490H#67.68 seconds

EPYC 9554#46 seconds

单路EPYC 9554渲染时间更短,平均TDP更低。

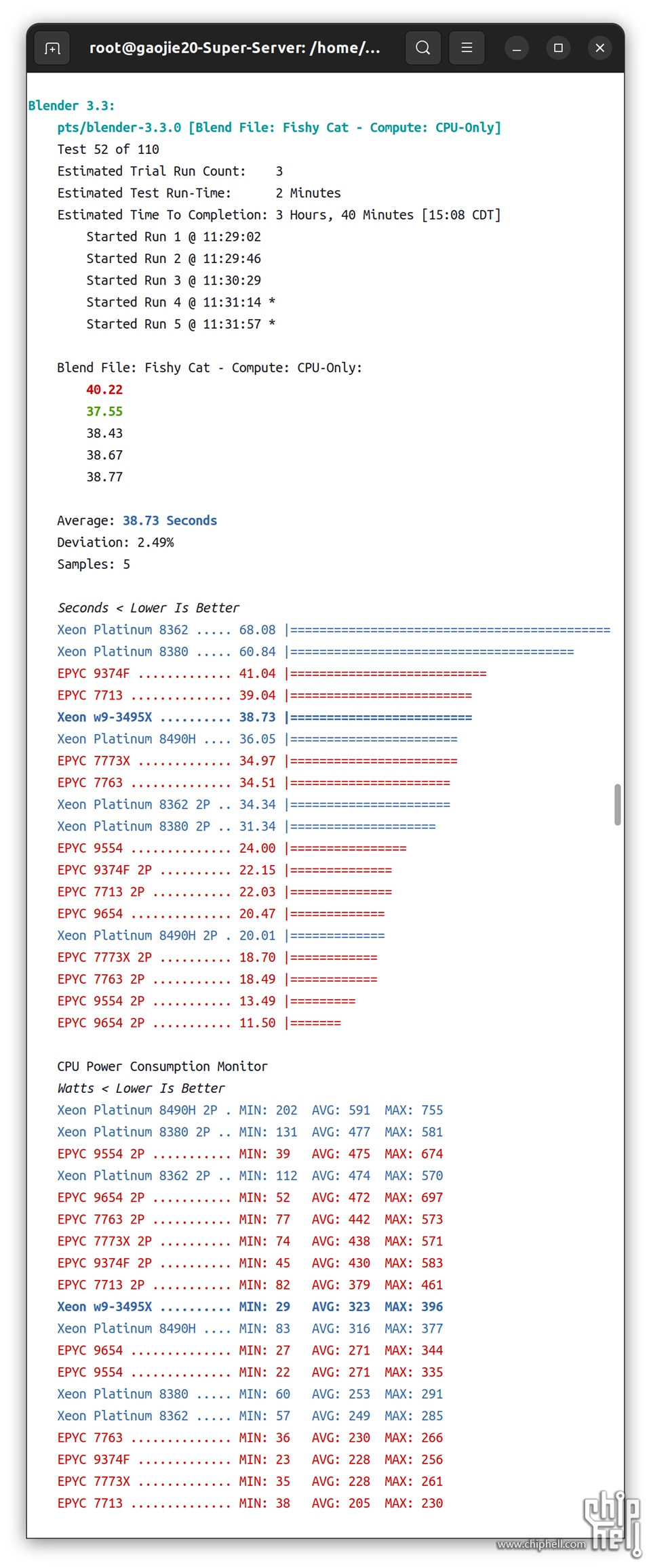

2.5.1.3 ▐ Model:Fishy Cat

▲

单路1P:

Xeon w9-3495X#39.73 seconds

Xeon Platinum 8490H#36.05 seconds

EPYC 9554#24 seconds

单路EPYC 9554渲染时间更短,平均TDP更低。

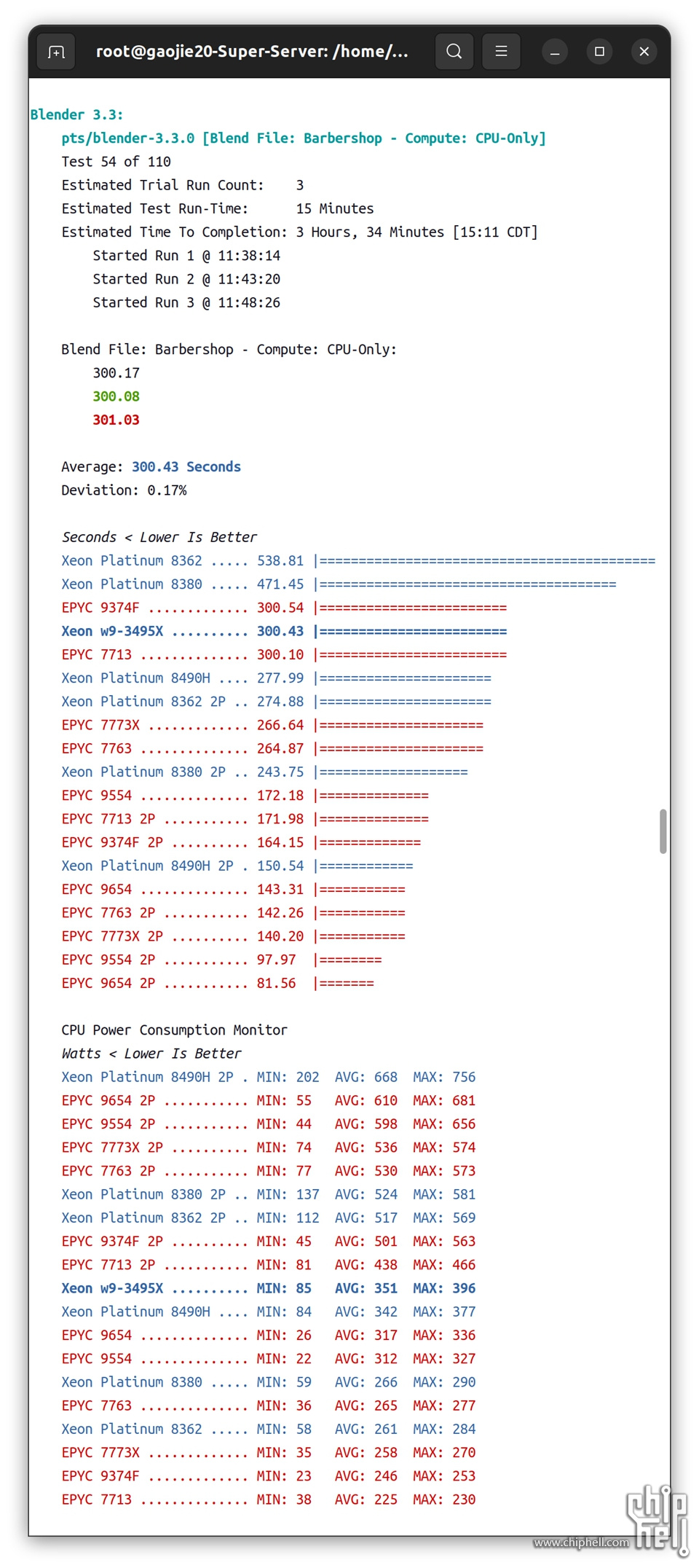

2.5.1.4 ▐ Model:Barbershop

▲

单路1P:

Xeon w9-3495X#300.43 seconds

Xeon Platinum 8490H#277.99 seconds

EPYC 9554#172.18 seconds

单路EPYC 9554渲染时间更短,平均TDP更低。

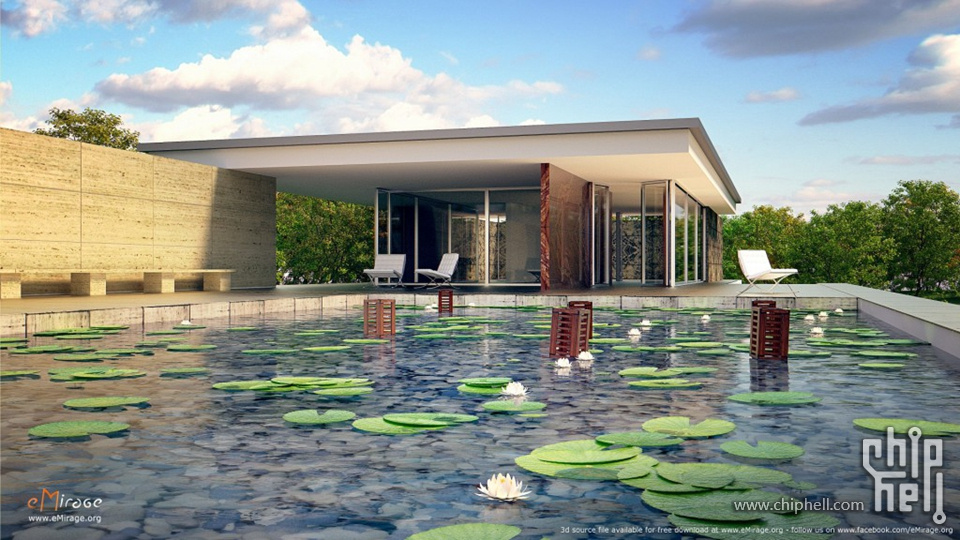

2.5.1.5 ▐ Model:Barcelona

▲

单路1P:

Xeon w9-3495X#97 seconds

Xeon Platinum 8490H#88.96 seconds

EPYC 9554#58.18 seconds

单路EPYC 9554渲染时间更短,平均TDP更低。

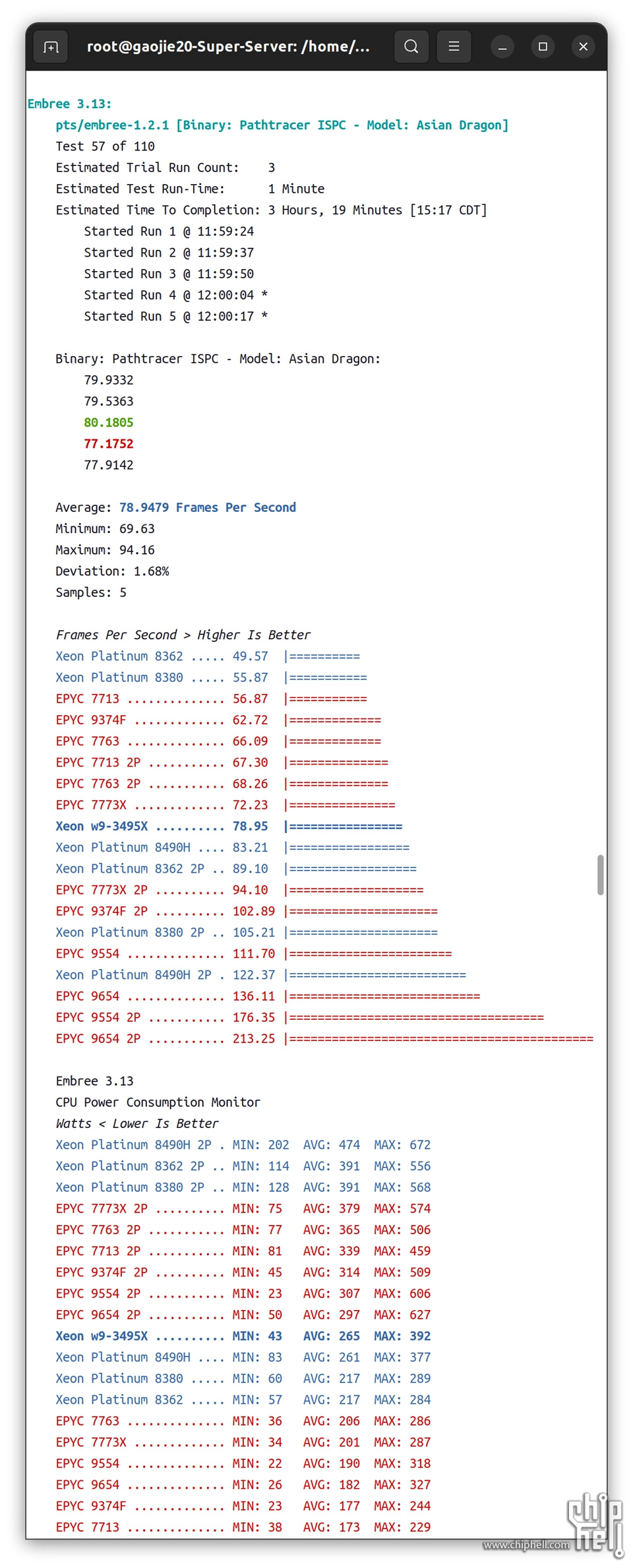

2.6▐ 光线追踪

2.6.1▐ Embree 3.13

Intel Embree 是一组高性能光线追踪内核,用于在 CPU(和通过 SYCL 的 GPU)上执行并支持 SSE、AVX、AVX2 和 AVX-512 等指令集。Embree 还支持使用英特尔 SPMD 程序编译器 (ISPC)。

▲

单路1P: Xeon w9-3495X#78.95 FPS Xeon Platinum 8490H#83.21 FPS EPYC 9554#111.70 FPS 单路EPYC 9554 FPS更高,平均TDP更低。

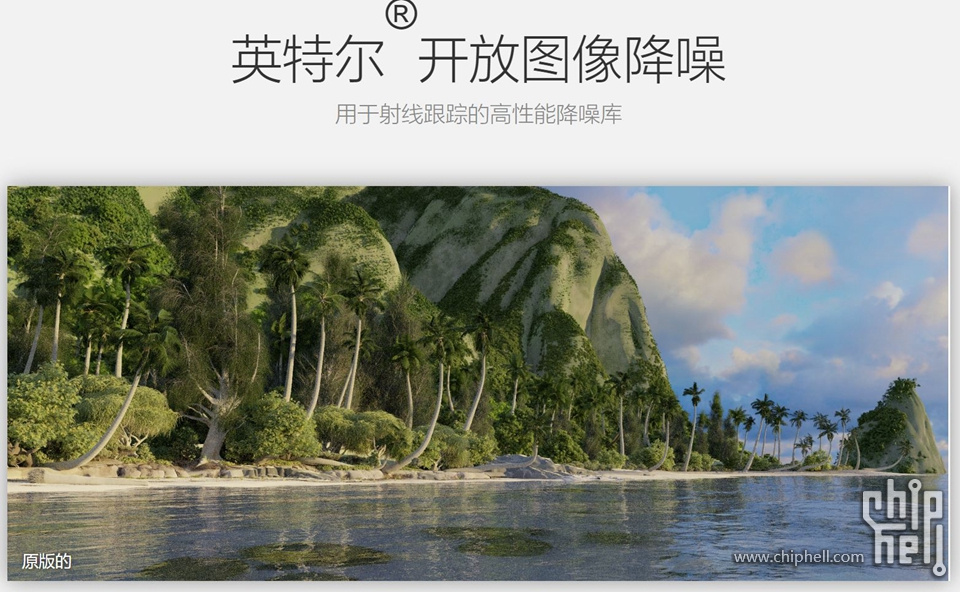

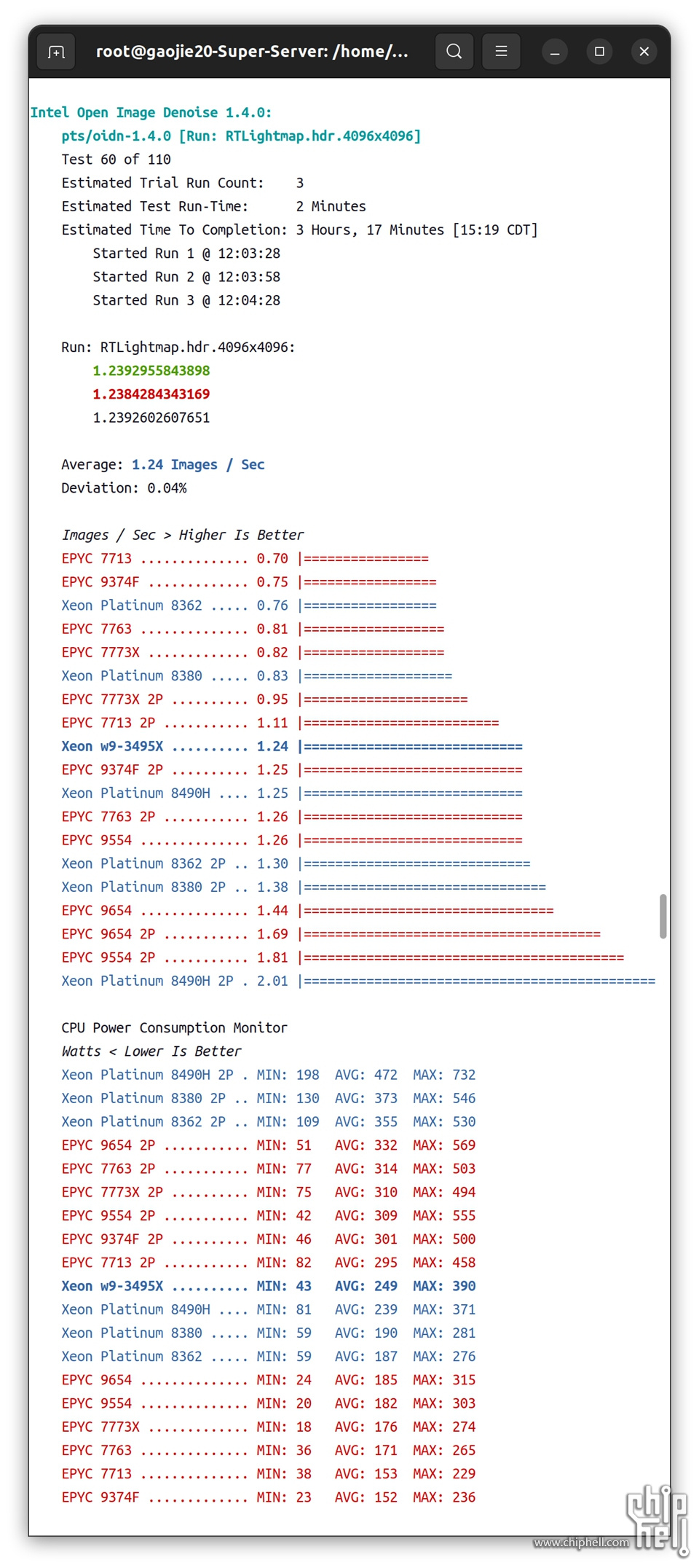

2.6.2▐ Intel Open Image Denoise 1.4.0

Open Image Denoise 是一个用于光线追踪的去噪库,是 oneAPI 渲染工具包的一部分。英特尔®Open Image Denoise的目的是提供一个开放,高质量,高效且易于使用的去噪库,该库可显着减少基于光线跟踪的渲染应用程序中的渲染时间。它可以滤除随机光线跟踪方法(例如路径跟踪)固有的蒙特卡洛噪声,从而将每个像素所需的样本数量减少了甚至多个数量级(取决于所需的与地面真实程度的接近程度)。一个简单但灵活的C / C ++ API确保该库可以轻松集成到大多数现有或新的渲染解决方案中。

英特尔®Open Image Denoise库的核心是一组基于深度学习的高效降噪滤波器,这些滤波器经过训练可以处理从1 spp到几乎完全收敛的每个像素(spp)的各种样本。因此,它适用于预览和最终帧渲染。滤镜可以仅使用嘈杂的颜色(美感)缓冲区对图像进行降噪,或者为了保留尽可能多的细节,还可以选择使用辅助特征缓冲区(例如反照率,正常)。大多数渲染器都将此类缓冲区作为任意输出变量(AOV)支持,或者通常可以轻松实现。

尽管该库附带了一组预训练的过滤器模型,但并非必须使用这些模型。为了针对特定渲染器,样本数量,内容类型,场景等优化过滤器,可以使用随附的训练工具包和用户提供的图像数据集来训练模型。

英特尔®Open Image Denoise支持基于英特尔®64架构的CPU和兼容架构,并且可以在从笔记本电脑,工作站到HPC系统中的计算节点的任何设备上运行。它的效率足够高,不仅适合于脱机渲染,而且取决于所使用的硬件,还适合于交互式光线跟踪。

Intel Open Image Denoise内部建立在Intel oneAPI深度神经网络库(oneDNN)之上,并自动利用Intel SSE4,AVX2和AVX-512等现代指令集来实现高去噪性能。要运行Intel Open Image Denoise,需要至少支持SSE4.1的CPU。

溯源自:https://www.openimagedenoise.org/

2.6.2.1 ▐ RT.ldr_alb_nrm.3840x2160

▲

单路1P:

Xeon w9-3495X#2.61 Images/Sec

Xeon Platinum 8490H#2.64 Images/Sec

EPYC 9554#2.67 Images/Sec

单路EPYC 9554 每秒处理的图片数更多,平均TDP更低。

2.6.2.2 ▐ RTLightmap.hdr.4096x4096

▲

单路1P:

Xeon w9-3495X#1.24 Images/Se

Xeon Platinum 8490H#1.25 Images/Sec

EPYC 9554#1.26 Images/Sec

单路EPYC 9554 每秒处理的图片数更多,平均TDP更低。

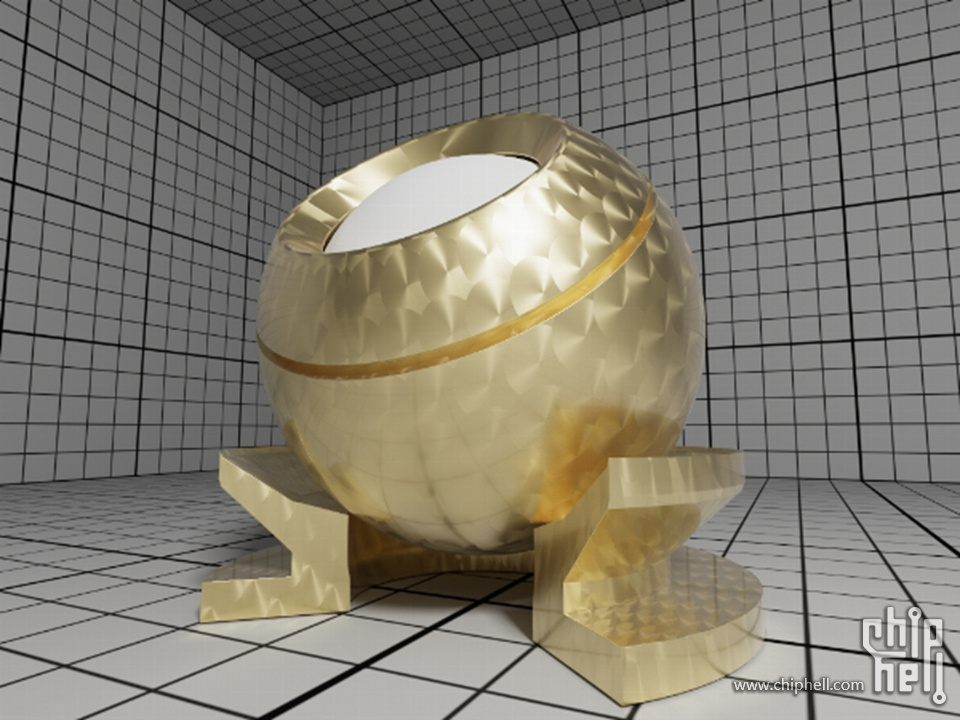

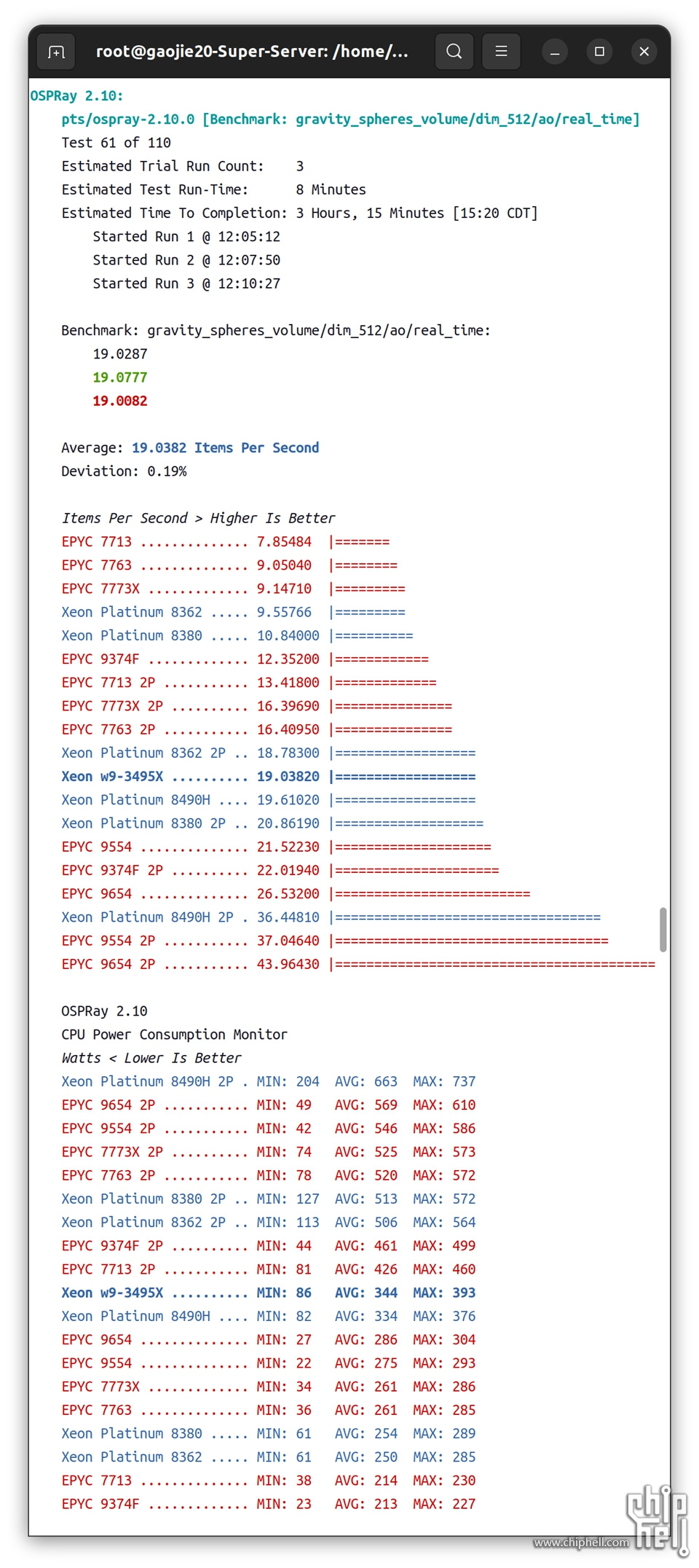

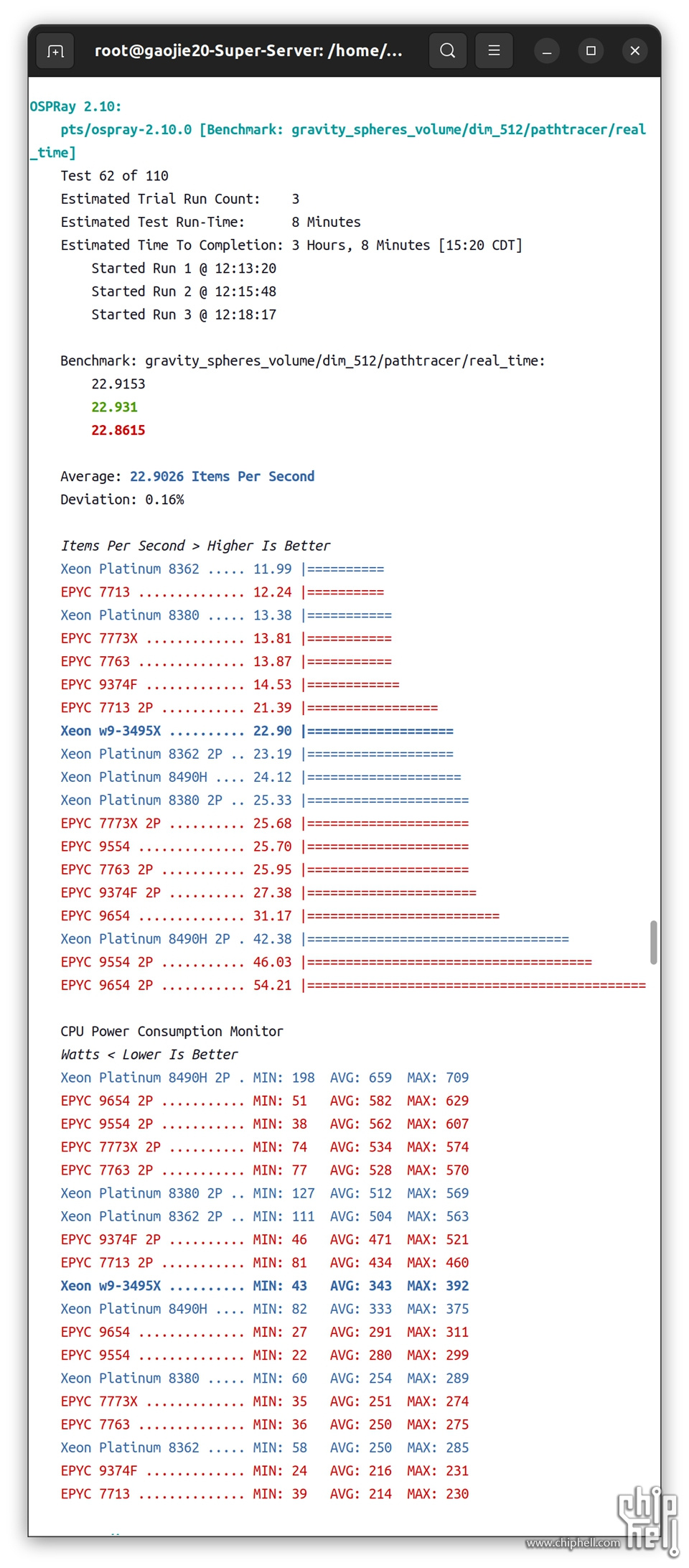

2.6.3▐ OSPray 2.10

Intel OSPray 是一种便携式光线追踪引擎,用于高性能、高保真科学可视化。OSPray 构建了英特尔的 Embree 和英特尔 SPMD 程序编译器 (ISPC) 组件,作为 oneAPI 渲染工具包的一部分。

2.6.3.1 ▐ gravity_spheres_volume/dim_512/ao/real_time

▲

单路1P:

Xeon w9-3495X#19.038 Items/Sec

Xeon Platinum 8490H#19.61 Items/Sec

EPYC 9554#21.52 IItems/Sec

单路EPYC 9554 每秒处理的项目数更多,平均TDP更低。

2.6.3.2 ▐ gravity_spheres_volume/dim_512/pathtracer/real_time

▲

单路1P:

Xeon w9-3495X#22.90 Items/Sec

Xeon Platinum 8490H#24.12 Items/Sec

EPYC 9554#25.70 IItems/Sec

单路EPYC 9554 每秒处理的项目数更多,平均TDP更低。

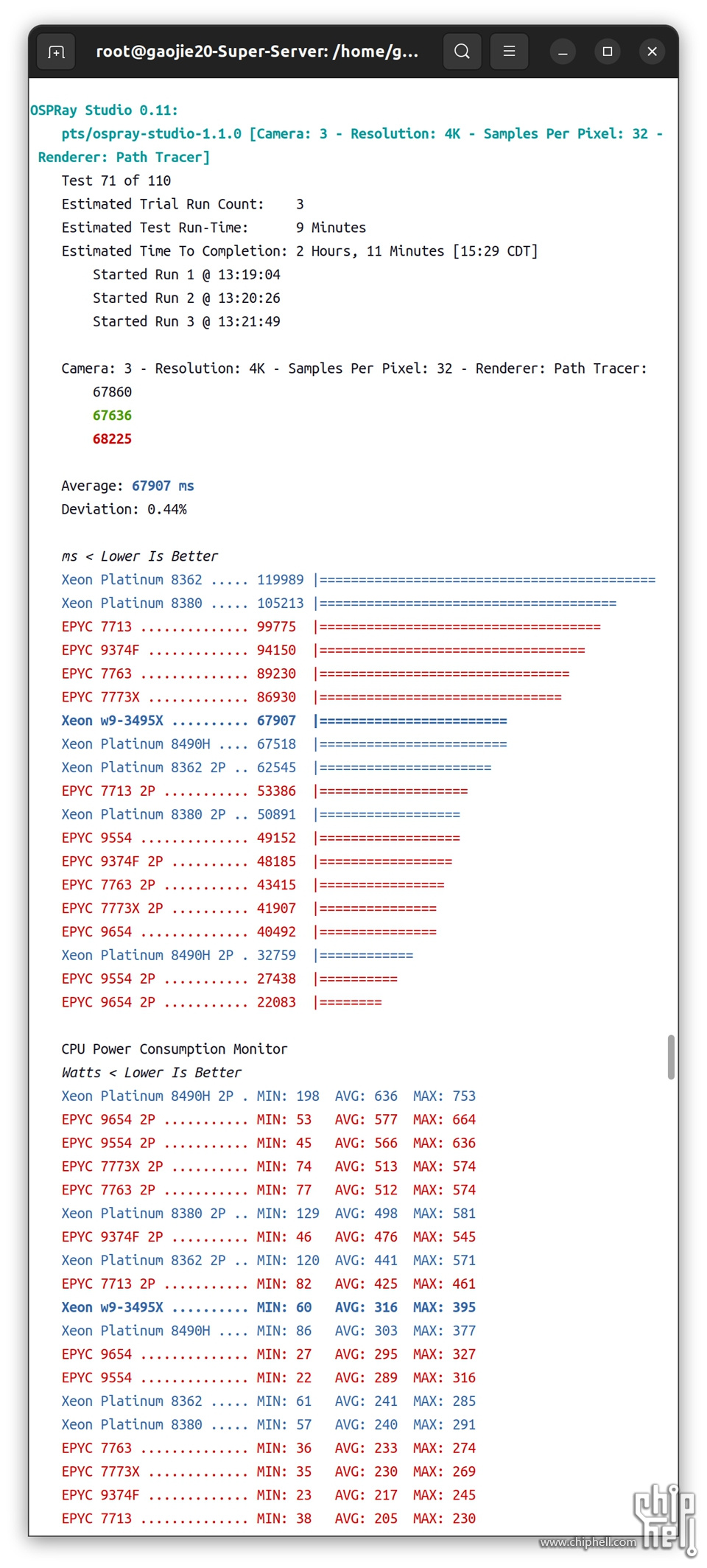

2.6.4▐ OSPRay Stadio 0.11

英特尔 OSPRay Studio 是一个开源的交互式可视化和光线追踪软件包。OSPRay Studio 使用 Intel OSPRay,这是一种用于高性能、高保真可视化的便携式光线追踪引擎。OSPRay 构建了英特尔的 Embree 和英特尔 SPMD 程序编译器 (ISPC) 组件,作为 oneAPI 渲染工具包的一部分。

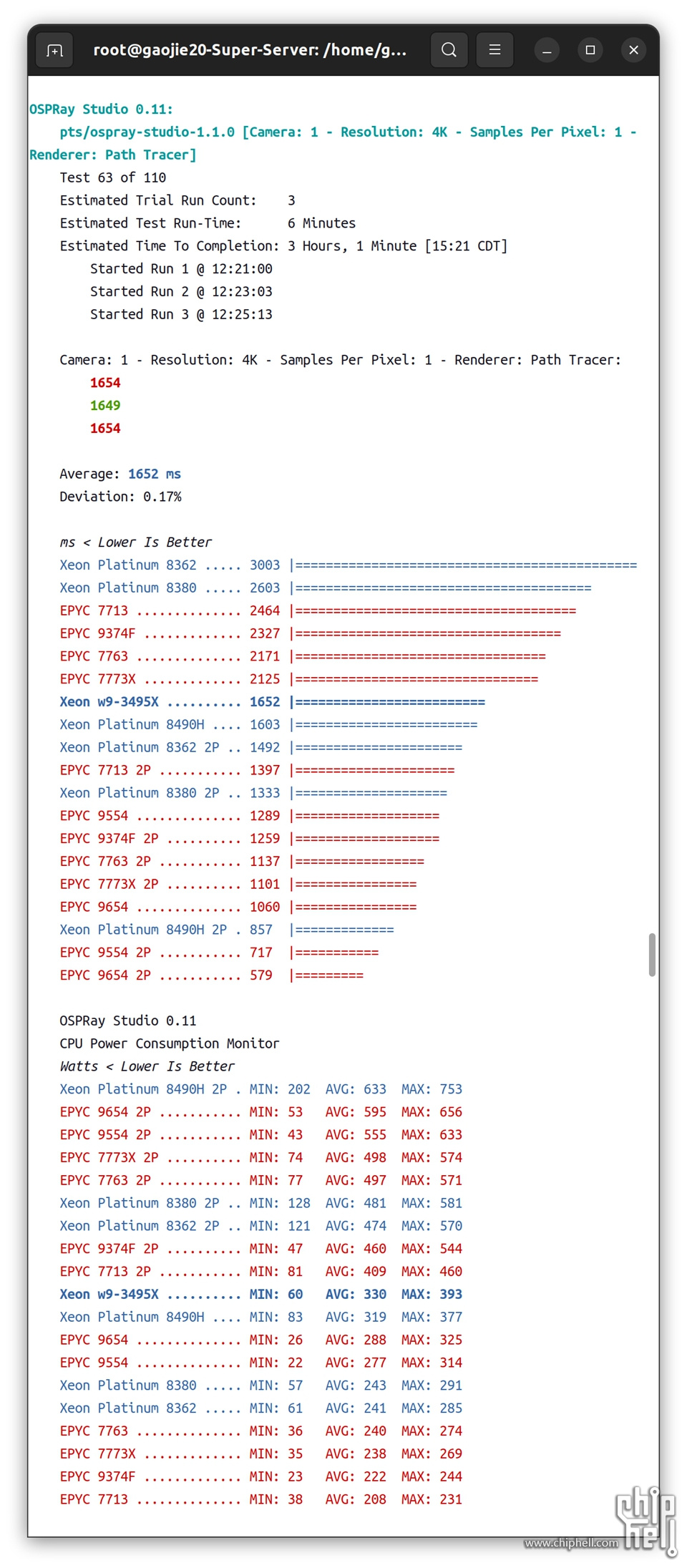

2.6.4.1 ▐ 1 - 4K - 1 - Path Tracer

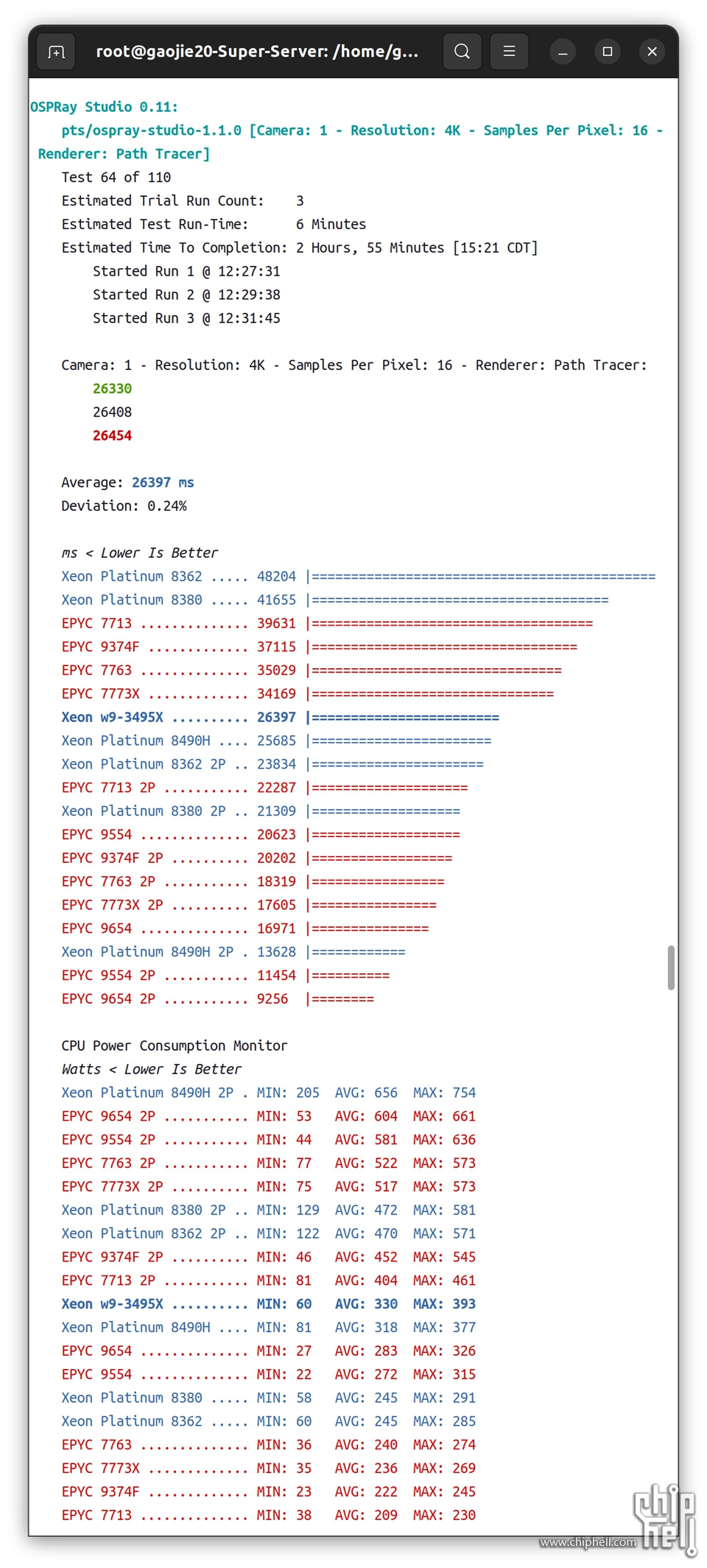

2.6.4.2 ▐ 1 - 4K - 16 - Path Tracer

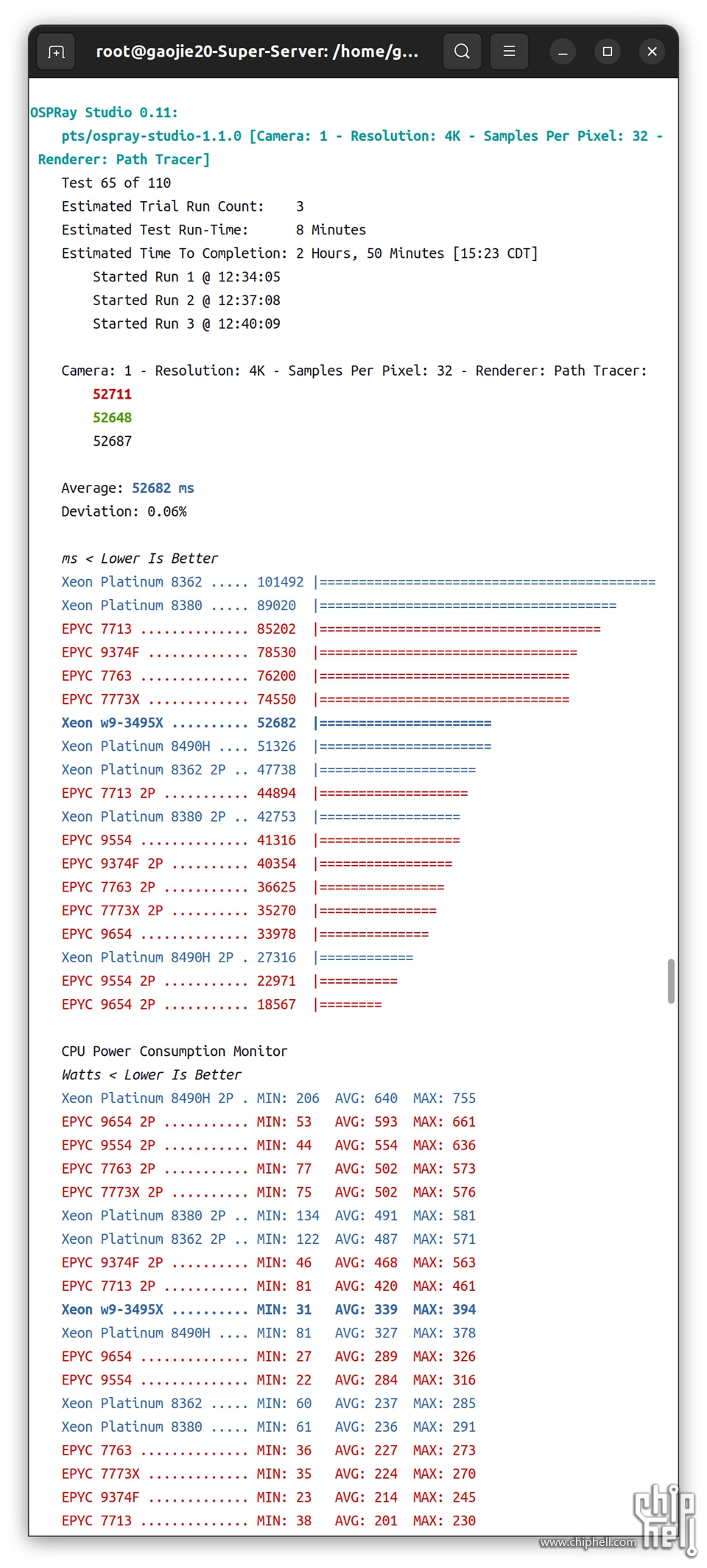

2.6.4.3 ▐ 1 - 4K - 32 - Path Tracer

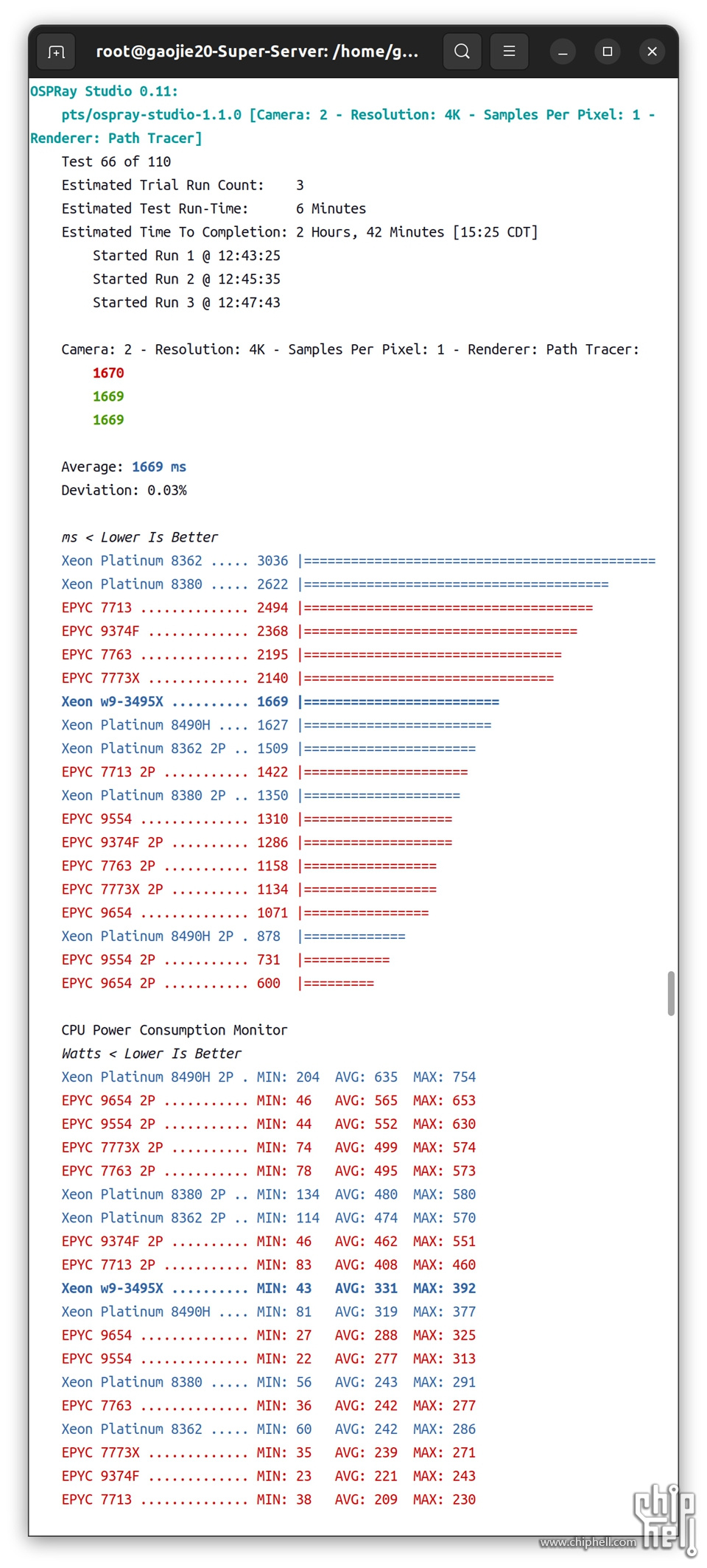

2.6.4.4 ▐ 2 - 4K - 1 - Path Tracer

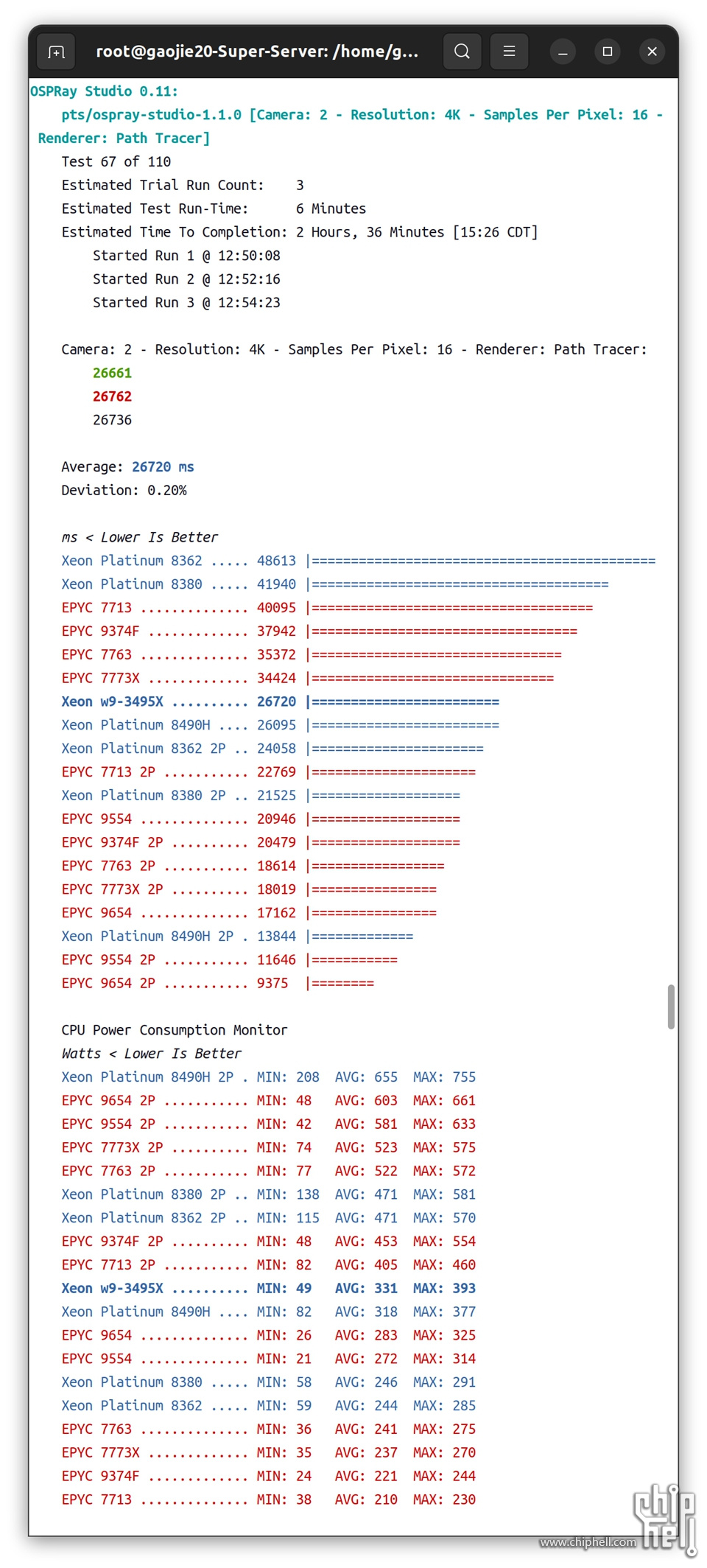

2.6.4.5 ▐ 2 - 4K - 16 - Path Tracer

2.6.4.6▐ 2 - 4K - 32 - Path Tracer

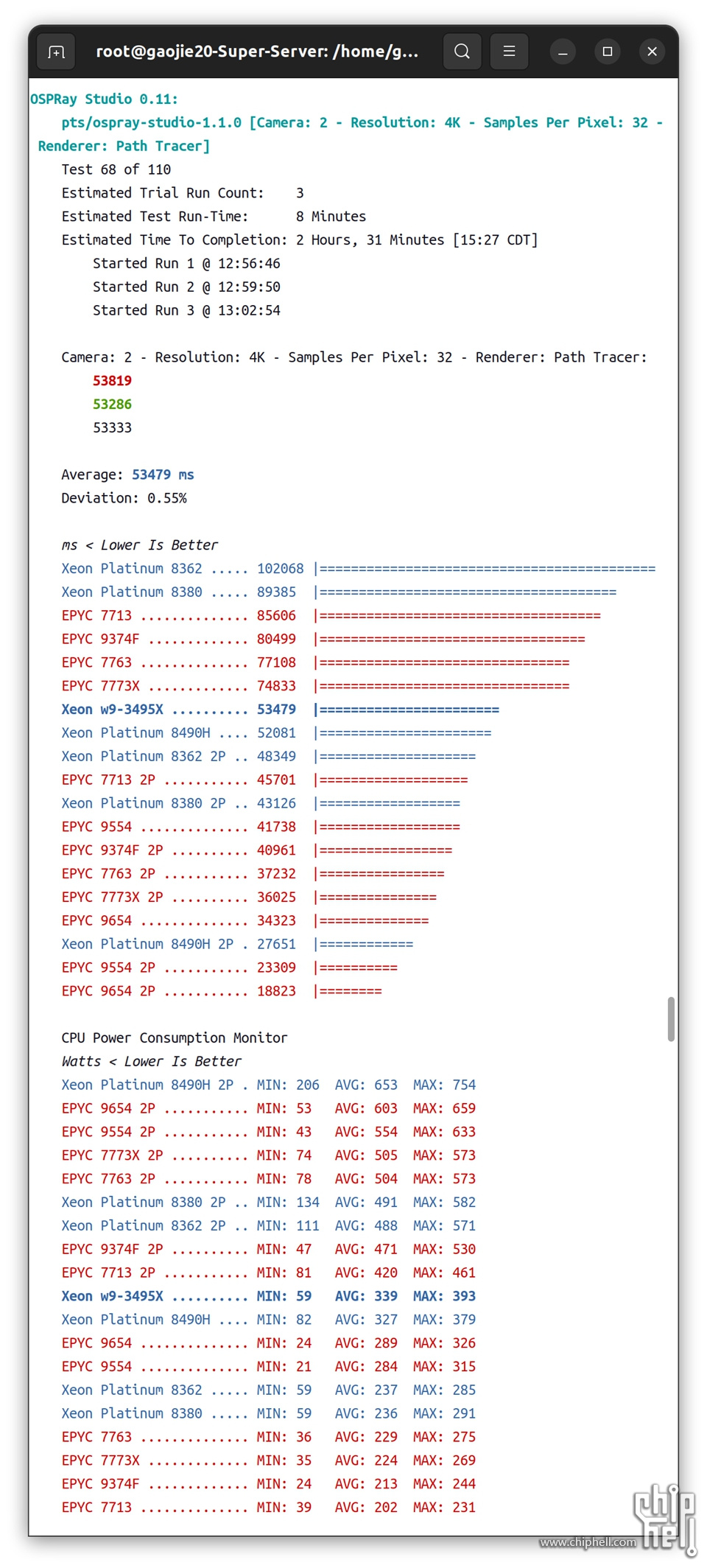

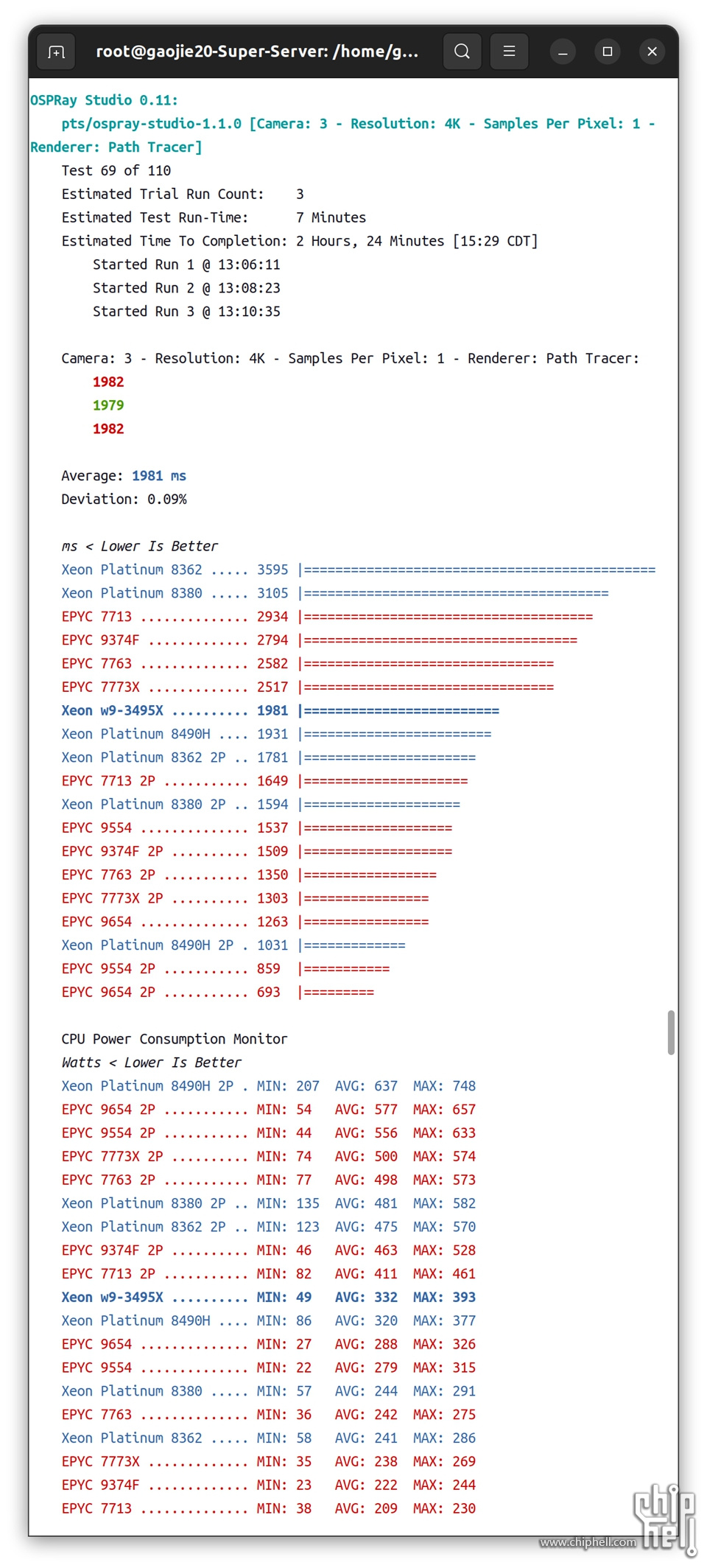

2.6.4.7 ▐ 3 - 4K - 1 - Path Tracer

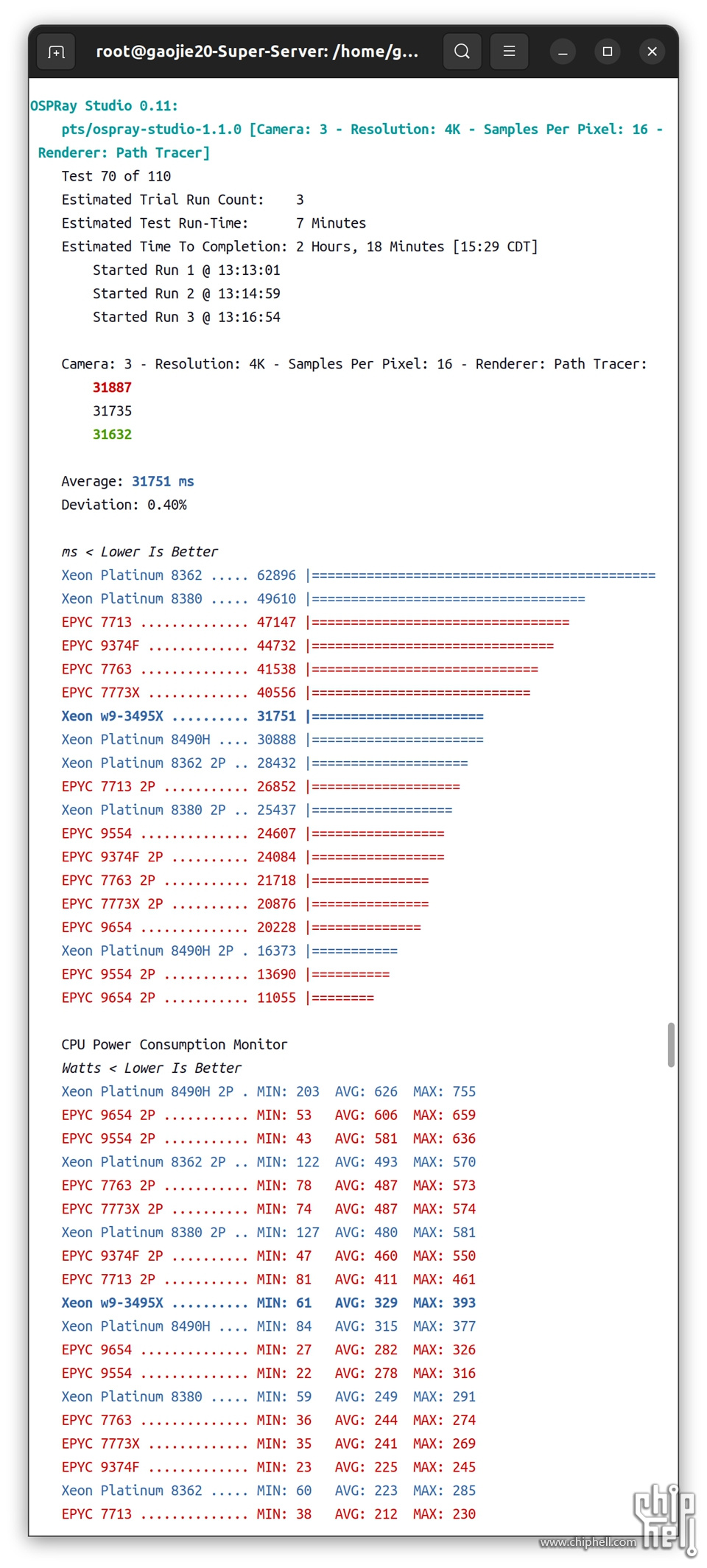

2.6.4.8 ▐ 3 - 4K - 16 - Path Tracer

2.6.4.9 ▐ 3 - 4K - 32 - Path Tracer

▲这个Intel自己写的光线追踪测试竟然一点都不黑AMD,EPYC 9554仍然比Xeon w9-3495X和Xeon Platinum 8490H要快。

2.7▐ Python

2.7.1▐ PyBench 2018-02-16

此测试配置文件报告来自 PyBench 的不同平均定时测试结果的总时间。PyBench 报告了不同函数的平均测试时间,例如 BuiltinFunctionCalls 和 NestedForLoops,这个总结果提供了对 Python 在给定系统上的平均性能的粗略估计。该测试配置文件每次运行 PyBench 20 轮。溯源:https://svn.python.org/projects/python/trunk/Tools/pybench/

▲

单路1P:

Xeon w9-3495X#582 Milliseconds

Xeon Platinum 8490H#771 Milliseconds

EPYC 9554#849 Milliseconds

单路Xeon w9-3495X 平均测试时间最短,性能最好,这是一个主频受益权重较大的测试。

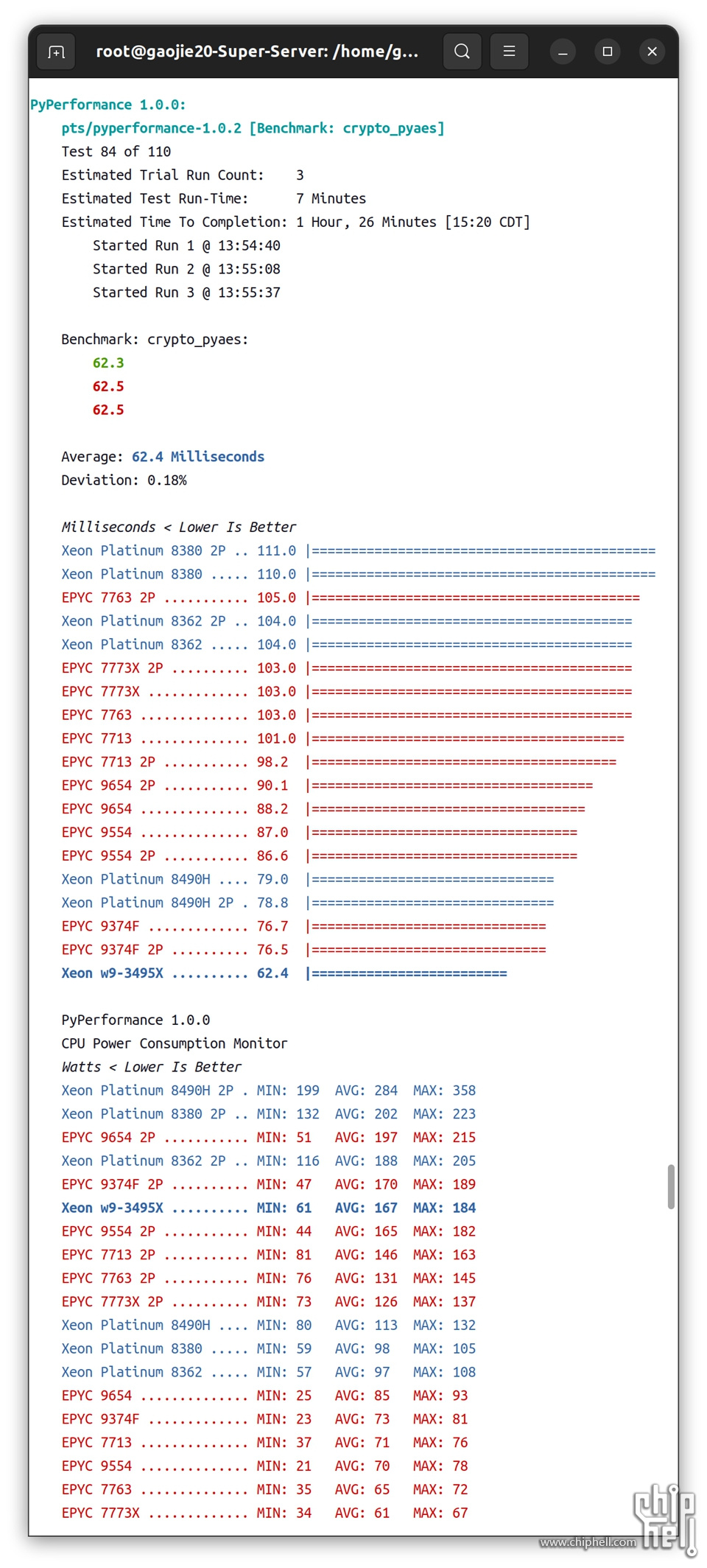

2.7.2▐ PyPerformance 1.0.0

PyPerformance 是参考 Python 性能基准套件。

2.7.2.1▐ crypto_pyaes

▲

单路1P:

Xeon w9-3495X#62.4 Milliseconds

Xeon Platinum 8490H#79 Milliseconds

EPYC 9554#87 Milliseconds

单路Xeon w9-3495X 平均测试时间更短,性能更好。

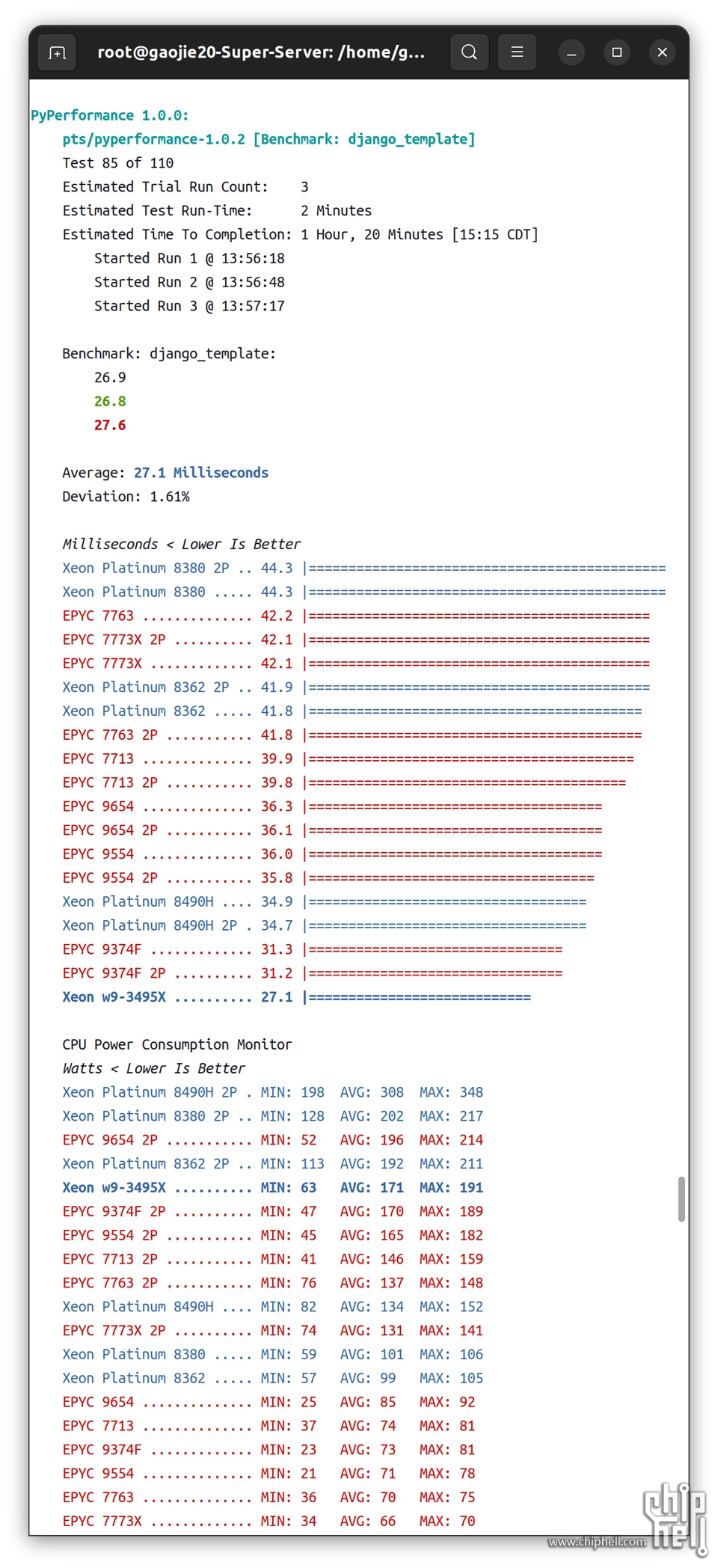

2.7.2.2 ▐ django_template

▲

单路1P:

Xeon w9-3495X#27.1 Milliseconds

Xeon Platinum 8490H#34.9 Milliseconds

EPYC 9554#36 Milliseconds

单路Xeon w9-3495X 平均测试时间更短,性能更好。

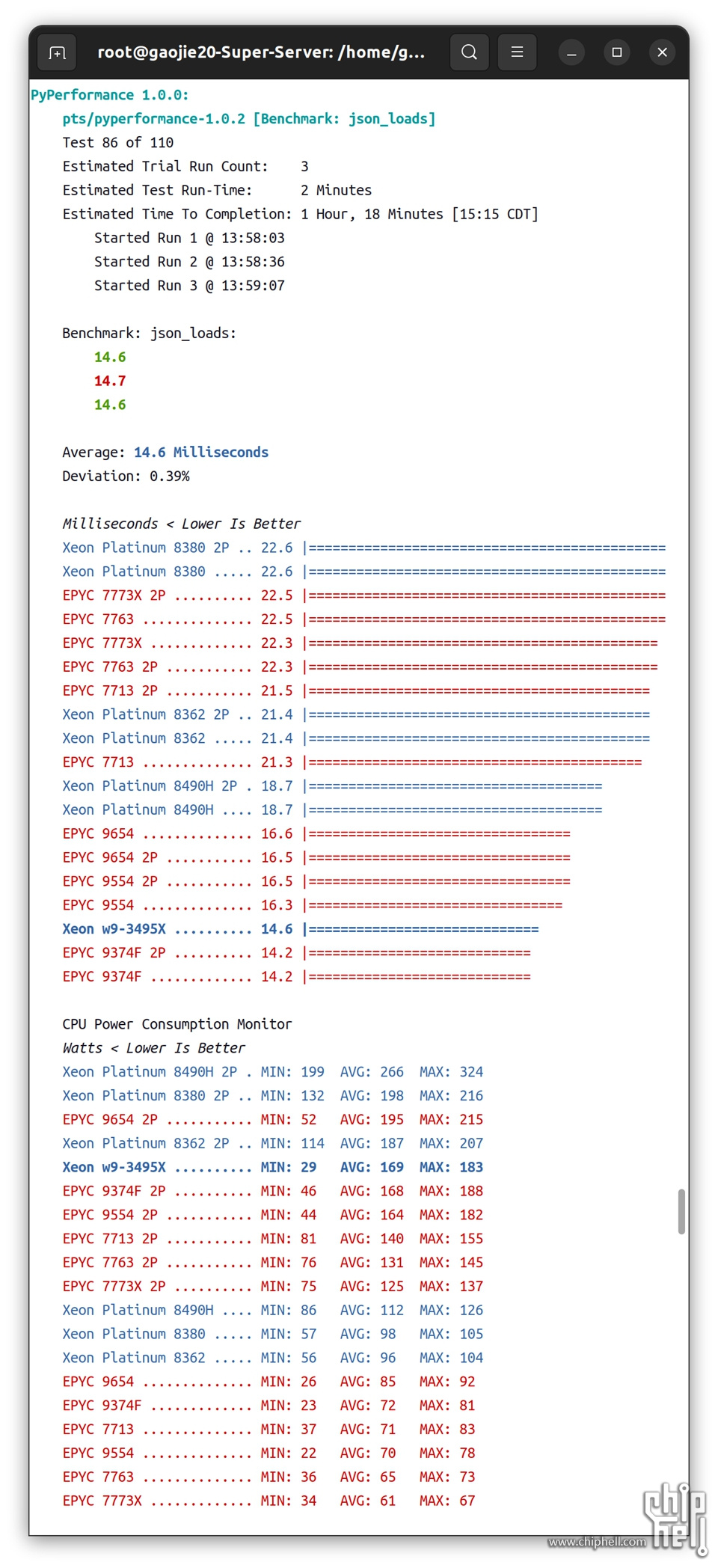

2.7.2.3▐ json_loads

▲

单路1P:

Xeon w9-3495X#14.6 Milliseconds

Xeon Platinum 8490H#18.7 Milliseconds

EPYC 9554#16.3 Milliseconds

单路Xeon w9-3495X 平均测试时间更短,性能更好。

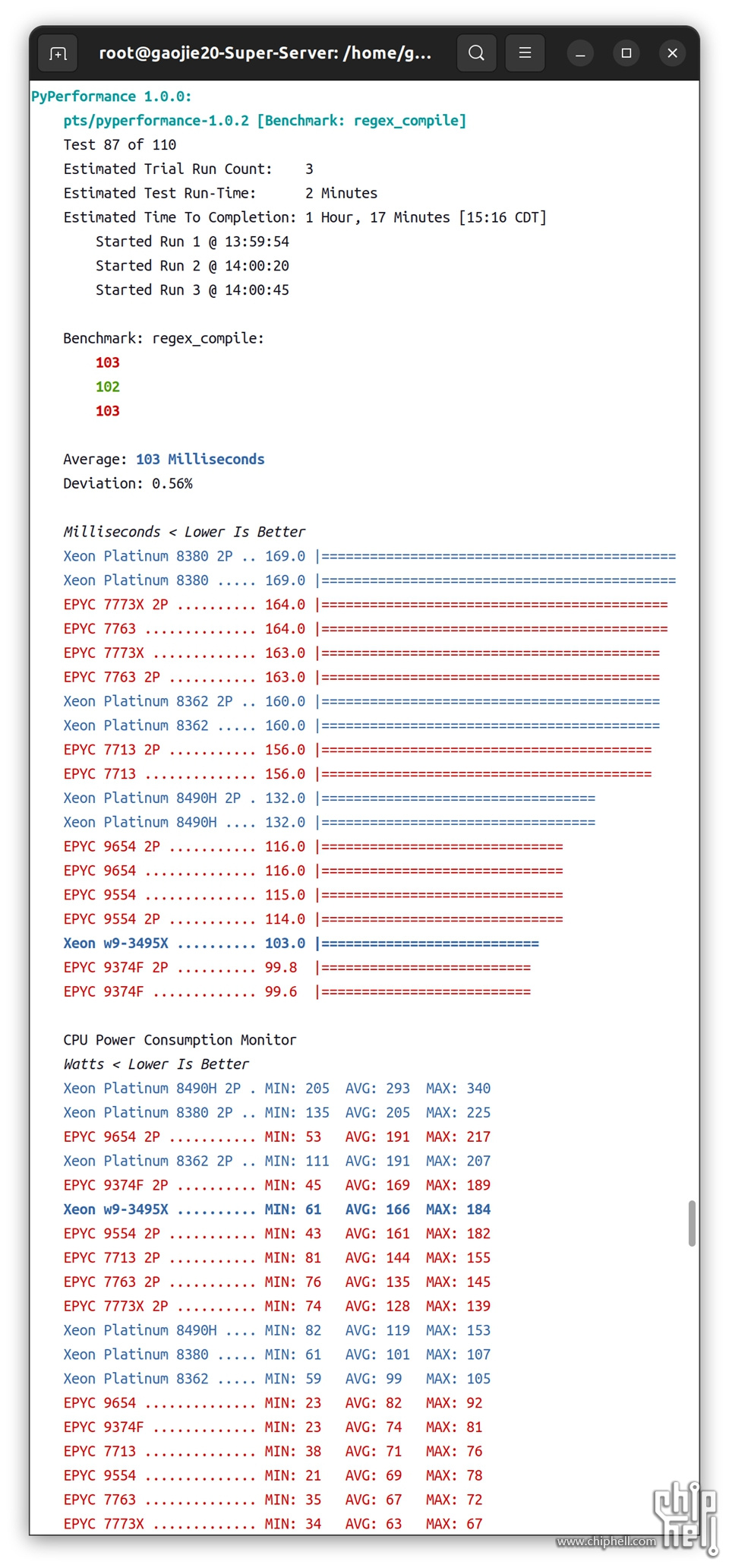

2.7.2.4▐ regex_compile

▲

单路1P:

Xeon w9-3495X#103 Milliseconds

Xeon Platinum 8490H#132 Milliseconds

EPYC 9554#115 Milliseconds

单路Xeon w9-3495X 平均测试时间更短,性能更好。

2.8▐ 金融量化交易

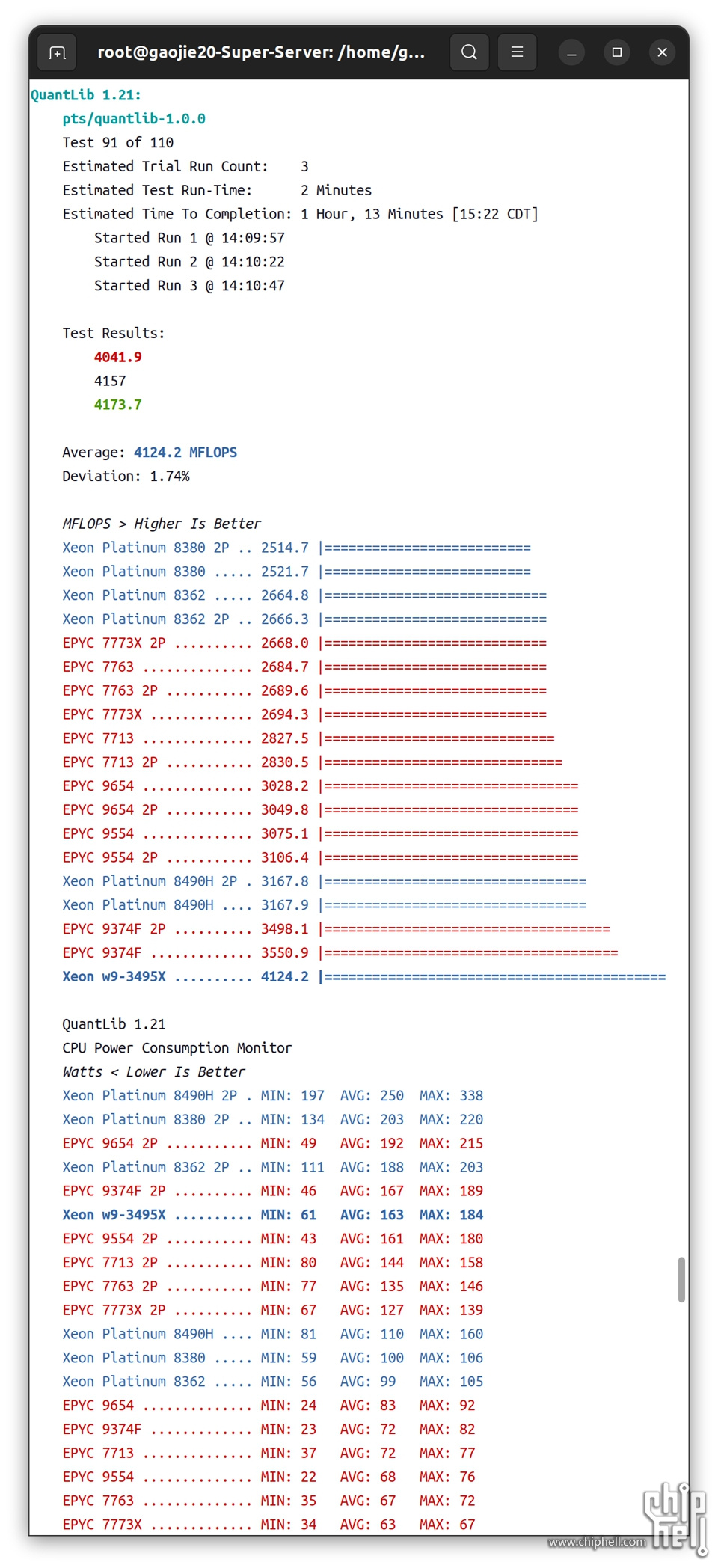

2.8.1▐ Quanlib 1.21

QuantLib 是一个围绕量化金融的开源库/框架,用于建模、交易和风险管理场景。QuantLib 是用带有 Boost 的 C++ 编写的,其内置的基准测试报告了 QuantLib Benchmark Index 基准测试得分。

▲

单路1P:

Xeon w9-3495X#4124.2 MFLOPS

Xeon Platinum 8490H#3167.9 MFLOPS

EPYC 9554#3075.1 MFLOPS

单路Xeon w9-3495X 平均测试数据量更大,性能更好。

2.9▐ 压缩解压缩

2.9.1▐ 7-Zip Compression 22.01

这是对 7-Zip 压缩/解压缩及其集成基准功能的测试

▲ 单路1P: Xeon w9-3495X@353978 MIPS@269179 MIPS Xeon Platinum 8490H@378741 MIPS@291248 MIPS EPYC 9554@545728 MIPS@523531 MIPS 单路EPYC 9554平均测试数据量更大,性能更好。

2.10.1▐ LeelaChessZero

▲

单路1P: Xeon w9-3495X@10182 Nodes/Seconds Xeon Platinum 8490H@10513 Nodes/Seconds EPYC 9554@8996 Nodes/Seconds 但凡涉及神经网络的计算,Intel总是会让你看到奇迹。

2.10.2▐ asmFish 2018-07-23

asmFish 是用 Assembly 编写的高级国际象棋基准测试。

▲ 单路1P: Xeon w9-3495X@127328259 Nodes/Seconds Xeon Platinum 8490H@130447170 Nodes/Seconds EPYC 9554@209533141 Nodes/Seconds

▲所有测试结束,系统统计了以下平均CPU功耗。

前面大家看到了太多Xeon w9-3495X默认状态下输给Xeon Platinum 8490H和EPYC 9554的测试了,不用急马上可以翻身。因为Ubutu没有适用的超频软件,所以我们要超频必须对BIOS进行设置调整,我推荐两种,我命名为OC SOP1和OC SOP2。

2.12.1▐ OC SOP1

OC SOP1是降压超频的操作,直接将Core Voltage降低0.1-0.15V,因为此时CPU的TDP没解锁,所以理论上降压后性能会得到提升。

▲ AdvancedOverclocking feature ProcessorCore Voltage Offset = 100-150 ProcessorOffset Prefix = [-] 图中我是直接降压0.15V

2.12.2▐ OC SOP2

OC SOP2是解锁超频的操作,解除功耗锁,解除电流锁

▲ AdvancedCPU ConfigurationAdvanced Power Management Configuration Package Current ConfigCurrent Limit Override = Enabled

▲ Package Current ConfigCurrent Limitation = 1FFF Current Limitation:0表示 Auto, 以 Xeon w9-3495X 为例 , Auto 值為 1130(16进制) = 550A。而设置为1FFF(16进制) = 1023.875A。

▲ SOCKET RAPL ConfigPL1 Power Limit = 4095 PL1 Time Window = 448 SOCKET RAPL ConfigPL2 Power Limit = 4095 PL2 Time Window = 0.438

PL1 Power Limit :0表示 Auto, 为CPU 的 Max.TDP,以Xeon w9-3495X为例 , Auto 值为350. PL2 Power Limit:0表示 Auto, 为CPU的Boost.TDP,是PL1的1.2 倍 , 以Xeon w9-3495X为例 , Auto 值为420.

2.12.3▐ 测试

以上两种都直接通过BIOS设置,无论Win11还是Ubuntu都可以直接使用,稳定高效。

其实我非常喜欢EPYC 9554,但是它的性能是固化的,而Xeon w9-3495X性能是可以通过适度OC提升的,我借用一个Ubuntu下的NAMD 2.14的测试来说明问题,为什么选择NAMD 2.14?第一是这个测试非常耗电,容易跑到满载以上,第二是这个空气动力学计算项目对intel没有任何商业优化。

▲无论是OC SOP1的降压还是OC SOP2的解锁,都可以轻松超越EPYC 9554和Xeon Platinum 8490H。OC SOP2的性能略高,但是会增加100W左右的功耗。

NAMD 2.14:

days/ns < Lower Is Better

Xeon w9-3495X ...................... 0.30016 |=====================

Xeon Platinum 8490H ...........0.29076 |====================

EPYC 9554 .................................0.28101 |====================

Xeon w9-3495X OC SOP1 .. 0.26260 |===================

Xeon w9-3495X OC SOP2 .. 0.25761 |==================

CPU Power Consumption Monitor

Watts < Lower Is Better

Xeon w9-3495X OC SOP2 ......MIN: 44 AVG: 403 MAX: 527

Xeon w9-3495X .........................MIN: 86 AVG: 304 MAX: 399

Xeon w9-3495X OC SOP1 .....MIN: 55 AVG: 299 MAX: 381

Xeon Platinum 8490H ............MIN: 82 AVG: 298 MAX: 376

EPYC 9554 ..................................MIN: 23 AVG: 259 MAX: 328

CPU Temperature Monitor

Celsius < Lower Is Better

Xeon w9-3495X OC SOP2 . MIN: 23.0 AVG: 38.5 MAX: 45.0

Xeon w9-3495X OC SOP1 . MIN: 24.0 AVG: 33.0 MAX: 36.0

▲我把有价值的信息汇总如上,各位自行判定。性能分析和功耗温度一目了然。首选OC SOP1不解锁功耗,直接降压超频,优点是功耗不会增加,缺点是-0.10V还是0.15V需要自行摸索,次选OC SOP2直接解锁功耗墙,电流开到1FFF最大,不动主频直接使用,缺点是待机和满载功耗都会增加,温度也会上升。你需要更强大的AIO散热以及更高瓦数的电源,总体使用成本会增加。

3▐ Windows 11 22H2 X64 Workstation

3.1▐ 刷新BIOS

最新的BIOS版本是1.1a,习惯Windows刷新BIOS的用户可以关注SuperMicro出品的SuperDoctor5。

▲第一步上传BIOS

▲第二步刷新BIOS

▲第三步刷新完毕重启即可

▲下面的测试会涉及到一些BIOS的截图操作,本来对于SuperMicro这种AMI BIOS而言截图十分困难,但是借助于SuperMicro BMC的IPMI系统可以方便的对BIOS进行远程截图操作。

▲BIOS启动界面

▲主板BIOS已经刷新为1.1a版本,发布时间为2023年4月25日

▲对于这颗CPU而言,请在使用时将WINDOWS电源模式设置为卓越性能,否则会有间歇性卡顿情况出现。

为了测试的公正性,本次选用的测试套件包含在BENCHMATE 10.12.2内部,可以反馈即时的频率和TDP功耗。

Windows 11 22H2 X64 Workstation即使是最新的Windows在执行CINEBENCH R23 X64的时候也无法跑满全部核心,所以在测试之前我们要进行如下设置保证56核心能够全速运行。

▲使用管理员权限打开Windows PowerShell,输入以下代码

- reg add "HKEY_LOCAL_MACHINESYSTEMCurrentControlSetControlNUMA" /v SplitLargeNodes /t REG_DWORD /d 1

3.3.1▐ 默认性能

SuperMicro X13SWA-TF默认状态下是不解锁CPU TDP限制的,那么这颗CPU依然被锁在Base TDP=350W,Turbo TDP=420W。

▲首先在默认状态下,R23得分61348,TDP 369W,CPU最高温度46度。

3.3.2▐ OC SOP1

▲在降压0.15V超频状态下,R23得分7**,TDP 361W,CPU最高温度45度。其实这个状态是比较舒服的一个临界点,功耗温度性能得到一个平衡,适合长期使用。

3.3.3▐ OC SOP2

▲在解锁超频状态下,R23得分72261,TDP 411W,CPU最高温度45度。功耗比OC SOP1解锁有提升,这个状态也比较稳定适合长期使用。下面我们来打一下这块主板的重度超频。

3.3.4▐ 重度超频

▲在OC SOP2的BIOS调试基础上,直接进入Intel XTU调试 Voltage Offset = -0.175V Performance Active-Core Tuning/47 to 56 = 41 点击Apply测试,最终获得R23 99776的成绩,TDP 715W,CPU最高温度59度。这是全核4.1GHz的成绩。

4.1▐ 关于Ubuntu下的测试

首先出于对真理的探索和对测试者的尊重,我保持了CPU的默认设置进行对比测试,主要是想探知其真实的性能。一开始就直接超频对其他CPU不公平。

4.1.1▐ Xeon w9-3495X和Xeon Platinum 8490H

把条件设定在单路1P默认性能范畴: 性能上:Xeon w9-3495X可以理解成Xeon Platinum 8490H的93%~97%,超频后轻松秒。 功耗上:Xeon w9-3495X可以理解成Xeon Platinum 8490H的100%~105% 言尽于此!

4.1.2▐ Xeon w9-3495X 只有一个DSA加速器,影响使用体验么?

w9-3495X只有1个DSA加速器,还缺少另外的3个加速器,但目前庞大的测试数据说明Xeon w9-3495X可以理解成加速器满血版Xeon Platinum 8490H的93%~97%性能。包括一些深度学习的测试也充分说明了问题。

4.2▐ 关于Windows下的测试

4.2.1▐ 手动超频

即使是最新发布的1.1a BIOS,我发现Intel的原味设置还是会有问题,比如核心频率的BIOS设置还是乱七八糟的不生效,所以如果要动主频,尽量使用XTU会比较简单。

4.2.2▐ 游戏性能

如果需要游戏性能,可以直接购买一颗Core i9 13900K或者Ryzen 9 7950X,游戏性能会远超Xeon w9-3495X和Xeon Platinum 8490H。

4.3▐ 电源模式

Ubuntu请设置为性能模式,Windows请设置为卓越性能,设置后日常功耗会增加,但是丝般顺滑。不设置会日常卡顿。

4.4▐ Xeon w9-3495X在X13SWA-TF上的使用感受

某些主板会偷偷动一下默认电压,但是X13SWA-TF没有,所以默认性能是正常的,只有某些板的设置激进了,默认性能同时默认功耗和温度也会降低,正常的OC使用请参考我上面的两点建议,会迅速让你找回性能雄起。这颗CPU的OC媒体宣传感觉纯属误导,OC只是一个很小的卖点,而且某些OC评测已经放弃了使用体验,追求昙花一现。这颗CPU的亮点是在Intel oneDNN和oneAPI框架下的深度学习性能优化,提升相当大。X13SWA-TF是一块中轨中距的板,它的亮点是唯一的16条DIMM主板,其PCIe插槽的设计可以同时容纳四张涡轮双槽显卡,槽点就是PCH的U.2使用了PCIe3.0x4而不是主流的PCIe4.0x4,供电部分的设计我觉得可以,因为这块板是为了稳定的输出性能而设计,不是为了拿超频冠军而设计,产品定位问题,毕竟它只卖1000美金以内的价格而已。ADATA的DDR5 ECC RDIMM内存很稳定,ABEE的SPR360效能真的出乎我的意料,Coolermaster的HAF700和CoolerMaster MWE GOLD V2 1250提供了超强的EATX主板兼容性以及稳定的供电输出,特别是HAF700,我本来很想购买SilverStone RM44 4U Rack配合X13SWA-TF上四张RTX 4090涡轮,后来在HAF700上一试,顿时觉得冷却和安静才是王道。

参考

TIP :本次使用 Supermicro X13SWA-TF 重点测试了Xeon w9-3495X 在Server方面的性能,对比侧重于和Xeon Platinum 8490H以及EPYC 9554对比,下次想选择ASUS Pro WS W790-SAGE SE 和 ASRock W790 WS 测试一下Workstation方面的性能,着重对比AMD Ryzen Threadripper PRO 5995WX的性能差异,以及OC后的表现,重点在POWER和BOOST,所以下一篇我们来在这两块主板中选择一块做专业性能测试,在5月底之前发布,先看哪一张主板我比较容易拿到吧。因为这两片主板对电源的要求比较高,所以下篇我会选择高瓦数的电源比如Seasonic TX-1600来进行Benchmark。感谢观看,再见! |

310112100042806

310112100042806