hawie 发表于 2025-9-3 18:24 所以DSM版本最低需要哪个呢? |

装陈醋的酱油瓶 发表于 2025-9-1 20:55 搜syno_hdd之类,有大神GitHub开源维护。UI没有的,命令行有。自己搜吧。 |

hawie 发表于 2025-7-14 09:47 非原装盘怎么DIY? 另外想要查看SMART + 想要去重最高/最低的DSM版本分别是哪个? |

高子 发表于 2023-12-4 12:18 同一个文件,你放到100个文件夹,你看到的也是100个文件。实际就是占用1个的空间。 |

懒得整理的资料,肯定是要启用的。这算是全闪存储的福利吧。

|

roubaozi1 发表于 2023-12-4 13:55 就是 FIDEDUPRANGE ioctl 系统调用 对于个人用户来说,还是文件级别的去重好用,成本低、效果相差无几 |

tide~ 发表于 2023-12-4 13:48 这是linux 文件系统的高级特性,放到windows你连驱动都没有,根本打不开 |

|

哪些 Synology NAS 型号支持重复数据删除? 存储管理器Btrfs 更新时间:Nov 6, 2023 部分文章为机器自动翻译,文中可能有文法错误或语义模糊之处。 详细信息 重复数据删除使您可以用更少的存储空间存储更多数据而不会影响数据完整性。您可以计划在非高峰时段自动运行重复数据删除,也可以选择手动运行一次性操作。 重复数据删除需要至少一个仅由 Synology SSD 组成的 Btrfs 存储空间。要了解更多信息请参阅本文。 解决方案 下表列出了支持重复数据删除的Synology NAS型号。 1 系列 型号 FS 系列 FS6400、FS3600、FS3410、FS3400、FS2500 HD 系列 HD6500 SA 系列 SA6400、SA3610、SA3600、SA3410、SA3400 21 系列 RS4021xs+、RS3621xs+ 2 、RS3621RPxs 2 注意 您所在地区可能未提供某些型号,请联系您当地的经销商以了解更多信息。 启用重复数据删除至少需要 16 GB 内存。 // 恩。。。 |

| 块级的去重,盲猜用的bees https://btrfs.readthedocs.io/en/latest/Deduplication.html |

| 真没注意过这功能,消除重复数据块是个什么逻辑?重复文件我能明白。 |

| 赛门铁克备份里用过这个功能,能节省超过一半的备份空间。 |

tide~ 发表于 2023-12-4 05:48 新点内核的Linux box没问题 为啥要放windows上扫 |

| “由于重复数据删除会移除重复的数据块,可能会造成部分数据不连续,影响读写性能。”这句话已经说的很明白了,块级别的重删,不是文件级别的做个软连接这么简单 |

|

同名文件(同hash)只留一个,具有不同文件夹属性;这个好理解; 问题是这是存在NAS层的某记录文件里的;一旦取出这块硬盘,放win环境下的磁盘扫描,会不会报交叉链接错误,就再也没法恢复了? |

高子 发表于 2023-12-4 12:18 类似Linux的软连接,只要文件Hash一样,只保留一份数据,不重复占用空间,底层都指向一个文件。 |

dcl2009 发表于 2023-12-4 11:39 不知道啥原理 |

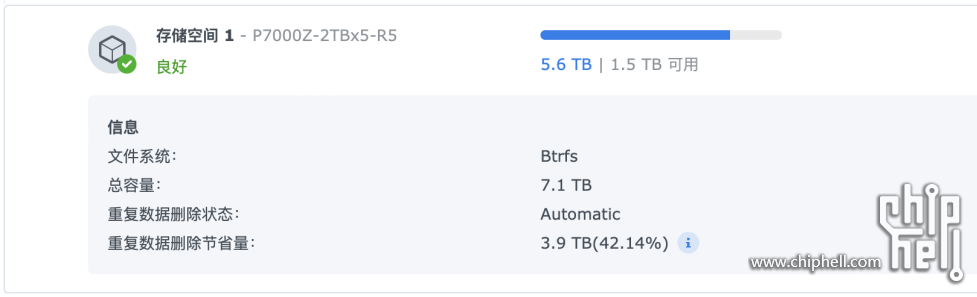

huihuige 发表于 2023-12-4 12:42 可以设置自动的呀,我传图片了,你看看 |

|

我这试了 我记得官网问了 好像是不是自动的 我这有几个重复的文件 他是不会自动删除的 |

压缩去重这不是高端存储才有的功能么? |

| 用过,因为我之前几块硬盘的数据合并到一块大容量盘,有些数据是重复的,筛选出来还是手动删比较稳妥 |

|

貌似是固态盘专属。 我感觉没啥大的意思。 |

| 没看到这个功能 |

|

群晖也支持去重了? 什么原理啊,比如我A文件夹里有1 2 3 4 5文件,B文件夹里有2 4 6 7 8文件,存储的时候就是1 2 3 4 5 6 7 8文件,那我复制出来A或者B文件夹的时候,得到还是1 2 3 4 5或者2 4 6 7 8文件么? |

|

跟truenas里面的zfs一样的效果? 我现在群晖里面mount truenas 里面的NFS用,truenas开去重和压缩,效果挺不错 |

不想去搞这些 就是放照片和做家庭影视库 年纪大了 不想搞明白其他功能了 |

二手烟 发表于 2023-12-4 10:52 NAS里也要不了太强的硬盘性能吧,牺牲点性能换取空间我觉得也是个不错的办法 |

lovetree1225 发表于 2023-12-4 10:43 我是资料放在S4520里,影视之类的在HC550里,分开了。 |

| 用过一次,还好重复的是电影。 |

| 同样423+ 4块银河18T |

Archiver|手机版|小黑屋|Chiphell

( 沪ICP备12027953号-5 ) 310112100042806

310112100042806

GMT+8, 2025-10-23 03:52 , Processed in 0.012840 second(s), 10 queries , Gzip On, Redis On.

Powered by Discuz! X3.5 Licensed

© 2007-2024 Chiphell.com All rights reserved.