|

|

本帖最后由 godspeed66 于 2024-4-24 16:34 编辑

RTX 5880 鸡肋了

RTX 5880 降频严重,鸡肋了(怀疑是程序问题,或者通信消耗变大)

实测RTX 5880 单卡 的推理速度仅有L20 约80%速度;与RTX 6000ADA 对比,仅有RTX 6000ADA 75%~83%的速度

实测RTX 5880单卡、双卡、三卡(四卡等待机箱改造中)的推理速度均比RTX 6000 ADA 慢,肉眼可见的慢,甚至比不上RTX 4090*2

RTX 5880\RTX 6000 环境

操作系统:Linux-5.15.146.1-microsoft-standard-WSL2-x86_64-with-glibc2.35.

python版本:3.11.7 (main, Dec 15 2023, 18:12:31) [GCC 11.2.0]

项目版本:v0.2.10

langchain版本:0.0.354. fastchat版本:0.2.35

当前使用的分词器:ChineseRecursiveTextSplitter

当前启动的LLM模型:['Qwen1.5-32B-Chat'] @ cuda

{'device': 'cuda',

'host': '0.0.0.0',

'infer_turbo': False,

'model_path': 'Qwen1.5-32B-Chat',

'model_path_exists': True,

'port': 20002}

当前Embbedings模型: bge-large-zh-v1.5 @ cuda

L20 *4 是AUTODL的环境

操作系统:Linux-5.15.0-91-generic-x86_64-with-glibc2.35.

python版本:3.11.7 (main, Dec 15 2023, 18:12:31) [GCC 11.2.0]

项目版本:v0.2.10

langchain版本:0.0.354. fastchat版本:0.2.35

当前使用的分词器:ChineseRecursiveTextSplitter

当前启动的LLM模型:['Qwen1.5-32B-Chat'] @ cuda

{'device': 'cuda',

'host': '0.0.0.0',

'infer_turbo': False,

'model_path': 'Qwen/Qwen1.5-32B-Chat',

'model_path_exists': True,

'port': 20002}

当前Embbedings模型: bge-large-zh-v1.5 @ cuda

RTX 4090*2 环境

操作系统:Linux-6.5.0-27-generic-x86_64-with-glibc2.35.

python版本:3.11.7 (main, Dec 15 2023, 18:12:31) [GCC 11.2.0]

项目版本:v0.2.10

langchain版本:0.0.354. fastchat版本:0.2.35

当前使用的分词器:ChineseRecursiveTextSplitter

当前启动的LLM模型:['Qwen1.5-32B-Chat-AWQ'] @ cuda

{'device': 'cuda',

'host': '0.0.0.0',

'infer_turbo': False,

'model_path': 'Qwen/Qwen1.5-32B-Chat-AWQ',

'model_path_exists': True,

'port': 20002}

当前Embbedings模型: bge-large-zh-v1.5 @ cuda

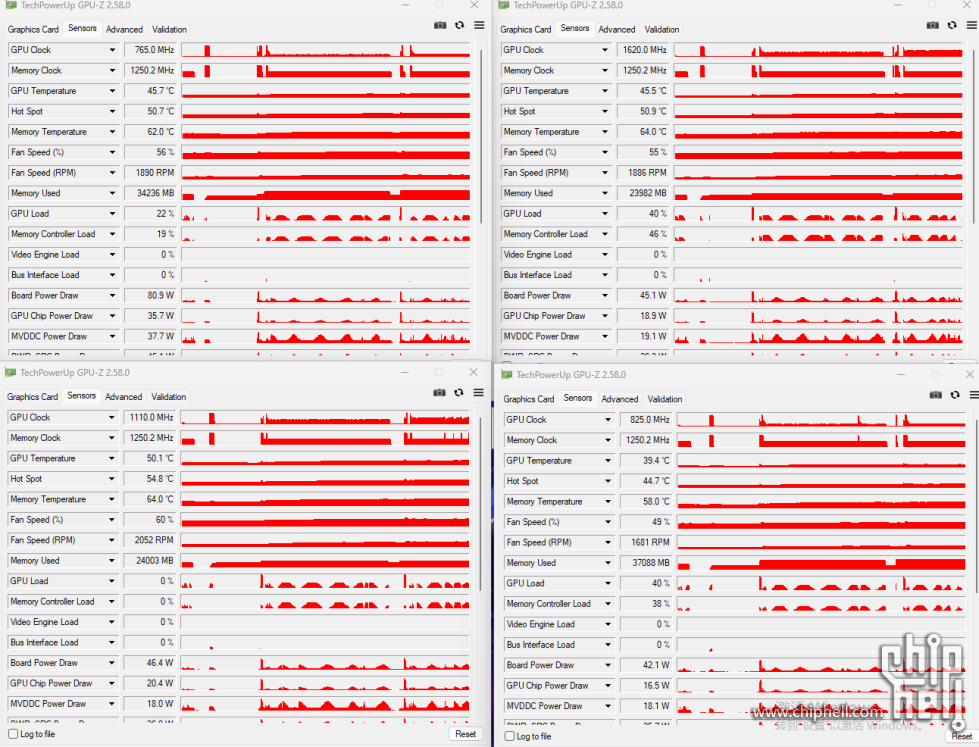

目前遇到的问题是,推理时RTX 5880的GPU频率上不去

后面就越来越慢

|

|

310112100042806

310112100042806